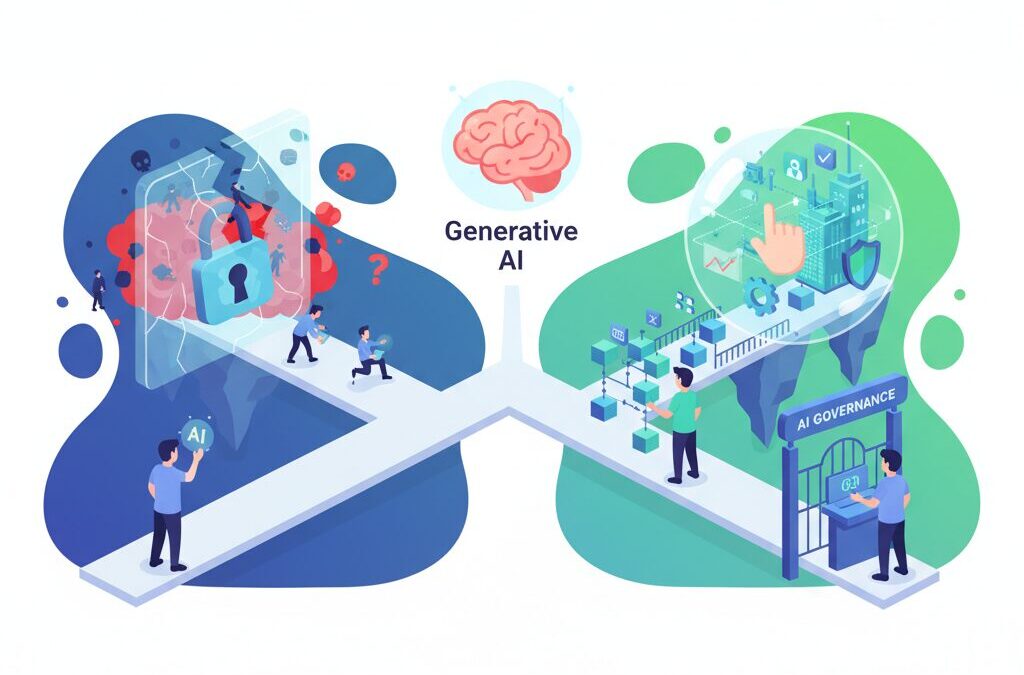

生成AIはもはや一部の先進企業だけのものではなく、あらゆる業務に深く入り込む社会インフラになりました。文章作成、要約、分析、開発支援など、その利便性を実感している方も多いのではないでしょうか。一方で、多くの企業や組織が今もなお「機密情報は入力禁止」というルールのもと、試行錯誤を続けています。

しかし2026年現在、その禁止ルールが現場で形骸化し、かえってリスクを増幅させている現実が明らかになりつつあります。従業員の善意によるシャドーAI利用、営業秘密や個人情報漏洩の急増、経営層と現場の認識ギャップなど、生成AIを巡る課題はより複雑化しています。

本記事では、日本企業の最新統計、実際のインシデント事例、政府・業界団体のガイドライン、そして先進企業や自治体の取り組みを横断的に整理します。単なる禁止ではなく、リスクを制御しながら価値を最大化するために必要な考え方と方向性を理解できるはずです。生成AI時代における実践的なガバナンスの全体像を、専門的かつ体系的に掴みたい方にとって必読の内容です。

2026年の生成AIと日本企業を取り巻くセキュリティ環境

2026年の日本企業を取り巻く生成AIのセキュリティ環境は、もはや一過性の課題ではなく、経営基盤そのものを左右する構造的テーマになっています。大規模言語モデルは電力やインターネットと同様に業務へ深く溶け込み、**生成AIを前提としない業務設計の方が例外**になりつつあります。その一方で、機密情報や個人情報の扱いを巡る不安は解消されておらず、企業の対応は明確に分岐しています。

独立行政法人情報処理推進機構が2025年に公表した調査によれば、生成AIに関する利用ルールを策定している企業は52.0%に達しました。ただし、その内訳を見ると「利用を許可」が25.8%、「利用を禁止」が26.2%と拮抗しており、**日本企業のガバナンスが二極化している現実**が浮かび上がります。

| 生成AI利用ルールの状況 | 割合 |

|---|---|

| 利用を許可 | 25.8% |

| 利用を禁止 | 26.2% |

| ルールなし・不明 | 48.0% |

この背景には、営業秘密漏洩リスクの急激な顕在化があります。同調査では、過去5年間に営業秘密の漏洩被害を認識した企業が35.5%に達し、2020年時点の5.2%から異常とも言える増加を示しました。特に注目すべきは、漏洩原因として「サイバー攻撃」だけでなく、「現職従業員のルール不徹底」や「内部不正」が3割前後を占めている点です。

生成AIはこの内部要因リスクを加速させます。業務効率化を目的に、従業員が顧客情報や未公開資料をプロンプトとして入力してしまう行為は、悪意がなくとも重大なインシデントにつながりかねません。個人情報保護委員会も、生成AIへの個人情報入力が再学習や越境データ移転を通じて想定外の二次利用を招く可能性について、継続的に警鐘を鳴らしています。

さらに、クラウド利用の拡大もリスク構造を変えました。IPAによれば、日本企業のクラウド利用率は2024年時点で50%を超えています。生成AIもクラウドサービスの一形態として利用される以上、**従来の境界型セキュリティだけでは統制できない領域**が急速に広がっています。経営層が「禁止しているから安全」と考えるほど、現場との認識ギャップが拡大し、統制外の利用が水面下で進行する危険性が高まります。

PwCの生成AI実態調査でも、業界ごとに温度差が顕著であることが示されています。化学やエネルギー分野では競争力強化のため積極導入が進む一方、金融や医療では規制と責任の重さから慎重姿勢が続いています。これは単なるIT投資の違いではなく、**将来の生産性と競争優位性を分けるセキュリティ戦略の差**と言えます。

2026年の生成AIと日本企業を取り巻くセキュリティ環境は、「使うか使わないか」を議論する段階を既に通過しています。問われているのは、不可避となった生成AI利用を前提に、どこまでリスクを可視化し、どのレベルで制御できるのかという現実的な判断力です。その判断を誤れば、セキュリティ事故だけでなく、競争力そのものを失うリスクが顕在化する時代に入っています。

生成AI利用ルールが二極化する理由と最新統計

生成AIの利用ルールが二極化する最大の理由は、生産性向上への期待と、機密情報漏洩への恐怖が同時に極限まで高まっている点にあります。

独立行政法人情報処理推進機構が2025年に公表した調査によれば、生成AIに関する何らかの社内ルールを策定している企業は52.0%に達しています。

一見するとガバナンスが進んでいるように見えますが、その内訳が現在の分断を如実に物語っています。

| 区分 | 割合 |

|---|---|

| 生成AIの利用を許可 | 25.8% |

| 生成AIの利用を禁止 | 26.2% |

| ルールなし・不明 | 48.0% |

特に注目すべきは、「利用を許可している企業」と「全面禁止している企業」がほぼ同率で拮抗している点です。

これは日本企業が、生成AIを競争力の武器と捉える層と、リスク源として排除する層に真っ二つに割れていることを示しています。

禁止を選択する背景には、営業秘密漏洩リスクの急激な顕在化があります。

同調査では、過去5年間に営業秘密の漏洩被害を認識した企業が35.5%に上り、2020年時点の5.2%から異常とも言える増加を示しました。

専門家の間では、この数字はサイバー攻撃だけでなく、クラウド利用の拡大と人為的ミスの累積結果だと分析されています。

実際、漏洩原因の内訳を見ると、外部からの侵入が36.6%に急増する一方で、現職従業員のルール不徹底が32.6%を占めています。

生成AIへの安易なプロンプト入力は、まさにこの「ルール不徹底」の新しい形として認識され始めています。

一方で、利用を許可する企業は、AIを前提とした業務設計に踏み出しています。

PwCの生成AI実態調査では、積極活用企業ほど業務効率化や意思決定の高速化を実感しており、投資対効果が明確になりつつあると指摘されています。

つまり二極化の本質は、リスクを恐れて停止するか、リスクを前提に管理へ進むかという経営判断の差にあります。

この選択の違いは、2026年以降の人材生産性、意思決定速度、そして市場競争力に静かに、しかし確実に影響を及ぼし始めています。

営業秘密・個人情報漏洩が急増する構造的背景

営業秘密や個人情報の漏洩が急増している背景には、単なる従業員の不注意やモラル低下では説明できない、構造的な変化があります。**最大の要因は、業務データの流通経路が人間の認知能力を超えるスピードと複雑さで拡張していること**です。生成AIはその変化を加速させる触媒として機能しています。

独立行政法人情報処理推進機構が公表した調査によれば、過去5年間で営業秘密の漏洩被害を経験した企業は35.5%に達し、2020年調査時の5.2%から異常な伸びを示しています。注目すべきは、この増加が特定の業界や大企業に限定されていない点です。クラウドサービスと生成AIが中小企業を含めて一気に普及したことで、**情報管理の難易度が企業規模に関係なく跳ね上がった**のです。

構造的背景の一つが、クラウドシフトとSaaS依存の進行です。IPAの同調査では、業務でクラウドサービスを利用する企業の割合が2020年の22.6%から2024年には50.4%へと倍増しています。データはもはや社内サーバーに閉じ込められた資産ではなく、API連携やブラウザ操作を通じて常時外部と行き来する存在になりました。この環境下で生成AIは、ごく自然に“もう一つのクラウド入力先”として組み込まれています。

| 構造変化 | 具体的内容 | 漏洩リスクへの影響 |

|---|---|---|

| クラウド利用の常態化 | SaaS・API連携の増加 | 管理境界が曖昧化 |

| 生成AIの業務浸透 | 非定型業務への利用拡大 | 入力内容の可視化困難 |

| 人依存のルール運用 | 現場裁量に委ねた判断 | 善意による漏洩増加 |

もう一つの重要な要因は、漏洩原因の質的変化です。IPAによれば、サイバー攻撃が36.6%と最大要因である一方、「現職従業員のルール不徹底」が32.6%、「内部不正」が31.5%と、内部要因が依然として高水準を占めています。特に生成AI時代に特徴的なのは、**悪意のない“善意の入力”がそのまま漏洩につながる点**です。業務効率化のために入力したデータが、結果として管理外に流出する構造が出来上がっています。

さらに、情報の行き先も変化しています。従来は競合他社への漏洩が中心でしたが、近年は取引先や無関係な第三者を含む「その他」への流出が48.8%にまで拡大しています。これは、生成AIやクラウドを介した情報拡散が、**意図した相手だけに情報を届けることを極めて難しくしている**現実を示しています。

このように、営業秘密・個人情報漏洩の急増は、技術進化と業務構造の変化が生み出した必然的な帰結です。ルール強化や注意喚起だけでは追いつかず、**人・技術・業務プロセスのズレそのものがリスクを内包している**ことを正確に理解する必要があります。

シャドーAIの台頭と『禁止』が生む逆説的リスク

生成AIの業務利用を「禁止」することでリスクを抑えようとする企業は少なくありませんが、2026年時点ではその発想自体が新たな危険を生み出していると指摘されています。象徴的なのが、組織の管理外で従業員がAIを利用するシャドーAIの急増です。独立行政法人情報処理推進機構や民間調査が示す通り、禁止は利用を止めるどころか、可視性を奪う方向に作用しています。

株式会社SIGNATEが2025年12月に公表した調査によれば、生成AIへの関心が高い層のうち約34.8%がシャドーAIを経験しています。注目すべきは、その多くが「ほぼ毎日」あるいは「1日に複数回」利用している点です。つまりシャドーAIは一時的な抜け道ではなく、すでに日常業務の一部として定着しています。

| 観点 | 公式AI利用 | シャドーAI利用 |

|---|---|---|

| 可視性 | 管理・監査が可能 | 管理不能 |

| セキュリティ | DLPやログ取得が可能 | 個人任せ |

| データ学習制御 | オプトアウト設定可 | 再学習リスク不明 |

シャドーAIの厄介さは、利用動機が悪意ではない点にあります。同調査では、主な理由として業務効率化や生産性向上、新技術への好奇心が挙げられています。つまり禁止ルールは、最も意欲的で生産性の高い人材を、最も危険な利用環境へと追いやっているのです。

さらに、公式ツールが存在していても問題は解消されません。回答精度が低い旧モデルしか使えない、利用のたびに煩雑な承認が必要といった制約がある場合、従業員は自然と個人端末から高性能なパブリックAIへ流れます。PwCやIPAの分析でも、ルールの厳格さと現場の実務要求が乖離したとき、遵守率が急激に低下することが示唆されています。

この状況は組織内のリスク認識ギャップも浮き彫りにします。シャドーAIを利用しない層の約8割は、セキュリティやコンプライアンスを理由に慎重姿勢を取っています。一方で、利用者側は「禁止されているが、業務上やむを得ない」と考えており、同じ組織内でAIに対する価値観が完全に分断されています。

経営層が「禁止しているから安全だ」と認識している場合、このギャップは致命的です。実際には、管理も監査も及ばない場所で機密情報がプロンプトとして入力され続けている可能性があります。専門家の間では、これをガバナンス不全が生む逆説的リスクと呼び、単純な禁止策の限界を示す代表例と位置づけています。

シャドーAIの台頭は、生成AIがすでに社会インフラ化している現実を映し出しています。禁止という単線的な対応は、もはや抑止策ではなく、リスクの地下化を招く要因になっています。この逆説を直視できるかどうかが、2026年以降のAIガバナンスの成熟度を分ける分水嶺となっています。

経営層と現場に生じるリスク認識ギャップ

生成AIを巡る最大の構造的リスクの一つが、**経営層と現場の間に存在するリスク認識のギャップ**です。経営層はガイドライン策定や利用禁止をもって「統制できている」と認識しがちですが、現場では業務効率や成果創出のプレッシャーの中で、異なる判断軸が働いています。このズレは単なる意識差ではなく、ガバナンス不全そのものを生み出します。

IPAの調査によれば、生成AI利用を禁止している企業は26.2%存在しますが、その一方で、SIGNATEの調査では生成AI関心層の34.8%がシャドーAIを利用しています。**経営層が「禁止=安全」と考えるほど、現場では管理外利用が広がる逆説**が、統計的にも裏付けられています。

| 視点 | 経営層の認識 | 現場の実態 |

|---|---|---|

| 生成AI利用ルール | 明文化されており遵守されている | 業務上の必要から例外的に無視されがち |

| 主なリスク | 外部攻撃・情報漏洩 | 業務停滞・生産性低下 |

| AI利用の動機 | 慎重・防御的 | 効率化・品質向上 |

このギャップを拡大させている要因の一つが、**リスクの定義そのものが異なる**点です。経営層は「情報が漏れる可能性」を最大リスクと捉えますが、現場にとっての最大リスクは「納期遅延」や「品質低下」です。PwCの生成AI実態調査でも、現場主導での試行利用が多く、トップダウン型の統制が追いついていない実情が示されています。

さらに深刻なのは、経営層がリスクを「発生確率」で評価するのに対し、現場は「日常頻度」で判断している点です。生成AIは毎日の業務で即効性のある成果をもたらすため、**低確率だが高インパクトな漏洩リスクより、高頻度で発生する業務非効率の方が重く見える**のです。この認知の非対称性が、ルール逸脱を常態化させます。

IPAも、経営層と現場のリスク理解の乖離が内部統制を弱体化させると指摘しています。特に「ルール不徹底」が営業秘密漏洩原因の32.6%を占める事実は、**制度設計よりも運用理解の欠如が問題である**ことを示唆しています。

重要なのは、現場を「違反者」として管理する発想から脱却することです。生成AIを使いたいという現場の行動は、組織にとって価値創出のシグナルでもあります。**このシグナルを抑圧するほど、リスクは見えない場所に移動する**という現実を、経営層は直視する必要があります。

経営層と現場のリスク認識ギャップは、生成AIという技術がもたらした新しい課題ではなく、可視化された既存課題です。しかし、生成AIはその影響範囲と速度が桁違いであるため、放置すれば短期間で致命傷になり得ます。**共通言語としてのリスク定義を再設計できるかどうかが、2026年のガバナンス成熟度を分ける分水嶺**となります。

日本の法規制・政府ガイドラインから読み解く実務対応

日本の法規制や政府ガイドラインを踏まえると、生成AIへの機密情報入力に関する実務対応は、単なる社内ルール策定では完結しません。重要なのは、既存法令の延長線上でどのようにAIを位置づけ、どこまでを許容範囲と定義するかです。2025年以降、政府・関係機関の文書は「全面禁止」を前提とせず、管理可能性を重視する方向へ明確にシフトしています。

デジタル庁が2025年に公表した生成AI調達・利活用ガイドラインでは、入力データが再学習に使われるか否かを調達段階で確認することが強く求められています。これは行政向け文書ですが、実務的には民間企業にとっても事実上の基準点となっています。**契約上で再学習の有無を明示し、オプトアウト可能な設定を選択することが、法令順守の第一歩**になります。

| 観点 | 実務上の確認ポイント | 関係ガイドライン |

|---|---|---|

| 入力データ | 再学習への利用有無、ログ保存範囲 | デジタル庁 |

| 契約条項 | 秘密情報の定義と取扱い | JDLA |

| 個人情報 | 匿名化・マスキングの有無 | 個人情報保護委員会 |

契約実務の観点では、日本ディープラーニング協会が公開した生成AI開発契約ガイドラインの影響が大きいです。ここでは、ユーザー企業が入力したデータの権利帰属や、ベンダー側の秘密保持義務が具体的に整理されています。**「入力した瞬間に第三者の管理下に移る情報は何か」を法務部門が把握しているかどうか**が、実務リスクを大きく左右します。

個人情報保護法との関係も避けて通れません。個人情報保護委員会は、生成AIへの安易な個人情報入力が、目的外利用や越境移転の問題を引き起こす可能性を繰り返し指摘しています。特に海外事業者のAIサービスを利用する場合、本人同意や委託契約の整理が不十分だと、法令違反に直結するリスクがあります。

さらに見落とされがちなのが知的財産の観点です。専門家の解説によれば、未公開の発明情報を生成AIに入力した場合、特許法上の新規性喪失につながるおそれがあります。研究開発部門では、情報セキュリティ規程とは別に、**知財法務の視点から入力可否を判断する基準**を設けることが現実的な対応です。

これらを総合すると、日本の法規制・政府ガイドラインが示しているのは「生成AIは使うな」ではなく、「責任主体と管理方法を明確にしたうえで使え」というメッセージです。実務対応としては、データ分類、契約条項、技術的制御を一体で設計し、法令順守を理由に思考停止しない姿勢こそが、2026年以降のスタンダードになりつつあります。

個人情報保護・知的財産の観点から見た入力リスク

生成AIへの入力リスクを語る上で、最も本質的なのが個人情報保護と知的財産の観点です。多くの現場では「出力内容の妥当性」や「業務効率」に目が向きがちですが、**真のリスクは入力した瞬間に発生する不可逆な情報移転**にあります。

個人情報保護委員会が継続的に注意喚起している通り、生成AIサービスに氏名、連絡先、顧客属性、医療・金融情報などを入力した場合、そのデータがサービス提供事業者の管理下に置かれ、再学習やログ保存を通じて二次利用される可能性を完全には排除できません。特に海外事業者が提供するAIでは、越境データ移転が発生し、日本の個人情報保護法とは異なる法体系のもとで処理される点が、専門家の間でも強く懸念されています。

このリスクは「匿名化すれば安全」という単純な話ではありません。複数の属性情報を組み合わせることで個人が再識別されるリスクは、OECDや欧州データ保護会議でも繰り返し指摘されています。**一見すると個人を特定できない入力であっても、業務文脈そのものが個人情報になり得る**という点は、AI時代特有の盲点です。

| リスク区分 | 入力例 | 発生し得る問題 |

|---|---|---|

| 個人情報 | 顧客対応履歴、相談内容 | 再学習・ログ経由での二次流出 |

| 準個人情報 | 部署・役職・行動履歴 | 文脈からの個人特定 |

| 知的財産 | 未公開仕様、研究メモ | 権利喪失・競争優位の消滅 |

知的財産の観点では、さらに深刻な問題が存在します。特許法においては、発明が公知となった時点で新規性が失われる可能性があります。法務・知財分野の専門家が指摘するように、**未公開の発明内容やアルゴリズムの詳細をパブリックな生成AIに入力する行為は、事実上の公開と評価されるリスク**を伴います。これは研究開発部門に限らず、事業企画や新規サービス設計に携わる部門でも同様です。

また、生成AIへの入力は「秘密情報を第三者に開示した」と解釈される余地があります。日本ディープラーニング協会が公表している契約ガイドラインでも、プロンプトに含まれる情報の権利帰属や秘密保持義務が、従来のIT契約よりも複雑化する点が強調されています。**入力は単なる相談ではなく、法的には情報提供行為そのもの**であるという認識が不可欠です。

重要なのは、これらのリスクが悪意ある行為ではなく、善意の業務改善の中で発生する点です。顧客対応を改善したい、アイデアを整理したい、その自然な行動が、結果として法令違反や権利侵害につながりかねません。だからこそ、個人情報保護と知的財産の観点からは、「何を入力してはいけないか」を抽象論ではなく、具体的な業務シナリオで定義する必要があります。

生成AIは強力な知的補助輪ですが、入力内容の重みは人間側が引き受けなければなりません。**入力は思考ではなく行為であり、行為には必ず責任が伴う**。この前提を共有できるかどうかが、AI活用の成熟度を分ける分水嶺になります。

技術で守る生成AI活用:マスキング・DLP・専用環境

生成AI活用を現実解へと押し上げたのが、技術による防御線の高度化です。2026年時点で先進企業が共通して採用しているのは、禁止ではなく、入力内容そのものを安全化する設計思想です。人の注意力に依存せず、システム側で事故を起こさせない構造を作ることが、この領域の本質です。

中核となるのがデータマスキングです。IPAが指摘するように、営業秘密漏洩の多くは悪意ではなく運用ミスに起因します。その対策として、AIへの入力前に個人名、顧客ID、取引先名などを自動検知し、伏字やトークンへ変換する仕組みが標準化しました。欧米のプライバシー規制にも対応したK2viewなどの動的マスキングは、API通信の途中で処理を行うため、元データを一切改変しない点が評価されています。

次に重要なのがDLPの進化です。従来はメールやUSB対策が中心でしたが、現在は生成AIへの貼り付け操作そのものを監視します。Fortra DLPのような製品では、ブラウザ上でクレジットカード番号や社外秘ラベルを検知すると即座にブロックや警告を出します。PwCの調査でも、技術的制御を導入した企業ほどシャドーAI利用率が低下する傾向が示されています。

| 技術 | 防げる主なリスク | 特徴 |

|---|---|---|

| データマスキング | 個人情報・営業秘密の直接流出 | 入力前に自動加工、精度維持 |

| DLP | うっかり入力・内部不正 | リアルタイム検知と遮断 |

| 専用環境AI | 再学習・越境移転リスク | 外部ネットワークから隔離 |

そして最も強力な選択肢が、専用環境での生成AI運用です。東芝デジタルエンジニアリングのAI-no-teに代表されるオンプレミス型は、入力データが外部へ出ない構造そのものがセキュリティ対策になります。製造業では、未公開図面や障害履歴といった極秘情報をAIに解析させ、熟練工の知見を形式知化する用途で成果を上げています。

デジタル庁のガイドラインでも、入力データが再学習に使われないことを調達要件として明記する姿勢が示されました。これは技術選定がガバナンスそのものであるというメッセージです。安全な環境を用意せずに利用だけを禁止すれば、SIGNATEが示したようにシャドーAIはむしろ増えます。

**生成AI時代の防御は、禁止ではなく設計です。マスキング、DLP、専用環境を組み合わせることで、初めて安全と生産性が両立します。** この三層構造を持たない活用は、2026年以降、競争力以前にガバナンス不全と見なされる局面に入りつつあります。

実際のインシデント事例に学ぶ生成AI時代の脆弱性

生成AI時代の脆弱性は、理論上の懸念ではなく、すでに現実のインシデントとして顕在化しています。特に2025年前後に発生した複数の情報漏洩事例は、生成AIそのものではなくとも、生成AI利用と極めて親和性の高いリスク構造を内包しており、重要な教訓を与えています。

独立行政法人情報処理推進機構によれば、近年の情報漏洩は「高度なサイバー攻撃」と「人為的ミス」が複合的に絡むケースが主流です。生成AIは、入力されたプロンプトや参照データがログとして蓄積される点で、従来のSaaS以上に被害のインパクトが大きくなりがちです。

問題の本質は、AIそのものよりも「AIに接続された周辺システム」と「人間の運用」にあります。この視点で実際のインシデントを見直すと、生成AI時代に特有の脆弱性が浮かび上がります。

| 事例 | 発生年 | 生成AI時代への示唆 |

|---|---|---|

| PR TIMES 管理画面不正アクセス | 2025年 | クラウド上に蓄積された管理データは、認証突破で一気に露出する |

| 中央大学 メールアカウント侵害 | 2025年 | 日常業務データが知的資産として外部に流出する危険性 |

| NTT系基幹システム侵入 | 2025年 | API連携部分が新たな攻撃面になる可能性 |

例えばPR TIMESの事例では、SaaS型サービスの管理者権限が突破されたことで、内部情報が一挙に閲覧可能となりました。生成AIサービスでも、アカウントが侵害されれば、過去のチャット履歴や業務相談内容がそのまま流出します。これは単なるデータ漏洩ではなく、企業の意思決定プロセスや未公開戦略が露見することを意味します。

中央大学のケースは、メールという日常的なツールが知的資産の保管庫になっている現実を示しました。生成AIを文章作成や翻訳に用いる場合、その入力内容はメール以上に整理された「知識の塊」となります。攻撃者にとっては、断片的なメールよりも、生成AIの対話ログの方が価値が高いのです。

さらに注目すべきは、NTT関連のインシデントが示すAPI連携のリスクです。社内文書検索やRAG構成で生成AIを基幹データに接続している場合、プロンプトインジェクションなどを通じて、AIが“正規ルート”として情報を引き出してしまう危険があります。これは従来の境界防御では想定しにくい攻撃です。

これらの事例が共通して示すのは、「想定外の使われ方」が最大の脆弱性になるという点です。生成AIは便利であるがゆえに、ログ、履歴、連携データが過剰に集約されやすく、一度突破されると被害が連鎖的に拡大します。

PwCの調査でも、AI活用企業ほど「インシデント発生時の影響範囲が読みにくい」という課題を抱えていると指摘されています。生成AI時代のセキュリティとは、単に漏洩を防ぐことではなく、漏洩した場合に何が失われるのかを正確に把握し、設計段階で被害半径を小さくする思想そのものなのです。

先進企業・自治体に見る『攻めのガバナンス』モデル

生成AIガバナンスにおいて先進的な組織が共通して示しているのは、リスク回避を目的とした守りの統制ではなく、価値創出を前提とした攻めの設計です。禁止や萎縮ではなく、利用を前提にどう制御するかという発想転換が、2026年の競争力を左右しています。

その象徴的な事例が、神奈川県横須賀市の全庁的な生成AI活用です。同市はLGWAN内に閉じた利用環境を構築し、外部インターネットと物理的に隔離した上でChatGPTを導入しました。2025年時点の市職員アンケートでは、約95%が業務効率の向上を実感していると回答しています。**重要なのは、個人情報を入力しないという抽象的な注意喚起ではなく、マスキング前提の入力ルールと継続的な研修をセットで運用している点**です。

この取り組みは、デジタル庁の生成AI利活用ガイドラインが示す調達段階での安全確認や再学習回避の考え方とも整合します。自治体という高い説明責任を負う組織が、制度と技術を組み合わせることで実用段階まで踏み込んだことは、民間企業にとっても強い示唆となります。

| 主体 | ガバナンスの特徴 | 得られた効果 |

|---|---|---|

| 横須賀市 | 閉域網+明確な入力ルール | 職員の生産性向上と利用定着 |

| 製造業大手 | オンプレミスAIによる隔離 | ノウハウ継承と分析高度化 |

製造業やインフラ企業では、別の形の攻めが見られます。東芝デジタルエンジニアリングに代表されるオンプレミス型生成AIの採用は、機密情報を外に出さないための禁止ではなく、**安全な場所に閉じ込めて最大限活用する隔離戦略**です。設計図や不具合履歴といった社外秘データを前提にAIを使える環境は、熟練工不足という構造課題への実践的な解となっています。

さらに視野を広げると、サムスンが示唆したGalaxy AIの有料化は、AIがOSやデバイスに不可逆的に組み込まれる未来を物語ります。AIが日常機能になる世界では、入力禁止というルール自体が現実性を失います。**だからこそ先進組織は、入力を止めるのではなく、入力されたデータをどう守り、どう記録し、どう説明可能にするかに投資しているのです。**

IPAやPwCの調査が示す二極化の中で、これらの事例は明確な方向性を提示しています。生成AIを脅威とみなして遠ざけるのではなく、ガードレールを敷いた上で走らせる。この攻めのガバナンスこそが、2026年以降の先進企業・自治体を特徴づける共通言語になりつつあります。

『全面禁止』から『制御された適応』へ向かうパラダイムシフト

2026年に入り、生成AIガバナンスの議論は明確な転換点を迎えています。かつて主流だった「機密情報は一切入力禁止」という全面禁止型のルールは、現実の業務運用と乖離し、**リスク低減どころか新たなリスクを生む**ことが各種調査で裏付けられてきました。ここで起きているのは、禁止か許可かという二項対立から、「制御された適応」へと向かうパラダイムシフトです。

独立行政法人情報処理推進機構(IPA)の調査によれば、生成AIの利用を明確に禁止している企業は2025年時点で26.2%と依然として多く存在します。しかし同時に、SIGNATEの実態調査では、**禁止企業に所属する従業員の約3人に1人がシャドーAIを利用している**ことが示されました。これは、ルールが実態を抑止できていないことを意味します。

| 観点 | 全面禁止 | 制御された適応 |

|---|---|---|

| 表向きの安全性 | 高いが形骸化しやすい | 技術と運用で担保 |

| 実際の利用状況 | シャドーAIが横行 | 公式環境に集約 |

| 競争力への影響 | 中長期で低下 | 生産性と統制を両立 |

制御された適応とは、入力そのものを止めるのではなく、**「どの情報を・どの環境で・どの条件下なら入力可能か」を精緻に設計する考え方**です。デジタル庁の生成AIガイドラインが示すように、再学習の有無を契約で管理し、入力データを技術的に制御することで、リスクは連続的に下げられます。

重要なのは、この転換が思想レベルではなく、実務レベルで進んでいる点です。オンプレミス型生成AI、動的データマスキング、DLPによるリアルタイム監視などにより、**「安全だから禁止」ではなく「制御できるから使う」**という判断が可能になりました。PwCの分析でも、こうした制御型アプローチを取る企業ほど、AI活用とセキュリティ成熟度を同時に高めていることが示唆されています。

全面禁止は分かりやすい一方で、変化の速いAI環境では持続しません。制御された適応は、曖昧で妥協的な選択ではなく、**技術・契約・人の判断を前提にした高度なガバナンス戦略**です。この発想転換こそが、2026年以降の生成AI活用の成否を分ける分水嶺になりつつあります。

参考文献

- PwC Japan:生成AIに関する実態調査 2025春 5カ国比較

- SIGNATE:AI活用実態調査レポート2025年12月版

- デジタル庁:行政の進化と革新のための生成AIの調達・利活用に係るガイドライン

- 一般社団法人日本ディープラーニング協会(JDLA):生成AI開発契約ガイドライン

- 個人情報保護委員会:生成AIサービスの利用に関する注意喚起等について

- 横須賀市:生成AIを活用した24時間365日の相談サービス