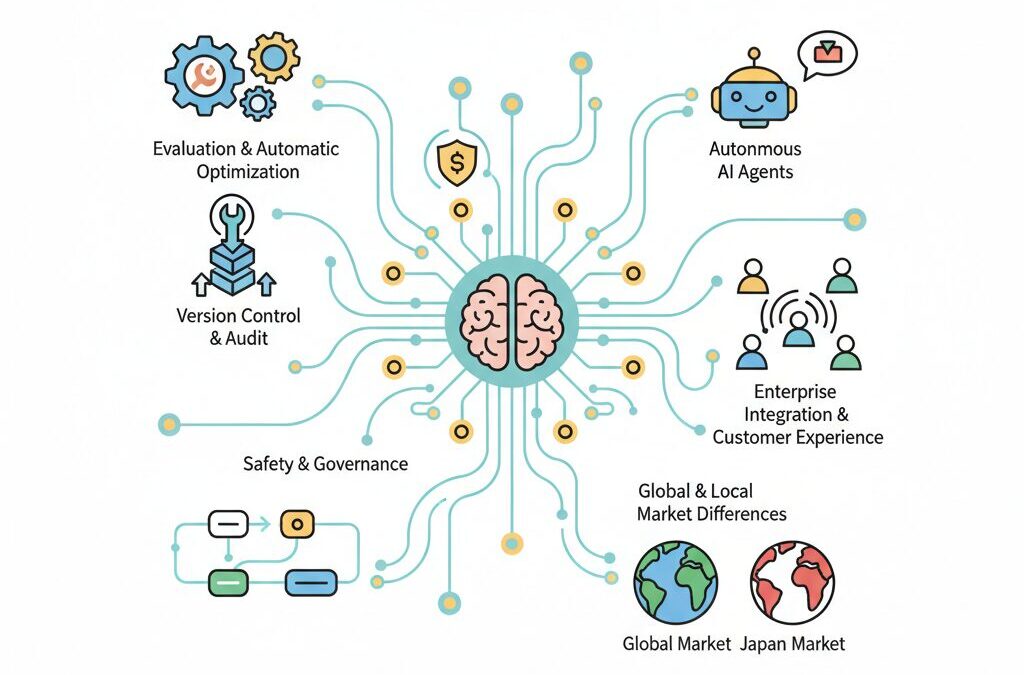

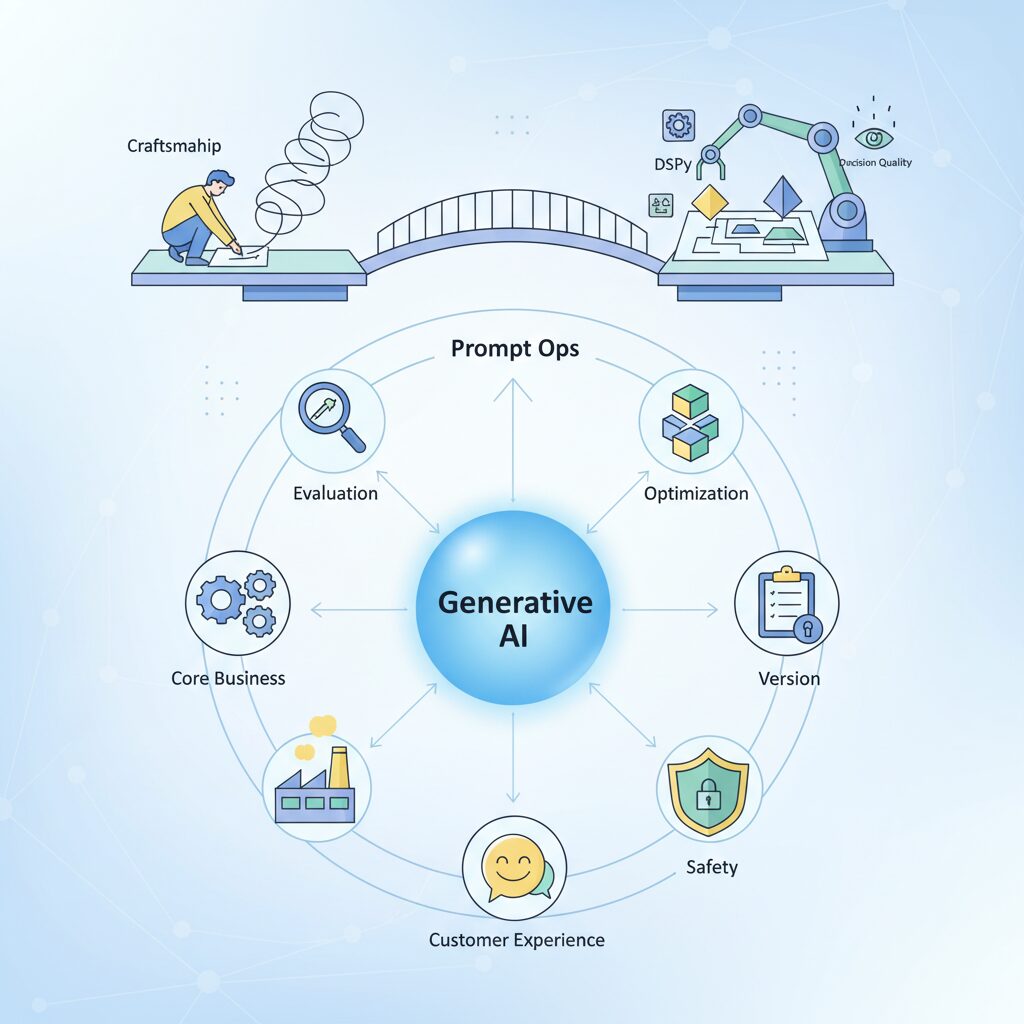

生成AIは試験的なPoCの段階を終え、いまや企業の基幹業務や顧客体験を支える中核技術となりました。特に2026年現在、注目を集めているのが「Prompt Ops」という新しい実践領域です。これは単なるプロンプト作成のテクニックではなく、AIを安全かつ継続的に価値創出させるための運用思想そのものを指します。

かつて職人技とされてきたプロンプト設計は、評価・自動最適化・バージョン管理・監査といったエンジニアリングの対象へと進化しました。DSPyや自動プロンプト最適化、Decision Qualityといった概念は、AI専門家にとって無視できない必須知識になりつつあります。

本記事では、自律型AIとエージェンティックAIが前提となる2026年の環境において、Prompt Opsがなぜ不可欠なのかを整理します。グローバルと日本市場の違い、最新ツール、実際の企業事例、そしてキャリアへの影響までを俯瞰的に理解することで、読者の皆さまが次の一手を描けることを目指します。

2026年に起きたAI実装のパラダイムシフト

2026年に起きた最大の変化は、生成AIの位置づけが「試す技術」から「止められない社会インフラ」へと完全に転換した点にあります。2023〜2024年に多くの企業が取り組んだPoC中心の活用はすでに役割を終え、現在のAIは基幹業務、顧客接点、意思決定支援といった中枢領域に深く組み込まれています。**AIを止めることが事業停止に直結する**、その現実が実装思想そのものを変えました。

この転換を象徴するのが、プロンプトの扱いの変化です。かつては一部の担当者が試行錯誤で調整する属人的ノウハウでしたが、2026年のエンタープライズ環境では、**プロンプトはコードと同等の管理対象であり、監査可能な組織資産**として扱われています。Mordor Intelligenceの市場分析によれば、エンタープライズAI市場の成長はモデル性能よりも運用・管理レイヤーへの投資が牽引しており、この傾向は不可逆的とされています。

| 観点 | PoC時代 | 2026年の実装 |

|---|---|---|

| プロンプト | 個人の工夫 | 組織で管理する資産 |

| 品質保証 | 目視確認 | 自動評価と監査ログ |

| 責任所在 | 担当者依存 | 組織的ガバナンス |

この構造変化を体系化した概念がPrompt Opsです。DevOpsやMLOpsの思想を生成AIに拡張し、設計・テスト・デプロイ・監視・セキュリティまでを一気通貫で扱います。スタンフォード大学を中心とした研究動向でも、**「正しい出力を出し続けられるか」という信頼性工学の重要性**が繰り返し強調されています。もはや一度うまく動けば良い、という発想は成立しません。

背景にあるのがエージェンティックAIの普及です。AIが自律的に計画し、複数のツールやプロンプトを連鎖的に実行する環境では、単一プロンプトの最適化では全体挙動を制御できません。**ワークフロー全体を前提とした設計と監視**が不可欠となり、Prompt Opsは複雑性に対する実装上の回答として定着しました。

さらに、EUのAI法や日本のAIセーフティ・インスティテュートによるガイドラインは、透明性と説明責任を企業に強く求めています。どのバージョンのプロンプトが、誰の承認で使われ、なぜその出力に至ったのかを説明できなければ、AIは使えません。**2026年のAI実装とは、技術導入ではなく、責任を引き受ける体制づくり**そのものなのです。

Prompt Opsとは何か:プロンプトを資産として扱う思想

Prompt Opsとは、プロンプトを一過性の入力文ではなく、継続的に価値を生み出す「組織的な資産」として扱うための思想と運用体系を指します。2023〜2024年に流行したプロンプトエンジニアリングが、個人の試行錯誤や属人的ノウハウに依存していたのに対し、Prompt Opsはその限界を明確に超える概念です。

2026年現在、多くの企業では生成AIが基幹業務や顧客接点に深く組み込まれています。この段階では、たまたまうまく動くプロンプトでは不十分で、再現性・説明責任・改善可能性が求められます。Mordor Intelligenceなどの市場調査でも、エンタープライズAIの成否はモデル性能より運用設計に左右される比重が急速に高まっていると指摘されています。

Prompt Opsの核心は、プロンプトをコードや設定ファイルと同様にライフサイクル管理する点にあります。誰が、いつ、どの目的で作成し、どの環境で使われ、どのような結果を生んだのかを追跡できる状態を作ります。これはDevOpsやMLOpsの考え方を生成AIの入力層にまで拡張したものだと理解すると分かりやすいです。

| 観点 | 従来のプロンプト | Prompt Ops的扱い |

|---|---|---|

| 位置づけ | 一時的な指示文 | 再利用可能な資産 |

| 管理方法 | 個人のメモやSlack | バージョン管理・承認フロー |

| 評価 | 主観的な良し悪し | 指標に基づく継続評価 |

特にエージェンティックAIの普及は、この思想を不可逆的なものにしました。複数のプロンプトが連鎖し、意思決定やツール実行にまで影響を与える環境では、単一プロンプトの最適化では全体品質を保証できません。Prompt Opsは、ワークフロー全体を一つのシステムとして捉え、プロンプト同士の相互作用まで含めて管理するための前提条件になります。

さらに、EUのAI法や日本のAIセーフティ・インスティテュートのガイドラインが示すように、なぜその出力に至ったのかを説明できることは法的・社会的要請になりつつあります。どのバージョンのプロンプトが使われたのかを記録・監査できる仕組みは、もはや技術的な贅沢ではありません。

このようにPrompt Opsとは、単なる運用手法ではなく、生成AIを信頼できる業務パートナーとして扱うための思想的転換です。プロンプトを資産として扱うかどうかが、AI活用を実験で終わらせる企業と、競争優位を築く企業の分水嶺になっています。

エージェンティックAI時代にプロンプト管理が崩壊する理由

エージェンティックAIの普及によって、従来のプロンプト管理は根本から限界を迎えています。最大の理由は、もはやAIが単一プロンプトで完結する存在ではなくなった点にあります。2025年以降に主流化したエージェント型アーキテクチャでは、AIは自律的に計画を立て、ツールを選択し、複数の内部プロンプトを連鎖的に実行します。人間が一文ずつ最適化してきた従来の管理手法では、この振る舞い全体を把握できません。

スタンフォード大学のDSPy研究が示すように、現代のLLMシステムではプロンプトは固定文字列ではなく、最適化アルゴリズムによって動的に生成される構成要素になっています。つまり本番環境では、実行のたびに異なるプロンプトが生成される可能性があり、「最新版の正解プロンプト」という概念そのものが成立しなくなっているのです。

この構造変化により、個人管理やスプレッドシートによる管理は即座に破綻します。どのエージェントが、どの文脈で、どの中間プロンプトを使い、どんな判断を下したのかを追跡できなければ、障害解析も品質改善も不可能です。Google DeepMindのOPROなど、LLM自身がプロンプトを改善する手法が実用化したことで、この問題はさらに顕在化しました。

| 観点 | 従来型プロンプト管理 | エージェンティックAI環境 |

|---|---|---|

| プロンプト数 | 人間が把握可能 | 動的に増殖 |

| 変更主体 | 人間 | 人間+AI |

| 再現性 | 比較的高い | 低下しやすい |

さらに深刻なのがガバナンス面です。EU AI法や日本のAIセーフティ・インスティテュートのガイドラインでは、AIの判断根拠とプロンプトのトレーサビリティが求められています。エージェント内部で生成・変形されるプロンプトを記録できない管理体制は、法的にも運用的にも許容されません。

現場ではすでに破綻の兆候が報告されています。複数エージェントが連携するシステムで、一部の内部プロンプト変更が想定外の行動を誘発し、原因特定に数週間を要した事例もあります。BCGの分析によれば、自律型AI導入企業の多くが「挙動の説明不能性」を主要リスクとして挙げています。

要するに、エージェンティックAI時代においてプロンプトは管理対象ではなく、観測・評価・最適化され続けるプロセスになりました。静的なプロンプト管理は、この動的システムに耐えられず崩壊する運命にあるのです。

DSPyが変えたプロンプト設計と最適化の常識

DSPyの登場は、プロンプト設計における前提そのものを根底から覆しました。従来のプロンプト設計は、人間が自然言語で最適な指示文を試行錯誤しながら書き上げる、いわば職人技に依存していました。しかしDSPyでは、その発想が大きく転換されます。開発者が行うのは文章を書くことではなく、**モデルに期待する振る舞いを宣言的に定義すること**です。

スタンフォード大学の研究チームが提唱したDSPyでは、「入力は何で、出力は何か」というシグネチャと、推論や生成の構造を示すモジュールのみをコードとして記述します。具体的なプロンプト文やFew-Shot例は、人間の手を離れ、テレプロンプターと呼ばれる最適化アルゴリズムが自動生成します。この仕組みにより、プロンプトは可読性の低い文字列ではなく、**評価可能で再現性のあるソフトウェア構成要素**として扱われるようになりました。

| 観点 | 従来の手動設計 | DSPy以降 |

|---|---|---|

| 設計単位 | 自然言語の文章 | シグネチャとモジュール |

| 最適化方法 | 人間の試行錯誤 | アルゴリズムによる探索 |

| 再利用性 | 低い | 高い |

| モデル変更時 | 全面書き直し | 再最適化のみ |

この変化が実務に与えた影響は極めて大きいです。DSPyを用いた研究では、人間が丹念に作り込んだプロンプトと比較して、コード生成やハルシネーション検出といったタスクで精度が大幅に向上したことが報告されています。arXivで公開された実証研究によれば、正答率が46.2%から64.0%へ改善したケースも確認されています。これは、最適化の探索空間を人間の直感に限定せず、データと評価指標に基づいて機械的に探索できるようになった成果です。

さらに重要なのは、**プロンプトがモデル非依存になった点**です。DSPyでは、GPT系モデルからLlama系モデルへ切り替えた場合でも、プロンプト文を書き直す必要はありません。同じ宣言的定義のもとで再最適化を行うだけで、新しいモデル特性に適応したプロンプトが生成されます。これにより、モデル選定とプロンプト設計が疎結合になり、エンタープライズ環境で求められる長期運用と柔軟性が飛躍的に高まりました。

DSPyが変えた最大の常識は、「良いプロンプトを書く」ことよりも、「良い評価関数を設計する」ことの重要性を明確にした点です。

実際、DSPyを活用する現場では、エンジニアの関心はプロンプト文言そのものではなく、「どのデータで最適化するのか」「何を正解とみなすのか」という評価設計に向かっています。Google DeepMindやスタンフォードの研究動向を見ても、LLMをオプティマイザとして用いる自己反省型手法や、進化的アルゴリズムとの組み合わせが主流になりつつあります。

このようにDSPyは、プロンプト設計を感覚的な作業から工学的プロセスへと昇華させました。結果として、プロンプトはもはや調整対象ではなく、**継続的に改善されるシステムの一部**として位置づけられています。この価値観の転換こそが、Prompt Ops時代の最も象徴的な変化だと言えるでしょう。

自動プロンプト最適化(APO)の主要アプローチ

自動プロンプト最適化(APO)は、2026年時点のPrompt Opsにおいて中核的な技術領域となっています。人手による試行錯誤を前提とした従来のプロンプト設計は、エージェンティックAIや大規模運用の現場では限界が明確になり、アルゴリズム主導でプロンプトを進化させるアプローチが不可欠になりました。

2025年に公開されたスタンフォード大学やACL系会議のサーベイ論文によれば、APOは主に三つのアプローチに体系化されています。それぞれは排他的ではなく、実運用では組み合わせて使われるケースが増えています。

| アプローチ | 特徴 | 強み |

|---|---|---|

| LLM自己最適化 | LLMが自身の出力を評価しプロンプトを修正 | 人間が気づかない言語的ニュアンスを発見 |

| 勾配ベース最適化 | プロンプトを連続ベクトルとして学習 | 特定タスクで極めて高い性能 |

| 進化的アルゴリズム | 遺伝的操作でプロンプトを探索 | 局所解に陥りにくく多様性が高い |

第一の「LLMによる自己反省と書き換え」は、LLM-as-an-Optimizerとも呼ばれます。Google DeepMindが提案したOPROでは、モデル自身に失敗理由を言語化させ、その分析結果を基にプロンプトを更新します。論文では、数学推論やコード生成タスクにおいて、人手設計を上回る精度改善が報告されています。評価と改善を同一モデルで閉じる点が、この手法の最大の特徴です。

第二の勾配ベース最適化は、プロンプトチューニングとして知られています。プロンプトを人間可読な文章ではなく埋め込みベクトルとして扱い、誤差逆伝播で更新します。生成されるプロンプトは解釈困難ですが、arXivの報告では中小規模モデルでも大規模LLMに匹敵する性能を示す例が確認されています。これは性能を優先する業務特化AIで特に重宝されています。

第三の進化的アルゴリズムは、複数のプロンプト候補を世代交代させながら探索します。評価指標が非連続でも機能するため、意思決定支援や創造的タスクとの相性が良いとされています。2026年現在、金融やSRE領域で用いられるDecision Quality指標と組み合わせ、安定した改善ループを構築する事例が増えています。

重要なのは、これらのAPO手法が評価関数の設計能力をエンジニアに強く要求する点です。BCGの分析によれば、最適化アルゴリズムそのものよりも、何を良しとするかを定義できる人材が競争力の源泉になると指摘されています。APOは単なる自動化技術ではなく、組織の意思決定基準をAIに埋め込むための装置として位置づける必要があります。

評価指標の進化とDecision Qualityという考え方

生成AIの社会実装が進むにつれ、評価指標そのものが限界を迎えていることが明らかになってきました。BLEUやROUGEのような従来指標は、語彙や表現の一致度を測るには有効ですが、**その出力が実際の意思決定に役立つかどうか**までは捉えきれません。2026年のPrompt Opsでは、評価の焦点が「正しく書けたか」から「正しい判断につながったか」へと大きく移行しています。

この文脈で注目されているのがDecision Quality(DQ)という考え方です。DQは、生成AIの出力を最終成果物として評価するのではなく、**その出力を使った人間やシステムの意思決定の質**を測ろうとする指標です。スタンフォード大学やSREコミュニティの研究によれば、DQに基づく評価は専門家によるレビュー結果と高い相関を示し、実運用に耐えることが示されています。

Decision Qualityは主に三つの観点から構成されます。妥当性、具体性、正確性です。妥当性はその判断が現実的かどうか、具体性は曖昧さを排除できているか、正確性は事実誤認やハルシネーションがないかを見ます。重要なのは、これらが単独ではなく、**組み合わさって初めて意思決定の質を担保する**点です。

| 評価観点 | 評価対象 | 実務での意味 |

|---|---|---|

| 妥当性 | 論理構造・実行可能性 | そのまま行動に移せるか |

| 具体性 | 数値・手順・条件 | 解釈のブレを防げるか |

| 正確性 | 事実・根拠 | 誤判断のリスクを抑えられるか |

特にエージェンティックAIの時代では、DQの重要性が一段と高まります。AIエージェントは複数の判断を連鎖的に行うため、初期出力のわずかな質の低下が、最終結果に大きな影響を及ぼします。Google DeepMindやarXivで公開されたマルチエージェント研究では、**中間判断をDQで評価しフィードバックすることで、最終的な意思決定精度が安定する**ことが報告されています。

日本企業でも実践は始まっています。トヨタコネクティッドやメルカリでは、ゴールデンクエリセットを用意し、DQスコアをCIパイプラインに組み込むことで、プロンプトやモデル更新時の意思決定品質を自動検証しています。これはテスト駆動開発の発想を評価に拡張したもので、**評価が設計を規定する**という新しい開発文化を生み出しています。

評価指標の進化は、Prompt Opsの成熟度を測るリトマス試験紙でもあります。何を良しとするかを定義できない組織は、AIを最適化することもできません。Decision Qualityは単なる新指標ではなく、**AIを意思決定パートナーとして扱うための前提条件**として、2026年以降の標準になりつつあります。

2026年のPrompt Opsツールエコシステム概観

2026年のPrompt Opsツールエコシステムは、単一の万能ツールを中心に据える世界ではなく、役割ごとに最適化された複数レイヤーが疎結合で連携する構造へと明確に進化しています。かつては「どのプロンプト管理SaaSを使うか」が主な関心事でしたが、現在は設計、実行、評価、監査という各工程をどう分離し、どう統合するかが競争力を左右しています。

この変化を理解する鍵が、Prompt Opsを「ツール」ではなく「エコシステム」として捉える視点です。スタンフォード大学のDSPy研究が示したように、プロンプトは静的なテキストではなく、実行時に生成・最適化される構成要素になりました。その結果、エコシステムは生成系、実行制御系、可観測性・評価系という三層構造を取るようになっています。

| レイヤー | 主な役割 | 代表的機能 |

|---|---|---|

| 生成・定義層 | 振る舞いの抽象定義 | 宣言的プロンプト、モジュール化、再利用 |

| 実行・制御層 | ワークフロー運用 | エージェント連携、RAG制御、権限制御 |

| 可観測・評価層 | 品質と信頼性の保証 | トレーシング、自動評価、監査ログ |

特に2026年を特徴づけるのが、可観測性と評価を中心に据えたツール群の存在感です。Langfuseに代表される可観測性プラットフォームは、単なるログ収集を超え、エージェントの意思決定経路や中間生成物まで追跡可能にしました。これは、EUのAI法や日本のAISIガイドラインが求める説明責任に直接応えるものであり、事実上の業界標準になりつつあります。

また、Difyのようなビジュアル指向ツールが担う役割も再定義されています。ノーコード開発の利便性だけでなく、運用フェーズでの自動修復やプロンプト最適化支援が評価され、非エンジニアを含む組織全体をPrompt Opsに巻き込むハブとして機能しています。市場調査会社Mordor Intelligenceによれば、エンタープライズAI導入の失敗要因の多くは運用段階に集中しており、この層の厚みがROIを左右すると指摘されています。

日本市場では、これらのグローバルツールに国産プラットフォームが重なり合う形でエコシステムが形成されています。富士通や日立の基盤は、セキュリティと監査を前提にPrompt Opsを内包し、SIer主導の統合モデルを成立させました。ツール選定そのものがガバナンス設計の一部になった点は、2026年ならではの特徴です。

総じて言えば、2026年のPrompt Opsツールエコシステムは「どれが最強か」を競う段階を終え、「どう組み合わせ、どう運用するか」を問う成熟期に入っています。この全体像を把握できるかどうかが、AI専門家としての次の差別化要因になっています。

グローバル標準ツールと日本市場での適応

グローバル標準ツールと日本市場での適応を考える際、2026年時点でのPrompt Opsは単なるツール選定ではなく、組織文化と市場特性の翻訳作業になっています。欧米でデファクトとなっているLangfuseやPromptLayer、Difyといったツール群は、APIファーストで高い拡張性を持ち、OSSコミュニティと連動しながら急速に進化しています。特にLangfuseは、LLMのトレーシングやコスト、レイテンシを可視化する可観測性の高さが評価され、スタンフォード大学発のDSPyのようなプログラマティック・プロンプティングとも親和性が高いとされています。

一方で、日本市場では同じツールをそのまま導入しても成功しないケースが少なくありません。経済産業省やAIセーフティ・インスティテュートのガイドラインが求めるトレーサビリティや承認プロセスへの対応、そして日本語特有の文脈依存性の高さが、運用設計に大きな影響を与えます。Forbes Japanが指摘するように、日本企業はSaaSの寄せ集めよりも、SIerや大手ベンダーが提供する統合プラットフォームを好む傾向が強く、Prompt Opsも例外ではありません。

| 観点 | グローバル標準 | 日本市場での適応 |

|---|---|---|

| 設計思想 | 開発者体験と拡張性重視 | 統制・承認プロセス重視 |

| 言語対応 | 英語中心の最適化 | 日本語特化モデルや辞書連携 |

| 導入形態 | セルフサービス型SaaS | SIer主導の包括導入 |

このギャップを埋める動きとして注目されているのが、グローバルツールのローカライズと国産基盤の併用です。PromptLayerが日本語特化モデルや量子化モデルまでサポートを広げているのは象徴的な例であり、海外ツール側も日本市場を無視できなくなっています。同時に、PKSHA Technologyや富士通のKozuchiのように、Prompt Opsを含むLLMOps全体を国内要件に合わせて再構成するアプローチも広がっています。

実際、メルカリやトヨタコネクティッドの事例が示すように、グローバルな設計思想を取り入れつつ、日本独自の評価駆動開発や防御層を追加することで、Prompt Opsは初めて実用段階に到達します。グローバル標準をそのまま受け入れるのでも、国産に閉じるのでもなく、両者を前提にした設計力こそが、日本市場における競争優位の源泉になりつつあります。

国産プラットフォームが選ばれる背景

国産プラットフォームが選ばれる最大の背景には、日本企業特有のリスク認識と意思決定プロセスがあります。生成AIがPoCの段階を越え、基幹業務や顧客接点に深く組み込まれた2026年現在、評価軸は性能やコストだけでは不十分です。**長期運用に耐えるガバナンス、説明責任、そして万一の際の対応力**が、ツール選定の中核に据えられています。

とりわけ強い要因となっているのが、法規制と準拠要求への対応です。日本ではAIセーフティ・インスティテュート(AISI)や経済産業省のガイドラインにより、プロンプトの変更履歴、承認フロー、監査ログの保存といった運用レベルの透明性が求められています。**これらを前提条件として設計されている国産プラットフォームは、追加開発なしで規制対応を満たしやすい**点が評価されています。

加えて、日本語処理の最適化は依然として無視できない差別化要因です。日本語は文脈依存性が高く、敬語や省略表現による意味の揺らぎが大きいため、海外製ツールでは評価設計やエラーハンドリングが難しい場面が残ります。国内ベンダーは、日本語LLMや業務データでの検証を前提に、**評価指標やハルシネーション抑制ロジックを日本語特化で実装**しており、実務での安定性に直結しています。

| 観点 | 国産プラットフォーム | 海外プラットフォーム |

|---|---|---|

| 規制・監査対応 | AISI・政府調達要件を前提に設計 | 追加設定や独自実装が必要な場合が多い |

| 日本語最適化 | 日本語LLM・業務文書での検証が豊富 | 英語中心、評価はユーザー任せ |

| サポート体制 | 日本語・対面支援、SI連携が充実 | 英語中心、セルフサポートが基本 |

サポートと責任分界の明確さも重要です。日本企業では障害時や事故時に「誰が説明し、誰が是正するのか」が厳しく問われます。富士通や日立、PKSHA Technologyのような国産ベンダーは、ツール提供にとどまらず運用設計や改善プロセスまで含めた伴走型支援を行い、**ベンダー自身が説明責任の一部を担う体制**を構築しています。これはセルフサービス型SaaSとは根本的に異なる価値です。

さらに、既存IT資産との親和性も選定理由として大きいです。多くの日本企業はレガシーシステムやオンプレミス環境を抱えており、生成AIだけを切り離して導入することができません。国産プラットフォームはSIerとの連携を前提に、ID管理、ログ基盤、既存データレイクとの統合を含めたPrompt Ops基盤を提供し、**全社アーキテクチャの一部としてAIを組み込める**点が評価されています。

海外調査機関BCGも、AI活用が進むほど「技術力そのものより、運用と組織への適合性が競争優位を左右する」と指摘しています。国産プラットフォームが選ばれているのは、性能で海外勢に劣るからではありません。**日本企業の意思決定構造、リスク許容度、言語と文化に最適化された“運用の完成度”が、結果として合理的な選択となっている**ことが、本質的な背景です。

日本企業に学ぶPrompt Ops実践事例

日本企業におけるPrompt Opsの実践は、単なる技術導入ではなく、既存の業務プロセスや組織文化とどのように融合させるかという点に特徴があります。特に公開情報から確認できる先進事例では、評価・ガバナンス・現場適応の三点が一貫した軸として浮かび上がります。

象徴的なのがトヨタコネクティッドの取り組みです。同社はデジタル取扱説明書に生成AIを組み込むにあたり、プロンプトを「防御対象の運用資産」として管理しています。マニュアル記載内容のみを根拠に回答させる認識論的プロンプトを採用し、さらに入力段階でプロンプトインジェクションを検知・遮断するガーディアン層を設けています。ZenMLの事例分析によれば、こうしたPrompt Ops設計により、ハルシネーションを実運用レベルで抑制しつつ、顧客接点への展開を可能にしています。

一方、メルカリの事例はPrompt Opsを組織変革の装置として位置づけている点が際立ちます。同社AIチームはFOSSASIA Summit 2025で、評価駆動開発を中核としたLLMOps基盤を公表しました。プロンプト修正の前に評価指標とゴールデンクエリを定義し、変更のたびに自動回帰テストを実行します。これにより、個々のエンジニアの勘や経験に依存せず、組織全体で再現性のあるPrompt Opsが成立しています。

| 企業 | 主な適用領域 | Prompt Opsの要点 |

|---|---|---|

| トヨタコネクティッド | 顧客向けデジタルマニュアル | 防御層と評価自動化による信頼性確保 |

| メルカリ | 全社AIプロダクト開発 | 評価駆動開発による標準化 |

さらにリクルートでは、採用業務におけるスカウト文面や要件定義を対象に、検証済みプロンプトをライブラリ化し、誰が使っても一定品質を担保できる運用を構築しています。これはPrompt Opsを属人化排除の仕組みとして活用した好例です。

これらの事例に共通するのは、Prompt Opsを「賢い指示文を書く技術」ではなく、品質・説明責任・再現性を担保する運用基盤として捉えている点です。スタンフォード大学のDSPy研究が示すように、プロンプトをコード同様に扱う潮流は、日本企業においても既に実践段階に入っています。

セキュリティ・ガバナンスとPrompt Opsの役割

生成AIが基幹業務に組み込まれるにつれ、セキュリティとガバナンスは付加的な配慮ではなく、設計段階から組み込むべき前提条件になっています。特に2026年のエンタープライズ環境では、プロンプト自体がシステム挙動を左右する制御層であり、その管理不全は即座に情報漏洩や不正操作につながります。ここで中核的な役割を果たすのがPrompt Opsです。

Prompt Opsは、プロンプトを「誰が・いつ・どの目的で・どのバージョンを使ったのか」を追跡可能にし、ガバナンス要件を技術的に担保する運用基盤として機能します。EUのAI法や日本のAIセーフティ・インスティテュート(AISI)のガイドラインが求める説明責任に対し、属人的な管理では対応できません。

たとえば、Prompt Opsではプロンプトの変更履歴、承認フロー、実行ログが自動的に保存されます。これにより、問題発生時に「なぜその出力が生成されたのか」を再現可能な形で説明できます。これは金融や医療、公共領域でAIを運用する際の最低条件になりつつあります。

| 観点 | 従来の管理 | Prompt Ops導入後 |

|---|---|---|

| プロンプト管理 | 個人依存・非共有 | バージョン管理と承認制 |

| 監査対応 | 事後調査が困難 | 監査ログで即時対応 |

| セキュリティ対策 | 場当たり的 | 設計段階から組み込み |

セキュリティ面で特に重要なのが、Prompt Opsと防御技術の統合です。OWASPが公表しているLLM向けトップリスクでは、プロンプトインジェクションや機密情報漏洩が依然として上位に挙げられています。Prompt Ops環境では、危険な入力を検知するガードレール、レッドチーミング用のテストプロンプト、異常出力を検出する評価指標をCI/CDに組み込み、継続的に検証します。

これは「AIを信頼する」のではなく、「信頼できる状態を運用で作り続ける」ための仕組みです。AISIが推奨するレッドチーミング手法も、Prompt Ops上でテストケースとして管理することで初めてスケール可能になります。

さらに、エージェンティックAIの普及により、ガバナンスの対象は単一プロンプトからワークフロー全体へ拡張されています。どのプロンプトがどの権限でツールを呼び出したのか、過剰な権限行使がなかったかを監視することは、人間の内部統制と同等の重要性を持ちます。

結果として、Prompt Opsはセキュリティ部門、法務、開発チームをつなぐ共通言語となりつつあります。技術と統制を分断せず、同じ運用基盤で扱うことが、2026年以降のAIガバナンスにおける現実的な解であると、複数の国際的な調査や企業事例が示しています。

市場動向とPrompt Ops人材のキャリア展望

2026年におけるPrompt Ops市場は、生成AIブーム後の調整局面を経て、実運用を前提としたインフラ型市場として急速に拡大しています。Mordor Intelligenceなどの市場調査によれば、エンタープライズAI市場は年率30%超の成長が見込まれており、その中でもPrompt OpsやLLMOpsは「失敗できない本番運用」を支える中核領域として投資が集中しています。

特に顕著なのは、PoC止まりのAI施策が淘汰され、評価・監査・改善を継続できる組織だけがAI活用をスケールさせている点です。BCGが指摘するように、AIは人材戦略を上回る速度で進化しており、Prompt Opsは技術というより経営リスク管理の装置として位置づけられ始めています。

この市場動向は、人材の役割定義にも直接的な影響を与えています。かつて注目を集めた「プロンプトを書く専門職」は急速に姿を変え、現在ではプロンプトをコードとして管理し、CI/CDや評価指標と結びつけて運用できる人材が強く求められています。Stanford大学のDSPy研究が示したように、手動調整よりも自動最適化を設計できるエンジニアの方が、再現性と事業価値の両面で優位に立っています。

| 人材レベル | 主な役割 | 年収レンジ(日本) |

|---|---|---|

| エントリー | 既存プロンプトの運用・改善 | 500〜600万円 |

| ミドル〜シニア | Prompt Ops基盤設計・評価自動化 | 800〜1200万円 |

| エキスパート | AI戦略・ガバナンス設計 | 1500万円以上 |

このような年収の二極化は、ERIやSalaryExpertの調査でも裏付けられており、単なるツール利用者と運用全体を設計できる人材との差が拡大しています。特に日本市場では、金融・製造・公共分野を中心にガバナンス要件が厳しく、Prompt Ops人材はIT部門だけでなく法務やリスク管理と連携できることが評価されます。

今後のキャリア展望として重要なのは、Prompt Opsが一過性の職種ではなく、「自律型AIを管理するための恒常的な専門領域」になりつつある点です。AIエージェントが増えるほど、人間は直接作業するのではなく、AIの振る舞いを評価・調整する立場へ移行します。Prompt Ops人材はその中心に立ち、AI時代の品質保証と意思決定を担う職能として、長期的な市場価値を持ち続けると考えられます。

参考文献

- Mordor Intelligence:Enterprise AI Market – Share, Trends & Size 2025 – 2030

- Stanford HAI:DSPy: Compiling Declarative Language Model Calls into State-of-the-Art Pipelines

- arXiv:Is It Time To Treat Prompts As Code? A Multi-Use Case Study For Prompt Optimization Using DSPy

- arXiv:A Systematic Survey of Automatic Prompt Optimization Techniques

- Langfuse:Langfuse Documentation

- ZenML:Enterprise-Wide LLM Framework for Manufacturing and Knowledge Management (Toyota)

- Japan AI Safety Institute:Guide to Red Teaming Methodology on AI Safety (Version 1.10)