「データマイニング」と聞いて、統計解析や過去データの分析を思い浮かべる方は多いのではないでしょうか。

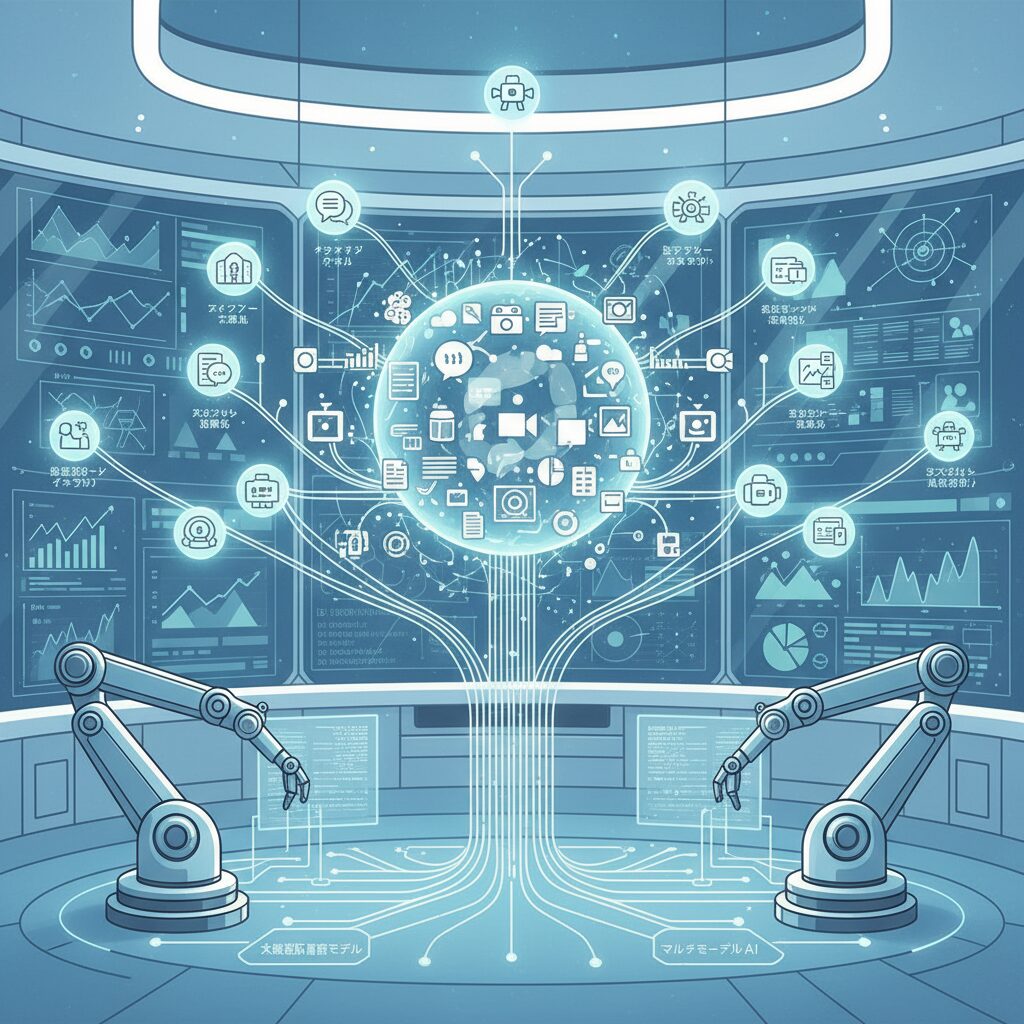

しかし2026年現在、その常識は大きく塗り替えられつつあります。大規模言語モデルやマルチモーダルAIの進化により、データマイニングは単なるパターン抽出から、意味理解や意思決定支援を担う存在へと変貌しています。

企業が保有するデータの大半を占める非構造化データが本格的に活用され、画像・音声・動画・テキストを横断した分析が当たり前になりました。さらに、自ら考え行動するエージェント型AIの登場により、分析結果は人間を待つのではなく、次のアクションへと直結するようになっています。

本記事では、AIに関心のある方に向けて、2026年時点でのデータマイニングの再定義とパラダイムシフトをわかりやすく整理します。最新モデルの特徴、研究動向、産業別の実例、日本の政策や市場への影響までを俯瞰することで、これから学ぶべき視点とビジネスやキャリアに活かすヒントを得られるはずです。

データマイニングはどう再定義されたのか

2026年現在、データマイニングは従来の「大量データから統計的な相関を見つけ出す技術」という定義から、大きく書き換えられています。現在の中核にあるのは、大規模言語モデルや大規模マルチモーダルモデルによる意味理解と推論を前提とした知的プロセスです。単なる数値処理ではなく、データの背後にある文脈や意図、因果関係までを読み解くことが求められるようになっています。

この変化を決定づけた要因の一つが、企業データの約80%以上を占めるとされる非構造化データの本格活用です。文章、画像、音声、動画といった形式の異なる情報を、AIが横断的に理解し、意味レベルで統合できるようになったことで、データマイニングは「検索」から「解釈」へと役割を進化させました。IBMの技術解説によれば、こうしたマルチモーダル処理は、データを共通の埋め込み空間で扱うことで初めて実用段階に到達したとされています。

特に2025年から2026年にかけて実用化が進んだGPT-5やGemini 3、Claude 4といった次世代モデルは、20万トークンを超える長大なコンテキストを一括で処理できる点が特徴です。これにより、従来は分断されていたレポート、議事録、設計資料、顧客の声などをまとめて読み込み、全体像を踏まえた洞察を導き出せるようになりました。Clarifaiの業界レポートでも、これを境にデータマイニングの性質が根本的に変わったと指摘されています。

| 観点 | 従来型データマイニング | 2026年以降の再定義 |

|---|---|---|

| 主な対象 | 構造化データ | 非構造化・マルチモーダルデータ |

| 分析の軸 | 相関関係 | 文脈・因果・意味理解 |

| アウトプット | 分析結果の提示 | 意思決定支援・提案生成 |

さらに重要なのは、Mixture-of-Expertsアーキテクチャの進化によって、専門分野ごとの高度な推論を低コストで実行できるようになった点です。これによりデータマイニングは「過去データを理解する行為」から、「現在の状況を踏まえて次の一手を示す知的エージェント的機能」へと拡張されました。単なる分析ツールではなく、業務や研究の意思決定に直接関与する存在へと変貌しています。

このように、2026年のデータマイニングはもはや裏方の分析技術ではありません。多様なデータを意味で結び付け、判断や行動につなげる推論基盤として再定義されたことで、AI活用の成否を左右する中心的な役割を担うようになっています。

生成AI時代を支える大規模言語モデルとマルチモーダルAI

生成AI時代の中核を成す技術として、大規模言語モデルとマルチモーダルAIの進化は、データ活用の前提そのものを変えつつあります。従来のAIはテキストや数値など単一形式のデータ処理が中心でしたが、2026年現在では言語・画像・音声・動画を同時に理解し、意味として統合する能力が標準になっています。IBMの解説によれば、マルチモーダルAIは人間の知覚に近い形で情報を扱える点が最大の特徴とされています。

この変化を支えているのが、GPT-5やGemini 3、Claude 4といった次世代LLMです。これらのモデルは20万トークンを超える広大なコンテキストウィンドウを持ち、膨大な資料や会話履歴を一度に把握できます。スタンフォード大学やOpenAIの研究動向でも、長文脈理解が推論精度と意思決定品質を大きく左右することが示されています。

また、マルチモーダルAIでは異なるデータ形式を共通の埋め込み空間に変換する技術が重要です。テキストはトランスフォーマーベースのエンコーダーで意味ベクトル化され、画像はVision Transformerによって形状や配置情報が抽出されます。これにより、例えば会議動画を解析し、発言内容とスライド画像を結び付けた要約を自動生成するといった高度な理解が可能になります。

| モデル | 技術的特徴 | 主な活用領域 |

|---|---|---|

| GPT-5 | ネイティブマルチモーダル、長文脈推論 | 研究支援、法務分析 |

| Gemini 3 | 高速推論、検索統合 | 企業ナレッジ活用 |

| Claude 4 | 安全性重視、論理整合性 | 教育、医療相談 |

こうした基盤モデルの進化により、AIは単なる情報生成ツールではなく、文脈を理解した上での意味的推論エンジンへと変貌しました。マッキンゼーの分析でも、非構造化データを扱える企業ほど生産性向上の効果が大きいと報告されています。実際、企業データの8割以上を占める非構造化情報を活用できるかどうかが競争力を左右します。

さらに、Mixture-of-Expertsアーキテクチャの高度化により、専門分野ごとに最適化された推論を低コストで実行できるようになりました。これにより、医療、金融、製造など異なる領域でも同一基盤モデルを柔軟に適応させることが可能です。汎用性と専門性を両立したAI基盤こそが、生成AI時代を支える土台となっています。

非構造化データ活用を加速させる埋め込み技術と推論能力

非構造化データ活用を飛躍的に押し上げている中核技術が、埋め込み技術と推論能力の進化です。2026年現在、テキストや画像、音声、動画といった形式の違いは、分析上の障壁ではなくなっています。あらゆるデータを意味ベースで同一空間に写像する埋め込み表現が、AIにとっての共通言語として機能しているからです。

この変化を象徴するのが、トランスフォーマーベースの高性能エンコーダーです。IBMの解説によれば、最新のマルチモーダルモデルでは、テキストは文脈依存の分散表現へ、画像はVision Transformerによって抽象概念レベルまで特徴抽出され、共通の埋め込み空間に統合されます。これによりAIは、単なる類似検索ではなく「意味の近さ」や「文脈の連続性」を捉えられるようになりました。

実務面でのインパクトは明確です。例えば数万件の議事録、チャットログ、設計図、動画マニュアルを横断的に解析し、暗黙知や判断基準を抽出することが可能になります。従来は人間の経験に依存していた洞察が、埋め込み+推論によって再現性のある知識へと変換されつつあります。

| 観点 | 従来手法 | 2026年型アプローチ |

|---|---|---|

| データ形式 | 主に構造化データ | 非構造化・マルチモーダルが前提 |

| 表現方法 | 特徴量手設計 | 意味的埋め込み表現 |

| 分析の主眼 | 相関関係 | 文脈理解と因果推論 |

さらに重要なのが推論能力の質的変化です。GPT-5やGemini 3、Claude 4といった次世代モデルは、20万トークン超の文脈を保持しながら連鎖的思考を行えます。Clarifaiの業界ガイドが指摘する通り、長文脈×高精度推論の組み合わせにより、断片情報を統合して仮説を構築することが可能になりました。

この推論力は、ベクトルデータベースやGraphRAGと結びつくことで真価を発揮します。単なる類似度検索に留まらず、データ同士の関係性を踏まえたマルチホップ推論が可能となり、金融リスク分析や医療知識探索での精度向上が報告されています。非構造化データが“考えられる資産”に変わった点こそ、2026年の決定的な転換点です。

ベクトルデータベースとGraphRAGがもたらす分析精度の進化

2026年現在、分析精度の進化を語る上で欠かせないのが、ベクトルデータベースとGraphRAGの融合です。従来のRAGは、意味的に近い情報を検索する点では有効でしたが、文脈の断片化という課題を抱えていました。ベクトルデータベースは、LLMに長期記憶を与え、事実に基づいた生成を可能にする基盤として確立した一方で、それ単体では「なぜそうなるのか」という関係性の理解には限界があったのです。

この弱点を補完したのがGraphRAGです。GraphRAGでは、人物、企業、概念、出来事といった実体をノードとして定義し、それらの因果関係や依存関係をエッジとして保持します。IBMやGoogleの研究動向でも指摘されている通り、グラフ構造を用いることで、単なる類似検索では不可能だったマルチホップ推論が実現しました。これにより、情報の「点」ではなく「構造」としての理解が可能になります。

例えば金融分析では、決算資料、業界ニュース、マクロ経済指標が複雑に絡み合います。GraphRAGを用いることで、「ある政策変更が特定業界の企業業績にどのような連鎖的影響を与えるか」を段階的に追跡できます。KDD 2025で注目されたLeidenアルゴリズムによる階層的クラスタリングは、こうした文書群をコミュニティ単位で要約し、全体像と詳細の両立を可能にしました。

| 観点 | ベクトル検索 | GraphRAG |

|---|---|---|

| 主な強み | 意味的類似性の高速検索 | 因果関係・構造理解 |

| 推論能力 | 単一ステップ中心 | マルチホップ推論 |

| 分析精度 | 局所的に高い | 全体最適で高い |

医療分野でも同様の進化が見られます。症状、検査結果、既往歴、論文知見をグラフで接続することで、単なる類似症例検索ではなく、診断根拠の説明性が向上しました。NatureやNeurIPS系の研究でも、構造化された知識グラフを併用するRAGは、ハルシネーションを大幅に抑制すると報告されています。

重要なのは、GraphRAGがベクトルデータベースを否定する技術ではない点です。実際の実装では、ベクトル検索で候補情報を絞り込み、その後グラフ推論で関係性を精査する二層構造が主流になっています。意味検索と構造理解を組み合わせることで、分析精度は量的にも質的にも次の段階へ進化したと言えるでしょう。

エージェント型AIが変えるデータ分析と意思決定プロセス

エージェント型AIの登場により、データ分析と意思決定のプロセスは根本から変わりつつあります。従来は人間が問いを立て、分析手法を選び、結果を解釈する直線的な流れが一般的でしたが、2026年現在はAI自身が目的を理解し、分析計画を立案し、意思決定までを支援する段階に入っています。

ガートナーやデロイトの予測によれば、2028年までにエンタープライズソフトウェアの33%にエージェント型AIが組み込まれ、日常業務の意思決定の約15%が自律的に行われるとされています。これは単なる自動化ではなく、状況変化に応じて判断基準そのものを調整する「適応的意思決定」が現場レベルで実装され始めていることを意味します。

特にデータ分析の現場では、エージェント型AIが複数のデータソースを横断し、仮説検証を繰り返す役割を担います。例えば、売上低下の要因分析において、過去データの統計解析だけでなく、顧客の自由記述レビュー、コールセンター音声、市場ニュースまでを統合し、因果関係の可能性を提示します。このプロセスは、人間の分析者が数日かけて行っていた作業を、ほぼリアルタイムで実行します。

| 観点 | 従来の分析 | エージェント型AI導入後 |

|---|---|---|

| 分析開始 | 人間が課題を定義 | 目的からAIが課題を分解 |

| データ活用 | 主に構造化データ | 非構造化データを含む統合分析 |

| 意思決定 | 人間が最終判断 | AIが選択肢と推奨案を提示 |

この変化は、意思決定のスピードだけでなく質にも影響を与えています。マッキンゼーの分析では、生成AIとエージェント型AIを組み合わせた企業は、意思決定の一貫性と再現性が向上し、全社的な生産性が大きく改善すると指摘されています。人間の直感や経験に依存していた判断が、データと文脈に裏付けられた形で共有可能になるためです。

重要なのは、エージェント型AIが人間の代替ではなく、意思決定のパートナーとして機能する点です。AIが複雑な分析と選択肢の整理を担い、人間は価値判断や最終的な責任を引き受ける。この役割分担こそが、エージェント型AIがもたらすデータ分析と意思決定プロセスの本質的な進化だと言えます。

最新研究と学会動向から見るデータマイニングの最前線

最新研究と学会動向から見ると、データマイニングは理論と実装の距離が急速に縮まるフェーズに入っています。KDD、NeurIPS、ICMLといったトップカンファレンスでは、単なる精度向上ではなく、現実世界で使い切れるかどうかを強く意識した研究が主流になっています。

特にKDD 2025では、超軽量モデルと堅牢性に関する研究が注目を集めました。Maolin WangらによるCross-Distillation法は、わずか1.91MBという極小サイズのBERT系モデルを実現し、モバイル端末やエッジ環境での高度なデータマイニングを可能にしています。**巨大モデル一択だった流れに対し、用途特化型・省資源型という新たな最適解を示した点が評価されています。**

同じくKDDで発表された偽相関への耐性を高める研究は、実運用における信頼性を大きく前進させました。表面的な相関に引きずられないモデル設計は、金融リスク分析や医療データ解析など、誤判断が許されない領域で特に重要視されています。

| 学会 | 研究テーマ | 示した方向性 |

|---|---|---|

| KDD 2025 | 超軽量モデル・因果解析 | 実運用とスケーラビリティ重視 |

| NeurIPS 2025 | マルチエージェント推論 | 協調的・自律的意思決定 |

| ICML 2025 | 生成的レコメンデーション | 行動文脈の深い理解 |

NeurIPS 2025では、SYMPHONYに代表されるマルチエージェント研究が脚光を浴びました。異なる言語モデルを役割分担させ、計画立案から実行までを協調させるこのアプローチは、**単一モデルでは難しかった複雑なデータマイニングタスクを現実的な計算コストで実現する道筋**を示しています。

ICML 2025では、レコメンデーション分野における生成モデルの進化が印象的でした。ActionPieceは、ユーザー行動を細かなトークン列として再構成することで、従来の特徴量設計に依存しない柔軟なマイニングを可能にしています。これは、ECやコンテンツ配信だけでなく、教育や医療の行動分析にも応用可能とされています。

これらの研究に共通するのは、説明可能性と効率性への強い志向です。実際、CityUHKとAnt Groupの研究成果は、数百万台規模の実システムに展開され、クリック率向上という明確な成果を示しました。**学会発のアルゴリズムが短期間で社会実装に到達する流れは、2026年のデータマイニング研究を象徴しています。**

最新の学会動向を追うことは、単なる技術トレンドの把握ではありません。どの課題が「解ける段階」に入り、どこが次の研究フロンティアなのかを見極めるための、極めて実践的な指針になっているのです。

市場規模と経済インパクトから読み解く成長シナリオ

市場規模と経済インパクトの観点から見ると、2026年は生成AIと高度化したデータマイニングが本格的にマクロ経済へ影響を及ぼし始めた転換点だと言えます。Precedence Researchなどの調査によれば、生成AI市場は2026年に550億ドル規模へ到達し、その後2030年代にかけて指数関数的な成長が見込まれています。この成長は単なるIT投資の増加ではなく、意思決定そのものの自動化と高度化が経済活動の前提条件になりつつあることを示しています。

特に注目すべきは、ソフトウェアセグメントが市場全体の65%以上を占めている点です。これは、モデル単体の価値よりも、業務プロセスに組み込まれたエージェント型AIや分析基盤としてのデータマイニングが、直接的に収益やコスト構造へ影響していることを意味します。ガートナーやマッキンゼーの分析によれば、こうしたAI導入企業は平均して約38%の成長率を見込んでおり、**AI活用の有無が企業成長の分水嶺になりつつあります。**

| 区分 | 2025〜2026年 | 中長期予測 |

|---|---|---|

| 生成AI市場規模 | 約550億ドル | 2035年に1兆ドル超 |

| 北米シェア | 約41% | 技術大手主導で安定成長 |

| アジア太平洋 | CAGR 約27% | 政府投資で急拡大 |

地域別では、北米が依然として最大市場である一方、アジア太平洋地域の成長率が突出しています。中国や日本では、国家主導の研究開発投資とデータ主権を意識したオンプレミスAIの需要が、市場拡大を後押ししています。SkyQuestやKen Researchの分析でも、日本企業の約7割がモデルの内製化や社内運用を計画しているとされ、これはデータマイニングが競争優位の源泉として認識され始めた証拠です。

経済インパクトは市場規模にとどまりません。マッキンゼーは、生成AIが世界経済に年間最大4.4兆ドルの付加価値をもたらすと試算しており、その多くはデータマイニングを基盤とした生産性向上によるものです。**人が分析していた時間をAIが担い、人は戦略や創造に集中する**という構造変化が、今後の成長シナリオの中核を成しています。

この流れは労働市場にも波及しています。AI・データ関連スキルを持つ人材には50%を超える賃金プレミアムが発生しており、知的労働の価値基準そのものが再定義されつつあります。市場規模の拡大、企業成長率の上昇、人材価値の変化が連動することで、データマイニングは一過性のブームではなく、長期的な経済成長エンジンとして定着し始めています。

製造業・ヘルスケア・エンタメにおける実践的ケース

製造業・ヘルスケア・エンタメの三分野では、2026年現在のデータマイニングは「分析結果を読む技術」ではなく、**現場の意思決定や体験そのものをリアルタイムに変える実装技術**として定着しつつあります。共通しているのは、LLMやマルチモーダルAIが非構造化データを意味理解し、行動につなげている点です。

| 分野 | 主なデータ | 実践的な成果 |

|---|---|---|

| 製造業 | センサー・画像・作業ログ | ダウンタイム40%削減 |

| ヘルスケア | 画像・ゲノム・診療記録 | 診断精度と創薬速度の向上 |

| エンタメ | 行動履歴・音声・感情反応 | 体験の完全パーソナライズ |

製造業では、GEやトヨタが象徴的です。GEはデジタルツインとAIを組み合わせ、設備の振動や温度といった時系列データを意味的に解釈することで、**突発的な停止を約40%削減**しました。デロイトの分析によれば、これは単なる予測ではなく、AIエージェントが保守計画まで自律的に組み立てている点が決定的な違いです。

ヘルスケアでは、日本政府主導のAIホスピタル構想が進み、画像診断や創薬で成果が見え始めています。武田薬品工業などは、膨大な化学構造データと論文テキストを統合的にマイニングし、候補化合物の探索期間を短縮しています。IBMや学術論文が示す通り、**マルチモーダル解析は人間の専門医でも見逃す微細なパターン検出に強み**を発揮しています。

エンターテインメント分野では、データマイニングは体験設計の中核です。生成AIはユーザーの行動速度、選択傾向、音声入力から感情状態を推定し、ゲームのNPCや音楽、物語展開を即座に変化させます。ガートナーが指摘するように、**コンテンツは「完成品」ではなく「生成され続ける体験」へと変貌**しました。

この三分野の事例が示すのは、データマイニングの価値が分析結果そのものではなく、**現場での行動・判断・体験をどれだけ自然に変えられるか**に移行しているという事実です。2026年の実践的ケースは、その転換点を明確に物語っています。

日本のAI政策とデータ活用を巡る法規制の現在地

2026年現在、日本のAI政策とデータ活用を巡る法規制は、世界的にも特徴的な立ち位置を築いています。最大の転換点となったのが、2025年9月に全面施行されたAI推進法です。欧州のAI法のようにリスクごとの厳格な規制や罰則を設けるのではなく、**AIの研究開発と社会実装を国家戦略として後押しする「促進型」アプローチ**を明確に打ち出しました。

この法律の中核にあるのが、アジャイル・ガバナンスという考え方です。技術進化のスピードに合わせてガイドラインを柔軟に更新し、企業や研究機関の自主的な取り組みを前提に透明性と安全性を確保します。国際法曹協会やBird & Birdの分析によれば、この枠組みはイノベーション抑制のリスクを最小化しつつ、国際的な信頼性を担保する点で評価されています。

データ活用の観点で重要なのは、個人情報保護法との関係です。日本では既存の個情法を基軸に、AI特有の課題はガイドラインで補完する設計が取られています。これにより、医療・製造・金融といった高付加価値分野で、**非構造化データを含む高度なデータマイニングを実装しやすい環境**が整いつつあります。

| 制度・組織 | 主な役割 | データ活用との関係 |

|---|---|---|

| AI推進法 | AI研究開発と利用の国家的促進 | 過度な規制を避け、実証実験を加速 |

| AI事業者ガイドライン | 透明性・説明責任の指針提示 | データ品質管理とリスク低減 |

| AIセーフティ・インスティテュート | 安全性評価と適合性検証 | 医療・ロボティクスのデータ信頼性確保 |

特に注目されるのが、AIセーフティ・インスティテュートの役割です。2025年に公表されたビジョンペーパーでは、AIシステムの評価だけでなく、学習データや運用データの品質管理まで射程に入れています。**ハルシネーションやデータ偏りへの対策を制度面から支える動き**は、生成AI時代のデータマイニングに不可欠です。

米国の市場主導型、中国の国家主導型とも異なり、日本は「信頼性」と「使いやすさ」を両立させる中間モデルを志向しています。CSISの分析では、この柔軟な法規制が、海外企業の研究拠点誘致や共同研究を後押しする可能性が指摘されています。

日本のAI政策は、単なる規制整備ではありません。**高品質なデータを安心して活用できる社会基盤を整えること自体が競争力になる**という発想が、その根底にあります。この現在地を理解することは、国内外でAIを活用する企業や研究者にとって、戦略設計の前提条件になりつつあります。

ハルシネーション対策とデータ信頼性の重要性

生成AIが高度な推論や意思決定支援を担うようになった現在、最大のリスクとして常に挙げられるのがハルシネーションです。もっとも重要なのは、ハルシネーションを単なるモデル性能の問題として捉えないことです。**本質的な課題は、AIが参照しているデータの信頼性と、それを検証する仕組みが設計段階から組み込まれているかどうか**にあります。

IBMやスタンフォード大学の研究者によれば、ハルシネーションの多くは「モデルが知らないことを、もっともらしく補完しようとする挙動」から発生します。2026年時点では、この問題に対して多層的な技術的防御が実装されるのが一般的です。特にRAGを中核とした接地設計は、LLM単体運用と比較して事実誤認率を大幅に低減することが報告されています。

| 対策アプローチ | 役割 | 信頼性への影響 |

|---|---|---|

| RAG | 検証済み外部データを参照 | 事実根拠を明示できる |

| Self-Reflective RAG | 生成内容を自己評価 | 矛盾の自動修正が可能 |

| 構造化出力 | 回答形式を厳格化 | 創作的誤りを抑制 |

実運用では、技術以上にデータガバナンスの成熟度が成果を左右します。ガートナーが示す分析でも、ハルシネーション発生率が低い組織ほど、データ品質監査を継続的なプロセスとして定義しています。**一度きりのデータクレンジングではなく、データの収集、更新、廃棄までを含むライフサイクル管理が不可欠**です。

また近年注目されているのが、AIが生成したデータを再学習に用いることで発生するモデル崩壊です。ミシガン大学のNeurIPS 2025関連研究では、生成データ比率が一定閾値を超えると、モデルの多様性と事実整合性が急激に低下することが示されています。この問題への対策として、エントロピー指標を用いたデータ選別や、生成コンテンツへの電子透かしが実装レベルで普及し始めています。

日本においても、AIセーフティ・インスティテュートが中心となり、医療やロボティクス分野を対象にデータ信頼性評価フレームワークの整備が進められています。これは技術規制というより、**信頼できるデータを使っていることを説明可能にする仕組み**を社会実装する試みです。

最終的に、ハルシネーション対策は「AIを賢くする」話ではありません。**AIが参照する事実を、人間がどこまで責任を持って管理し、検証可能な形で提示できるか**。この姿勢こそが、2026年以降のAI活用におけるデータ信頼性の分水嶺になります。

参考文献

- Clarifai:Top LLMs and AI Trends for 2026

- IBM:What is Multimodal AI?

- Paper Digest:KDD 2025 Papers & Highlights

- Deloitte Insights:2026 Manufacturing Industry Outlook

- SkyQuest:Generative AI Market Growth, Opportunities, and Long-Term Insights

- Bird & Bird:Japan’s AI Governance Major Government Steps Since the AI Act

- NineTwoThree:AI Hallucinations: Why They Occur and How to Prevent Damage