AIの進化にワクワクしながらも、「結局、社会や産業はどう変わるのだろう」と感じていませんか。2026年現在、その答えの一端を担っているのが、AIと融合した次世代シミュレーション技術です。もはやシミュレーションは、現象を再現する裏方の技術ではありません。

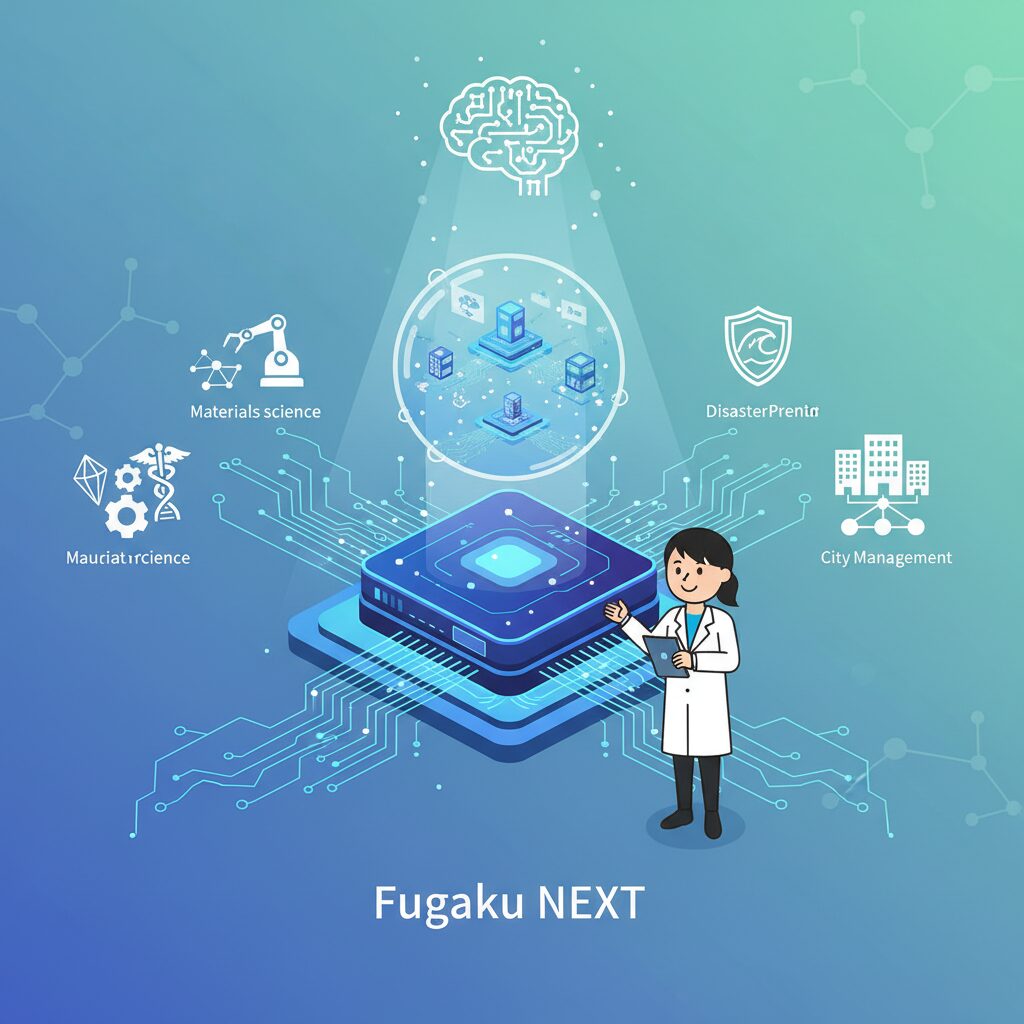

日本が開発を進める次世代スーパーコンピュータ「富岳NEXT」を中心に、計算基盤は飛躍的な進化を遂げ、AIは自ら仮説を立て、未来を予測し、最適解を導き出す存在へと変わりつつあります。こうした技術は、材料開発や製造業だけでなく、医療、防災、都市運営といった私たちの生活に直結する分野にも広がっています。

本記事では、AIに関心のある方に向けて、2026年時点で注目すべきシミュレーション技術の全体像をわかりやすく整理します。富岳NEXTが目指す性能の意味、AI for Scienceの革新性、そしてデジタルツイン2.0がもたらす意思決定の変化までを俯瞰することで、これからのAI時代を理解するための確かな視点を得られるはずです。

2026年はなぜシミュレーション技術の転換点なのか

2026年がシミュレーション技術の転換点とされる最大の理由は、**シミュレーションが「再現の道具」から「未来を自律的に設計する知能」へと質的変化を遂げた年**だからです。背景には、AIとハイパフォーマンス・コンピューティング(HPC)が分離不可能な形で融合し、計算の意味そのものが変わり始めたという決定的な構造変化があります。

従来のシミュレーションは、物理法則を人間が定義し、計算機が高速に解くという受動的な枠組みでした。しかし2026年時点では、AIが仮説生成や探索を担い、シミュレーション結果をもとに次の最適解を自律的に選び取る段階へと進んでいます。理化学研究所を中心に進む次世代計算基盤「富岳NEXT」は、その象徴的存在です。専門家によれば、AI処理の実効性能で現行比約100倍を目指す設計思想は、単なる速度競争ではなく、社会課題を解くための計算様式の刷新を意味しています。

| 観点 | 従来型シミュレーション | 2026年以降のシミュレーション |

|---|---|---|

| 役割 | 現象の再現・検証 | 未来予測と最適化 |

| 知能の主体 | 人間 | AI+人間の協調 |

| 計算基盤 | CPU中心HPC | AI-HPC統合基盤 |

特に重要なのが、AIが科学研究や設計プロセスの中核に組み込まれ始めた点です。2026年には「AI for Science」を前提とした計算基盤の運用が始まり、AIが既存論文やデータを解析し、新たな仮説や設計候補を提示することが現実のものとなりました。**シミュレーションはもはや「答えを確認する工程」ではなく、「答えを生み出す起点」になりつつあります。**

また、計算規模の拡大だけでなく、効率の質的向上も転換点を強く印象づけています。低精度演算と高度アルゴリズムを組み合わせることで、同じ電力規模のまま計算能力を飛躍的に高める設計思想は、エネルギー制約という現実的課題への明確な回答です。これは理研や富士通、NVIDIAといった国際的プレイヤーが共有する方向性でもあり、権威ある研究機関が示すロードマップとも一致しています。

2026年は、ハードウェア、アルゴリズム、AI活用のすべてが同時に臨界点を超えた年です。**この年を境に、シミュレーションは「未来を考えるための補助線」ではなく、「未来を先に試すための社会基盤」へと役割を変え始めました。**その変化はすでに研究室の外へと広がり、産業や政策決定の現場に静かに浸透し始めています。

次世代スーパーコンピュータ富岳NEXTが示す計算性能の新基準

次世代スーパーコンピュータ富岳NEXTは、計算性能の評価軸そのものを更新する存在として位置づけられています。これまでスーパーコンピュータの価値は、TOP500に代表される倍精度演算性能の順位で語られることが一般的でした。しかし富岳NEXTでは、社会的インパクトに直結する実効性能を中心に据えた新たな基準が明確に打ち出されています。

理化学研究所が公表している目標値によれば、富岳NEXTはAI処理における実効性能で50EFLOPS以上、低精度演算であるFP8ではピーク600EFLOPS超を想定しています。これは単なる数値の誇示ではなく、大規模言語モデルや科学特化型AIを現実的な時間で学習・推論できることを意味します。松岡聡センター長が強調するように、重要なのは理論値ではなく、実アプリケーションでどれだけ速く、安定して成果を出せるかです。

| 指標 | 富岳 | 富岳NEXT目標 |

|---|---|---|

| AI実効性能 | 数百PFLOPS | 50EFLOPS以上 |

| AIピーク性能(FP8) | 未対応 | 600EFLOPS超 |

| 一般HPC実効性能 | 基準値 | 5〜10倍以上 |

| 総消費電力 | 約30〜40MW | 約40MW |

特筆すべきは、性能向上とエネルギー効率を同時に成立させている点です。計算能力を桁違いに引き上げながら、システム全体の消費電力を現行富岳と同程度に抑える設計は、国際的にも極めて挑戦的です。これは半導体プロセスの微細化だけでなく、CPUとGPUの役割分担最適化、メモリ階層設計、データ転送削減といった総合的なアーキテクチャ戦略の成果といえます。

また富岳NEXTは、従来型HPCとAIワークロードを同一基盤で高効率に動かす「AI-HPCプラットフォーム」を前提に設計されています。富士通の次世代CPUとNVIDIAのGPUを密結合する構成により、気象予測や材料シミュレーションとAI解析を連続的に実行できる点が大きな特徴です。これにより、計算性能の基準は単一ベンチマークから、複合的・連続的な科学計算能力へと移行しつつあります。

富岳NEXTが示す新基準は、世界最速かどうかではなく、「未来の課題をどこまで先回りして解けるか」です。その意味でこのスーパーコンピュータは、計算性能の競争軸を塗り替え、次世代の知的インフラの物差しを定義する存在になろうとしています。

ゼタスケールとは何か|AI実効性能100倍のインパクト

ゼタスケールとは、スーパーコンピュータの計算性能がゼタという桁、すなわち10の21乗回クラスに到達することを指す概念です。単なる性能競争の延長ではなく、**AIの実効性能が社会実装レベルで桁違いに跳ね上がる転換点**として位置づけられています。2026年時点で議論されているゼタスケールは、理論値ではなく、AI学習や推論といった現実のワークロードでどれだけ力を発揮できるかが核心です。

理化学研究所を中心に開発が進む富岳NEXTでは、AI処理の実効性能で現行の富岳比およそ100倍、50EFLOPS以上を目標に掲げています。さらに低精度演算であるFP8を活用したAIピーク性能では600EFLOPS超が想定されており、これは事実上、**世界初の実用的ゼタスケール領域に踏み込む挑戦**だと専門家の間で評価されています。

ここで重要なのは、ゼタスケールが単に計算が速くなる話ではない点です。AIモデルの規模拡大、学習データの爆発的増加、リアルタイム推論の高度化が同時に進む中で、従来のエクサスケールではボトルネックが顕在化していました。米国エネルギー省や欧州のHPC研究でも、AIとシミュレーションの融合には桁違いの演算密度が必要だと指摘されています。

| 指標 | 現行富岳 | 富岳NEXT目標 |

|---|---|---|

| AI実効性能 | 数百PFLOPS | 50EFLOPS以上 |

| AIピーク性能(FP8) | 未対応 | 600EFLOPS超 |

| 一般HPC実効性能 | 基準値 | 5〜10倍以上 |

AI実効性能100倍のインパクトは、研究現場に直結します。例えば材料開発では、従来は計算資源の制約から探索できなかった組成空間を一気に走査できるようになります。気象・気候分野でも、空間分解能と予測リードタイムを同時に引き上げることが可能になり、**精度と速度のトレードオフが事実上解消されます**。

富岳NEXTが特徴的なのは、CPUとGPUを密結合したAI-HPCプラットフォームを前提に設計されている点です。富士通の次世代CPUとNVIDIAのGPUを組み合わせる構成は、AI学習と物理シミュレーションを同一基盤で回すことを可能にします。理研の松岡聡センター長も、TOP500順位ではなく実課題解決性能を重視する姿勢を明言しています。

さらに注目すべきはエネルギー効率です。性能を100倍に引き上げながら、総消費電力は富岳と同程度の約40MWに抑える設計思想が採られています。これは、演算効率とアルゴリズム最適化を前提としたゼタスケールであり、**持続可能性を伴った計算基盤**であることを意味します。

ゼタスケールとは、未来のAIが机上の理論ではなく、産業や社会の現場で実際に使える知能へと進化するための土台です。AI実効性能100倍という数字は、単なる指標ではなく、研究開発の速度、意思決定の質、そして競争力そのものを塗り替えるインパクトを内包しています。

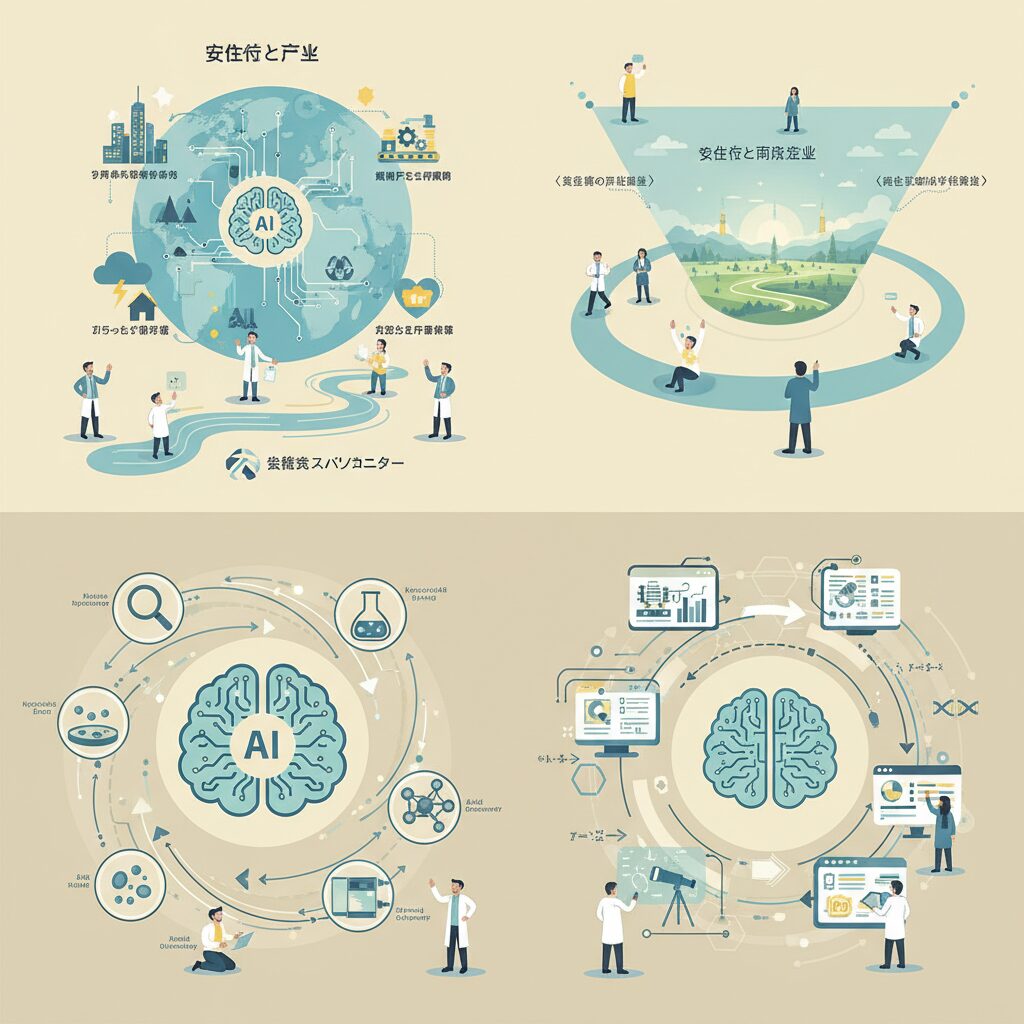

AI for Scienceが変える科学研究の進め方

AI for Scienceは、科学研究の進め方そのものを根底から変えつつあります。従来の研究は、研究者が仮説を立て、実験やシミュレーションを実行し、結果を解釈するという人間中心の反復作業でした。しかし2026年現在、AIはこの一連のプロセスに深く入り込み、研究サイクルを自律的に高速回転させる存在へと進化しています。

理化学研究所を中心に進められているAI for Scienceでは、AIが過去数十年分の論文や実験データを解析し、有望な仮説候補を生成します。さらに、その仮説を検証するためのシミュレーションコードを自動生成し、計算結果を踏まえて次の仮説を更新する流れが実運用に入りつつあります。これはNatureやScienceでも繰り返し指摘されてきた「探索空間の爆発」という科学の限界に対する、現実的な解答だと言えます。

特に注目されているのが、物理情報ニューラルネットワークとサロゲートモデルの活用です。これらは既知の物理法則を学習過程に組み込むことで、計算結果の物理的一貫性を保ちながら、従来の数値計算に比べて数十分の一から数百分の一の計算量で結果を導き出します。計算時間の短縮は、単なる効率化ではなく、試せる仮説の数そのものを増やす点に本質的な価値があります。

| 観点 | 従来型研究 | AI for Science |

|---|---|---|

| 仮説生成 | 研究者の経験と直感 | 論文・データ解析に基づく自動生成 |

| 検証速度 | 計算資源に強く依存 | サロゲートモデルで高速化 |

| 研究サイクル | 人手中心の反復 | AIによる自律的ループ |

この変化は材料科学や創薬分野ですでに成果を上げています。新材料探索では、AIが候補構造を数万単位で評価し、実験に進むべき数十件まで絞り込む事例が報告されています。米国エネルギー省や欧州の研究機関も同様のアプローチを採用しており、日本の取り組みは国際的潮流と軌を一にしています。

AI for Scienceがもたらす最大の変革は、研究者の役割そのものの変化です。研究者は計算作業の担い手ではなく、AIが提示する結果を解釈し、問いの質を高める存在へとシフトします。科学は「考える時間」を取り戻し、発見の速度と深さを同時に高める段階に入ったといえるでしょう。

物理法則を学習するAI|PINNsとサロゲートモデルの実力

物理法則を学習するAIとして注目を集めているのが、PINNsとサロゲートモデルです。これらは、データ駆動型AIと物理シミュレーションの長年の溝を埋める存在として、2026年時点のAI for Scienceの中核技術になっています。

従来の深層学習は大量データから相関を学ぶ一方、物理的にあり得ない解を出すリスクがありました。PINNsはこの弱点を克服するため、**学習プロセスそのものに物理方程式を組み込み、解の物理的一貫性を保証する**点が最大の特徴です。理化学研究所を含む複数の研究機関によれば、流体力学や熱伝導の問題で、従来手法に比べ計算量を数十分の一から数百分の一に削減できたと報告されています。

PINNsの学習では、観測データとの誤差に加えて、ナビエ・ストークス方程式などの支配方程式の残差を同時に最小化します。これにより、観測点が疎な状況でも物理的に妥当な連続解を再構成でき、実験や計測が難しい領域で特に威力を発揮します。

| 観点 | 従来数値解析 | PINNs・サロゲートモデル |

|---|---|---|

| 計算コスト | 非常に高い | 大幅に低減 |

| 物理整合性 | 厳密 | 学習過程で担保 |

| リアルタイム性 | 困難 | 可能 |

このPINNsを用いて構築されるのがサロゲートモデルです。サロゲートモデルは、重い物理シミュレーションを高速に近似する代替モデルであり、**一度学習すればミリ秒単位で結果を推定できる**点が評価されています。富岳NEXTのような次世代HPC環境では、高忠実度シミュレーションとPINNsを組み合わせ、学習と推論を循環させる運用が現実になりつつあります。

具体例として、航空宇宙分野では乱流解析、材料科学では結晶成長や相変態の予測に応用が進んでいます。米国の主要大学と欧州研究機関の共同研究では、従来数日かかっていたパラメータ探索を数分に短縮できたと報告されており、設計探索の自由度が飛躍的に高まりました。

さらに重要なのは信頼性です。ブラックボックスになりがちなAIに対し、PINNsは「なぜその解になるのか」を物理法則で説明できます。**この解釈可能性こそが、医療や防災、エネルギー分野での実運用を可能にする決定的要因**です。専門家の間では、物理を学習するAIは単なる高速化手段ではなく、科学的理解そのものを拡張する道具だと位置づけられています。

2026年現在、PINNsとサロゲートモデルは研究段階を越え、実務に組み込まれ始めています。物理法則とAIの融合は、シミュレーションを「計算するもの」から「学習し進化するもの」へと変えつつあり、その実力はすでに産業と科学の両面で証明され始めています。

デジタルツイン2.0とは何が新しいのか

デジタルツイン2.0の最大の新しさは、現実世界を忠実に再現する段階を超え、自ら考え、判断し、行動を提案する主体へと進化した点にあります。従来のデジタルツインは、センサーから得られるデータを可視化し、人間の意思決定を支援する役割が中心でした。しかし2026年時点では、AIと高度なシミュレーションが完全に統合され、意思決定そのものを担う存在へと変わりつつあります。

この変化を支えているのが、AIプランナーと呼ばれる自律型意思決定エンジンです。理化学研究所や産業界の共同研究によれば、AIプランナーは複数の制約条件や目的関数を同時に扱い、最適解をリアルタイムで更新できます。これにより、単一設備の最適化にとどまらず、工場、物流、エネルギー供給といった複数ドメインを横断した判断が可能になりました。

| 観点 | 従来型 | 2.0世代 |

|---|---|---|

| 役割 | 可視化と分析 | 自律的な計画と実行 |

| 意思決定 | 人間主導 | AI主導 |

| 対象範囲 | 単一設備やライン | 複数領域の統合 |

もう一つの重要な進化は、フェデレーション型マルチドメイン統合です。これは、複数のデジタルツインを連携させ、相互作用を含めてシミュレーションする仕組みです。例えば生産計画を変更した場合、その影響がサプライチェーン全体やエネルギー消費、さらにはCO2排出量にどう波及するかを同時に評価できます。専門家の間では、これが経営判断の質を一段引き上げると評価されています。

産業用メタバースとの融合も、デジタルツイン2.0を象徴する特徴です。3D仮想空間上で人・設備・プロセスを統合的に再現し、経営層がその中でシナリオを体験しながら判断できます。『デジタルツイン2.0白書2026年版』によれば、投資判断や新工場計画において、数週間かかっていた検討プロセスが数時間に短縮された事例も報告されています。

さらに注目すべきは、予兆保全とリアルタイム最適化の精度です。マルチセンサーと深層学習を組み合わせたモデルでは、設備故障を約99%の確度で事前検知できるとされています。これにより突発停止を前提とした運用から、計画的に止めない運用へと移行が進んでいます。

総じてデジタルツイン2.0の新しさは、技術的な高度化だけではありません。意思決定の主体が人からAIへと移り、判断のスピードとスケールが桁違いに拡張された点に本質があります。この変化は、企業活動だけでなく、社会インフラ全体の運用思想をも塗り替え始めています。

産業用メタバースが経営判断にもたらす変化

産業用メタバースの進展は、経営判断の質とスピードを根本から変えつつあります。従来の経営判断は、過去データの集計や統計モデルに基づく予測が中心でしたが、2026年時点では、現実世界と同期した3D仮想空間上で未来の選択肢を直接試行できる環境が整い始めています。これは単なる可視化ではなく、経営そのものをシミュレーションする行為へと進化しています。

デジタルツイン2.0を中核とする産業用メタバースでは、工場、サプライチェーン、市場需要、エネルギー制約といった複数の要素が同時に再現されます。理化学研究所や産業界の報告によれば、AIプランナーを内包したモデルが、投資額、稼働率、CO2排出量などのKPIをリアルタイムで再計算し、経営層に複数の意思決定シナリオを提示できる段階に入っています。

特に大きな変化は、経営会議における意思決定プロセスです。数十ページの資料を読み解く代わりに、経営陣自身が仮想空間に入り、設備配置や生産条件を変更し、その結果を即座に体感できます。意思決定が「説明を受けて理解するもの」から「体験して納得するもの」へと変わった点は、組織の合意形成にも大きな影響を与えています。

| 観点 | 従来型の経営判断 | 産業用メタバース活用後 |

|---|---|---|

| 判断材料 | 過去データと静的予測 | リアルタイムシミュレーション |

| 検討スピード | 数週間〜数か月 | 数分〜数時間 |

| リスク評価 | 定性的・部分的 | 物理挙動を含む定量評価 |

例えば新工場建設の判断では、立地条件や設備投資額だけでなく、将来の需要変動や人材配置の制約まで含めた仮想運用が可能です。産業用メタバース上で数百通りの運用パターンを試行し、最もROIが高く、かつリスク耐性の強い選択肢を選べます。これは富岳クラスのHPCとAIが融合した計算基盤があって初めて実現するものです。

また、M&Aや事業再編といった戦略判断にも影響が及んでいます。統合後の生産能力やコスト構造を事前に仮想空間で再現することで、買収効果を過大評価するリスクを抑えられます。経済産業政策や産業シミュレーションに関わる専門家の間では、産業用メタバースは経営者の直感を拡張する「第2の思考空間」と位置付けられ始めています。

このように、産業用メタバースは単なるDXツールではなく、経営判断の前提条件そのものを変革しています。未来を予測するのではなく、複数の未来を事前に経験した上で選択する。この意思決定様式の変化こそが、産業用メタバースが経営にもたらす最も本質的なインパクトだと言えます。

医療・自動車・防災で進むシミュレーション活用の最前線

医療・自動車・防災の分野では、シミュレーション技術が実証段階を越え、社会インフラとして実装されるフェーズに入っています。2026年時点の特徴は、AIと高性能計算基盤の融合により、過去を再現する技術から未来を先回りして設計する技術へと役割が変わった点にあります。

医療分野では、個人単位の生理学的モデル、いわゆるデジタル・バイオツインの活用が現実味を帯びています。日医総研が示す「医療のグランドデザイン2030」によれば、PHRの全国的な整備を前提に、健診情報や投薬履歴を反映した患者固有モデルを用いることで、治療効果や副作用を事前に予測する医療体制が構想されています。実際、患者のCTやMRIデータを基にした手術シミュレーションでは、術前リハーサルによる合併症リスク低減が報告されており、医師の経験に依存していた判断を定量的に支援する役割を果たしています。

自動車産業では、EV開発を中心にシミュレーションの重要性が急速に高まっています。特に電池の熱管理や劣化挙動は、実車試験だけでは網羅できない複雑系です。高精度な物理モデルとAIサロゲートモデルを組み合わせることで、走行条件や気温差が航続距離や安全性に与える影響をリアルタイムで評価できるようになりました。理化学研究所や自動車メーカーの研究では、試作回数を大幅に削減しつつ設計空間を広げる手法が国際競争力の源泉になりつつあると指摘されています。

| 分野 | 主なシミュレーション対象 | 社会的インパクト |

|---|---|---|

| 医療 | 患者固有モデル、治療効果予測 | 個別化医療と医療安全の向上 |

| 自動車 | 電池熱管理、衝突・走行挙動 | 開発期間短縮と品質安定 |

| 防災 | 浸水・土砂災害予測、避難行動 | 被害最小化と迅速な意思決定 |

防災分野では、内閣府SIP第3期「スマート防災ネットワーク」に象徴されるように、シミュレーションが人命保護の中核技術として位置付けられています。気象シミュレーションと都市デジタルツインを連携させることで、豪雨時の浸水深や到達時間を分単位で更新し、個々人に最適化された避難ルートを提示する仕組みが社会実装され始めています。防災科学技術研究所の知見によれば、こうしたリアルタイム予測は自治体の初動対応を大きく改善するとされています。

医療では一人の命、自動車では大量生産される製品の安全性、防災では地域全体の生存確率が対象となりますが、いずれも意思決定の質が結果を左右します。2026年の最前線にあるシミュレーション活用は、専門家の勘や経験を否定するものではなく、それを拡張し、再現可能な知として次世代へ引き継ぐ基盤になりつつあります。

シミュレーション技術と国家戦略|日本の立ち位置

シミュレーション技術は、2026年時点で国家の競争力を左右する中核技術として位置づけられています。単なる研究開発の効率化ツールではなく、**経済安全保障、産業政策、科学技術外交を横断する戦略資産**へと性格を変えつつあります。米国、中国、欧州が国家主導で計算基盤とAIシミュレーションへの投資を加速させる中、日本の立ち位置は「追随」ではなく「選択と集中」によって特徴づけられています。

その象徴が、理化学研究所を中核とした次世代計算基盤構想と、AIと物理シミュレーションの融合を国家レベルで推進する姿勢です。理研や文部科学省の公開資料によれば、日本は世界最高性能を単純に競うのではなく、**社会課題解決に直結する計算性能と信頼性を重視する方針**を明確にしています。これは、気候変動、防災、医療、エネルギーといった分野で「使えるシミュレーション」を国家価値に変換する戦略だと言えます。

| 地域 | 国家戦略の軸 | シミュレーション技術の位置づけ |

|---|---|---|

| 米国 | 技術覇権と安全保障 | 軍事・エネルギー・AI研究の基盤 |

| 中国 | 自立自強と産業統制 | 国家主導の超大規模計算資源 |

| 日本 | 社会実装と信頼性 | 産業・防災・医療への実装重視 |

この比較から浮かび上がるのは、日本が「速度や規模」ではなく「質と用途」で差別化を図っている点です。専門家の間では、**日本は高精度シミュレーションと現実世界のデータ統合に強みを持つ稀有な国**だと評価されています。特に、物理法則に基づくモデルとAIを組み合わせた手法は、結果の説明可能性が求められる分野で国際的な信頼を得やすいとされています。

また、地政学的な観点でもシミュレーション技術は重要性を増しています。半導体供給網の不安定化や国際情勢の緊張が続く中で、実験や試作を仮想空間で代替できる能力は、**外部依存を減らし、国内で意思決定を完結させる力**につながります。経済産業省や内閣府が計算基盤と産業DXを同一文脈で語る背景には、こうした危機意識があります。

さらに、日本の戦略的特徴として見逃せないのが国際連携の設計思想です。完全な自国完結型ではなく、共通基盤を通じて海外研究機関や企業と接続しつつ、**中核部分の技術と知見を国内に蓄積するモデル**を採っています。これは、日本がグローバル標準の形成に間接的に関与し続けるための現実的な選択だと、科学技術政策の研究者は指摘しています。

シミュレーション技術を国家戦略として捉えたとき、日本の立ち位置は決して派手ではありません。しかし、**信頼性・実装力・社会的合意形成を重視する姿勢**は、長期的には国際社会における独自の存在感を生み出します。2026年は、その方向性が明確に可視化され始めた転換点だと言えるでしょう。

人材・エネルギー・倫理から考える今後の課題

シミュレーション技術が社会の中枢に組み込まれていくにつれ、人材、エネルギー、倫理という三つの視点が避けて通れない課題として浮かび上がります。特に2026年以降は、技術的ブレークスルーよりも、それを持続可能に使いこなす社会的基盤が問われる段階に入っています。

まず人材の側面では、物理、数学、情報科学、さらに産業ドメインを横断できる高度な専門性が求められています。理化学研究所が次世代計算基盤開発部門を新設した背景には、単なる計算機エンジニアではなく、AIとシミュレーションを統合的に設計・運用できる人材が決定的に不足しているという危機感があります。**欧米の研究機関では博士課程学生の段階からAI for Scienceを前提とした教育が進んでおり、日本でも大学と産業界が連動した育成モデルの構築が急務です。**

次にエネルギーの問題です。富岳NEXTは性能を約100倍に高めながら、消費電力を40MW程度に抑えるという極めて野心的な目標を掲げています。これは国際的に見ても異例であり、計算効率そのものが研究テーマとなっています。

| 観点 | 従来型HPC | 次世代HPCの課題 |

|---|---|---|

| 性能向上 | 演算器の増強 | AI活用とアルゴリズム最適化 |

| 電力消費 | 性能比例で増加 | 同等電力で桁違いの性能 |

| 社会的制約 | 限定的 | 脱炭素・電力インフラ制約 |

国際エネルギー機関によれば、データセンター由来の電力需要は今後も増加が見込まれており、スーパーコンピュータも例外ではありません。**計算科学は環境負荷と真正面から向き合うフェーズに入っています。**

最後に倫理の課題です。AIが自律的に予測や意思決定を行うシミュレーションでは、その結果が社会に与える影響が極めて大きくなります。医療や防災分野では、誤った予測が直接人命に関わるため、説明可能性と物理的一貫性の担保が不可欠です。NatureやScienceでも、ブラックボックス型AIへの過度な依存に警鐘が鳴らされています。**高速化や自動化の先にある「責任の所在」をどう設計するかが、今後の技術受容を左右します。**

参考文献

- PC Watch:スパコン「富岳NEXT」は現行富岳の約100倍、50EFLOPS以上を目指す

- 理化学研究所:理化学研究所、富士通およびNVIDIAとの国際連携による「富岳NEXT」の開発について

- CEATEC EXPERIENCE:次世代スーパーコンピュータ「富岳NEXT」、「AI for Science」推進で計算可能領域の拡張へ

- PR TIMES:『デジタルツイン2.0白書2026年版』発刊のお知らせ

- 工場DX研究所:【2026】デジタルツインとは?シミュレーションとの違いや活用事例を紹介

- ジェトロ:世界半導体市場は2026年、1兆ドル規模に王手の予測