生成AIを業務に試してみたものの、「結局チャットボット止まりだった」「PoCで終わってしまった」と感じている方は少なくないのではないでしょうか。

2025年を境に、AIは“答える存在”から“仕事を完遂する存在”へと進化しつつあります。その中心にあるのが、自ら目標を理解し、計画を立て、ツールを使って成果を出す自律型AIエージェントです。

実際に、グローバルではエージェント型AIを業務に組み込み、生産性や意思決定の質を大きく変え始めている企業が増えています。一方で、日本企業では期待の大きさとは裏腹に、導入が進まない現実も浮き彫りになっています。

本記事では、自律型AIエージェントの本質的な特徴から技術構造、グローバルと日本の実務適用事例、法的・倫理的な論点、そして2030年を見据えた戦略的ロードマップまでを体系的に整理します。

単なるトレンド解説ではなく、「なぜ今エージェントなのか」「どうすれば自社で使いこなせるのか」という実践的な視点を得たい方にとって、最後まで読む価値のある内容をお届けします。

生成AIから自律型AIエージェントへのパラダイムシフト

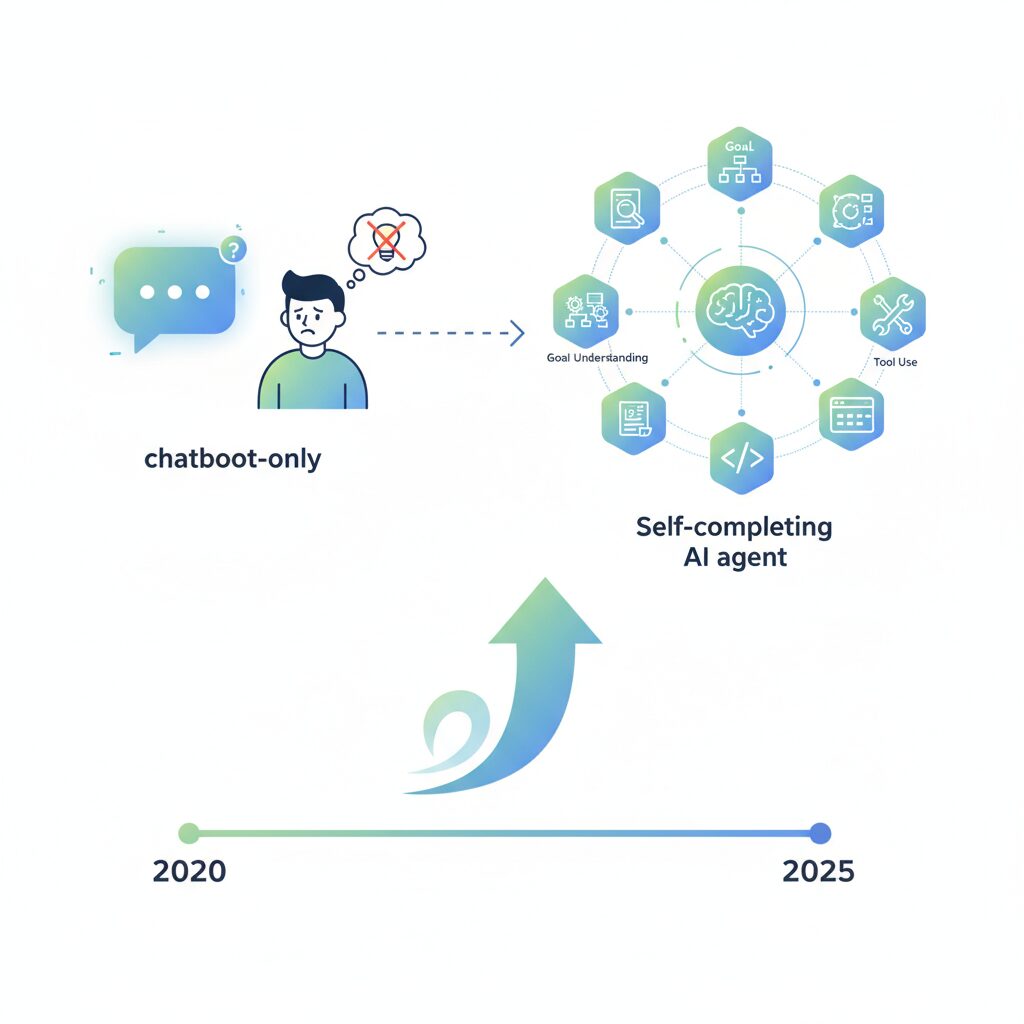

2025年を境に、生成AIを巡る議論の重心は大きく変わりつつあります。これまで主役だったのは、プロンプトに応じて文章やコードを返す生成AIでしたが、現在注目されているのは、目標を理解し、自ら計画し、行動まで完遂する自律型AIエージェントです。Deloitteが示すように、企業におけるAI活用は「生成」から「実行」へとフェーズが移行しており、AIは支援ツールではなく、実務を担う存在として再定義され始めています。

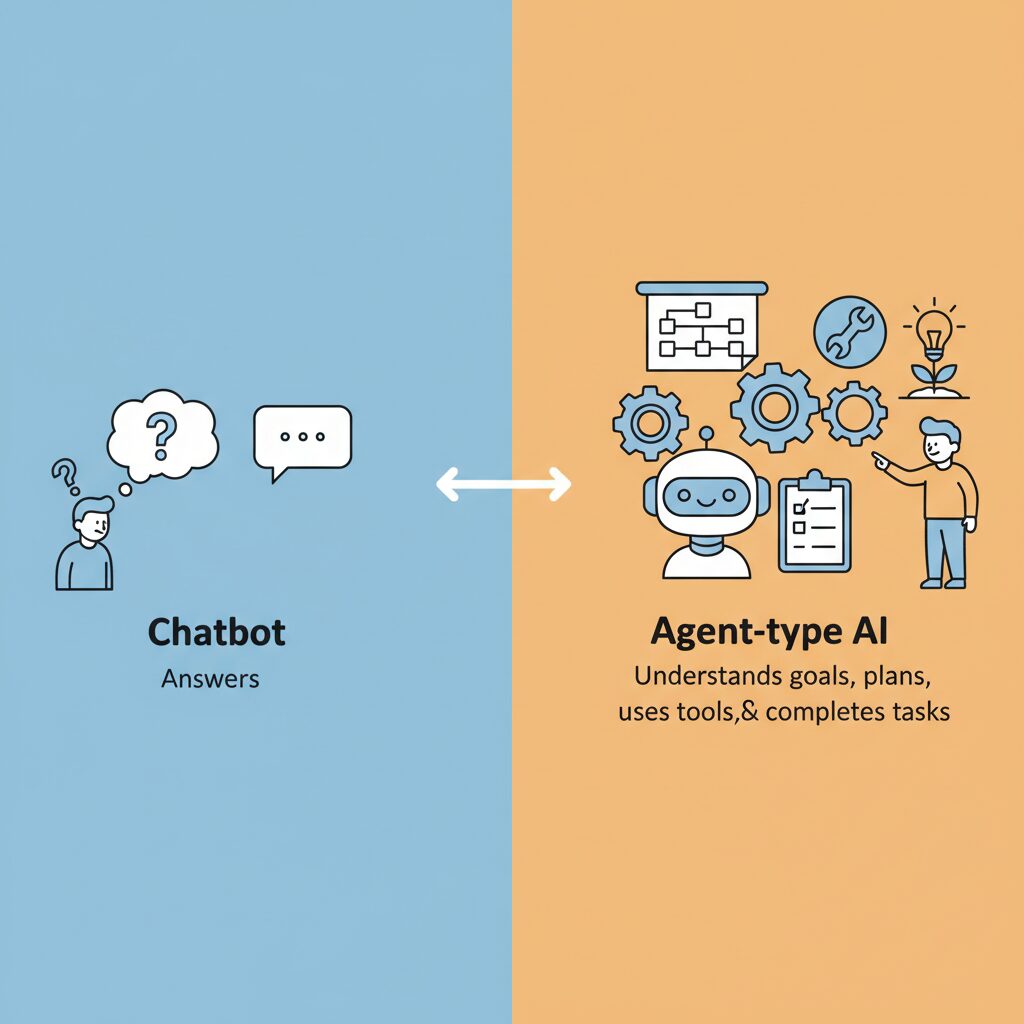

この変化を理解するうえで重要なのは、従来のチャットボットとエージェント型AIの役割の違いです。チャットボットはあくまで人間の問いかけを起点とする受動的な存在でした。一方でエージェント型AIは、与えられたゴールを起点にタスクを分解し、外部ツールを操作しながら結果を出す能動的な主体です。McKinseyの調査でも、世界の組織の約62%がAIエージェントを試験導入している一方、全社展開できている企業は1割未満にとどまり、ここにパラダイムシフトの難しさと同時に大きな伸び代が示されています。

| 観点 | 生成AI(チャットボット) | 自律型AIエージェント |

|---|---|---|

| 起点 | ユーザーの質問 | ユーザーの目標 |

| 行動範囲 | 情報生成まで | 計画・実行・修正まで |

| 価値 | 知識提供・補助 | 業務成果の創出 |

なぜ今、この転換が現実的になったのでしょうか。その背景には、推論能力が強化された大規模言語モデル、APIや業務システムと連携するツール利用の標準化、そしてRAGやベクターデータベースによる記憶管理技術の進化があります。OpenAIやDeepSeekが発表した推論特化型モデルは、AIが途中で破綻せずに長い業務プロセスを遂行する基盤を整えました。世界経済フォーラムも、こうした技術的収束がAIを「意思決定と行動の主体」へ押し上げていると分析しています。

特に日本では、労働人口減少という構造的課題がこのシフトを加速させています。みずほリサーチ&テクノロジーズの推計では、2035年に約850万人の労働力不足が見込まれており、自律型AIエージェントは生産性向上の選択肢ではなく、前提条件になりつつあります。生成AIが「考える補助輪」だとすれば、エージェントは「実際に走る同僚」です。この認識の転換こそが、生成AIから自律型AIエージェントへのパラダイムシフトの本質だと言えるでしょう。

チャットボットとエージェント型AIの決定的な違い

チャットボットとエージェント型AIの違いを一言で表すなら、**「応答する知能」か「仕事を完遂する主体」か**という点に集約されます。両者は同じ大規模言語モデルを基盤にしていても、設計思想と役割が根本的に異なります。

従来のチャットボットは、ユーザーからの入力に対して最も尤もらしい回答を返す受動的な存在です。質問への回答、文章生成、要約といった知的作業は得意ですが、その出力はあくまで判断材料に留まります。最終的な意思決定や実行は人間が担う前提であり、AIは「賢い相談相手」に近い位置づけです。

一方でエージェント型AIは、ユーザーから与えられたのが質問ではなく「目標」である点が決定的に異なります。目標を受け取ると、タスクを分解し、順序立てて計画を立案し、外部ツールを操作しながら結果を検証し、必要に応じて修正行動を取ります。**主体性、すなわちエージェンシーを持つこと**が本質です。

| 観点 | チャットボット | エージェント型AI |

|---|---|---|

| 起点 | 質問・指示 | 達成すべき目標 |

| 行動 | テキスト生成が中心 | 計画立案と実行 |

| ツール操作 | 基本的に不可 | APIや業務システムを操作 |

| 役割 | 意思決定支援 | 業務の代行・完遂 |

この違いは具体例で考えると明確です。例えば「大阪出張を準備してほしい」と依頼した場合、チャットボットは候補となるホテルや移動手段を列挙しますが、予約や社内調整までは行いません。対してエージェント型AIは、カレンダーを確認し、社内規定に沿った宿泊先を選定し、交通手配や関係者への連絡までを自律的に進めます。

デロイトによれば、2025年には生成AI活用企業の25%がエージェント型AIのパイロット運用を開始すると予測されています。これはAIが「考える存在」から「働く存在」へと役割を変えつつあることを示しています。

つまり、チャットボットは人間の知的作業を補助する道具であり、エージェント型AIはデジタル空間における労働主体です。この違いを理解することが、AI活用を単なる効率化で終わらせず、業務そのものを再設計する第一歩になります。

なぜ2025年にエージェント型AIが急速に実用化したのか

2025年にエージェント型AIが急速に実用化した最大の理由は、技術的ブレークスルーとビジネス要請が同時に臨界点を超えた点にあります。生成AIが話題先行の段階を終え、実務で成果を出すことが強く求められる局面に入りました。その中で、指示待ちではなく自律的に業務を完遂できるエージェント型AIが現実解として浮上しました。

まず決定的だったのは、推論特化型大規模言語モデルの成熟です。OpenAIのo1やDeepSeek-R1のように、複雑なタスクを段階的に分解し自己検証できるモデルが登場したことで、長時間タスクでも破綻しにくくなりました。複数の研究レビューによれば、こうしたモデルネイティブな推論能力は、従来のプロンプト工夫に依存した手法よりも失敗率を大幅に低減しています。これにより、**エージェントが途中で迷走するという致命的欠点が実務レベルで許容範囲に収まりました。**

次に、ツール連携の標準化が実装コストを劇的に下げました。Model Context Protocolの登場により、AIがカレンダー、CRM、社内データベースなどを共通仕様で扱えるようになりました。AnthropicやMicrosoftなど主要プレイヤーがこの流れに追随したことで、個別開発に伴う不確実性が減り、企業は安心して業務に組み込めるようになりました。

| 要因 | 2023年以前 | 2025年 |

|---|---|---|

| 推論能力 | 短文・単発タスク中心 | 長時間・多段タスクに対応 |

| ツール連携 | 個別API実装が必要 | 標準プロトコルで即接続 |

| 記憶管理 | 会話履歴のみ | RAGと長期記憶が実用化 |

さらに重要なのが、記憶管理技術の進化です。RAGとベクターデータベースの普及により、エージェントは社内規定や過去事例を参照しながら判断できます。マッキンゼーの調査でも、スケーリングに成功している企業は、例外なくナレッジ統合を重視していると指摘されています。**知識を忘れないAIになったことが、人に仕事を任せる感覚を企業にもたらしました。**

最後に見逃せないのが、社会経済的な圧力です。Deloitteは、2025年に生成AI利用企業の25%がエージェント型AIのパイロット運用を始めると予測しましたが、その背景には人手不足と生産性停滞があります。特に日本では、将来的に数百万人規模の労働力不足が見込まれており、AIを単なる支援ツールとして使う余裕はありませんでした。

これらの要因が重なった結果、2025年は「試してみる年」ではなく「使わなければ競争力を失う年」へと転換しました。エージェント型AIは技術的に可能になったからではなく、**使わざるを得ない必然性を帯びたことで一気に実用化が進んだ**のです。

自律型AIエージェントの技術的構造と主要コンポーネント

自律型AIエージェントの技術的構造を理解することは、単なる概念理解ではなく、実務で安全かつ再現性高く運用するための前提条件になります。近年の研究やDeloitte、マッキンゼーの分析によれば、2025年時点で主流となっているエージェントは、明確に分離された複数のコンポーネントによって構成されており、それぞれが役割分担することで自律性と制御性を両立しています。

中心となるのは「知覚・記憶・推論と計画・行動」という4層構造です。これは人間の認知モデルに近く、特に産業用途での信頼性確保において重要視されています。世界経済フォーラムやarXiv上の最新サーベイ論文でも、この分離設計がスケーラブルなエージェント実装の共通パターンであると指摘されています。

知覚(Perception)は、エージェントが世界と接続する唯一の窓口です。テキストだけでなく、画像、UI画面、ログデータなどを取り込み、状況を構造化して内部状態へ変換します。ブラウザ操作型エージェントが画面キャプチャからボタンや入力欄を認識できるのは、この層でマルチモーダルモデルが機能しているためです。

| コンポーネント | 主な役割 | 実務上の価値 |

|---|---|---|

| 知覚 | 外部情報の取得と解釈 | 環境変化への即応性 |

| 記憶 | 知識・経験の保持 | 一貫した判断と再利用性 |

| 推論・計画 | 目標分解と手順設計 | 長時間タスクの安定実行 |

| 行動 | ツールやAPIの操作 | 業務成果への直結 |

次に記憶(Memory)は、エージェントの品質を左右する差別化要因です。短期記憶は現在のタスク文脈を保持し、長期記憶は過去の成功・失敗や社内規定を蓄積します。RAGやベクターデータベースを用いた長期記憶設計は、パナソニック コネクトの事例が示すように、ハルシネーション抑制と業務精度向上に直結します。

推論と計画(Reasoning & Planning)は、従来の生成AIとエージェントを分ける核心部分です。単に文章を生成するのではなく、曖昧な目標を実行可能なアクションへ分解し、途中結果を評価しながら自己修正します。DeepSeek-R1や推論特化型モデルの登場により、外部ルールに依存しないモデル内在型の計画能力が実用水準に達したと、複数の研究論文で報告されています。

最後の行動とツール使用(Action & Tool Use)は、エージェントを「語る存在」から「働く存在」へ変換します。API呼び出し、コード実行、業務システムへの書き込みなどを担い、ここで初めてビジネス価値が生まれます。マッキンゼーが指摘するように、スケーリングに失敗する企業の多くは、この行動層の権限設計と制御に課題を抱えています。

重要なのは、これらのコンポーネントをブラックボックスとして扱わないことです。各層を独立して設計・監視できる構造こそが、自律性とガバナンスを両立させ、日本企業が実務でAIエージェントを使いこなすための技術的基盤になります。

主要エージェント開発フレームワークの特徴と選び方

主要なエージェント開発フレームワークは数多く存在しますが、選定を誤るとPoC止まりに終わる可能性が高まります。**重要なのは機能の多さではなく、どの思想で設計され、どこまで制御できるか**です。マッキンゼーが指摘するように、AIエージェントを全社規模でスケールできている企業が1割未満に留まる最大の理由は、初期設計段階でのフレームワーク選択にあります。

現在主流のフレームワークは、大きく「自律性重視」と「制御性重視」に分かれます。前者はエージェント同士の対話や自己判断を最大化し、後者は業務フローや状態遷移を厳密に管理します。実務適用が進む2025年以降は、後者への回帰が顕著です。

| フレームワーク | 設計思想 | 実務適合性 |

|---|---|---|

| AutoGen | 会話型マルチエージェント | 開発・分析用途に強い |

| CrewAI | ロール分担による協調 | 非エンジニアでも扱いやすい |

| LangGraph | 状態遷移の厳密制御 | 基幹業務・承認フロー向き |

| PydanticAI | 型安全性と検証重視 | 本番運用・業務組込向き |

例えばMicrosoftのAutoGenは、エージェント同士が自然言語で議論しながらコード生成や分析を進める点が評価されています。一方で、無限ループや予期せぬ挙動のリスクも報告されており、**高度な自律性はそのまま運用リスクに直結する**ことを理解する必要があります。

対照的にLangGraphは、処理をグラフ構造で定義し、人間の承認ノードを明示的に組み込めます。Deloitteのレポートでも、エンタープライズ領域ではHuman-in-the-loopを前提とした制御可能な設計が不可欠とされています。PydanticAIはさらに踏み込み、入出力スキーマを厳格に検証することで、ハルシネーションが業務データに混入するリスクを最小化します。

選び方の軸は明確です。**試作段階では自律性、本番では制御性**が重要になります。短期的なデモの派手さではなく、誤動作時に止められるか、責任範囲を定義できるかが判断基準です。実務で成果を出している企業ほど、段階的にフレームワークを使い分けています。

最終的に問われるのは「どのフレームワークが優れているか」ではなく、「自社の業務リスクと成長フェーズに適合しているか」です。エージェントは労働力そのものになる存在だからこそ、開発基盤の選択が企業競争力を左右する時代に入っています。

グローバル市場に見る産業別の導入状況とインパクト

自律型AIエージェントの導入は、国別だけでなく産業別に見ても明確な濃淡が現れています。グローバル全体では、デジタル完結度の高い産業ほど導入が早く、物理的・規制的制約が強い産業ほど慎重になる傾向が確認されています。

マッキンゼーのThe State of AI 2025によれば、**テクノロジー・メディア・通信(TMT)とヘルスケアが、エージェント型AIの導入と投資の両面で先行**しています。TMTでは、ソフトウェア開発、ITサービスデスク、デジタル広告運用など、入力から出力までが完全にデジタルな業務が多く、エージェントによる自律実行のROIが可視化しやすい点が強みです。

| 産業 | 主な適用領域 | インパクトの特徴 |

|---|---|---|

| TMT | 開発、IT運用、広告最適化 | 人件費削減と開発速度の飛躍的向上 |

| ヘルスケア | 診断支援、事務処理 | 専門人材不足の補完と品質の標準化 |

| 製造業 | 生産計画、品質管理 | 柔軟な多品種少量生産への転換 |

| 小売・EC | 顧客対応、在庫管理 | 顧客体験の高度化と運営効率化 |

ヘルスケア分野では、中国の事例が象徴的です。世界経済フォーラムの報告によれば、AIエージェントが診断プロセス全体をシミュレーションする「バーチャル病院」では、呼吸器疾患の診断精度がMedQAベンチマークで93%超に達しました。**これはAIが単なる事務効率化を超え、臨床判断の補助という高付加価値領域に踏み込んでいることを示しています。**

一方、製造業では導入形態が異なります。中国では170万台を超える産業用ロボットとAIエージェントを連携させ、現場状況に応じて生産条件を自律調整する取り組みが進んでいます。従来の固定プログラム型制御と比べ、段取り替え時間の短縮や不良率低下といった実務的成果が報告されており、**エージェントはホワイトカラーだけでなくブルーカラーの生産性にも影響を及ぼし始めています。**

小売・ECやカスタマーサポートでは、米国スタートアップの存在感が際立ちます。問い合わせ対応の80%以上を自律解決するエージェントが登場し、返金処理や配送変更まで完遂する事例も珍しくありません。デロイトは、こうした領域では2027年までに「人間は例外処理のみを担当する運用モデル」が主流になると指摘しています。

ただし、すべての産業が同じ速度でスケールできているわけではありません。**世界の企業の62%が実験段階にある一方、特定業務で大規模展開できているのは23%にとどまる**という数字が示す通り、規制、責任分界、品質保証が重い産業ほど慎重です。産業別の導入状況を俯瞰すると、自律型AIエージェントは万能技術ではなく、各産業の構造的課題を映す「鏡」として機能していることが浮き彫りになります。

日本企業における実務適用事例と成功要因

日本企業における自律型AIエージェントの実務適用は、慎重な姿勢が目立つ一方で、導入設計と組織運営を工夫することで明確な成果を上げている事例が着実に現れています。成功企業に共通するのは、最新技術の採用そのものよりも、業務文脈への適合と人間側の関与設計を重視している点です。

代表例としてソフトバンクの取り組みは、日本的組織文化の制約を逆手に取った事例です。全社員参加型でAIエージェント作成を義務化し、短期間で250万以上のエージェントが生まれました。このアプローチにより、AI活用が一部のDX部門に閉じず、現場主導で実用性の高いエージェントが自然淘汰される環境が形成されました。Deloitteが指摘するように、AIエージェントは試行錯誤を通じた学習が不可欠であり、参加率の高さ自体が競争優位になります。

一方、リクルートの観光DX実証実験は「一点突破型」の成功モデルです。熱海市におけるマーケティング分析や多言語対応にエージェントを投入し、分析工数を最大15分の1まで削減しました。ここで重要なのは、全業務を自動化しようとせず、人手不足が深刻で、かつ成果が定量化しやすい業務に限定した点です。マッキンゼーの調査でも、スケーリングに成功する企業は適用範囲を意図的に絞っていると報告されています。

| 企業 | 主な適用領域 | 確認された効果 |

|---|---|---|

| ソフトバンク | 全社業務改善 | AIリテラシーの底上げと大量の業務特化エージェント創出 |

| リクルート | 観光マーケティング | 分析・翻訳工数の大幅削減 |

| パナソニック コネクト | 技術サポート | ハルシネーション抑制と回答精度向上 |

パナソニック コネクトの事例は、日本企業が特に重視する「信頼性」への回答です。同社はRAGにナレッジグラフを組み合わせ、製品知識の論理構造をエージェントに理解させました。これにより、製造業特有の複雑な問い合わせでも高精度な応答が可能となり、AIは使えるが信用できないという現場の不安を技術で解消しています。

これらの事例から導かれる成功要因は明確です。第一に、トップダウンかボトルネック特化か、明確な導入戦略を持つこと。第二に、人間の確認や学習を前提とした運用設計を行うこと。第三に、日本企業が重視する品質や説明責任に耐えうる技術構成を採用することです。世界平均より導入率は低いものの、条件を満たした企業ではエージェントが確実に実務成果を生んでいる点は、AI専門家にとって見逃せない示唆と言えます。

ハルシネーションとどう向き合うか:信頼性確保の実践手法

自律型AIエージェントの実務適用が進むにつれ、避けて通れない課題がハルシネーションです。特にエージェントは自律的に判断し行動するため、誤情報がそのまま業務プロセスに組み込まれるリスクがあります。マッキンゼーの調査でも、多くの企業がスケーリングに踏み切れない最大要因として信頼性への不安を挙げています。重要なのは、ハルシネーションをゼロにする発想ではなく、前提として管理する設計思想です。

実践的な第一歩は、情報源を限定することです。大規模言語モデル単体に自由回答させるのではなく、RAGによって参照可能なデータを社内ナレッジや検証済み資料に絞ります。パナソニック コネクトが採用したRAGとナレッジグラフの組み合わせは、情報の正確性だけでなく、因果関係や仕様の整合性まで担保できる点で注目されています。これは製造業のように曖昧さが許されない領域で特に有効です。

| 対策アプローチ | 主な役割 | 信頼性への効果 |

|---|---|---|

| RAG | 参照情報の限定 | 事実誤認の低減 |

| ナレッジグラフ | 関係性の構造化 | 論理破綻の防止 |

| Human-in-the-loop | 人間による確認 | 業務事故の回避 |

第二に重要なのが、人間参加型の運用設計です。Deloitteが指摘するように、初期段階のエージェントは新入社員と同様に扱うべきです。すべてのアウトプットを人がレビューし、誤りや修正内容を記憶としてフィードバックします。この循環によって、エージェントは業務文脈に適応し、再発しやすいハルシネーションの傾向も把握できます。信頼性はモデル性能ではなく、運用プロセスから生まれます。

最後に、評価指標の設計も欠かせません。正答率だけでなく、「根拠を提示できた割合」や「人間修正の頻度」といったプロセス指標を継続的に監視します。これにより、ハルシネーションが顕在化する前兆を捉えることが可能です。日本総研も、エージェントの安全性確保には権限管理と可観測性の両立が不可欠だと指摘しています。ハルシネーションと向き合うとは、AIを疑うことではなく、検証可能な仕組みを組み込むことです。

法的・倫理的リスクと日本企業に求められるガバナンス

自律型AIエージェントの実装が進むにつれ、法的・倫理的リスクは抽象論ではなく、経営リスクそのものとして顕在化しています。特にエージェントは人間の明示的な操作を介さずに判断・実行を行うため、「誰が責任を負うのか」「どこまで任せてよいのか」という問いが避けられません。

日本における重要な指針が、総務省・経済産業省が公表したAI事業者ガイドライン1.0です。これはEUのAI法のような罰則付き規制ではなく、ソフトローとして企業の自主的対応を促す設計になっています。しかし、専門家の間では、事故やトラブル発生時にガイドライン不遵守が過失判断の根拠になり得る点が繰り返し指摘されています。法的拘束力がないから無視してよい、という理解は極めて危険です。

特に日本企業が直面しやすいのが、契約や発注をAIエージェントに委ねた場合の責任問題です。電子消費者契約法はB2C取引において消費者保護を定めていますが、B2B取引には適用されません。研究者や実務家の分析によれば、業務用エージェントが誤って大量発注や不利な契約を結んだ場合、その結果責任は原則として企業側が負うと解釈される可能性が高いとされています。

| リスク領域 | 具体例 | 企業に求められる対応 |

|---|---|---|

| 契約・発注 | 購買エージェントの誤発注 | 金額・数量条件での自動停止ルール |

| 倫理・人権 | 差別的判断の自動化 | 学習データと判断結果の定期監査 |

| セキュリティ | プロンプト・インジェクション | 最小権限設計と人間承認フロー |

また、セキュリティ面ではプロンプト・インジェクションが深刻な脅威として認識されています。日本総研の分析によれば、外部情報を自律的に読み取るエージェントほど、悪意ある指示を誤って実行するリスクが高まります。これに対し、権限を細かく分離し、人間が最終的に統制する設計がガバナンスの中核になります。

重要なのは、ガバナンスを「利用を縛るためのブレーキ」と捉えないことです。多くの先進企業では、責任分界点、監査ログ、緊急停止手段を明確化することで、むしろ安心してエージェントの自律性を高めています。日本企業に求められるのは、法令遵守と倫理配慮を前提にした設計思想そのものを、AIエージェントのアーキテクチャに組み込むことだと言えます。

2026〜2030年を見据えた自律型AIエージェント導入ロードマップ

2026〜2030年を見据えた自律型AIエージェント導入ロードマップでは、技術論よりも「組織としてどう成熟していくか」が主戦場になります。Deloitteの予測によれば、2027年までに生成AI活用企業の50%がエージェントを導入するとされていますが、McKinseyが指摘する通り、全社スケールまで到達できる企業は依然として少数派です。このギャップを埋めるためには、時間軸に沿った戦略設計が不可欠です。

2026〜2027年は「制御された実装フェーズ」です。この段階では、完全自律を目指すのではなく、Human-in-the-loopを前提とした業務統合が中心となります。特に日本企業では、ハルシネーションや誤操作リスクへの懸念が強いため、人間の最終判断を組み込んだ設計こそが導入速度を高める近道になります。Deloitteも、初期のエージェントは新入社員として扱い、レビューとフィードバックを前提に運用すべきだと述べています。

2028年前後に入ると、ロードマップは「オーケストレーションと横断連携」の段階へ進みます。LangGraphやVertex AI Agent Builderのような基盤を用い、複数エージェントを役割分担させる動きが加速します。リサーチ、分析、実行、監査といった工程を分離することで、単体エージェントでは難しかった長時間・高信頼タスクが可能になります。この時期の競争力は、モデル性能ではなくエージェント同士をどう協調させるかで決まります。

| 期間 | 導入の主眼 | 組織の成熟度 |

|---|---|---|

| 2026〜2027 | パイロットと部分自動化 | 人間主導・検証重視 |

| 2028 | マルチエージェント連携 | 監督型マネジメント |

| 2029〜2030 | 業務単位での自律運用 | 成果ベース評価 |

2029〜2030年には、「Human-on-the-loop」への移行が現実的になります。これは人間が逐一確認するのではなく、異常時のみ介入する監督モデルです。みずほリサーチ&テクノロジーズが示す労働力不足の試算を踏まえると、この段階で初めてAIエージェントは実質的な労働力として機能します。重要なのは、評価軸が「正確に動いたか」からどれだけ成果を出したかへ変わる点です。

このロードマップ全体を通じて一貫して重要なのは、標準化への追従です。AnthropicやMicrosoftが関与するMCPやACPといったプロトコルにより、エージェントは特定ベンダーに閉じない存在になりつつあります。世界経済フォーラムも、相互運用性が産業レベルのAI活用を左右すると指摘しています。2026〜2030年の勝者は、最も高度なAIを持つ企業ではなく、進化を前提に組織と業務を設計できた企業になるでしょう。

参考文献

- Deloitte Insights:Autonomous generative AI agents

- McKinsey & Company:The State of AI: Global Survey 2025

- みずほリサーチ&テクノロジーズ:AIは人手不足解消のカギになるか

- arXiv:Beyond Pipelines: A Survey of the Paradigm Shift toward Model-Native Agentic AI

- World Economic Forum:Blueprint to Action: China’s Path to AI-Powered Industry Transformation

- MarkeZine:リクルート、生成AIを活用した観光マーケティングの実証実験を開始