生成AIやAIエージェントの進化により、企業のデータ活用は新たな段階へと入りました。これまで多くの企業が悩まされてきたデータサイロの問題は、単なる業務効率の低下では済まされなくなっています。

AIが自律的に判断し、業務を横断して実行する時代において、データの分断や定義の揺らぎは、誤作動や誤った意思決定を連鎖的に引き起こす深刻なリスクとなります。人間の経験で補えていた曖昧さは、AIにとっては致命的な欠陥です。

さらに2026年現在、日本企業は「2025年の崖」を越えた先で、レガシーシステム、AIサイロ、ROIが見えないDX投資といった複合課題に直面しています。本記事では、AIエージェント時代に求められるデータ統合の本質を整理し、MDMやセマンティックレイヤー、Data MeshとData Fabricの融合、そして価値創出につながる実践的な視点を体系的に解説します。

データとAIを競争力に変えたい方にとって、本記事は戦略設計の指針となるはずです。

2026年に起きているデータ統合のパラダイムシフト

2026年に起きているデータ統合の最大の変化は、技術刷新ではなく思考様式そのものの転換にあります。生成AIが業務に深く入り込んだ現在、データ統合は「人が分析するための下準備」ではなく、「AIが理解し行動するための前提条件」へと役割を変えています。Forresterが2026年を再評価の年と位置づけたように、PoC中心のAI活用は終わり、実運用で価値を生むかどうかが厳しく問われています。

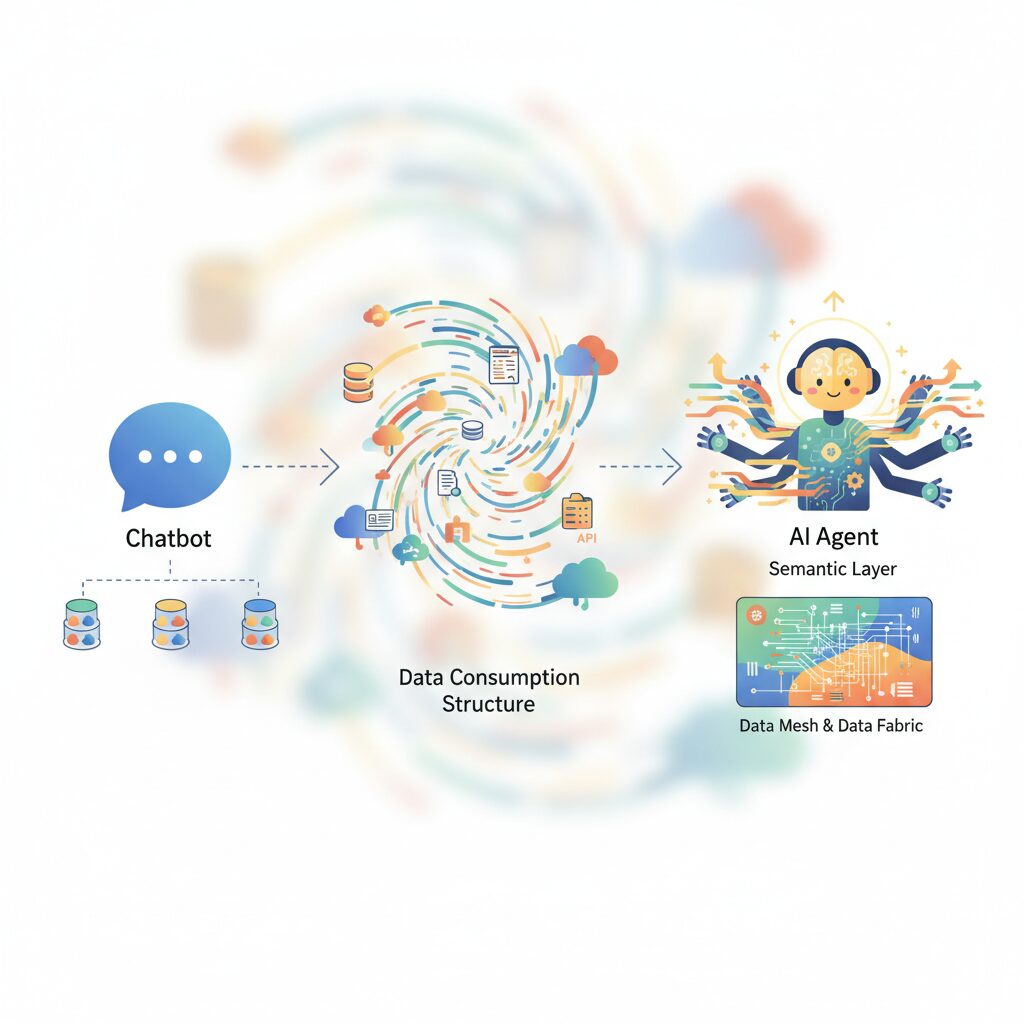

特に重要なのは、チャットボット型AIから自律的にタスクを遂行するAIエージェントへの進化です。IDCによれば、主要企業におけるAIエージェント利用は2027年までに10倍に増え、APIコールやデータ参照量は桁違いに増大すると予測されています。**これはデータが「参照される資産」から「意思決定を駆動する燃料」へ変わったことを意味します。**

この変化により、従来は見過ごされがちだったデータ定義の曖昧さが、直接的な経営リスクとして顕在化しました。人間であれば文脈補完できた表記揺れや解釈差が、AIエージェント同士の連携では誤発注や誤判断として連鎖します。Gartnerが指摘するハルシネーション対策コストの増大は、その背景に統合不全のデータ基盤があることを示唆しています。

| 観点 | 従来のデータ統合 | 2026年以降のデータ統合 |

|---|---|---|

| 主な利用者 | 人間(分析担当者) | AIエージェント |

| 重視点 | 可視化・レポート | 意味定義・一貫性 |

| リスク | 分析精度の低下 | 自律処理の誤作動 |

さらに2026年特有の現象として、領域特化型AIの増殖による「AIサイロ」が問題視されています。製造、財務、マーケティングそれぞれに最適化されたAIが独自の前提でデータを解釈すると、組織全体として意味の不整合が生じます。**同じ「売上」という言葉が、AIごとに異なる現実を指す状態は、もはや許容できません。**

この文脈で再評価されているのが、マスターデータ管理とセマンティックな共通定義です。MDMは単なる裏方ではなく、AIにとっての信頼の源泉として位置づけられています。どのAIも同じ顧客ID、同じ製品定義を参照することで、初めて自律分散型の業務連携が成立します。データ統合のパラダイムシフトとは、AIを前提に組織の「共通言語」を再設計する動きにほかなりません。

チャットボットからAIエージェントへ―データ消費構造の変化

2026年に入り、企業における生成AI活用の重心は、対話型のチャットボットから自律的に業務を遂行するAIエージェントへと明確に移行しています。この変化はUIの進化にとどまらず、**データがどのように消費され、意思決定に使われるのかという構造そのものを変えつつあります**。

従来のチャットボットは、人間が質問を投げ、AIが文章で応答するという一方向的な支援が中心でした。多少データ定義が曖昧でも、人間が文脈補完できたため、データ統合の要件は比較的緩やかでした。しかしAIエージェントは、人間の介在なしにシステムを横断し、判断し、実行します。そのため、データは「読むもの」から「行動を駆動する燃料」へと性質を変えています。

| 観点 | チャットボット | AIエージェント |

|---|---|---|

| 主な役割 | 質問応答・補助 | 自律的な業務実行 |

| データ消費 | 参照中心 | 参照+更新+判断 |

| 許容される曖昧さ | 比較的高い | 極めて低い |

Forresterが2026年の予測で指摘している通り、エンタープライズソフトウェアはユーザー中心設計から、**人間とAIエージェントの双方を「労働者」と見なす設計思想へ移行しています**。これは、画面の使いやすさよりも、APIの整合性やデータ定義の一貫性が価値の源泉になることを意味します。

IDCの予測では、2027年までに主要企業で稼働するAIエージェント数は現在の約10倍に増加し、APIコールやトークン消費量は1,000倍規模に達するとされています。これは、データ消費が人間主導の断続的アクセスから、機械主導の常時・高速アクセスへ変わることを示す定量的な裏付けです。

この環境下では、データの表記揺れや意味の不統一は致命的です。人間なら会議で調整できた「売上」や「在庫」といった定義のズレが、AIエージェント同士では即座に誤った処理として連鎖します。**2026年のデータ統合とは、人間が理解するためではなく、機械が誤解せず行動するための統合**だと言えます。

チャットボット時代の延長線でデータを考え続ける限り、AIエージェントは真価を発揮できません。データ消費構造の変化を正しく理解できるかどうかが、AIを実験で終わらせる企業と、競争力の中核に据える企業を分ける分水嶺になっています。

組織を分断する新たな脅威「AIサイロ」とは何か

近年、組織を分断する新たな脅威として注目されているのが「AIサイロ」です。これは従来のデータサイロが、部門やシステム単位で情報が孤立していたのに対し、業務ごとに導入された特化型AIそのものが孤立し、相互に理解できない状態を指します。生成AIの活用が実証実験から本格運用へ移行した2026年、この問題は急速に顕在化しています。

背景には、汎用LLMだけでは業務精度が不足するという反省があります。Forresterの分析によれば、多くの企業が製造、財務、医療、マーケティングなど領域特化型モデルの導入を進めています。しかし、それぞれのAIが異なるデータ定義や前提知識で学習すると、同じ言葉でも意味が一致しません。人間であれば会話で調整できた認識のズレが、AI同士では自動処理のまま連鎖的な誤判断を生む点が、AIサイロの本質的な危険性です。

例えば「売上」という指標一つでも、営業AIは受注金額、財務AIは入金額、マーケティングAIは将来価値を含む指標として扱う場合があります。この違いが放置されると、在庫補充や価格調整を行うAIエージェントが、互いに矛盾したアクションを実行しかねません。IDCは、AIエージェントの利用拡大により、API呼び出しや自動処理の規模が指数関数的に増えると予測しており、小さな定義のズレが経営リスクへ直結すると警鐘を鳴らしています。

| 観点 | 従来のデータサイロ | AIサイロ |

|---|---|---|

| 分断の主体 | 部門・システム | 特化型AI・AIエージェント |

| 主な問題 | データ共有の遅れ | 意味理解の不一致 |

| 影響範囲 | 業務効率 | 自律判断・経営意思決定 |

重要なのは、AIサイロが技術的な問題にとどまらず、組織の知能そのものを分断する点です。ガートナーも、AI活用の失敗要因として「意味と前提条件のガバナンス不足」を挙げています。個別最適を追求してAIを増やすほど、全体最適が失われるという逆説が起きているのです。

このため、AIサイロは単にモデルを統合すれば解決する問題ではありません。共通の言語や定義、信頼できる参照点がなければ、AIは高速で誤りを量産します。AI時代のサイロとは、データの壁ではなく意味の壁であり、それを自覚できるかどうかが、組織の将来を大きく左右します。

共通言語として再評価されるMDMとセマンティックレイヤー

AIエージェントが組織横断で自律的に意思決定を行う時代において、MDMとセマンティックレイヤーは単なるデータ管理技術ではなく、組織の共通言語を再構築するための中核的インフラとして再評価されています。特に2026年以降、領域特化型AIが増殖するにつれ、人間同士では暗黙的に補正できていた言葉の揺らぎが、AI間では致命的な誤作動を引き起こすことが明らかになってきました。

Forresterの分析によれば、AIエージェント活用が失敗する最大要因の一つは「意味定義の不整合」であり、データ量やモデル性能以前に、共通の前提が欠如している点が問題視されています。ここでMDMは、顧客・製品・取引先といった基幹エンティティに一意な識別子と正規化された定義を与え、AIにとっての信頼できる唯一の参照点を提供します。

一方で、MDMだけでは十分ではありません。売上や利益、KPIといったビジネス概念は、計算ロジックや利用文脈まで含めて共有されなければ、AIは正しく行動できないからです。ここで重要になるのがセマンティックレイヤーです。Gartnerが指摘するように、セマンティックレイヤーは「組織の常識を機械可読な形で実装する層」として、マルチエージェント環境の安全装置として機能します。

| 観点 | MDM | セマンティックレイヤー |

|---|---|---|

| 主対象 | 顧客・製品などのマスター | KPI・指標・業務用語 |

| 役割 | 一意性と正統性の担保 | 意味と計算ロジックの統一 |

| AIへの効果 | 参照ミスの防止 | 判断の一貫性確保 |

例えば「売上」という言葉一つでも、受注基準か請求基準かで意味は大きく異なります。セマンティックレイヤー上でその定義をAPI経由で提供することで、営業AI、財務AI、経営分析AIが同一の前提で動作するようになります。これは人間向けのダッシュボード最適化ではなく、AI同士の対話品質を保証する設計です。

結果として、MDMとセマンティックレイヤーを組み合わせた企業では、AIエージェント間の調整コストが大幅に削減され、誤った自動処理やハルシネーション連鎖のリスクが抑制されていると報告されています。共通言語の整備は地味に見えますが、AI時代においては最も戦略的な投資領域の一つになっているのです。

Data MeshとData Fabricはなぜ融合へ向かったのか

Data MeshとData Fabricが融合へ向かった最大の理由は、**生成AIとAIエージェントの実運用が始まり、従来のアーキテクチャ思想だけでは現実の複雑性を支えきれなくなった**ことにあります。理論としては対照的だった両者が、2026年には実務の現場で補完関係にあることが明確になりました。

Data Meshは、ドメインごとにデータのオーナーシップを委譲し、現場の知識を最大限に活かす設計思想です。一方でData Fabricは、メタデータや自動化を用いて、データ発見・接続・統合・セキュリティを横断的に制御する基盤アプローチです。ガートナーが指摘するように、AI活用が本格化した組織では、どちらか一方のみではスケールと統制の両立が困難になっています。

特にAIエージェント時代においては、データは人間が読むためのものではなく、**機械が解釈し即座に行動へ移すための入力資源**となります。このとき、ドメイン単位で意味づけされた高品質データは不可欠ですが、それを全社・全AIに安全かつ一貫して届ける仕組みがなければ、AIサイロや誤作動の温床となります。

| 観点 | Data Mesh単体 | Data Fabric単体 |

|---|---|---|

| 強み | ドメイン知識の反映、俊敏性 | 自動化、横断統制、可視性 |

| 限界 | 技術重複、ガバナンスのばらつき | 中央ITのボトルネック化 |

この限界を突きつけたのが、特化型AIやマルチエージェントの増殖です。Forresterの2026年予測によれば、AIエージェントは複数の業務システムを横断し、API経由でデータを高速消費します。このとき、ドメインごとに異なる定義や品質基準が露呈すると、AI同士が「会話できない」状態に陥ります。

そこで採用が進んだのが、**論理は分散、実装は集中**という融合モデルです。意味定義や品質責任はData Meshの考え方で現場に委ねつつ、データ接続、カタログ、セキュリティ、リネージ管理といった共通機能はData Fabricとして中央提供します。この分業構造により、スピードと信頼性を同時に満たせることが実証されました。

日本企業においても、2025年の崖を越える過程でこの融合は現実解となっています。レガシーを抱えた環境では、全社統一基盤を一気に作ることは困難ですが、Fabric的な基盤で既存資産を包み込みつつ、Mesh的に価値あるデータプロダクトを育てるアプローチが機能しています。

もはや「中央集権か分散か」という二項対立は意味を持ちません。**AIが理解できる意味の一貫性と、組織が動けるスピードをどう両立させるか**という問いに対する答えが、この融合モデルだったのです。

RAG本番運用で顕在化するベクトルデータのサイロ問題

RAGは企業独自データを生成AIに安全かつ高精度に接続する手法として急速に普及しましたが、本番運用フェーズで顕在化しているのがベクトルデータのサイロ問題です。PoC段階では部門単位や用途別にベクトル化と検索精度を確認できれば十分でしたが、その延長線上で本番化すると、組織全体にとって深刻な歪みを生み出します。

多くの企業では、FAQ用、法務文書用、技術マニュアル用といった形で、目的別にベクトルデータベースが乱立しています。これ自体は合理的に見えますが、更新頻度、前処理ルール、埋め込みモデル、メタデータ設計が統一されていない場合、同じ原文書を参照しているはずのRAGでも回答内容に差異が生じます。Gartnerが指摘するように、生成AIの信頼性低下はモデル性能よりもデータ管理不備に起因する割合が高いとされています。

特に問題となるのが、ベクトル化後のデータが「二級データ」として扱われがちな点です。元のドキュメントは更新されているにもかかわらず、ベクトル再生成が行われず、AIが過去の情報をあたかも最新のように提示してしまうケースが報告されています。これは単なる精度低下ではなく、誤った意思決定を自動化するリスクに直結します。

| 観点 | PoC段階 | 本番運用での問題 |

|---|---|---|

| 更新管理 | 手動・非定期 | 陳腐化による誤回答 |

| 権限継承 | 考慮されない | 情報漏洩リスク |

| 設計思想 | 用途特化 | 全社最適を阻害 |

さらに深刻なのがアクセス制御です。元データでは厳密に権限管理されていても、ベクトルデータベース側に同等の制御が実装されていない場合、検索結果経由で本来閲覧不可の情報が露出する可能性があります。Forresterも、RAGの本番障害の多くがセキュリティとガバナンスに集中していると分析しています。

この問題に対し、先進企業ではVectorOpsやLLMOpsの考え方を導入し、ベクトル生成から廃棄までをデータライフサイクルとして管理しています。具体的には、原文書の更新をトリガーに自動再埋め込みを行い、リネージ情報と可観測性を付与する仕組みです。ベクトルを一時的な副産物ではなく、第一級の業務データとして扱うことが、本番RAG成功の前提条件になりつつあります。

RAGは検索精度の工夫だけで競争優位が決まる段階を終えました。2026年の実運用では、ベクトルデータをいかに統制し、組織横断で再利用可能な形に保つかが、AI活用の成熟度を測る明確な分水嶺となっています。

2025年の崖を越えた日本企業が直面する現実

2025年の崖を越えた日本企業の多くは、劇的な崩壊ではなく、より厳しい現実に直面しています。それは、レガシーシステムを抱えたまま事業は継続できているものの、競争力だけが静かに削られていく状態です。経済産業省がDXレポートで示した年間最大12兆円の経済損失は、単年で可視化されるものではなく、投資機会の逸失や意思決定の遅延として企業体力を蝕んでいます。

2026年時点の調査では、多くの日本企業でIT予算の約8割が既存システムの維持運用に充てられています。これはForresterやGartnerが指摘する「Year of Reckoning」、すなわちAI投資の成果が厳しく問われる局面において、攻めのAI活用に必要な原資と時間が決定的に不足していることを意味します。

特に深刻なのが、人材とデータの両面での制約です。COBOLや独自仕様に精通したベテランの退職が進み、システムは事実上ブラックボックス化しています。その結果、AIエージェントを導入しようとしても、必要なデータをAPIで取得できず、PoC止まりで終わるケースが後を絶ちません。これは技術の問題というより、過去の意思決定が現在の選択肢を奪っている構造問題です。

| 項目 | 崖を越えた企業の現実 | 競争力への影響 |

|---|---|---|

| IT予算配分 | 維持運用が約8割 | AI・新規事業投資が進まない |

| 人材構成 | レガシー依存・高齢化 | 変革スピードの低下 |

| データ状態 | 部門・システムごとに分断 | AI活用が局所最適に留まる |

さらに見過ごせないのが、生成AIとAIエージェントの普及によって市場環境そのものが変わった点です。Gartnerによれば、生成AIはすでに「差別化要因」ではなく「前提条件」になりつつあります。顧客対応、需要予測、サプライチェーン最適化をAIエージェントで自動化する企業が増える中、データサイロを抱えた企業は競争の土俵に立てない状態に陥っています。

実際、国内外の先進企業では、AIエージェントが24時間稼働し、部門横断で意思決定を支援する体制が整いつつあります。一方で、日本企業の多くは、データ連携に時間がかかり、意思決定が人手と会議に依存したままです。この差は年々拡大し、価格競争力や顧客体験、パートナー選定に直接影響します。

重要なのは、2025年の崖は「終わったイベント」ではないという認識です。むしろ2026年以降、その影響はAI時代の適応力の差として顕在化しています。崖を越えた日本企業が直面する現実とは、過去の負債を抱えたまま、AIネイティブ企業と同じスピードで走ることを求められる、極めて厳しい競争環境そのものなのです。

iPaaSとデータ連携基盤の進化がもたらす選択肢

iPaaSとデータ連携基盤の進化は、企業にとって「どのツールを選ぶか」という単純な比較の段階をすでに超えています。2026年現在の本質的な変化は、データ連携そのものが戦略的な選択肢になった点にあります。AIエージェントが複数システムを横断して自律的に動く前提では、連携基盤は単なる中継装置ではなく、意思決定の速度と安全性を左右する中枢神経として機能します。

ForresterやGartnerの分析によれば、生成AIの実運用フェーズに入った企業ほど、APIコールの急増やデータ定義の不整合による障害を経験しています。こうした背景から、iPaaSは「つなげば終わり」のツールではなく、可観測性・ガバナンス・AI連携を前提に設計された基盤へと進化しています。

特に注目すべきは、iPaaSの選択が組織構造や運用モデルと強く結びつくようになった点です。ノーコード型iPaaSは現場主導のデータ活用を後押しする一方、エンタープライズ向けiPaaSはAIエージェント基盤としての統制と拡張性を重視します。これは技術の優劣ではなく、誰がデータ連携を主導するのかという経営判断の違いを反映しています。

| 観点 | 従来型iPaaS | 2026年型iPaaS |

|---|---|---|

| 主目的 | システム間接続の自動化 | AIエージェント前提のデータ流通 |

| 価値の源泉 | 開発・運用コスト削減 | 意思決定スピードと信頼性 |

| 中核機能 | コネクタとワークフロー | 可観測性、セマンティクス、AIアダプター |

また、生成AIアダプターの標準化は選択肢を大きく広げました。例えば、非構造化データをAIで解釈し、正規化して基幹系へ戻すといった処理が、ノーコードで実装可能になっています。ASTERIA Warpなどの事例が示すように、データクレンジングや名寄せをAIに委ねる設計は、従来の人手依存プロセスを根本から置き換えつつあります。

一方で、RAGやマルチエージェント運用が進むほど、連携基盤の乱立という新たなリスクも顕在化します。IDCが指摘するように、API負荷や連携フローのブラックボックス化は、障害時の影響を指数関数的に拡大させます。そのため2026年型の選択肢では、どこまで中央で統制し、どこから現場に委ねるかを明確に設計できるiPaaSが評価されています。

重要なのは、iPaaSを単体製品として評価しないことです。データメッシュやデータファブリック、MDM、セマンティックレイヤーとどう接続し、AIエージェントにどのような共通言語を与えるのか。その設計思想こそが、連携基盤の選択肢を「コストの比較」から競争優位を左右する戦略判断へと引き上げています。

分散環境で不可欠となるセキュリティとデータガバナンス

分散環境でデータ活用が高度化するほど、セキュリティとデータガバナンスは後回しにできない中核テーマになります。特にAIエージェントが自律的にデータへアクセスし、判断や処理を行う2026年の環境では、**人間向けに設計された従来の統制モデルがそのまま通用しません**。

象徴的なのが、オープンテーブルフォーマットの普及です。Apache IcebergやDelta Lakeのような形式により、複数のクラウドや分析エンジンから同一データを参照できるようになりました。一方で、アクセス制御やマスキング設定が基盤ごとに分断され、**セキュリティポリシー自体がサイロ化するリスク**が顕在化しています。

Gartnerの分析によれば、分散データ基盤における主要なインシデント原因の一つは「技術的欠陥」ではなく、「ポリシー適用の不整合」です。ある基盤では匿名化されている個人データが、別のクエリエンジン経由では平文で取得できてしまう事例は、すでに珍しくありません。

| 観点 | 従来型ガバナンス | 分散環境での新モデル |

|---|---|---|

| アクセス制御 | 基盤・ツールごとに個別設定 | 中央ポリシーエンジンで一元定義 |

| 対象ユーザー | 人間ユーザー中心 | 人間+AIエージェント |

| 統制の単位 | システム単位 | データとコンテキスト単位 |

この課題に対し主流になりつつあるのが、**ポリシー・メタデータ駆動型ガバナンス**です。データがどこに物理的に存在していても、アクセス要求は必ず単一のポリシー判断層を通過し、利用者の属性、目的、実行環境に応じて動的に制御されます。物理的分散と論理的集中を分離する設計思想だと言えます。

重要なのは、このガバナンスがAIエージェントにも適用される点です。AIはAPIキーを持つ単なるプログラムではなく、「どの業務目的で、どのデータを、どこまで扱ってよいか」を定義された主体として扱われます。Forresterが指摘するように、**AIエージェントを信頼できる労働力に変える鍵は、権限と責任の明確化**にあります。

さらに視野を広げると、日本で進むエリアデータ連携基盤の議論は、企業内ガバナンスにも示唆を与えます。デジタル庁やDSAが重視する「データ主権」は、データの所有者が利用条件をコントロールしながら分散連携する考え方です。これは、データメッシュ環境におけるドメインオーナーシップと本質的に重なります。

例えば災害時に限り、本人同意を前提として医療・行政データが連携される設計は、**常時フルアクセスではなく、条件付きアクセスを前提としたガバナンス**の実例です。企業でも同様に、「誰が」ではなく「どの状況で、何の目的で」という条件軸の制御が不可欠になります。

分散環境におけるセキュリティとデータガバナンスは、イノベーションを縛る鎖ではありません。**AIエージェントが暴走せず、かつ最大限の価値を発揮するための安全設計**です。統制を後付けするのではなく、最初からアーキテクチャに組み込めるかどうかが、AI時代の競争力を静かに分けていきます。

コスト削減を超えるROIと価値創出の考え方

データ統合やAI基盤への投資を語る際、今なお「どれだけコストを削減できるのか」という問いが中心に据えられがちです。しかし2026年のAIエージェント時代において、この視点だけでは投資価値の本質を捉えきれません。**重要なのは、コスト削減を起点としたROIではなく、価値創出を起点としたROIへと評価軸を転換すること**です。

ForresterやGartnerの分析によれば、生成AIやデータ基盤投資の効果は、短期的な人件費削減よりも、中長期での意思決定品質の向上や事業スピードの加速に強く現れるとされています。特にAIエージェントが業務プロセスに深く組み込まれる環境では、「判断が早まる」「試行回数が増える」「失敗コストが下がる」といった非財務的効果が、最終的に大きな経済価値へと転化します。

| 従来のROI視点 | AI時代のROI視点 |

|---|---|

| 業務時間削減 | 意思決定リードタイム短縮 |

| 人件費圧縮 | 人材の付加価値最大化 |

| IT運用コスト低減 | 将来技術への即応力向上 |

象徴的な事例が、JDMCデータマネジメント賞で大賞を受賞した関西電力です。同社は全社的なデータマネジメントとAI活用により、2024年度単年で約300億円の価値創出を実現しました。この成果は単なるコスト削減では説明できず、設備保全の高度化、需給調整の最適化、新たな顧客サービス創出といった複合的な価値の積み上げによるものです。

この文脈で注目されているのが、**ROE(Return on Employee)とROF(Return on Future)という新しいROI概念**です。ROEは、AIと統合データ基盤によって従業員体験や生産性がどれだけ向上したかを測ります。データサイロが解消され、必要な情報に即座にアクセスできる環境は、創造的業務への集中を促し、人材価値を高めます。

一方ROFは、現在の投資が将来の競争優位性にどれだけ寄与するかを評価します。Gartnerが指摘するように、生成AIの進化速度は極めて速く、**新しいモデルやエージェント技術をどれだけ迅速に自社データへ適用できるかが勝敗を分けます**。データ統合とガバナンスが整備されていれば、この適応速度そのものがROIとなります。

コスト削減は確かに分かりやすい成果ですが、それは価値創出の副産物にすぎません。AIエージェントが自律的に動く時代において、データ基盤への投資は「経費」ではなく、組織の知能と未来選択肢を増幅させる戦略投資として評価される段階に入っています。

参考文献

- Qiita:2026年の10のデータマネジメント・トレンド(予測)

- Forrester:Predictions 2026: The Race To Trust And Value

- 経済産業省・KDDI Business:「2025年の崖」とは 経済産業省のDXレポートに触れながらわかりやすく解説

- デジタル庁:地方公共団体の基幹業務システムの統一・標準化

- IT Leaders:JDMCが「2025年データマネジメント賞」を発表、大賞の関西電力はDX/データ活用で300億円の価値創出

- Gartner:Gartner Top 10 Strategic Technology Trends for 2026