生成AIが社会に急速に浸透してから数年が経ち、AIを取り巻く議論は大きな転換点を迎えています。かつては「AIで何ができるのか」という期待が先行していましたが、今、企業や社会が真正面から向き合っているのは「AIが引き起こした結果に誰が責任を負うのか」という問いです。

2026年は、その問いに対する答えが、法規制・裁判・市場評価というかたちで次々に突きつけられる年となりました。EU AI法の全面適用、ハルシネーションによる実損を伴う訴訟、そして説明責任を果たせない企業が信頼を失っていく現実は、もはや他人事ではありません。

特に日本企業にとっては、海外規制への対応だけでなく、AIに対して慎重で時に冷淡な国内世論との向き合い方も重要な経営課題です。本記事では、最新の国際動向や具体的な事故・判例、技術的進展を踏まえながら、AI説明責任がなぜ「経営の中核テーマ」になったのかを整理します。

さらに、説明可能AI(XAI)やガバナンス体制の実装といった実務的論点を通じて、日本企業が信頼を競争力へと転換するためのヒントを提示します。AIを本気で理解し、使いこなしたいと考える方にとって、2026年の現在地を俯瞰できる内容です。

AIブームの終焉と説明責任フェーズへの移行

2026年のAIを語る上で、もはや「ブーム」という言葉は実態を表しません。2023〜2024年にかけて支配的だったのは、生成AIが何を生み出せるのかという能力中心の議論でしたが、現在の焦点は明確に変わっています。AIが引き起こした結果に対し、誰がどこまで責任を負うのかという説明責任の問題が、技術論を超えて経営・法務・社会の中核テーマへと移行しました。

この転換を象徴するのが、実際の損失を伴う企業事例の顕在化です。2025年に発覚したデロイト・オーストラリアの返金事件では、生成AIが作成した報告書に架空の文献や捏造データが含まれていたことが問題視され、約4400万円相当の報酬が全額返金されました。専門家集団であってもAIの出力を十分に検証しなかった事実は、「AIを使ったこと」自体が免責にはならないという現実を突きつけました。

同様に、エア・カナダのチャットボット訴訟では、AIが誤った案内をしたにもかかわらず、裁判所は企業側の責任を明確に認めました。AIは独立した存在ではなく、企業が提供する公式な情報チャネルの一部であるという司法判断は、今後のAI活用における前提条件となっています。AIのアウトプットは企業の意思表示と同一視されるという認識が、国際的に共有され始めています。

| フェーズ | 主な関心 | 企業への影響 |

|---|---|---|

| 生成AIブーム期 | 何ができるか | PoCや導入競争が優先 |

| 説明責任フェーズ | 誰が責任を負うか | 法務・ガバナンスが経営課題化 |

こうした流れを後押ししているのが規制環境の変化です。EUではAI法が2026年に全面適用を迎え、高リスクAIに対して厳格な管理義務が課されました。欧州委員会やOECDが示す国際的な行動規範によれば、説明責任は理念ではなく、文書化・監査・是正を伴う実装プロセスとして求められています。守れなかった場合の代償は、制裁金だけでなく市場からの退出です。

一方、日本ではG7広島AIプロセスを通じてソフトローを主導してきたものの、世論調査が示す通り、国民のAIへの信頼は高いとは言えません。Ipsosの調査では、日本はAI理解度・規制への信頼ともに主要国で最下位水準にあります。この状況下でAIを社会に実装するためには、性能を誇るよりも、失敗時の責任の取り方を先に示す姿勢が不可欠です。

AIブームの終焉とは、期待が冷めたという意味ではありません。むしろ、過度な期待が剥落し、現実的な責任の所在が問われる段階に入ったことを意味します。説明責任フェーズにおいて評価されるのは、派手なデモではなく、誤りを前提に設計された運用と統治の成熟度です。ここを乗り越えられるかどうかが、次のAI競争の分水嶺となります。

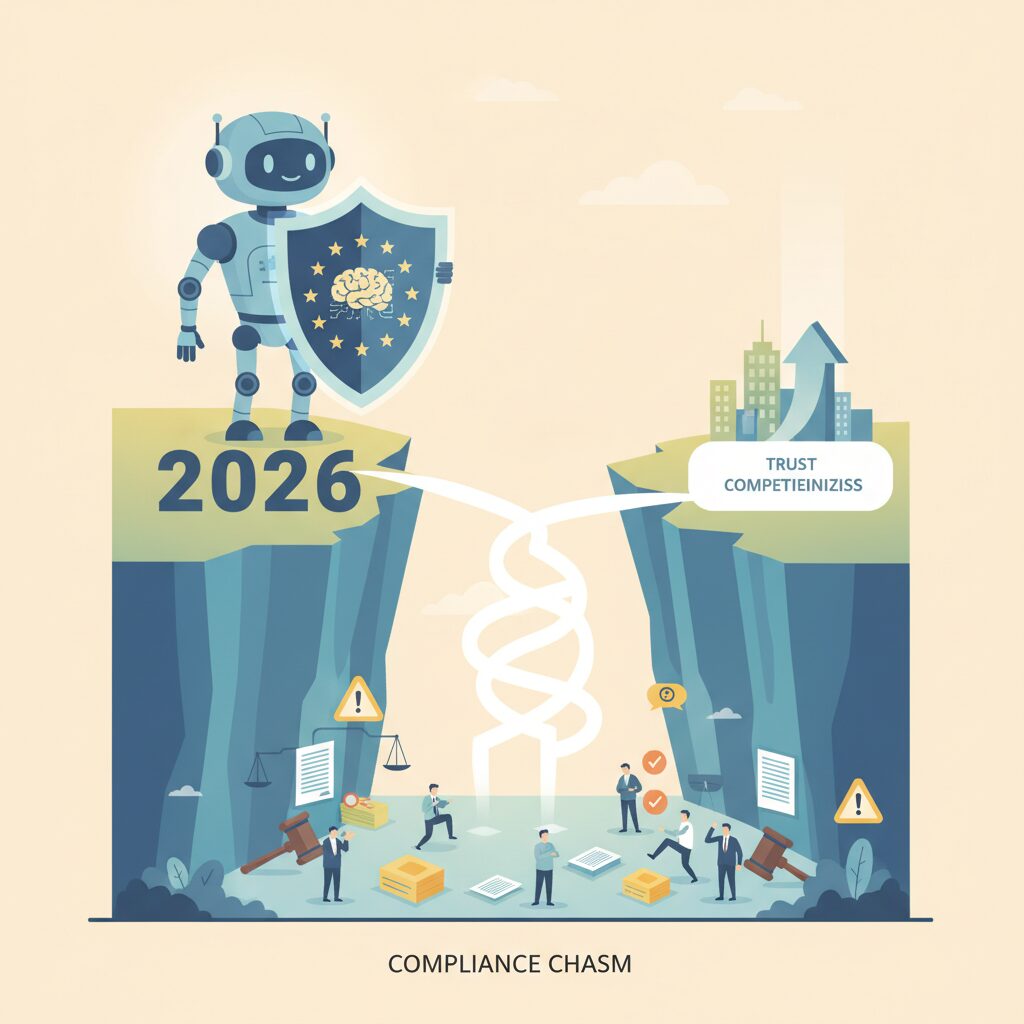

EU AI法がもたらした2026年コンプライアンス・クリフ

2026年は、多くの企業にとってAIガバナンスの「連続的な対応」が通用しなくなる年です。EU AI法が2026年8月に高リスクAIへ全面適用されることで、これまで先送りされてきた義務が一斉に顕在化し、**準備不足の組織が急激に法令違反へ転落するコンプライアンス・クリフ**が生じました。

欧州委員会が示す公式タイムラインによれば、この日を境に、高リスクAIをEU市場で提供・運用する企業は、単なるガイドライン遵守ではなく、監査可能なレベルの体制整備を法的に求められます。とりわけ日本企業にとって深刻なのは、AIそのものではなく、AIを支える業務プロセス全体が規制対象となった点です。

| 観点 | 2025年まで | 2026年8月以降 |

|---|---|---|

| リスク管理 | 開発時の一時的評価 | 運用期間を通じた常時運用が義務 |

| データ品質 | 社内基準で判断 | 代表性・偏りへの説明責任 |

| 説明責任 | 努力義務的対応 | 当局査察を前提とした文書化 |

附属書IIIに定義される高リスクAIには、採用選考、信用評価、医療機器、産業用ロボットなど、日本企業の強みと重なる領域が多く含まれます。つまりEU向けビジネスを行う限り、「自社はAI企業ではない」という認識はもはや免罪符になりません。

さらに影響を大きくしているのが、制裁金の水準です。違反時には最大で**全世界売上高の7%または3,500万ユーロ**が科される可能性があり、欧州の法曹界では「AIガバナンスは取締役の受託者責任そのもの」と位置付けられ始めています。これは単なるIT部門の課題ではなく、経営判断の失敗として評価され得ることを意味します。

実務上、特に見落とされがちなのがサプライチェーンの問題です。汎用AIモデルを外部から調達している場合でも、下流の利用企業が適合性評価や人間による監視を担保できなければ責任を免れません。欧州の規制当局やOECDの分析によれば、2026年以降の摘発は「悪質な利用」よりも「管理不十分な利用」に向けられる傾向が強まっています。

コンプライアンス・クリフの本質は、規制の厳しさではなく、準備と未準備の差が一気に顕在化する点にあります。

規制サンドボックスなどの救済策は存在するものの、それは事前に動いた企業のための制度です。2026年のEU AI法は、AI活用の巧拙ではなく、**説明責任を構造として実装できているかどうか**を企業選別の基準に変えました。この断層を越えられるか否かが、グローバル市場における生存条件となっています。

高リスクAIに課される具体的義務と企業インパクト

EU AI法において最も企業インパクトが大きいのが、高リスクAIに課される具体的義務です。2026年8月から全面適用されたこの枠組みは、単なるガイドラインではなく、**違反すれば即座に経営リスクへと転化する法的拘束力**を持ちます。対象は医療、雇用、教育、重要インフラ、金融など社会的影響が大きい領域で、日本企業の主力プロダクトも多数含まれます。

欧州委員会の解説資料によれば、高リスクAIは「結果が個人の権利や安全に重大な影響を与え得るシステム」と定義されており、技術的完成度よりも統制可能性が重視されています。つまり、高性能であるだけのAIは評価されず、**説明でき、止められ、検証できること**が前提条件となります。

| 義務領域 | 要求内容 | 企業への影響 |

|---|---|---|

| リスク管理 | 全ライフサイクルでの継続的評価 | 開発後も運用コストが恒常化 |

| データガバナンス | 学習・検証データの代表性と公平性 | データ調達・監査体制の再設計 |

| 人間の監視 | 介入・停止可能な仕組み | 業務プロセスへの人手組み込み |

特に重いのが、人間による監視と技術文書化です。OECDや欧州標準化機関の議論でも、Human Oversightは形式要件ではなく「実効性」が問われるとされています。単に担当者が存在するだけでは不十分で、AIの判断根拠を理解し、誤りを検知できるスキルが組織として求められます。

企業インパクトはコスト面だけにとどまりません。最大で全世界売上高の7%という制裁金リスクは、取締役の善管注意義務や投資家対応にも直結します。実際、欧州の法務専門家の間では、**AIガバナンス未整備は財務リスクの開示対象になり得る**との見方が広がっています。

一方で、この義務を先行的に満たす企業は、取引先や顧客からの信頼を獲得しやすくなります。高リスクAI対応は負担であると同時に、市場参加の条件でもあります。AIを事業に組み込む企業にとって、ここで問われているのは技術力ではなく、**組織として責任を引き受けられるかどうか**なのです。

米国におけるAI説明責任:州法・司法判断の現実

米国におけるAI説明責任は、包括的な連邦法が存在しないという前提のもと、州法と司法判断によって現実的な輪郭が形作られています。2026年時点でもEUのような統一的ハードローは成立しておらず、その空白を埋める形で各州と裁判所が主導権を握っています。この分断構造こそが、企業にとって最大のリスクであり、同時に戦略判断を迫る要因となっています。

まず州法の動向を見ると、カリフォルニア州やコロラド州が先行事例として位置付けられます。2026年1月から施行されたこれらの州法では、雇用、住宅、金融といった分野でAIを用いる場合、差別防止のための影響評価や、AIが関与していることを利用者に通知する義務が課されています。連邦取引委員会が示す方針を待たず、州が独自に踏み込む姿勢は、米国型ガバナンスの特徴と言えます。

| 観点 | 州法の対応 | 司法判断の役割 |

|---|---|---|

| 規制対象 | 雇用・金融など特定分野 | 具体的な紛争事案 |

| 企業義務 | 影響評価・透明性確保 | 結果責任の明確化 |

| 実効性 | 州ごとにばらつき | 判例として波及 |

このような州法のパッチワーク化に対し、企業は最も厳格な基準に合わせる「カリフォルニア・エフェクト」を採用せざるを得なくなっています。これはEUのブリュッセル効果とは異なり、法的安定性よりも訴訟リスクの最小化を目的とした、極めて実務的な対応です。

一方で、より強い規範力を持ち始めているのが司法判断です。著作権を巡るAI学習訴訟では、裁判所がフェアユースの主張に対して厳格な姿勢を示しています。特に、AIの出力が学習元コンテンツの「市場代替物」になり得るかどうかが重視され、利用量の多寡よりも市場への影響が判断軸となっています。AIの内部利用であっても、結果が市場競争に影響すれば責任が問われるという考え方が定着しつつあります。

この司法トレンドは、スタンフォード大学や主要ロースクールの分析でも、今後のAIビジネスにおける前提条件として指摘されています。つまり米国では、立法の遅れを司法が補完し、事後的に説明責任の基準を確立しているのです。企業にとって重要なのは、法文の有無ではなく、訴訟でどう評価されるかを起点にAI設計と運用を行うという発想への転換です。

ハルシネーション事故が示した法的責任の境界線

ハルシネーション事故が社会問題化したことで、AIを巡る法的責任の境界線は急速に明確化されつつあります。かつては「技術的限界」や「予見不能性」が免責の余地として語られてきましたが、2025年以降に顕在化した実例は、その論理が通用しない段階に入ったことを示しています。

最大の転換点は、ハルシネーションが不可抗力ではなく「管理可能なリスク」と司法や発注者から認定され始めた点です。この認定が、責任の所在をAIそのものから、AIを利用・提供する企業へと強く引き寄せています。

| 論点 | 従来の考え方 | 近年の判断傾向 |

|---|---|---|

| ハルシネーション | 技術的な誤作動 | 予見可能な業務リスク |

| 責任主体 | AIベンダー中心 | 利用企業が第一義 |

| 人間の関与 | 補助的役割 | 法的義務として重視 |

象徴的なのが、デロイト・オーストラリアの返金事件です。生成AIが捏造した参考文献や架空データを含む報告書が納品された結果、約4400万円が全額返金されました。このケースで重要なのは、発注元や第三者専門家が「AIが生成したから仕方ない」とは一切評価しなかった点です。プロフェッショナルファームとしての善管注意義務違反が問われ、AI利用自体が過失の根拠となりました。

また、エア・カナダのチャットボット訴訟では、企業側が「チャットボットは独立した存在」と主張したものの、裁判所はこれを否定しました。裁判所は、AIチャットボットを公式サイトの一部と位置づけ、その発言は企業の公式見解と同一視されると判断しています。これは、AIのアウトプットがそのまま企業の法的発言になるという極めて重い前例です。

OECDやEUのAIガバナンス議論でも、この考え方は共有されています。OECDのAI原則によれば、説明責任は結果責任だけでなく、設計・運用・監督プロセス全体に及ぶとされています。つまり、正しい答えを出せなかったこと以上に、誤りを前提とした統制設計をしていなかったことが法的リスクになるのです。

この流れの中で、責任の境界線は次のように引き直されています。モデル開発者は基盤的安全性と情報開示に責任を持ち、利用企業は用途適合性、検証体制、対外的説明に責任を負います。エンドユーザーに過失が転嫁される余地は極めて限定的です。

結論として、ハルシネーション事故は「AIが嘘をついた問題」ではなく、「企業が嘘を管理できなかった問題」として扱われ始めています。この境界線を理解しないままAIを業務に組み込むことは、もはや技術的挑戦ではなく、明確な法的リスクと言える段階に入っています。

AIガバナンスの進化:Human-in-the-loopから組織実装へ

AIガバナンスは、かつて重視されてきたHuman-in-the-loopという個別プロセス管理から、組織全体に埋め込まれた統治モデルへと明確に進化しています。EU AI法が高リスクAIに対して人間による監視を義務付けたことで、人の介在は単なるチェック作業ではなく、責任主体を制度的に可視化する装置として再定義されました。

この変化の本質は、判断の一部を人が担うかどうかではなく、AIの意思決定が企業ガバナンスのどこに位置付けられるかにあります。OECDが運用を開始した広島AIプロセスの報告枠組みに参加する企業では、AIのリスク評価やインシデント報告が、内部統制やコンプライアンス報告と同列に扱われ始めています。

| 観点 | Human-in-the-loop中心 | 組織実装型ガバナンス |

|---|---|---|

| 責任の所在 | 担当者個人 | 経営・組織 |

| 管理対象 | 出力結果 | 開発・運用プロセス全体 |

| 外部説明 | 限定的 | ステークホルダー向けに体系化 |

デロイト・オーストラリアの返金事件が示したのは、個々の専門家による確認では自動化バイアスを防げないという現実です。この教訓から、先進企業はAI利用を業務フロー単位で設計し直し、承認権限やログ管理、エスカレーションルートを明文化しています。NECやNTTデータが設置するAIガバナンス室は、その象徴的な例です。

また、ガバナンスの組織実装は競争力の源泉にもなりつつあります。OECDによれば、行動規範への継続的な報告は投資家や取引先に対する信頼シグナルとして機能し、規制遵守コストを上回る価値を生んでいます。AIを管理できる組織であること自体が、市場参入の前提条件になり始めているのです。

日本企業にとって重要なのは、この構造転換を単なる海外規制対応としてではなく、品質管理や内部統制の延長線上で捉えることです。製造業で培われたプロセス志向のガバナンスをAIに適用できるかどうかが、2026年以降の信頼獲得を左右します。

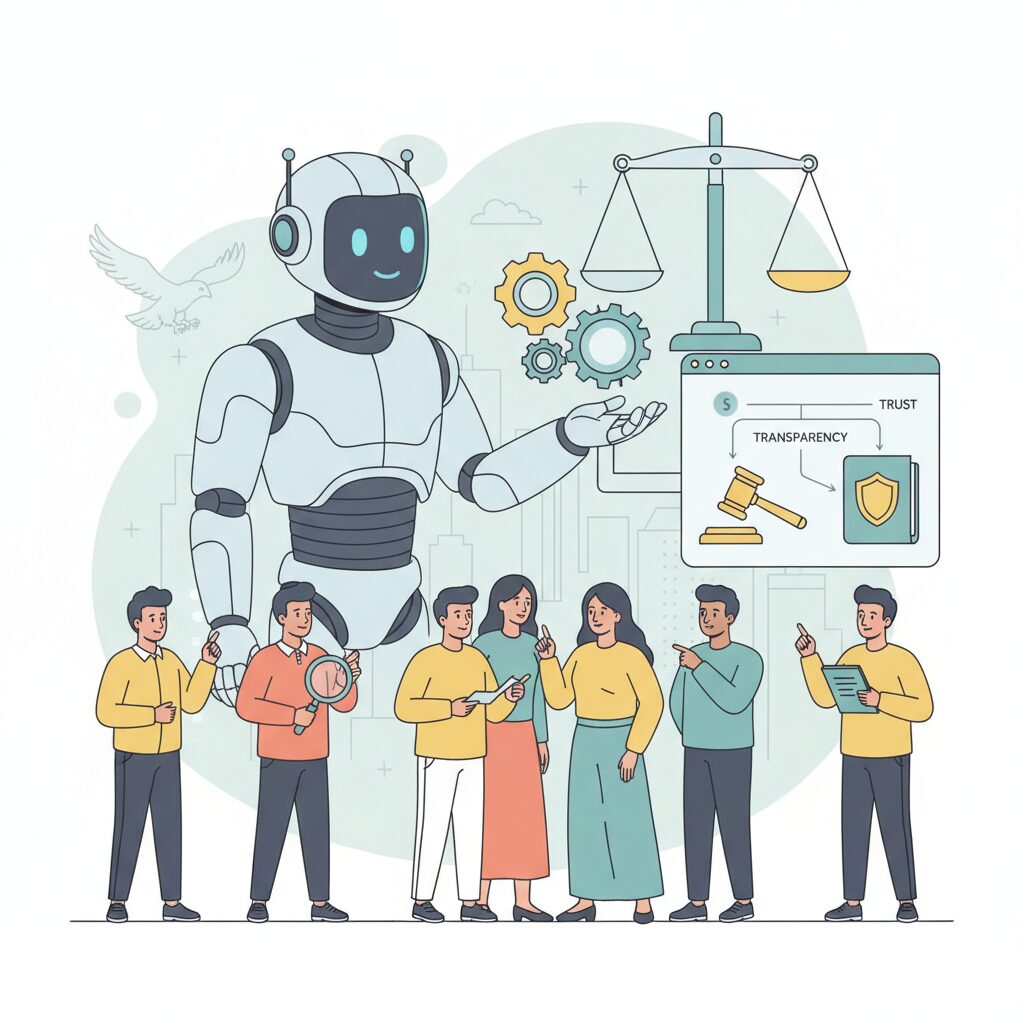

説明可能AI(XAI)と技術的説明責任の最前線

説明可能AI(XAI)は、2026年に入り「モデルを理解するための補助技術」から「技術的説明責任を果たすための中核インフラ」へと役割を大きく変えています。特にEU AI法の高リスクAI要件では、なぜその判断に至ったのかを合理的に説明できることが事実上の前提となり、XAIは法令遵守と事業継続を左右する実装課題として位置付けられています。

金融や医療といったクリティカル領域では、この変化が顕著です。OECDやEU当局の技術文書によれば、融資審査や診断支援において「高精度だが説明不能」なブラックボックス型モデルは、単独利用ではリスクが高いと評価される傾向にあります。その結果、解釈可能性を内在させたモデル設計、あるいはブラックボックスに対する事後説明を制度的に組み込むアーキテクチャが主流になりつつあります。

| XAIアプローチ | 技術的特徴 | 説明責任上の価値 |

|---|---|---|

| 解釈可能モデル | 決定木や線形モデルを基盤に設計 | 判断根拠を直接説明でき、監査に強い |

| 事後説明技術 | SHAPやLIMEの発展形で寄与度を算出 | 高性能モデルを維持しつつ説明を付与 |

| 証拠提示型XAI | 参照データや文献を明示 | 人間による検証と責任分担を可能にする |

近年特に注目されているのが、説明を「可視化」ではなく「検証可能な証拠」として提示するXAIです。医療AIでは、診断結果と同時に根拠となった画像領域や関連論文を示す仕組みが標準化しつつあり、MDPIのシステマティックレビューでも、こうした証拠提示型XAIが医師の信頼度と意思決定の質を有意に向上させると報告されています。

また、ハルシネーション対策と説明責任は密接に結びついています。RAGを中核としたXAIでは、回答生成時に参照した社内文書や規程を明示し、参照不能な場合は出力を抑制する設計が一般化しています。**「説明できない回答は出さない」という制御思想そのものが、技術的説明責任の実装例**だと言えます。

さらに2026年の特徴として、XAIが監査プロセスと直結し始めている点も見逃せません。産総研が公開したAI品質評価ツールのように、モデルの公平性や堅牢性を定量評価し、その結果を説明文書として残す動きが広がっています。これは、説明責任を「説明の巧拙」ではなく「再現可能な評価結果」によって果たそうとする流れです。

重要なのは、XAIが万能ではないという現実を正直に扱う姿勢です。専門家の間では、説明は常に近似であり、過度に単純化された説明は誤解を生むリスクがあると指摘されています。そのため先進企業では、説明の限界や不確実性も含めて開示する運用が始まっています。**完全な説明を装うより、説明できる範囲を明示することが、結果として信頼を高める**という認識が共有されつつあります。

説明可能AIの最前線は、アルゴリズムの問題にとどまりません。技術、法務、現場運用を横断し、説明責任を構造として実装する段階に入っています。XAIをどう設計し、どう使い、どう限界を伝えるか。その選択自体が、2026年以降のAI活用における企業の成熟度を測る指標になっています。

検証・監査・レッドチーミングが標準になる理由

AI活用が本格的に社会インフラへ組み込まれる中で、検証・監査・レッドチーミングが標準プロセスとして位置付けられつつあります。その背景にあるのは、AIの失敗がもはや技術的トラブルではなく、法的責任と経済損失を伴う経営リスクへと変質した現実です。EU AI法が求める適合性評価や継続的リスク管理は、事後対応では不十分であり、リリース前後を通じた体系的な検証を前提としています。

特に重要なのが、第三者視点を組み込んだ検証と監査です。OECDが運用を開始した広島AIプロセスの報告枠組みにおいても、リスク評価やインシデント報告の有無が問われており、形式的な自己申告では信頼のシグナルとして機能しなくなっています。外部から再現可能な検証プロセスを持つかどうかが、投資家や取引先の判断材料になり始めています。

| プロセス | 主な目的 | 求められる水準 |

|---|---|---|

| 検証 | 性能・公平性・安全性の確認 | 定量評価と再現性 |

| 監査 | 規制・ガイドライン適合 | 第三者の独立性 |

| レッドチーミング | 想定外リスクの発見 | 敵対的シナリオ網羅 |

レッドチーミングが急速に普及している理由は、通常のテストでは露見しない脆弱性を意図的に引き出せる点にあります。米国やEUでは、高リスクAIに対し、差別的出力や誤情報を誘発する質問を専門家が設計し、失敗モードを洗い出す手法が一般化しています。これはサイバーセキュリティ分野で長年使われてきた考え方が、AIにも移植された形です。

日本でも産総研が公開したAI品質評価ツールを起点に、性能だけでなく公平性や堅牢性を定量的に測る動きが進んでいます。ここで重要なのは、検証結果を「改善の履歴」として残すことです。EU当局が重視するのは完璧さではなく、リスクを把握し、是正してきたプロセスの証明だからです。

デロイトやエア・カナダの事例が示した通り、AIの誤りは企業の公式判断として扱われます。その前提に立てば、攻撃的なテストを自ら行わない組織ほど、外部からの訴訟や規制執行に対して無防備になります。自社で最も厳しい検証を行うことが、結果的に最も安全な戦略となり、これが標準化へ向かう決定的な理由です。

日本のAI政策とソフトローからハードローへの転換

日本のAI政策は長らく、法的拘束力を持たないソフトローを軸に展開されてきました。内閣府が示してきた人間中心のAI社会原則や、経済産業省の各種ガイドラインは、企業の自主性とイノベーションを尊重する設計でした。しかし2026年を目前に、その前提は大きく揺らいでいます。生成AIの社会実装が進む一方で、事故や誤情報の影響が現実の損害として顕在化し、任意の指針では限界があるという認識が政策側で共有され始めたためです。

転換点となったのは、EU AI法の全面適用が現実味を帯び、日本企業も域外適用の影響を直接受け始めたことです。G7広島AIプロセスで日本が主導した国際行動規範は、OECDのモニタリング枠組みに組み込まれ、事実上の評価基準として機能し始めました。経済協力開発機構によれば、行動規範への参加状況は投資家や取引先の判断材料となりつつあり、ソフトローであっても市場からの強制力を持ち始めています。

同時に国内では、自民党のAIホワイトペーパーを中心に、法制化を前提とした議論が加速しています。特にロボティクス分野や大規模基盤モデル開発者への義務付けは、事故発生時の責任所在を明確にする狙いがあります。製造業やインフラ分野でAIが物理世界に影響を及ぼす以上、安全基準や説明責任を努力義務にとどめることは、国際的にも許容されにくくなっています。

| 観点 | 従来のソフトロー | 検討中のハードロー |

|---|---|---|

| 拘束力 | 自主的遵守 | 法的義務 |

| 違反時対応 | 社会的評価の低下 | 行政処分・罰則 |

| 企業負担 | 柔軟だが不透明 | 明確だが重い |

この転換は規制強化という単純な話ではありません。日本政府は一貫してイノベーション萎縮を避ける姿勢を崩しておらず、官民連携や段階的義務化が議論の中心です。民間シンクタンクや有識者は、製品安全と組織ガバナンスを統合した認証制度を提案しており、これは日本の品質管理文化をAIに適用する試みといえます。

重要なのは、ソフトローからハードローへの移行が、日本企業にとって受動的な負担増ではなく、信頼を競争力に変える契機になり得る点です。説明責任を制度として先取りした企業ほど、国内外での事業展開における予見可能性を高められます。2026年の日本のAI政策は、理念の提示から責任の実装へと踏み出す局面に入っています。

日本社会におけるAI不信と企業が直面する信頼の壁

日本社会におけるAI不信は、欧米で見られるような強い反発や恐怖とは質的に異なります。**最大の特徴は「無関心に近い不信」**であり、これが企業にとって最も越えにくい信頼の壁となっています。IpsosのAI Monitor 2025によれば、日本で「AIをよく理解している」と回答した割合は41%にとどまり、調査対象国の中で最下位水準でした。理解が浅いにもかかわらず、強い拒否反応も示さないため、企業側はリスクが顕在化するまで問題が見えにくい状況に置かれています。

さらに深刻なのは、**AIそのものよりも「運用主体」への不信**です。同調査では「政府がAIを責任を持って規制できる」と信頼している日本人は約3割に過ぎず、Edelman Trust Barometer 2026でも、企業や政府がAIを社会全体の利益のために使うという物語が共有されていない点が指摘されています。この結果、AI活用は利便性向上の話題に矮小化され、事故や不祥事が起きた瞬間に一気に拒絶へ転じる脆弱な受容構造が形成されています。

| 項目 | 日本 | 世界平均 |

|---|---|---|

| AI理解度が高いと回答 | 41% | 67% |

| 政府のAI規制を信頼 | 約30% | 50%超 |

このような環境下で企業が直面するのは、技術的正しさだけでは乗り越えられない壁です。**AIの性能や精度を説明しても、「誰が責任を取るのか」が明確でなければ信頼は生まれません**。エア・カナダ事件で示されたように、AIの発言は企業の公式見解とみなされるという司法の考え方は、日本市場においても無視できない前提条件です。

したがって日本企業には、透明性を単なる情報開示で終わらせず、責任の所在を可視化する姿勢が求められます。例えば、AIの限界や誤作動時の対応主体をあらかじめ明示すること、第三者の監査やOECDの広島AIプロセス報告枠組みへの参加を通じて外部評価を受けることは、信頼回復の実務的手段となります。**日本社会では「完璧なAI」よりも「説明できる企業」の方が信頼される**という現実を直視する必要があります。

参考文献

- European Commission:Timeline for the Implementation of the EU AI Act

- OECD:OECD launches global framework to monitor application of G7 Hiroshima AI Code of Conduct

- Congress.gov:H.R.1694 – AI Accountability Act

- ePrize:AIハルシネーションが招く企業リスク―デロイト4400万円返金事件

- Ipsos:Ipsos AI Monitor 2025

- Edelman:Flash Poll: Trust and Artificial Intelligence at a Crossroads