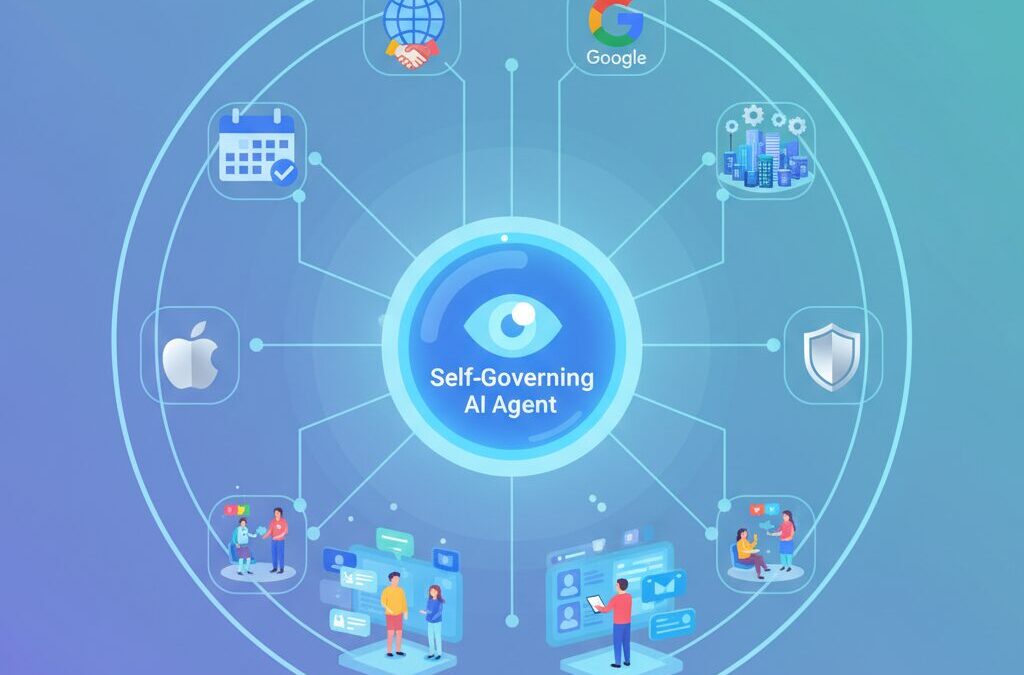

「AIアシスタントは質問に答えるだけの存在」――そんな認識は、すでに過去のものになりつつあります。2026年現在、バーチャルアシスタントは人間の指示を待つツールではなく、自ら考え、計画し、行動する“自律型AIエージェント”へと進化しています。

カレンダー調整や資料作成といった単純作業だけでなく、複数のアプリやシステムを横断し、目的達成までを一気通貫で実行するAIが、すでに私たちの生活や仕事に入り込み始めています。AppleとGoogleの歴史的提携や、日本企業で急速に進むAIエージェント導入は、その象徴的な動きです。

本記事では、AIに関心のある方に向けて、バーチャルアシスタントの定義がどのように変わったのか、自律型AIエージェントは何ができるのか、そして私たちはこの変化とどう向き合うべきかを整理します。技術トレンドだけでなく、日本市場ならではの事情や安全性の課題にも触れることで、2026年以降のAI活用を具体的にイメージできる内容をお届けします。

バーチャルアシスタントの定義はどう変わったのか

かつてバーチャルアシスタントといえば、音声で天気を聞いたり、アラームを設定したりする補助的なツールを指していました。しかし2026年現在、その定義は大きく書き換えられています。今のバーチャルアシスタントは、人間の指示を待つ存在ではなく、目標達成のために自ら考え、行動するAIエージェントとして位置づけられています。

この変化を象徴するのが「受動的対話」から「能動的実行」への転換です。2024年までの生成AIは、質問に答えたり文章を生成したりすることが中心でした。一方で現在のアシスタントは、ユーザーの意図を文脈から推測し、複数のアプリやシステムを横断してタスクを完結させます。ガートナーによれば、2028年までに業務上の意思決定の15%以上がAIエージェントによって自律的に行われると予測されており、定義の変化が実務レベルで進行していることが分かります。

この定義変容の中核にある概念が自律性(Autonomy)です。現在は自動運転の考え方にならい、アシスタントの自律度が段階的に整理されるようになりました。単なるルール実行から、計画・実行・結果学習までを自己完結させる存在へと進化しています。

| 自律性レベル | 特徴 | 定義上の位置づけ |

|---|---|---|

| 低 | 固定ルールに従う自動化 | 従来型アシスタント |

| 中 | 文脈に応じて手順を選択 | 高度化した業務支援AI |

| 高 | 目標設定から改善まで自律 | AIエージェント |

さらに2026年を特徴づけるのが「見えないAI」という考え方です。ユーザーが明示的に話しかけなくても、アシスタントはバックグラウンドで状況を解析し、必要な支援を先回りして提供します。専門家の間では、バーチャルアシスタントはもはやプロダクトではなく、生活や業務を支えるインフラになりつつあると指摘されています。

このように定義が変わった結果、私たちはアシスタントを「便利な秘書」としてではなく、「判断と実行を委ねるパートナー」として捉える必要が出てきました。バーチャルアシスタントとは何かという問いそのものが、人間とAIの役割分担をどう設計するかという、より本質的な議論へと進化しているのです。

自律型AIエージェントとは何か

自律型AIエージェントとは、**人間が逐一指示を出さなくても、与えられた目標を理解し、計画を立て、実行し、結果を評価して次の行動に反映できるAI**を指します。従来のチャットボットやバーチャルアシスタントが「聞かれたことに答える存在」だったのに対し、自律型AIエージェントは「目的達成の主体」として振る舞う点が本質的な違いです。

ガートナーによれば、2026年以降のAI活用の中心は対話型からエージェント型へと移行しており、2028年までに業務上の意思決定の少なくとも15%がAIエージェントによって自律的に行われると予測されています。これは、AIが単なる支援ツールではなく、業務プロセスの一部を担う存在として認識され始めたことを意味します。

自律性を理解するうえで重要なのが、AIエージェントの「自律性レベル」という考え方です。業界では自動運転になぞらえた段階整理が一般化しており、2026年時点では以下のように分類されています。

| レベル | 特徴 | 主な役割 |

|---|---|---|

| 低 | 決められた手順を順番に実行 | 定型業務の自動化 |

| 中 | 状況に応じて手順を組み替える | 部門単位の業務支援 |

| 高 | 計画・実行・修正を自己完結 | 顧客対応や営業判断 |

| 最高 | 目標設定から学習まで自律 | 金融取引や研究開発 |

特に注目されているのが、**計画・実行・適応のループを人間の介在なしで回せる点**です。例えば営業分野では、AIエージェントが顧客データを分析し、最適なアプローチを選択し、結果を学習して次の提案精度を高めています。これは単なる自動化ではなく、意思決定そのものへの関与です。

さらに2026年は「見えないAI」が一般化した年でもあります。ユーザーが明示的に操作しなくても、AIエージェントが文脈や状況を把握し、裏側でタスクを進めます。専門家の間では、AIが水道や電気のような不可視のインフラへ近づいていると指摘されています。

このように自律型AIエージェントとは、便利な機能の集合体ではなく、**目標達成の責任を部分的に引き受ける存在**です。その理解は、AIをどう使うかだけでなく、どこまで任せ、どこを人間が監督すべきかを考える出発点になります。

AIエージェントの自律性レベルとユースケース

AIエージェントを理解するうえで欠かせない軸が「自律性レベル」です。2026年現在、業界では自動運転の考え方にならい、AIエージェントの自律性を段階的に整理する枠組みが広く共有されています。これは技術的な成熟度だけでなく、どの業務を安心して任せられるかを判断する実践的な指標として機能しています。

重要なのは、自律性が高いほど必ずしも優れているわけではなく、目的に合ったレベルを選ぶことです。ガートナーによれば、AIエージェント導入の失敗要因の多くは、業務要件と自律性レベルの不一致にあるとされています。過剰な自律化は、統制不能やリスク増大を招くためです。

現在一般的に用いられている4段階の自律性レベルと、代表的なユースケースは以下の通りです。

| 自律性レベル | 判断の主体 | 主な特徴 | 代表的ユースケース |

|---|---|---|---|

| レベル1 | 人間 | 固定ルールに従い連鎖的に実行 | RPA、定型FAQ対応 |

| レベル2 | AI補助 | 限定範囲で手順を動的生成 | 社内検索、部門特化支援 |

| レベル3 | AI主体+人間監督 | 計画・実行・調整を自己完結 | AI営業、CS自動解決 |

| レベル4 | AI | 目標設定から学習まで完全自律 | 金融取引、創薬、物流最適化 |

実務で最も急速に普及しているのはレベル2からレベル3です。特に半自律型エージェントは、KPIやガイドラインといった制約条件を人間が設定し、その枠内でAIが最適行動を選択するため、効率性と安全性のバランスが取りやすいと評価されています。実際、ガートナーは2028年までに業務上の意思決定の15%以上がこの層のAIエージェントによって担われると予測しています。

一方、レベル4の完全自律型は、金融市場や創薬研究など「結果が数値で明確に評価できる領域」に限定して導入が進んでいます。文部科学省のAI for Scienceレポートでも、創薬分野では仮説生成からシミュレーション、次の実験条件の選定までをAIが自律的に回すことで、研究サイクルが大幅に短縮された事例が報告されています。

このように自律性レベルは、技術の進化段階ではなく、リスク許容度と業務特性を映し出す鏡です。AIエージェントを活用する際は、「どこまで任せ、どこから人が介在するのか」を設計すること自体が、競争力の源泉になりつつあります。

AppleとGoogleの提携が示す市場の転換点

AppleとGoogleの提携は、単なる技術協業ではなく、AI市場全体の力学が変わったことを象徴する出来事です。長年、Appleは自社開発モデルとクローズドなエコシステムを競争優位の源泉としてきましたが、2026年に次世代Siriの中核としてGoogleのGeminiを採用した判断は、その前提が転換点を迎えたことを意味しています。

この決断の背景には、**AIの競争軸が「UIや端末」から「推論能力とスケール」へ完全に移行した現実**があります。Apple自身もオンデバイスAIを進化させてきましたが、多段階推論や広範な世界知識を必要とするタスクでは、Googleが長年積み上げてきた検索・データ基盤とLLM運用の経験が決定的な差となりました。業界関係者の分析によれば、これはAppleが品質基準を守るために選んだ、極めて現実的な選択だとされています。

重要なのは、この提携が勝者と敗者を単純に分ける話ではない点です。**Appleは体験設計とプライバシー管理に集中し、Googleは知能インフラを供給する**という役割分担が明確化しました。これは、スマートフォン黎明期における「ハードとOS」「OSとアプリストア」の分業構造が、AI時代に再構築されているとも解釈できます。

| 観点 | 従来の構図 | 提携後に見える新構図 |

|---|---|---|

| 競争の主戦場 | デバイスとOS | 推論能力とAI基盤 |

| Appleの強み | 自社完結型エコシステム | UX設計とプライバシー統制 |

| Googleの強み | 検索と広告データ | 世界規模の知能インフラ |

この構造変化は、開発者や企業ユーザーにも直接的な影響を与えます。SiriがGeminiによって高度化することで、iOSやmacOS上の操作は「指示する」ものから「任せる」ものへと変わります。結果として、アプリ単体の差別化よりも、AIエージェントにどれだけ自然に組み込まれるかが、プロダクトの成否を左右する時代に入ったと言えるでしょう。

また、複数の海外メディアが指摘するように、この提携はAIモデルを巡る序列を固定化するシグナルでもあります。**莫大な計算資源とデータを持つ企業が基盤モデルを担い、それ以外の企業はその上で価値を再定義する**。AppleとGoogleの歴史的合意は、AI市場が理想論から現実の産業構造へ移行した瞬間を、私たちに強く印象づけています。

主要プラットフォーム各社のAIアシスタント戦略

2026年現在、主要プラットフォーム各社はAIアシスタントを単なる機能競争ではなく、自社エコシステム全体の価値を最大化するための戦略的中核として位置づけています。共通しているのは「対話」よりも「実行」に軸足を移し、ユーザーの行動や意思決定に深く介入する方向へ進化している点です。

その象徴がAppleのSiri刷新です。Appleはプライバシーを重視するオンデバイスAI路線を維持しつつ、推論性能が要求される領域ではGoogleのGeminiを採用しました。複数アプリを横断した予約や調整を一文で完結させる設計は、Siriを「操作窓口」から自律的な実務担当者へと変貌させています。Appleの公式技術資料によれば、Private Cloud Computeによりクラウド処理時でもデータが即時破棄される点が、他社との差別化要因です。

Googleの戦略は一貫して「知能インフラ化」です。GeminiとAgentspaceは、検索、マップ、YouTube、Workspaceを横断して文脈を理解し、ユーザーが次に必要とする情報や行動を先回りして提示します。これはスタンフォード大学などが指摘する“Invisible AI”の典型例で、ユーザーはAIを意識せずに意思決定の質だけを高められる構造です。

| 企業 | 戦略の軸 | アシスタントの役割 |

|---|---|---|

| Apple | プライバシー重視の統合 | デバイス操作の完全自動化 |

| 情報インフラの横断 | 文脈理解による先回り支援 | |

| Microsoft | 業務生産性の最大化 | 仕事を進める代理人 |

| OpenAI | 汎用知能の追求 | 高度思考と創造の伴走者 |

Microsoftは明確にビジネス領域へフォーカスしています。Microsoft 365 Copilotは、WordやExcelを個別に支援する存在ではなく、複数エージェントが役割分担しながら業務全体を進行させる司令塔として設計されています。IDCの分析でも、会議準備や資料作成の自動化により、管理職の意思決定時間が大幅に短縮されたと報告されています。

一方のOpenAIは、特定のOSや業務に縛られず、推論力と対話品質を極限まで高める戦略を取り続けています。ChatGPTは検索やコーディング、研究支援まで横断的に活用され、AGIへの距離を縮める実験場として機能しています。MITの研究者が指摘するように、この“汎用性”こそがOpenAIの最大の競争優位です。

各社の違いは、AIアシスタントを「誰のために、どこまで任せるか」という哲学の差に集約されます。2026年の競争は機能数ではなく、ユーザーがどれだけ自然に意思決定と実行を委ねられるかという信頼設計の戦いへと移行しています。

日本市場で進むAIエージェント導入の実態

日本市場におけるAIエージェント導入は、2026年を境に「実験段階」から「実務インフラ」へと明確に移行しました。矢野経済研究所の調査によれば、国内民間企業の生成AI導入率は2025年時点で43.4%に達しており、わずか2年前の1割未満という水準から急拡大しています。この数字は単なる関心の高まりではなく、実際の業務にAIが組み込まれ始めたことを示しています。

特に日本で特徴的なのは、チャット型ツールの利用を超え、業務プロセスそのものを代替・補完するAIエージェントへの関心が急速に高まっている点です。背景には深刻な労働力不足があります。総務省や経済産業省の各種報告でも指摘されている通り、少子高齢化による人手不足は今後も構造的に解消されにくく、単純な効率化では追いつかない状況にあります。そのため「人が判断して指示するAI」ではなく、「判断と実行を任せられるAI」への期待が一気に現実的なものになりました。

一方で、導入の中身を見ると企業間の格差は非常に大きいです。野村総合研究所の分析によれば、生成AIを導入した企業のうち約7割がリテラシーや運用スキル不足を課題として挙げています。実際には、資料作成や要約といった単機能活用にとどまり、AIエージェント本来の価値である自律的な業務遂行まで到達できていない企業が少なくありません。

| 項目 | 日本企業の現状(2026年) | 示唆される課題 |

|---|---|---|

| 導入率 | 43.4%まで急拡大 | 量的普及に対し質的成熟が未達 |

| 主な用途 | 翻訳・要約から業務自動化へ移行中 | 業務設計の再構築が追いついていない |

| 懸念点 | 誤情報・機密漏洩への不安が7割超 | ガバナンス設計と技術理解が必須 |

こうした状況の中で、日本企業特有の動きとして注目されているのが、国産AIモデルやオンプレミス環境を前提としたAIエージェント導入です。矢野経済研究所のレポートでも、セキュリティとプライバシーを重視する企業ほど、海外クラウド一択ではなく、国内事業者やハイブリッド構成を選択する傾向が強いとされています。これは、日本の厳格な個人情報保護意識や業界ごとの規制が、AIエージェントの設計思想そのものに影響を与えている好例です。

結果として、日本市場では「最新で最強のAIを使う」ことよりも、業務・文化・法規制に適合したAIエージェントをいかに安全に運用するかが導入成否を分けています。専門家の間でも、日本は派手なフル自律型より、半自律型エージェントを着実に業務へ埋め込むことで、現実的な成果を積み上げる市場になるという見方が主流です。2026年の日本は、AIエージェントの可能性が幻想から実務へと定着し始めた、まさに転換点に立っていると言えるでしょう。

国産AIとソブリンAIが注目される理由

2026年に入り、国産AIとソブリンAIが強く注目されている背景には、技術進化そのものよりも「誰がAIを支配し、誰の価値観で運用されるのか」という構造的な問題があります。生成AIや自律型エージェントが意思決定に深く関与する時代において、AIは単なるITツールではなく、国家や企業の競争力を左右する戦略インフラへと変質しました。

とりわけ日本では、機密情報や個人データを海外クラウドに依存することへの懸念が顕在化しています。矢野経済研究所の調査でも、企業が生成AI導入に際して最も警戒している点として「誤った情報の採用」と並び「機密情報の流出」が7割超を占めました。**この不安が、国内法規・商慣習に適合した国産AIへの需要を一気に押し上げています。**

ソブリンAIとは、データ、モデル、運用基盤を特定国の主権下で完結させる考え方です。東京大学の松尾豊教授も、他国のAI基盤に過度に依存することは、将来的に経済安全保障上のリスクになり得ると指摘しています。AIが行政、金融、医療、インフラ制御にまで入り込む現在、その判断ロジックや学習データの所在がブラックボックスであることは許容されにくくなっています。

この文脈で国産AIが評価される最大の理由は、日本語性能だけではありません。**モデルの透明性、オンプレミス運用のしやすさ、国内法規制への準拠性**が、実務レベルでの信頼性につながっています。たとえばNTTのtsuzumiは、1枚のGPUで稼働可能な軽量設計により、外部接続を最小限に抑えた運用が可能とされています。

| 観点 | 海外メガモデル中心 | 国産AI・ソブリンAI |

|---|---|---|

| データ主権 | 国外クラウド依存が多い | 国内完結が可能 |

| 法規制対応 | 各国仕様で調整が必要 | 日本法・業界慣行に最適化 |

| 透明性 | 学習過程が不明瞭 | スクラッチ開発で説明可能 |

さらに見逃せないのが、AIエージェント時代との相性です。自律的に行動するAIほど、内部ルールや判断基準を人間が監査できることが重要になります。SB IntuitionsのSarashinaやソフトバンクのAGENTIC STARは、外部連携や意思決定フローを制御しやすい設計が評価され、大企業の基幹業務での採用が進んでいます。

国産AIとソブリンAIが注目される理由は、愛国的な選択ではありません。**信頼性、説明責任、そして長期的な事業継続性を確保するための、極めて現実的な経営判断**として位置づけられています。AIが社会の深部に入り込むほど、「どのAIを使うか」は「どの価値観を選ぶか」と同義になりつつあるのです。

AIエージェントを支える技術進化の核心

2026年のAIエージェントを根底から支えているのは、単なるモデル性能の向上ではなく、システム全体の設計思想が変わった点にあります。核心となるのが、エージェント型ワークフローへの移行と、完全マルチモーダル化です。これによりAIは、指示待ちの存在から、自ら考え、行動し、修正する実行主体へと進化しました。

まずエージェント型ワークフローは、従来の「入力して出力を得る」線形処理を過去のものにしました。現在は、複数のAIエージェントが役割分担し、互いの結果を検証しながら循環的にタスクを進めます。ガートナーによれば、この構造は人間のチームワークに近く、特に複雑で曖昧さの多い業務において生産性を飛躍的に高めると評価されています。

計画・実行・検証・修正を自己完結できる点こそが、2026年型AIエージェントの最大の技術的ブレークスルーです。例えば多言語カスタマーサポートでは、感情検知、知識検索、ローカライズ、事実検証を担うエージェントが同時並行で稼働します。その結果、Vistatecの調査では解決時間が平均63%短縮され、運用コストも78%削減されたと報告されています。

| 処理構造 | 特徴 | 業務への影響 |

|---|---|---|

| 従来型ワークフロー | 単一モデルによる逐次処理 | 例外対応や修正に人手が必要 |

| エージェント型 | 複数エージェントが循環的に協調 | 自律的に品質と速度を両立 |

もう一つの柱がマルチモーダル技術です。2026年のAIエージェントは、テキストだけでなく、画像、音声、動画、さらには物理的な感覚情報までを統合して理解します。Analytics Vidhyaによれば、この統合認識が進んだことで、AIは「何が書かれているか」だけでなく、「どの状況で」「どんな意図で」発せられた情報かを把握できるようになりました。

具体例として、視覚と文脈を同時に扱う能力が挙げられます。画面上のエラーメッセージを認識し、過去の操作履歴やシステム構成を踏まえて修正案を提示する、といった行動が自然に行われます。これは単なる画像認識ではなく、行動につながる理解が実現したことを意味します。

マルチモーダル化は、AIを「説明する存在」から「一緒に作業する存在」へと変えました。音声のトーンから感情を読み取り応答を変える技術や、CES 2026で注目された触覚知能の研究は、その象徴です。これらの技術が組み合わさることで、AIエージェントはデジタル空間に留まらず、現実世界の業務や生活に深く溶け込んでいく基盤を手に入れました。

この二つの進化は独立しているわけではありません。エージェント型ワークフローが「思考と判断の骨格」を担い、マルチモーダル技術が「現実を正確に捉える感覚器」として機能します。その融合こそが、2026年のAIエージェントを単なる高性能AIではなく、実用的で信頼できるパートナーへと押し上げているのです。

ハルシネーションとプライバシーへの最新対策

AIエージェントが業務や生活の意思決定に深く関与するようになった2026年、ハルシネーション対策とプライバシー保護は「品質の話」ではなく「信頼の前提条件」として扱われています。特に企業利用では、もっともらしい誤情報や機密データ漏洩が、即座に経営リスクへ直結するためです。

文部科学省のAI for Scienceレポートによれば、近年の重大インシデントの多くはモデル性能不足ではなく、検証プロセスの欠如によって発生しています。これを受け、最新のAIエージェントでは生成と同時に検証を行う多層構造が標準化されました。

代表的なのが自己検証機構です。回答を生成したAIとは別のモデルが、外部の信頼できるデータベースや社内ナレッジと突き合わせ、根拠が曖昧な場合は出力を抑制します。ガートナーはこの仕組みにより、実運用環境でのハルシネーション率が大幅に低下したと分析しています。

加えて説明可能なAIの統合も進みました。AIがどの情報源の、どの部分を参照したかを人間が追跡できるため、判断の妥当性を監査できます。これは医療や金融だけでなく、マーケティング施策の根拠確認にも有効です。

| 対策技術 | 目的 | 実運用での効果 |

|---|---|---|

| 自己検証 | 事実性の担保 | 誤情報の自動抑制 |

| XAI | 判断根拠の可視化 | 人間による監査が可能 |

| 文脈制御 | 話題混線の防止 | 長時間対話の安定化 |

一方、プライバシーへの対策も質的に進化しています。Thunderbitの統計では、AI関連のセキュリティ事故は前年比56%増と報告されており、データ主権の確保が急務です。その解決策として注目されるのが、AppleのPrivate Cloud Computeです。

この仕組みでは、クラウド処理であってもデータは暗号化されたまま扱われ、処理後すぐに破棄されます。第三者監査を前提とした設計により、提供企業自身も中身を閲覧できません。ユーザーがAIを「信用する」のではなく、「検証できる」状態を作っています。

研究分野ではPrivWebのような適応型プライバシー保護も登場しました。AIが収集データの機微度をリアルタイムで判断し、特に敏感な情報では処理を一時停止して明示的な承認を求めます。利便性とプライバシーを二者択一にしない設計思想が、2026年のスタンダードになりつつあります。

ハルシネーションとプライバシーへの対策は、技術的進歩だけで完結しません。最終的に重要なのは、人間がAIの判断を監督できる構造を維持することです。AIが見えないインフラになる時代だからこそ、信頼を支える仕組みそのものが競争力になります。

フィジカルAIと家庭用ロボットの現実味

フィジカルAIと家庭用ロボットは、長年「技術的には可能だが家庭には遠い存在」とされてきましたが、2026年はその評価が明確に変わった分水嶺の年です。背景にあるのは、AIの知能そのものよりも、物理世界を理解し予測する能力が実用段階に入った点です。**AIが現実空間で安全かつ意味のある行動を取れるかどうか**が、家庭導入の可否を左右してきました。

その転換点として象徴的だったのが、CES 2026で発表されたNVIDIAのロボティクス向け世界モデル群です。同社が公開したCosmosは、カメラやセンサーから得た情報をもとに、物体の形状、重さ、摩擦、次に起こり得る動きを確率的に予測します。これにより、ロボットは「ぶつかったら止まる」段階から、「倒れそうだから支える」「落とすと危険だから持ち替える」といった人間的な判断に近づきました。ロボット研究者の間では、これは認識革命ではなく予測革命だと位置づけられています。

家庭用ロボットの現実味を高めた最大要因は、物理世界を“理解する”のではなく“先読みする”AIに進化した点です。

家庭内での利用を想定した場合、重要なのは万能性よりも限定された確実性です。掃除、片付け、見守り、簡単な調理補助といったタスクは、産業用ロボットほどの精度を必要としない一方、人間との共存が前提になります。東京大学の松尾豊教授も、2026年以降は「何でもできるロボット」ではなく、「失敗しにくい役割特化型ロボット」が家庭に届き始めると指摘しています。

実際、北米市場では2026年から段階的に家庭用AIロボットのデリバリーが始まる見込みとされていますが、その多くは自律移動、物の把持、高齢者の状態検知といった機能に絞られています。これは技術的制約というより、家庭内での安全性、信頼性、コストを最適化した結果です。MITのロボティクス分野の研究でも、家庭環境では成功率99.9%よりも「失敗時に危険を生まない設計」が受容性を大きく左右すると報告されています。

| 観点 | 従来の家庭ロボット | 2026年世代のフィジカルAI |

|---|---|---|

| 判断基準 | 事前定義ルール中心 | 確率予測と状況適応 |

| 環境対応 | 整った室内前提 | 散らかった家庭環境にも対応 |

| 安全設計 | 停止重視 | 回避・代替行動重視 |

一方で、日本市場では普及速度は緩やかになると見られています。住宅の狭さ、段差の多さ、家財の多様性は技術的ハードルが高く、さらに「機械が家に入ること」への心理的抵抗も根強いためです。ただし、高齢者の見守りや共働き世帯の家事補助といった文脈では、必要性が受容を上回り始めています。パナソニックが物流分野で培った自律エージェント技術を生活空間へ応用しようとしている点も、その兆候の一つです。

フィジカルAIと家庭用ロボットは、SF的な未来像ではなく、生活の一部として試される段階に入りました。重要なのは「いつ完全に人間の代わりになるか」ではなく、**どの不便を、どこまで静かに肩代わりしてくれるか**です。その現実的な進化こそが、2026年にこの分野が現実味を帯びた最大の理由です。

人間に求められる新しい役割とスキル

AIエージェントが自律的に判断し行動する時代において、人間に求められる役割は「作業の実行者」から「判断と設計の担い手」へと大きく移行しています。ガートナーが指摘するように、2028年までに業務上の意思決定の15%がAIエージェントによって自律化される見通しの中で、人間の価値はAIでは代替できない領域に集約されつつあります。

特に重要になるのが、AIの判断を前提として全体を統括する能力です。AIは最適解を高速に提示しますが、その前提条件の妥当性や、組織・社会に与える影響までを評価することはできません。Invisible AIが普及し、AIが裏側で動くほど、判断の根拠を問い直し、是非を決める人間の責任は重くなります。

野村総合研究所の調査でも、生成AIを導入した日本企業の70%以上が「リテラシー不足」を課題に挙げています。これは操作スキルの問題ではなく、AIの限界や前提を理解し、業務プロセス全体を再設計する視点が不足していることを意味します。

| 人間の新しい役割 | 求められるスキル | 具体的な行動例 |

|---|---|---|

| AI監督者 | 批判的思考 | AIの出力根拠を確認し、採用可否を判断する |

| 設計者 | 業務構造化力 | どの業務をAIに任せるかを設計する |

| 倫理的意思決定者 | 価値判断力 | 効率よりも社会的妥当性を優先する |

また、東京大学の松尾豊教授が述べるように、AI時代の競争力は「速さ」ではなく「問いの質」によって決まります。AIに何を目標として与え、どこまでの裁量を許すのか。その設計思想そのものが成果を左右します。

今後のキャリア形成において重要なのは、特定ツールへの習熟よりも、AIを前提とした判断力と責任感を磨くことです。AIが高度化するほど、人間には「決める力」と「引き受ける覚悟」が、これまで以上に求められていきます。

参考文献

- Salesmate CRM:The future of AI agents: Key trends to watch in 2026

- Analytics Vidhya:Top 10 AI Agent Trends and Predictions for 2026

- Business Review Europe:Apple selects Google’s Gemini to power its next-generation AI features

- 矢野経済研究所:国内生成AI/AIエージェントの利用実態に関する法人アンケート調査

- Web担当者Forum:2026年春頃「LINEヤフー広告」誕生、次世代AIエージェント構想も発表

- arXiv:PrivWeb: Unobtrusive and Content-aware Privacy Protection For Web Agents