ここ数年、生成AIや大規模言語モデルという言葉を耳にしない日はないほど、AIは急速に身近な存在になりました。ですが2026年の現在、多くの人が「結局AIは実務でどこまで使えるのか」「期待先行で終わらないのか」と感じ始めているのも事実です。熱狂の時代を経て、AIは今、真価が問われる段階に入っています。

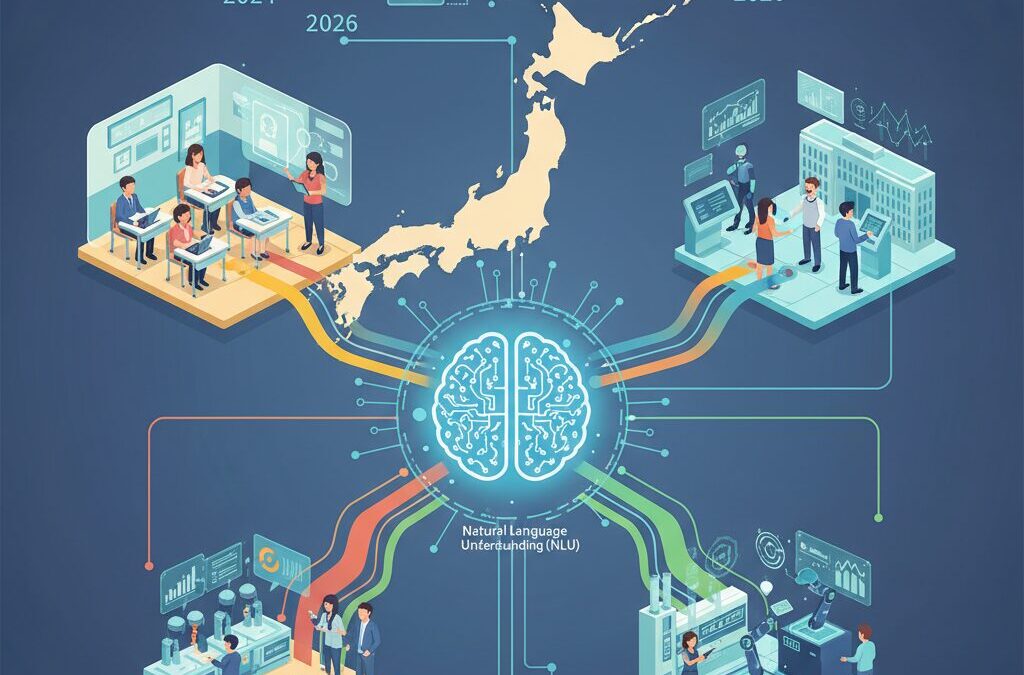

実は日本のAI市場では、PoC中心の試行錯誤から脱却し、投資対効果や責任の所在まで含めて評価される社会実装フェーズへと明確に移行しています。特に自然言語理解(NLU)は、単なる文章生成を超え、業務を自律的に遂行するAIエージェントとして進化を遂げました。その変化は、教育、行政、製造業といった現場で既に具体的な成果として現れています。

本記事では、2026年時点でのAIとNLUの最新動向を整理し、日本市場ならではの構造変化や国産LLMの戦略、そして信頼性やガバナンスの最前線までを分かりやすく解説します。AIに関心はあるものの全体像をつかみきれていない方にとって、今後の判断軸が明確になる内容をお届けします。

AI市場は熱狂期を終え、社会実装フェーズへ

2026年を迎えた現在、AI市場はかつての熱狂的な期待が先行する段階を明確に終え、社会実装と実利が厳しく問われるフェーズへと移行しています。スタンフォード大学HAI研究所が指摘するように、過剰な期待に基づく評価は後退し、AIが実際にどの業務で、どれだけの価値を生み出しているのかが冷静に検証される段階に入っています。

この変化を象徴しているのが、日本企業におけるPoCの位置づけです。2024年から2025年にかけて多数実施された実証実験は、2026年には投資対効果を伴わない限り継続されなくなりました。単なるデモや試験導入ではなく、既存システムと統合され、業務プロセスそのものを置き換えるAIだけが残る選別の時代に入っています。

特に注目すべきは、生成AIが「便利な道具」から「業務の主体」へと役割を変えつつある点です。IDCによる国内AIシステム市場の予測では、2024年に1兆3,412億円だった支出額が、2026年には約2.1〜2.3兆円規模に拡大しています。この成長を牽引しているのは、要約や翻訳といった単機能ではなく、複数の業務を横断的に処理するAIエージェントの本格導入です。

| 年 | 市場規模 | 技術の位置づけ |

|---|---|---|

| 2024年 | 1兆3,412億円 | 生成AIの試験導入と標準機能化 |

| 2026年 | 約2.1〜2.3兆円 | AIエージェントの社会実装 |

| 2029年 | 4兆1,873億円 | 自律型マルチエージェントの定着 |

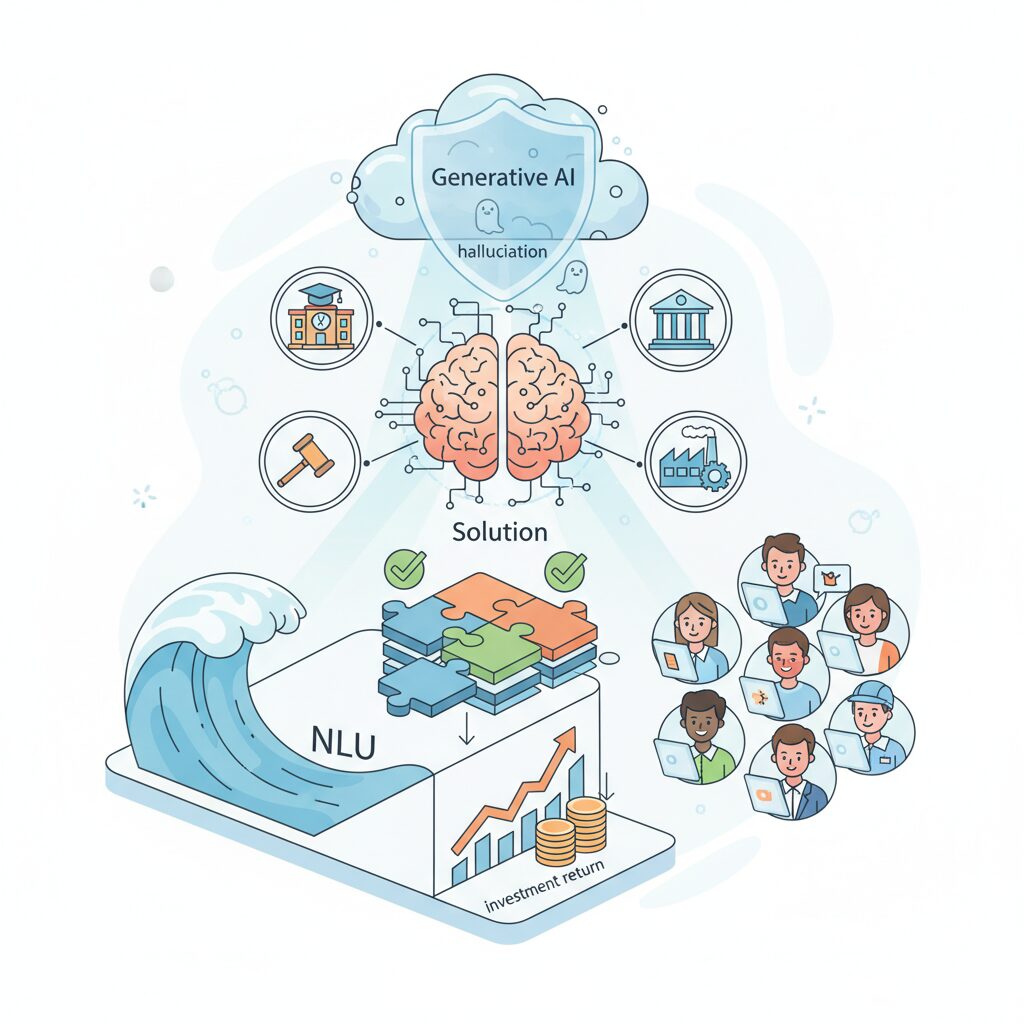

国内最大級のAIポータルメディアによる1万件超の問い合わせ分析でも、関心は「AIで何ができるか」から「自社データをどう安全に使い、成果を出すか」へと明確にシフトしています。ハルシネーション抑制、データ主権、責任あるAIといった実務的課題が、導入判断の中心に据えられています。

このように現在のAI市場は、流行に乗るかどうかを競う段階ではありません。AIを前提に業務や組織を再設計できるかどうかが、企業や社会の競争力を左右する局面に入っています。熱狂が去ったからこそ、本当に使えるAIだけが、静かに社会の基盤へと組み込まれ始めているのです。

日本のAI市場規模と成長率が示す現実的インパクト

日本のAI市場規模と成長率を冷静に見ていくと、そこには過度な楽観でも悲観でもない、極めて現実的で重みのあるインパクトが浮かび上がります。IDC Japanによれば、国内AIシステム市場は2024年時点で1兆3,412億円に達しており、2029年には4兆1,873億円規模まで拡大すると予測されています。**年平均成長率25.6%という数字は、日本市場としては異例の高さ**であり、AIが一過性のトレンドではなく、産業基盤そのものに組み込まれ始めていることを示しています。

重要なのは、この成長が単なる「AI導入ブーム」によるものではない点です。2024〜2025年に急増した生成AIの導入は、要約やコード生成といった生産性向上ユースケースがソフトウェアに標準搭載されたことが起点でした。しかし2026年の現在、企業の投資判断は明確に変化しています。**PoCの数ではなく、ROIをどこまで実証できるかが評価軸となり、AIはコストではなく業務遂行主体として扱われ始めています。**

| 年 | 市場規模 | 成長を支える主因 |

|---|---|---|

| 2024年 | 1兆3,412億円 | 生成AIの普及、業務支援の標準化 |

| 2026年 | 約2.1〜2.3兆円 | AIエージェントの本格実装 |

| 2029年 | 4兆1,873億円 | 自律型マルチエージェントの定着 |

この成長曲線が示す最大の現実的インパクトは、「人がやっていた業務の一部をAIが代替する」段階を超え、「AIを前提に業務プロセスそのものが再設計される」段階に入ったことです。国内最大級のAIポータルメディアが実施した1万件超の問い合わせ分析でも、関心の中心は機能説明から、自社データとの安全な統合や既存システムとの連携へと移行しています。

つまり市場拡大の正体は、AIソフトウェアの数が増えたことではありません。**AIが企業活動の中核に入り込み、使わなければ競争力を維持できない状況が静かに形成されていること**にあります。25%超のCAGRは派手な数字に見えますが、その裏側では、投資に耐えうる実用性と信頼性を備えた技術だけが生き残る、選別のフェーズがすでに始まっています。

この現実を直視すると、日本のAI市場成長は「夢の市場」ではなく、「結果を出した組織だけが恩恵を受ける市場」へと進化していることが分かります。規模と成長率は希望を示す指標である一方、同時に企業や個人に対して、AIをどう使いこなすかという具体的な覚悟を突きつけているのです。

生成AIからAIエージェントへ進化する自然言語理解

生成AIが「文章をそれらしく理解し、返答する存在」から一段進化した背景には、自然言語理解の役割そのものの変化があります。2026年現在のNLUは、単語や文脈を把握する技術ではなく、業務の目的や制約条件を理解し、自ら判断して行動につなげるための中核技術へと位置づけが変わっています。

この変化を象徴するのが、AIエージェントの台頭です。従来の生成AIは、ユーザーの指示を一度解釈して応答する「一問一答型」でした。一方、AIエージェントでは、NLUがユーザーの曖昧な要望や背景意図を読み取り、複数のタスクに分解し、必要に応じて社内データや外部システムと連携しながら処理を進めます。

IDCによる国内AI市場分析でも、2026年はAIアシスタントからAIエージェントへの転換点と位置づけられており、特に業務プロセス自動化の領域で投資が加速しているとされています。

| 観点 | 従来の生成AI | AIエージェント時代のNLU |

|---|---|---|

| 言語理解の範囲 | 入力文と文脈の理解 | 目的・制約・業務全体の理解 |

| タスク処理 | 単発の応答生成 | 複数タスクを自律的に遂行 |

| データ活用 | 主に学習済み知識 | 社内DBやRAGによる最新情報 |

この進化を支えているのが、RAGの高度化や知識編集技術です。EMNLPやACLといった国際会議では、事実性を担保しながら推論を進めるNLUが主要テーマとなり、理化学研究所や国内企業の研究成果も高く評価されています。これにより、AIエージェントは誤情報を前提に動くリスクを大きく減らしました。

さらに重要なのは、NLUが「対話の理解」から「業務文脈の理解」へ拡張された点です。国内AIポータルメディアによる1万件超の問い合わせ分析でも、企業の関心は機能説明ではなく、自社固有データや既存ワークフローとどう結合できるかに集中しています。NLUは、その橋渡し役として不可欠な存在になっています。

結果として、2026年の自然言語理解は、AIエージェントの思考エンジンとして機能し、人間の指示を待つ存在から、人間と並走しながら仕事を進める主体を実現する技術へと進化しています。この地味だが本質的な変化こそが、生成AIからAIエージェントへの進化を支えているのです。

ハルシネーションを抑制する最新NLU研究の到達点

2026年時点における自然言語理解研究の最大の到達点は、長年課題とされてきたハルシネーションを「後処理で抑える対象」から「構造的に起こさせない設計」へと転換した点にあります。EMNLP 2025やACLといった国際会議では、モデル規模の拡大競争よりも、**事実性と論理整合性をいかに数理的に保証するか**が主要テーマとなりました。

中核となっているのが、検索拡張生成であるRAGの高度化です。従来のRAGは単に外部文書を参照する仕組みでしたが、2026年の最新手法では、推論途中の各ステップで信頼度の高いデータソースと逐次照合を行い、根拠が見つからない推論経路そのものを遮断します。理化学研究所AIPセンターやサイバーエージェントの研究によれば、この方式により、業務文書生成における事実誤認率が従来比で大幅に低下したと報告されています。

もう一つの重要な進展が「知識編集(Knowledge Editing)」です。これはモデル全体を再学習させることなく、特定の事実やルールだけを局所的に更新する技術です。EMNLP 2025で発表された研究では、法改正や金融商品情報の変更を即時に反映させても、他の知識体系に悪影響を及ぼさないことが示されました。これにより、**古い知識が原因で生じるハルシネーション**という実務上のリスクが大きく低減しています。

| 技術要素 | 従来手法 | 2026年の到達点 |

|---|---|---|

| RAG | 回答前の一括検索 | 推論途中での逐次照合 |

| 知識更新 | 再学習が必要 | 局所的な知識編集 |

| 誤答対策 | 出力後の検証 | 推論経路自体を制約 |

さらに注目すべきは、推論の論理性を強化する研究の進展です。Chain-of-Thoughtを単なるプロンプト技法としてではなく、モデル内部に組み込むことで、因果関係や条件分岐を明示的に扱えるようになりました。スタンフォード大学や東京大学の関連研究では、多段階推論を必要とする会計・法務タスクにおいて、人間専門家と同等水準の整合性が確認されています。

これらの成果が示すのは、ハルシネーションが「AIの宿命」ではないという事実です。**信頼できる外部知識との連携、更新可能な知識構造、論理的に制約された推論経路**という三点を統合することで、NLUは社会実装に耐える信頼性を獲得しました。2026年の研究到達点は、AIを疑いながら使う段階から、前提として信頼できる基盤へと押し上げた転換点だと言えます。

推論能力の進化が業務自動化の質を変えた理由

業務自動化の質がここ数年で飛躍的に高まった最大の要因は、AIの推論能力が単なる補助機能から、業務そのものを担う水準へ進化した点にあります。従来の自動化は、条件分岐やルールベース処理が中心で、想定外の入力や文脈の変化に弱いという限界がありました。しかし2026年現在の自然言語理解は、**業務の背景や目的を踏まえて次の行動を選択する推論力**を獲得しています。

この変化を象徴するのが、Chain-of-Thoughtを内包した大規模言語モデルと、RAGによる外部知識照合の組み合わせです。EMNLPやACLといった国際会議でも、正答率の向上より「論理的整合性」や「因果関係の一貫性」を重視する研究が主流になりました。これによりAIは、単に文章を生成する存在から、**業務プロセス全体を論理的に再構成できる主体**へと変わっています。

実務への影響は明確です。例えば会計や法務では、入力文書を要約するだけでなく、関連規定を参照し、処理手順の妥当性を検証するところまで自動化され始めています。国内自治体での実証では、AIが根拠条文と判断理由を同時に提示することで、職員の確認工数が大幅に削減されたと報告されています。これは、**推論ができるからこそ実現した自動化の質的転換**です。

| 観点 | 従来型自動化 | 推論型AIによる自動化 |

|---|---|---|

| 判断基準 | 固定ルール | 文脈と目的を考慮 |

| 例外対応 | 人手に依存 | 論理的に処理可能 |

| 業務範囲 | 部分最適 | プロセス全体 |

さらに重要なのは、推論能力の向上がハルシネーション抑制と直結している点です。理化学研究所やサイバーエージェントの研究でも示されている通り、外部ソースとのリアルタイム照合や知識編集技術により、事実誤認を構造的に防ぐ設計が進んでいます。結果として、**自動化=リスク**という認識は薄れ、ROIを前提とした本格導入が可能になりました。

推論能力の進化は、業務を速くするだけでなく、判断の質そのものを底上げします。だからこそ2026年の自動化は、単なる省力化ではなく、企業や組織の意思決定レベルを引き上げる戦略的インフラとして評価されているのです。

Ghost Driftが示したAIガバナンスの新しい課題

Ghost Driftが提示した最大の問いは、AIの性能向上そのものではなく、意思決定が高度化するほど責任が見えなくなるという逆説的な課題にあります。2026年現在、AIエージェントやマルチエージェントシステムが業務の中核を担うようになり、「誰が最終的に判断したのか」を事後的に説明できないケースが現実のリスクとして浮上しています。

GhostDrift数理研究所によれば、この現象は単なる運用ミスではなく、複雑系システムに固有の構造問題とされています。複数のAI、複数のデータソース、人間の承認プロセスが絡み合うことで、判断が集合知として生成され、責任主体が霧散する「責任蒸発」が起きるのです。これは従来のAI倫理ガイドラインでは想定されていませんでした。

特に問題視されているのが、説明可能AIとされるXAIの限界です。多くのXAIは、結論が出た後に人間向けの説明文を生成しますが、Ghost Driftの研究では、これが実際の計算因果とは一致しない「後付けの物語」になりやすいと指摘されています。説明を重ねるほど真の因果から遠ざかる「事後説明の無限後退」は、監査や訴訟の場面で致命的です。

| 従来の考え方 | Ghost Driftが示す課題 |

|---|---|

| 高性能なら社会実装できる | 高性能ほど責任の所在が不明確になる |

| 説明できれば信頼できる | 説明が因果を歪める可能性がある |

| 事故後に検証すればよい | 事故前に責任を固定しなければ意味がない |

この構造的欠陥に対し、Ghost Driftは発想の転換を求めています。重要なのは「なぜそう判断したか」を後から語ることではなく、どこで、誰が、どのリスクを引き受けたかを判断前に固定することです。そのために提唱されたのが、決定前制約と完全再現性台帳という考え方です。

決定前制約では、AIが推論を進める途中段階に数理的な制限を組み込み、倫理的・法的に許されない経路そのものを計算不能にします。これはブレーキを後付けするのではなく、最初から進めない道を設計する発想です。理化学研究所や海外の数理ガバナンス研究でも、同様の方向性が有効と報告されています。

さらにADICプロトコルによる完全再現性台帳は、AIの判断プロセスをビット単位で再現可能な形で保存します。これにより、事故が起きた際に「ブラックボックスだった」という言い訳は通用しなくなります。Ghost Driftは、この仕組みを会計監査や金融取引、エネルギー制御の分野に適用する実証が進んでいるとしています。

この視点は、EU AI Actや日本のAI基本計画とも静かに共鳴しています。規制の厳しさ以上に問われているのは、AIが関与した判断において、人間社会が納得できる責任の線をどこに引けるかです。Ghost Driftは、その線引きを倫理ではなく数理で行おうとする点で、AIガバナンスの次の段階を示しています。

責任あるAIを実現する数理的フレームワーク

AIが社会インフラとして組み込まれる2026年現在、責任あるAIを実現するためには、倫理宣言やガイドラインだけでは不十分です。求められているのは、責任や判断の境界を数理的に固定できるフレームワークであり、AIの意思決定を検証可能な形で残す仕組みです。スタンフォード大学HAI研究所も、評価フェーズに入ったAIには再現性と説明責任が不可欠だと指摘しています。

この文脈で注目されているのが、GhostDrift数理研究所が提唱する「Ghost Drift」フレームワークです。これは、複雑なAIシステムにおいて責任が分散・希薄化する現象を構造的に捉え、責任が蒸発するポイントを数理モデルとして可視化する試みです。従来の説明可能AIが出力後の説明に依存していたのに対し、Ghost Driftは推論過程そのものに踏み込みます。

特に重要なのが「決定前制約」という考え方です。これは、AIが結論を出す直前ではなく、推論プロセスの各段階に数理的な制約条件を埋め込む手法です。たとえば法規制や倫理基準を満たさない経路は、計算上そもそも選択できないように設計されます。EMNLPやACLで議論されてきた論理整合性重視の流れとも一致し、ハルシネーションを構造的に抑制する基盤として評価されています。

| 要素 | 数理的役割 | 実務的な効果 |

|---|---|---|

| 決定前制約 | 推論経路の制限 | 不適切判断の物理的排除 |

| ADIC Ledger | 完全再現性の保証 | 監査・検証の自動化 |

| Beacon署名 | 責任境界の固定 | 人とAIの役割分離 |

ADICと呼ばれる有限台帳プロトコルも、この枠組みの中核です。有理数演算と外向き丸めを用いることで、同一入力に対して必ず同一の推論結果を生成します。これにより、事故や不正が発生した際に、どのデータとどの判断ノードが結果に影響したのかを数学的に再現できます。KPMGなどの監査分野でも、こうした完全再現性は次世代ガバナンスの前提条件とされています。

さらにBeaconと呼ばれる責任境界点署名は、人間が介入した判断ポイントを暗号的に記録します。これにより、AIと人間の共同意思決定において、誰が止められたのか、なぜ止めなかったのかを後から曖昧にできません。Ghost Drift研究所によれば、この仕組みは高度金融取引やエネルギー制御の現場で既に実証が進んでいます。

責任あるAIの本質は、AIを善良に振る舞わせることではありません。失敗したときに、必ず検証でき、必ず責任を特定できる構造を持たせることです。数理的フレームワークは、そのための言語であり、AIをブラックボックスから社会に耐えうる道具へと変える鍵になっています。

国産LLMとソブリンAIに注目が集まる背景

2026年現在、国産LLMとソブリンAIに注目が集まる最大の背景は、AIが実験段階を終え、社会や産業の中核インフラとして評価されるフェーズに入ったことにあります。生成AIが一般化した2024〜2025年を経て、企業や行政は「使えるかどうか」ではなく、**長期的に安心して使い続けられるか、責任を持って運用できるか**を重視するようになりました。この価値基準の転換が、海外モデル一辺倒だった流れを見直す契機となっています。

特に大きな要因となっているのが、データ主権と経済安全保障への意識の高まりです。スタンフォード大学HAI研究所が指摘するように、AIはもはや単なるITツールではなく、国家や産業競争力を左右する戦略資産です。業務データや学習データが国外のクラウドやモデルに依存する状態は、知的財産や機密情報の観点から無視できないリスクとなりました。**自国の法律、商慣習、価値観のもとで制御可能なAIを持つこと**が、現実的な経営・政策課題として浮上しています。

市場構造の変化も、この流れを後押ししています。IDCによれば、日本のAIシステム市場は2024年の1兆3,412億円から2029年には4兆円超へと拡大する見込みで、成長の中心は汎用的なチャット利用から、業務システムに深く組み込まれたAIエージェントへと移行しています。こうした用途では、日本語の微妙なニュアンス理解や、国内法規・業界ルールへの正確な適合が不可欠です。**英語圏中心に最適化された海外LLMでは、追加コストや運用リスクが顕在化しやすい**という現場の実感が、国産LLM再評価につながっています。

| 観点 | 海外LLM依存 | 国産LLM・ソブリンAI |

|---|---|---|

| データ管理 | 国外サーバー・法制度に依存 | 国内法のもとで管理可能 |

| 日本語・商慣習対応 | 追加調整が必要 | 初期設計から最適化 |

| 責任・監査 | ブラックボックス化しやすい | 説明性・監査性を設計に反映 |

さらに、EU AI Actの全面施行を目前に控え、AIの責任所在やトレーサビリティが国際的な義務となりつつあります。こうした規制環境では、モデルの内部仕様や運用プロセスを十分に把握できないAIは、ビジネス上のリスクとなります。経済産業省が推進するソブリンAI政策は、イノベーション促進と同時に、**説明可能性や監査可能性を前提とした「責任あるAI」基盤の確立**を狙ったものです。

この文脈で、NTTのtsuzumi2や、ソフトバンクが進める産業特化型LLMが注目されているのは偶然ではありません。巨大モデルでの性能競争ではなく、日本の産業構造や人口動態といった現実課題に即した最適解を提示できる点が評価されています。**国産LLMとソブリンAIへの関心の高まりは、ナショナリズムではなく、ROI・リスク・持続性を冷静に見極めた結果**だと言えるでしょう。

教育・行政分野で進むNLUの実用事例

教育・行政分野では、自然言語理解(NLU)が「業務を楽にする補助ツール」から「現場の前提条件を変える基盤技術」へと進化しています。背景にあるのは、GIGAスクール構想の定着や自治体DXの本格化により、現場に大量のテキストデータと対話データが蓄積されたことです。2026年現在、NLUはそれらを文脈ごと理解し、判断や対応を支援する段階に入っています。

教育分野で象徴的なのは、学習者の思考プロセスそのものを読み取る活用です。文部科学省のGIGAスクール構想の進展を受け、AIは単なる解答提示ではなく、児童生徒の発言や記述内容から理解度やつまずきの位置を推定し、問い返しを行います。スタンフォード大学HAI研究所が指摘するように、近年のNLUは表層的な正誤判定ではなく、学習過程の文脈把握に強みを持つようになりました。

実際、ベネッセの「自由研究お助けAI」では、子どもの曖昧な興味表現を対話的に深掘りし、テーマ設定まで導いています。学研のGDLSと生成AIの連携では、説明文の語彙や構文を学習者ごとに動的調整することで、学習継続率が12ポイント向上しました。**NLUが学力ではなく思考の癖を理解する点**が、従来の教材との決定的な違いです。

| 分野 | NLUの役割 | 具体的な効果 |

|---|---|---|

| 教育 | 学習者の発話・記述の文脈理解 | 個別最適化、学習継続率向上 |

| 行政 | 法規・マニュアルの意味解釈 | 業務時間短縮、対応品質の均一化 |

一方、行政分野では「調べる」作業そのものが再定義されています。自治体業務は法令、要綱、内部マニュアルが複雑に絡み合い、担当者の経験に依存しやすい構造でした。北九州市ではNECのLLM「cotomi」を活用し、職員が自然文で質問すると、関連する規定と処理手順を即座に提示できる仕組みを構築しています。これにより、会計室への問い合わせ待ちが解消され、意思決定のスピードが大幅に向上しました。

三島市の事例も示唆的です。秘密分散技術とAIを組み合わせることで、セキュリティを確保したままNLUを業務に組み込み、テレワークと業務自動化を両立しています。**NLUは単なるチャットボットではなく、行政知識を安全に扱うインターフェース**として機能しているのです。

教育と行政に共通するのは、人手不足という構造課題への対応です。AIが文脈理解を担うことで、教員や職員は対人対応や判断といった本質的業務に集中できます。国内外の研究や実装事例が示すように、NLUは公共分野において、人とAIの役割分担を現実的な形で成立させる段階に到達しています。

EU AI Actと日本のAI基本計画が企業に与える影響

EU AI Actと日本のAI基本計画は、2026年現在、企業のAI活用戦略に質的な転換を迫っています。**もはやAIは「使えば競争力になる技術」ではなく、「使い方を誤れば経営リスクになる経営課題」**として扱われ始めています。特にグローバル展開を行う企業ほど、この二つの制度の違いを正確に理解する必要があります。

EU AI Actは2026年8月に大部分が全面適用され、リスクベースでAIを分類し、ハイリスクAIには厳格な義務を課しています。KPMGによる整理によれば、適合性評価、学習データの管理、説明可能性、人的監督体制の整備が不十分な場合、**全世界売上高の最大7%という制裁金が現実的な経営リスク**になります。これはIT部門の問題ではなく、取締役会レベルのガバナンス課題です。

一方で日本のAI基本計画は、事前規制よりも活用促進を重視する「アジャイル・ガバナンス」を採用しています。内閣府の資料によれば、政府自らが行政・医療・製造業でAI活用を主導し、企業には過度な萎縮ではなく、**リスクを管理しながら挑戦する姿勢**が求められています。この温度差が、企業戦略に複雑な判断を迫っています。

| 観点 | EU AI Act | 日本のAI基本計画 |

|---|---|---|

| 基本思想 | 事前規制によるリスク最小化 | 活用促進と事後対応の両立 |

| 企業への影響 | 法令遵守コストの増大 | 実証と社会実装の加速 |

| 経営リスク | 違反時の高額制裁金 | 責任境界の不明確さ |

この差異は、企業のAI設計思想そのものに影響します。EU市場向けには、生成物へのラベル表示や電子透かし、意思決定ログの保存などを前提とした「コンプライアンス・ファースト設計」が不可欠です。実際、欧州で事業を展開する日本企業の中には、AIエージェントの自律度を意図的に制限し、人間の最終承認を組み込む設計へ切り替える動きが出ています。

同時に、日本国内ではROIが明確な業務領域での迅速な導入が評価されやすく、AIエージェントやマルチエージェントの実装が進んでいます。IDCの市場予測が示す高成長の背景には、**規制対応力そのものが競争優位になる**という企業の学習効果があります。EU基準を満たす設計は、そのまま信頼性の証明として国内外の取引で評価され始めています。

つまり企業にとって重要なのは、どちらか一方に合わせることではありません。EU AI Actを「最低限守るべき国際基準」として内製化し、日本のAI基本計画を「攻めの活用余地」として活かす二層構造の戦略です。**規制対応をコストではなく、信頼を獲得する投資と捉えられるかどうか**が、2026年以降のAI競争力を大きく左右します。

2026年のAI勢力図とAGIをめぐる専門家の見解

2026年のAI勢力図は、もはや一強体制では語れない段階に入っています。東京大学の松尾豊教授が指摘するように、この年は特定企業の独走から、複数の思想と戦略が拮抗する群雄割拠の構造へと転換しました。OpenAI、Google、Anthropic、Metaといった米国勢に、中国のDeepSeekなどが加わり、さらにオープンソース陣営が存在感を強めています。**競争の軸は「モデルの賢さ」から「どの社会課題を、どの責任構造で解くか」へと明確にシフトしています。**

米国では、OpenAIがMicrosoftの計算資源と法人顧客基盤を背景に、実務特化型の高度なエージェント化を推進しています。一方、GoogleはGeminiを中心に、検索、地図、動画といった既存サービスとの深い統合を武器に巻き返しを図っています。スタンフォード大学HAI研究所によれば、両者の差は純粋な性能ではなく、エコシステム設計と安全性アプローチの違いに集約されつつあります。

| 勢力 | 中核プレイヤー | 2026年時点の強み |

|---|---|---|

| 米国ビッグテック | OpenAI、Google | 計算資源とグローバル展開力、企業向けAIエージェント |

| 新興・対抗軸 | Anthropic、Meta | 安全性設計やオープンモデル戦略 |

| 中国・OSS圏 | DeepSeekなど | 低コスト提供と開発民主化 |

中国勢とオープンソースの台頭は、勢力図を一段と複雑にしています。DeepSeekに代表される中国モデルは、高性能でありながらオープン、もしくは極めて安価に提供され、研究者や新興企業の選択肢を広げました。これはAI開発の裾野を広げる一方で、データ主権や安全保障の観点から、各国政府や企業に新たな判断を迫っています。**AIは技術競争であると同時に、地政学的な選択でもある**という認識が、2026年には共有され始めています。

ではAGIは到来したのでしょうか。この問いに対し、専門家の見解は一貫して慎重です。スタンフォード大学HAI研究所は、現在を「過剰期待が剥落し、実力を冷静に測る評価フェーズ」と位置付けています。言語、画像、音声、物理制御を統合するマルチモーダル性能は飛躍的に向上しましたが、人間の知能をあらゆる文脈で代替するAGIには至っていない、というのが支配的な見方です。

ただし重要なのは、**産業ごとの限定領域ではAGIに近い挙動がすでに実用化されている**点です。法務、会計、製造制御など、条件が定義された環境では、人間を上回る一貫性と処理速度を示すAIエージェントが稼働しています。松尾教授は、AGIを「一つの到達点」と捉えるのではなく、こうした特化型知能の集合が社会をどう変えるかを見るべきだと述べています。

2026年のAI勢力図とAGI論争が示しているのは、万能知能の誕生よりも、責任を持って使える強力な知能が世界中に分散する未来です。その中で勝者となるのは、最も賢いモデルを持つ企業ではなく、最も信頼されるAIを社会に根付かせたプレイヤーだと言えるでしょう。

参考文献

- Ledge.ai:AGIは来ない、バブルは続かない スタンフォード大 HAI研究所が示す2026年のAI

- IDC Japan:国内AIシステム市場予測を発表

- AI Smiley:AIトレンドレポート2026

- CyberAgent:EMNLP 2025にて自然言語処理分野の論文が採択

- Zenn:AI倫理 2026年度版:制度・標準・研究の到達点

- 内閣府:人工知能基本計画骨子(案)