音声認識AIは、ただ話した言葉を文字に変換する技術だと思っていませんか。2026年現在、その認識は大きく更新されています。音声認識は今、感情や状況、周囲の環境までを理解する「人間に近い知能」へと進化しつつあります。

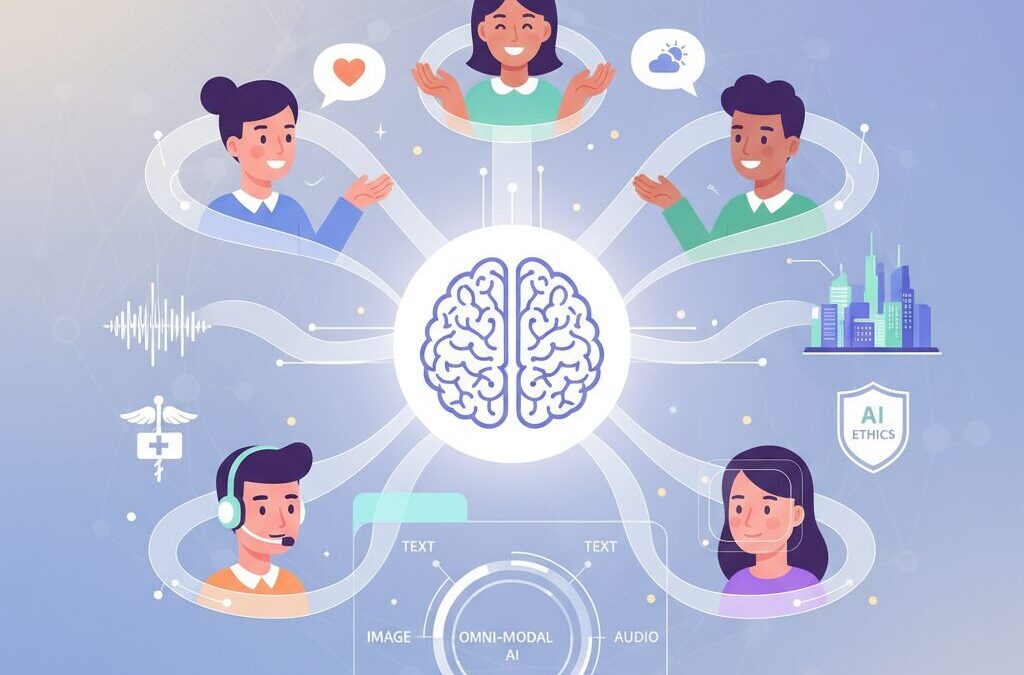

背景にあるのは、テキストや画像、音声を別々に処理する従来型AIから、すべてを同時に扱うオムニ・モーダルAIへの転換です。この変化により、会話の抑揚や感情、さらには表情や環境音までもが意味として統合され、AIとの対話体験は質的に変わりました。

本記事では、音声認識精度を示す最新データや、GPT-5やGeminiといった次世代モデルの技術的特徴、日本の医療やコールセンターで進む社会実装の事例、そしてディープフェイク対策や2030年に向けた未来像までを体系的に整理します。AIに関心のある方が、今後の技術動向とビジネス・社会への影響を一気に理解できる内容をお届けします。

音声認識AIが迎えた決定的な転換点

2026年現在、音声認識AIは「音声を文字に変換する技術」という従来の定義を完全に脱却しました。決定的な転換点となったのは、マルチモーダル学習がさらに進化し、人間の認知構造に近い形で情報を統合するオムニ・モーダルインテリジェンスへと到達した点です。音声はもはや単独で処理される対象ではなく、視覚、表情、環境音、文脈と不可分の存在として扱われるようになりました。

この変化の背景には、2023〜2024年に主流だった構成的アーキテクチャの限界があります。音声モデルと言語モデルを後段で接続する方式では、言語情報が過度に優先され、イントネーションや感情といった非言語的要素が正しく反映されないという課題が指摘されてきました。人工知能研究の第一人者たちも、こうしたテキスト・バイアスが人間らしい理解を阻害すると警鐘を鳴らしていました。

そこで登場したのが、設計段階から全モダリティを等価に扱うネイティブ・マルチモーダル・アーキテクチャです。OpenAIのGPT-5やGoogleのGemini 3、MetaのLlama 4といった次世代モデルでは、音声、テキスト、画像が単一のTransformerバックボーン上で同時に処理されます。**音声の抑揚や間の取り方、感情の揺らぎが、意味理解と同じレベルで統合される**ことが、この世代の本質です。

実際、ElevenLabsが発表したScribe v2は、日本語において3%台前半という歴史的に低いWERを記録しました。これは単なるアルゴリズム改善の成果ではなく、感情や文脈を含めて音声を理解する構造そのものが刷新された結果です。スタンフォード大学やMITの関連研究でも、早期融合型マルチモーダル学習が認識精度と意味理解の双方を同時に高めることが示されています。

| 観点 | 従来型音声認識 | 2026年以降の音声認識AI |

|---|---|---|

| 処理単位 | 音声のみ | 音声・視覚・文脈を統合 |

| 感情理解 | 限定的 | リアルタイムで高精度 |

| 役割 | 補助ツール | 判断・行動の中核 |

この決定的な転換は、音声認識AIの社会的な位置付けも変えました。医療やビジネスの現場では、人間の確認を前提としない自律的な理解が求められています。オムニ・モーダル化によって、音声は単なる入力手段ではなく、人間とAIを結ぶ最も自然なインターフェースとして再定義されました。

**音声認識AIが迎えた本当の転換点とは、精度の向上ではなく、理解の質が人間に近づいた瞬間**だったのです。この変化は一過性のブレイクスルーではなく、今後のAI体験全体を規定する不可逆な進化として位置付けられています。

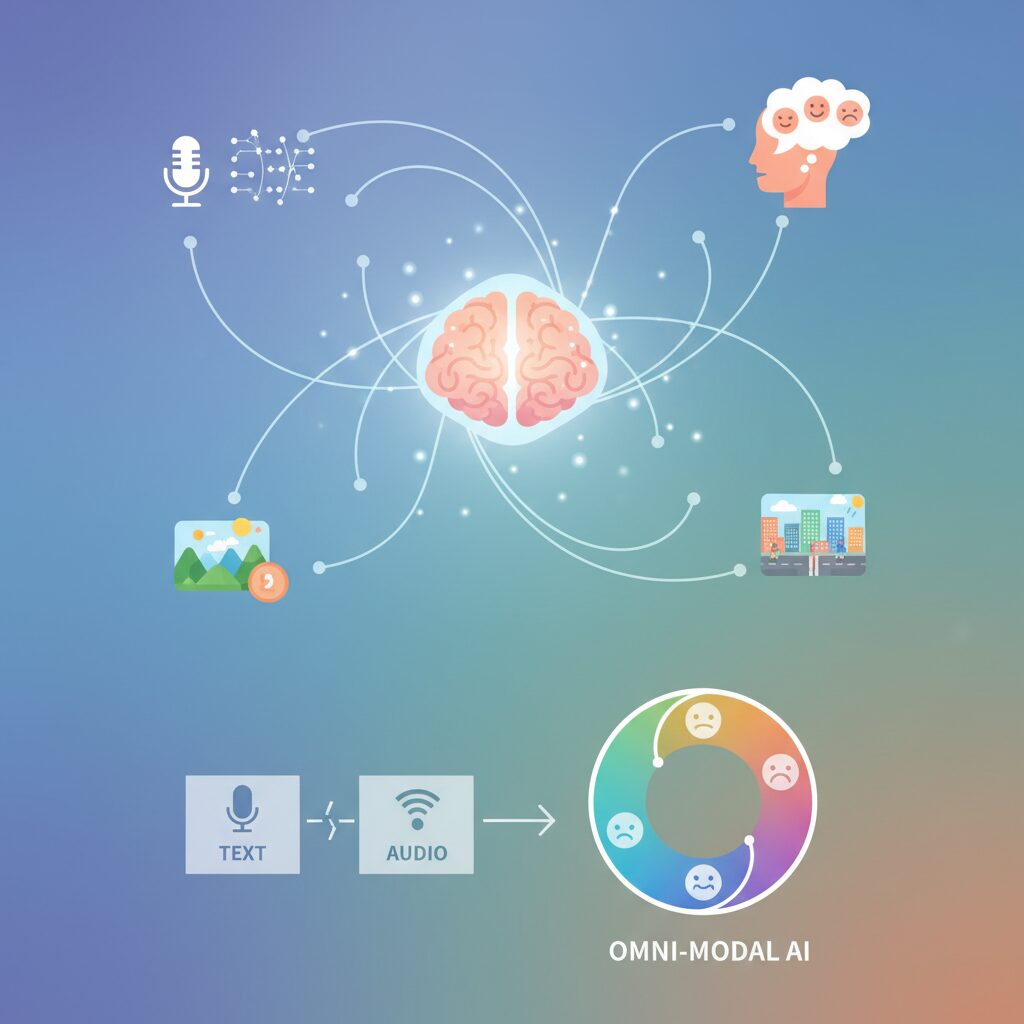

オムニ・モーダルAIとは何か

オムニ・モーダルAIとは、テキストや画像、音声といった複数の情報を単に組み合わせる段階を超え、人間の知覚に近いかたちで同時かつ統合的に理解する人工知能を指します。従来のマルチモーダルAIが「別々に理解した結果を後からつなぐ」発想だったのに対し、オムニ・モーダルAIは設計段階から全モダリティを等価に扱い、一つの知能として処理する点が決定的に異なります。

2026年現在、この概念が現実の技術として成立した背景には、ネイティブ・マルチモーダル学習の進展があります。OpenAIのGPT-5やGoogleのGemini 3、MetaのLlama 4などは、音声のイントネーション、話者の表情、映像の動き、テキストの意味を単一のTransformerバックボーン内で同時に処理します。米国のAI研究コミュニティによれば、これにより従来問題視されてきた「テキスト偏重の解釈バイアス」が大幅に緩和されたと報告されています。

例えば音声認識一つを取っても、発話内容だけでなく声の震えや間、周囲の環境音、さらには話者の表情が同時に考慮されます。スタンフォード大学のHuman-Centered AI研究所は、こうした統合処理によってAIの判断精度だけでなく、ユーザーからの信頼感も有意に向上することを示しています。これはAIが「何を言ったか」だけでなく「なぜそう言ったか」を推定できるようになったことを意味します。

| 観点 | 従来型マルチモーダル | オムニ・モーダルAI |

|---|---|---|

| 学習構造 | 個別モデルを後段で接続 | 単一モデルで同時学習 |

| 非言語情報 | 補助的扱い | 言語と同等に扱う |

| 理解対象 | データの意味 | 文脈・状況・意図 |

重要なのは、この進化が単なる性能向上ではなく、AIの役割そのものを変えつつある点です。IBMの将来予測でも、オムニ・モーダルAIは「操作されるツール」から「人間と並走する認知パートナー」へ移行すると述べられています。AIに興味を持つ読者にとって、オムニ・モーダルAIとは次世代技術の名称ではなく、人とAIの関係性を根本から書き換える概念として捉えるべき存在だと言えるでしょう。

ネイティブ・マルチモーダルアーキテクチャの進化

ネイティブ・マルチモーダルアーキテクチャの進化は、AIが人間の認知に一歩近づいた象徴的な変化です。従来は音声、画像、テキストを個別に処理し、後段で統合する構成が主流でしたが、この方式では言語情報が他モダリティを上書きしてしまう「テキスト・バイアス」が避けられませんでした。

2025年以降に登場したGPT-5、Gemini 3、Llama 4などは、設計段階から全モダリティを等価に扱うネイティブ・トレーニングを採用しています。音声の抑揚、間、環境音、さらには話者の表情や視線といった非言語情報までが、単一のTransformerバックボーン内で同時に処理されます。

この転換を技術的に支えるのが「初期融合(Early Fusion)」です。MetaのChameleonモデルでは、512×512ピクセルの画像を1024トークンに離散化し、テキストと同じ語彙空間で扱います。これにより、視覚や音声が言語に従属するのではなく、意味形成に対して対等な役割を持つようになりました。

| 観点 | 従来型 | ネイティブ型 |

|---|---|---|

| 学習方式 | 個別学習後に接続 | 全モダリティ同時学習 |

| 情報統合 | 後段融合 | 初期融合 |

| バイアス | テキスト優位 | 等価処理 |

さらにMoE(混合専門家)モデルの進化により、計算資源を動的に最適配分できるようになり、大規模マルチモーダル処理が現実的になりました。Radical Data Scienceの分析によれば、この構造は精度向上だけでなく、学習安定性と推論効率の両立にも寄与しています。

結果として音声認識は「聞いて書き起こす」技術から、「状況を理解し判断する」知覚システムへと変貌しました。医療やロボティクスの現場で、言葉にされない意図まで汲み取れるようになった背景には、ネイティブ・マルチモーダルという設計思想そのものの進化があります。

2026年の音声認識精度とWER最新ベンチマーク

2026年の音声認識分野で最も象徴的な進化指標が、WER(Word Error Rate:単語誤り率)の急激な低下です。**WERは音声認識の品質を定量的に測る国際的な標準指標**であり、数値が低いほど人間の聞き取りに近い精度を意味します。長年「5%の壁」が実用上の限界とされてきましたが、2026年はこの前提が完全に塗り替えられました。

ElevenLabsが発表したScribe v2は、日本語音声においてWER 3.1%〜4.2%を記録しています。これは100語中の誤認識がわずか3〜4語に留まる水準であり、専門家の間では「人手による確認が不要な領域に入った」と評価されています。音声認識研究の指標設計にも関わってきた学術コミュニティにおいても、この数値は歴史的なブレークスルーとして受け止められています。

| モデル | 日本語WER(2026年) | 技術的特徴 |

|---|---|---|

| Scribe v2(ElevenLabs) | 3.1%〜4.2% | 書き起こし特化・最高精度 |

| GPT-5(OpenAI) | 約4.8% | ネイティブ・マルチモーダル |

| GPT-4o | 5.3% | リアルタイム対話性能 |

| Gemini 2.5 Pro | 5.6% | 技術用語・専門領域に強み |

注目すべき点は、**精度向上の要因が単なるデータ量の増加ではないこと**です。2026年の上位モデルは、音声のみを処理する従来型ASRではなく、ネイティブ・マルチモーダル設計を採用しています。音響特徴、言語的文脈、話者の抑揚や間合いが単一のTransformer内で同時に処理されることで、日本語特有の省略表現や曖昧さに対する耐性が飛躍的に高まりました。

この水準のWERが意味する実務インパクトは極めて大きいです。医療現場では専門用語が連続する診療音声でも誤変換がほぼ発生せず、法律・金融分野では逐語的な議事録の正確性が担保されます。MarketsandMarketsや音声認識研究者の分析によれば、**WERが4%を下回ると人間の平均書記精度と統計的に有意差がなくなる**とされており、2026年はAIがこのラインを明確に超えた初年度と位置づけられます。

また、ベンチマークの評価方法自体も進化しています。静音環境の朗読データだけでなく、雑音環境、感情を伴う発話、複数話者が交錯する自然会話が評価対象に含まれるようになりました。その中で低WERを維持できるモデルのみが「実用最高水準」と認識されています。**2026年のWER最新ベンチマークは、音声認識が研究テーマから社会インフラへ移行したことを数値で証明した年**だと言えるでしょう。

ビッグテックが描く音声AIプラットフォーム戦略

2026年現在、ビッグテック各社は音声AIを単体機能としてではなく、エコシステム全体を束ねるプラットフォームの中核として位置づけています。**音声はキーボードやタップ操作を代替するUIではなく、ユーザー文脈を継続的に取得する“入口”**へと役割が変わりました。背景には、ネイティブ・マルチモーダル化によって音声がテキスト、画像、行動データと同列に扱えるようになった技術的転換があります。

象徴的なのが、GoogleによるGeminiの展開です。Geminiは検索、Android、Workspace、車載OSまで横断的に統合され、音声入力がユーザーIDや行動履歴と結びつくことで、文脈理解の精度を高めています。Alphabetの決算説明資料によれば、音声経由の検索やアシスタント利用は依然として増加傾向にあり、**広告・業務SaaS・デバイス販売を同時に押し上げる“ハブ”**として音声AIが機能していることが示唆されています。

一方、Appleはプライバシーを軸にした独自戦略を描いてきましたが、次世代Siriの高度化では外部モデルとの連携を選択しました。これは、音声AIが単なるオンデバイス機能ではなく、**クラウド規模の学習と推論を前提としたプラットフォーム競争に入った**ことを意味します。AI Businessなどの専門メディアは、この判断を「UX主導企業が性能主導モデルを取り込む転換点」と分析しています。

| 企業 | 音声AIの位置づけ | 主な狙い |

|---|---|---|

| 横断プラットフォームの中核 | 検索・広告・業務利用の統合 | |

| Apple | 体験価値を支える対話レイヤー | エコシステム維持と差別化 |

| OpenAI | 独立した音声対話基盤 | 自社デバイス・API拡張 |

OpenAIはApple提携縮小を受け、音声AIを自前プラットフォームで完結させる方向へ舵を切りました。リアルタイム音声対話や感情を反映した応答は、API利用だけでなく将来的な専用デバイスを視野に入れています。MarketsandMarketsの分析でも、**音声インターフェースを備えたAIデバイス市場は今後高成長が見込まれる**とされています。

この戦略の本質はロックインです。音声で取得した意図が、検索結果、業務文書、スケジュール、購買行動へと連鎖するほど、ユーザーは特定プラットフォームから離れにくくなります。IBMの将来予測が示すように、音声AIは今後アンビエント化し、意識せず使われる存在になります。そのとき主導権を握るのは、最も自然に音声をエコシステムへ溶け込ませた企業だと言えるでしょう。

世界市場と日本市場の成長データから見る可能性

世界市場と日本市場の成長データを俯瞰すると、音声認識技術が一過性のトレンドではなく、長期的に拡大する産業基盤であることが明確に見えてきます。MarketsandMarketsなどの調査によれば、世界の音声認識市場は2024年に約143.9億米ドル規模でしたが、2033年には約975.6億米ドルへと拡大する見通しで、年平均成長率は23.7%という極めて高い水準が示されています。

この成長率は、クラウドやSaaS、モバイルアプリといった既存のIT市場と比較しても突出しており、音声認識が単なる入力手段ではなく、業務プロセス全体を再設計する中核技術として評価され始めていることを意味します。特にグローバルでは、医療、金融、カスタマーサポートに加え、スマートシティや自動運転などリアルタイム性が求められる分野での需要が成長を牽引しています。

一方、日本市場も規模こそ世界全体より小さいものの、成長の質において独自の強みを持っています。Market Research Futureの分析では、日本の音声分析市場は2024年に約1.36億米ドル、2035年には約8.07億米ドルに達すると予測され、年平均成長率は17.54%と安定した拡大が見込まれています。

| 市場 | 直近市場規模 | 将来予測 | CAGR |

|---|---|---|---|

| 世界 | 143.9億米ドル(2024年) | 975.6億米ドル(2033年) | 23.7% |

| 日本 | 1.36億米ドル(2024年) | 8.07億米ドル(2035年) | 17.54% |

日本市場の特徴は、急拡大よりも社会課題と密接に結びついた実装型の成長にあります。労働人口の減少、医療・介護現場の逼迫、コンタクトセンターの高度化といった構造的課題に対し、音声認識AIが「コスト削減ツール」ではなく「社会インフラ」として導入されている点が、海外市場との大きな違いです。

さらに、日本語という高文脈言語に対応するための研究投資や、産総研による基盤モデル公開など、公的機関と民間が連動したエコシステム形成も進んでいます。これにより日本市場は、単なる海外技術の受け皿ではなく、高精度・高信頼性を武器に世界へ展開できる実験場としての価値を高めています。

世界的な爆発的成長と、日本独自の持続的かつ実装志向の成長。この二つのデータを重ね合わせることで、音声認識技術が今後も投資・研究・事業開発の中心に位置し続ける可能性は極めて高いと言えるでしょう。

日本の医療・コールセンターで進む社会実装

日本では音声認識AIが研究や実証の段階を完全に終え、医療とコールセンターという社会インフラの中核領域で本格的に使われ始めています。背景にあるのは、日本語における認識精度の劇的な向上と、現場業務に直結する設計思想への転換です。単なる文字起こしではなく、業務そのものを再設計する技術として受け入れられています。

医療分野では、医師や看護師の負担軽減が最大の導入目的です。厚生労働省が進める医師の働き方改革により、診療時間外の事務作業削減が急務となりました。大学病院を中心に、診察中の会話をリアルタイムで解析し、SOAP形式に整理したカルテ下書きを自動生成する仕組みが広がっています。医療ITニュースの報告によれば、紹介状や退院サマリの作成時間が70〜90%削減された事例も確認されています。

| 活用領域 | 導入効果 | 現場での変化 |

|---|---|---|

| 外来診療 | カルテ入力時間を大幅短縮 | 患者と向き合う時間が増加 |

| 紹介状作成 | 作成時間を90%以上削減 | 医師の残業時間が減少 |

| 看護記録 | 記録漏れ・転記ミスを抑制 | 夜勤帯の負担軽減 |

この実装を支えているのが、ElevenLabsのScribe v2やGPT-5世代のネイティブ・マルチモーダル音声モデルです。日本語WERが5%を下回ったことで、専門用語や略語が頻出する医療現場でも、人手による修正を前提としない運用が可能になりました。産業技術総合研究所が公開した「いざなみ」「くしなだ」といった日本語音声基盤モデルの存在も、国内医療機関が安心して導入できる要因となっています。

一方、コールセンターでは社会課題への対応が実装を加速させています。人手不足に加え、近年深刻化しているカスタマーハラスメント対策です。株式会社RevCommのMiiTelに代表される音声解析AIは、通話内容の文字起こしだけでなく、声の大きさや抑揚、沈黙の長さから感情状態をリアルタイムで解析します。東京大学との共同研究による威圧的音声検知技術など、オペレーターを守るためのAI活用が日本独自の進化として注目されています。

総務省の情報通信白書でも、通話の自動記録と感情分析はコンプライアンス強化と従業員保護の両立に資すると指摘されています。実際に現場では、AIが注意喚起を行うことで、対応の属人化が減り、精神的負荷の高い通話を管理職が即座に把握できる体制が整いつつあります。

このように、日本の現場で進む社会実装は、精度競争の先にある「使われ続けるAI」を実現し始めています。業務フロー、制度、倫理への配慮を含めて設計された音声認識AIは、すでに社会インフラの一部として静かに定着しつつあります。

感情認識AIがもたらすユーザー体験の変化

感情認識AIの進化は、ユーザー体験を「便利」から「理解されている」段階へと押し上げています。音声の内容だけでなく、声の抑揚や間、緊張感といった非言語情報を同時に捉えることで、AIは利用者の状態を文脈込みで把握できるようになりました。これにより、ユーザーは操作を意識せず、自然な対話の中でサービスを受けられるようになっています。

この変化を象徴するのが、コンタクトセンターにおける体験の質的転換です。東京大学との共同研究を含む日本国内の実装事例では、感情認識AIが通話中の苛立ちや不安をリアルタイムで検知し、対応トーンや説明量を自動調整しています。顧客が怒りを言語化する前にケアが入るため、クレームの長期化を防ぎ、結果として顧客満足度とオペレーターの心理的負荷の双方を改善しています。

医療分野でも体験は大きく変わりました。産総研の日本語音声基盤モデル「くしなだ」は、感情認識タスクで約84.8%の正解率を示しており、高齢者や子どもの声に含まれる不安や戸惑いを高精度に捉えます。診察時の声色から患者の理解度を推定し、説明を補足する仕組みは、厚生労働省が推進する医療DXの文脈でも注目されています。患者自身が気づいていない不安をAIが補足する体験は、従来の問診では実現が難しかった価値です。

| 利用シーン | 従来の体験 | 感情認識AI導入後 |

|---|---|---|

| カスタマーサポート | 発話内容中心の画一対応 | 感情に応じた即時トーン調整 |

| 医療現場 | 自己申告に依存 | 声色から不安や理解度を推定 |

| 音声アシスタント | 指示待ち型 | 心理状態を踏まえた提案型 |

音声アシスタントの体験も変容しています。GoogleやOpenAIが採用するネイティブ・マルチモーダル設計では、感情認識が対話制御に組み込まれ、ユーザーが疲れていると判断されれば応答速度を落とし、簡潔な返答に切り替わります。IBMの将来予測でも、人とAIの関係は操作から共生へ移行するとされており、感情理解はその中核要素と位置づけられています。

重要なのは、感情認識AIがユーザー体験を一律に最適化するのではなく、個人差を尊重し始めている点です。メタ学習を用いたパーソナライズ型SERの研究では、少量のデータから「その人にとっての怒りや不安」を学習できることが示されています。同じ言葉でも人によって意味が異なるという前提に立つことで、AIは初めて真に寄り添う存在となり、ユーザー体験は次の段階へ進化しています。

ディープフェイクと音声セキュリティの最前線

音声生成AIの精度が人間と区別できない水準に到達したことで、ディープフェイク音声は現実的かつ深刻なセキュリティリスクとなっています。特に2025年以降、実在の経営者や家族の声を模倣したボイスクローニング詐欺が世界的に急増し、音声というメディアそのものへの信頼が揺らぎ始めました。

もはや「本人の声だから信用できる」という前提は成立しません。この認識転換こそが、2026年時点の音声セキュリティの出発点です。

総務省の情報通信白書でも、生成音声によるなりすましが金融・行政・報道分野に与える影響は極めて大きいと指摘されています。これを受け、日本では2025年から官民連携によるフェイク音声検知プロジェクトが本格化しました。NABLASなどが参画する実証事業では、発話の周波数揺らぎや位相ノイズといった、人間が知覚できない特徴量を用いた検知モデルが研究されています。

一方で、MITやスタンフォード大学の研究者が示しているように、生成モデルと検知モデルの性能は相互に進化し続けます。そのため専門家の間では、検知精度の向上だけに依存する戦略は危険だという見解が主流になりつつあります。

| 脅威の種類 | 具体例 | 現在の対策アプローチ |

|---|---|---|

| ボイスクローニング詐欺 | CEOや親族を装った電話指示 | 多要素認証と音声指示の業務フロー分離 |

| 政治・報道の偽音声 | 発言捏造による世論操作 | プラットフォームでの迅速な検知・削除義務 |

| 内部不正誘発 | 上司の声による権限乱用 | ゼロトラスト前提の承認プロセス |

米国では2026年に施行されたTAKE IT DOWN Actにより、ディープフェイク音声・動画への対応がプラットフォーム事業者の法的義務となりました。EUや日本企業も越境取引の中で同等の対応を求められ、音声セキュリティは法務・IT・広報を横断する経営課題へと格上げされています。

最前線の考え方は「完全に見抜く」ではなく「騙されても被害を出さない」設計です。具体的には、音声による指示を単独で成立させない業務設計や、従業員への継続的な教育が重視されています。

AIが声を自由に再現できる時代において、信頼を担保するのは技術だけではありません。プロセスと人の認知を含めた多層防御こそが、ディープフェイクと音声セキュリティの最前線と言えるでしょう。

2030年に向けた音声認識AIの未来像

2030年に向けた音声認識AIの未来像は、精度競争の延長線上にはありません。**音声は「入力手段」から「環境そのもの」へと変質し、人間の意図や状態を先読みする存在になる**と考えられています。IBMが示すAIの将来像によれば、マルチモーダルAIは2030年前後に人間の行動や状況を継続的に理解する段階へ到達するとされ、音声認識はその中心的役割を担います。

最大の変化は、音声が単独で処理されなくなる点です。ネイティブ・マルチモーダル化が進んだ結果、発話内容だけでなく、話者の視線、表情、周囲の環境音、さらには位置情報や生体センサーのデータまでが同時に解釈されます。**「何を言ったか」よりも「なぜ今それを言ったのか」まで理解する音声AI**が、2030年の標準像です。

この進化はインターフェースの概念を根底から変えます。MarketsandMarketsの市場分析でも示されている通り、音声AIはスマートフォンやPCに閉じず、自動車、住宅、工場、医療機器へと溶け込みます。ユーザーが意識的に話しかけなくても、状況に応じて必要な情報や支援を提示する「アンビエント音声認識」が主流になります。

| 観点 | 2026年時点 | 2030年想定 |

|---|---|---|

| 役割 | 高精度な音声入力 | 状況理解と意思決定支援 |

| 処理単位 | 発話単位 | 行動・文脈単位 |

| 統合モダリティ | 音声+テキスト中心 | 視覚・感情・環境データを同時処理 |

特に注目すべきは「予測的音声認識」です。過去の会話履歴や行動パターンを学習したAIが、次に必要となる情報や操作を音声で提案します。たとえば医療現場では、医師の発話を待たずに検査結果や注意点を先回りして提示し、移動中の車内ではドライバーの声の緊張度から危険を察知する仕組みが現実味を帯びています。

一方で、2030年の音声認識AIは「万能な耳」ではなく、制御された存在であることが前提になります。総務省や国際的な規制動向が示すように、常時音声取得への懸念は強く、**オンデバイス処理や必要時のみの認識、利用目的の明確化**が技術要件として組み込まれます。利便性と信頼性を両立できるかが、普及の分水嶺です。

2030年の社会では、音声認識AIは目立つ存在ではなくなります。しかし、人間の判断や行動の裏側で静かに支え続けるインフラとして機能します。**話すことが操作である時代は終わり、声は人とAIが自然に共存するための媒介へと進化する**。それが2030年に向けた音声認識AIの現実的な未来像です。

参考文献

- Radical Data Science:AI News Briefs BULLETIN BOARD for January 2026

- MarketsandMarkets:Speech and Voice Recognition Market Size, Share & Trends

- note:【衝撃】ElevenLabs Scribe v2発表!日本語WER 3.1%達成

- Ledge.ai:日本語音声に特化した基盤モデル「いざなみ」「くしなだ」を産総研が公開

- AI Business:Apple to Overhaul AI Efforts, Siri With Google Gemini

- 総務省:令和6年版 情報通信白書|偽・誤情報の流通・拡散等の課題及び対策