生成AIの進化に驚いた経験がある方なら、次に何が起こるのか気になっているのではないでしょうか。

2026年現在、その答えの中心にあるのが「強化学習」です。強化学習はもはやゲーム攻略や研究用途にとどまらず、AIが自ら考え、試し、修正しながら成長するための中核技術として位置づけられています。

推論に特化した最新AIモデル、人型ロボットの量産化、創薬や材料開発の加速など、注目分野の多くで強化学習が決定的な役割を果たしています。特に推論時間を活用する新しい設計思想や、自己プレイによる知能の自己増幅は、これまでのAI像を大きく塗り替えました。

本記事では、AIに関心のある方に向けて、2026年時点で起きている強化学習のパラダイムシフトを整理し、技術・産業・社会への影響をわかりやすく俯瞰します。強化学習を理解することは、次世代AIの本質を理解する近道になります。

強化学習が「AIの中核知能」へと進化した理由

強化学習が「AIの中核知能」と呼ばれるようになった最大の理由は、知能の役割が「予測」から「意思決定」へと本質的に移行した点にあります。従来の深層学習は、大量データから正解らしい出力を推定することに優れていましたが、環境と相互作用しながら自ら試行錯誤し、最適な行動系列を構築する能力には限界がありました。

2025年以降、この前提を覆したのが強化学習のスケーリングと設計思想の変化です。NeurIPS 2025で最優秀論文賞を受賞した自己教師あり強化学習の研究によれば、報酬に依存せず、エージェント自身が目標を生成する学習によって、1000層規模の深層ネットワークでも安定的に性能が向上することが示されました。これは「強化学習は浅いモデルにしか適用できない」という長年の通説を否定する結果です。

この進化により、強化学習は単なる制御アルゴリズムではなく、長期的な計画立案、抽象的な目標設定、戦略の切り替えといった知的機能を担うようになりました。OpenAIの研究公開でも、推論型モデルにおいて強化学習が思考の連鎖を最適化し、誤りを自己修正する能力を獲得させていると説明されています。

| 観点 | 従来のAI | 強化学習中心のAI |

|---|---|---|

| 知能の役割 | 入力から出力を予測 | 状況に応じて行動を選択 |

| 時間軸 | 単発の応答 | 長期的な意思決定 |

| 学習源 | 静的データ | 環境との相互作用 |

さらに決定的だったのが、検証可能な報酬を用いた強化学習の普及です。数式の正誤やコードの実行結果といった客観的な評価を報酬に組み込むことで、モデルは論理的一貫性を保ちながら粘り強く思考する能力を身につけました。この仕組みは、数学やプログラミングといった高精度領域で、人間を上回る性能が報告され始めている背景でもあります。

このように強化学習は、「何を知っているか」ではなく「どう考え、どう行動するか」を司る層としてAIの中心に据えられました。予測モデルの上に意思決定エンジンを載せるのではなく、意思決定そのものが学習の主役になったことこそが、強化学習が中核知能へと進化した本質的な理由です。

EvoRLに代表されるハイブリッド強化学習の台頭

近年の強化学習の進化を語るうえで欠かせないのが、EvoRLに代表されるハイブリッド強化学習の台頭です。これは、勾配に基づく従来型の強化学習と、進化的アルゴリズムを組み合わせることで、長年ボトルネックとされてきた問題を同時に解消しようとするアプローチです。**2026年現在、この融合は研究段階を超え、実運用レベルで成果を出し始めています。**

従来の強化学習は、報酬設計の巧拙や初期パラメータへの感度が極めて高く、探索が局所最適に閉じ込められるリスクを常に抱えていました。一方、進化的アルゴリズムは勾配を必要とせず、多様な解候補を同時に探索できる反面、サンプル効率の低さが弱点でした。EvoRLはこの両者を統合し、進化的探索で大域的な構造を掴みつつ、強化学習で精緻な最適化を行うという役割分担を実現しています。

MDPIに掲載された包括的レビューによれば、EvoRLは特に「報酬が希薄、あるいは遅延する環境」において顕著な優位性を示しています。ロボットが長時間の試行錯誤を経て初めて成功報酬を得るような設定では、勾配情報だけに頼る手法は学習が進みません。**進化的アルゴリズムがポリシー全体を変異・選択によって探索することで、有望な行動系列を先に見つけ出せる点が決定的な差となります。**

| 観点 | 従来型RL | EvoRL |

|---|---|---|

| 探索方法 | 勾配ベース | 進化的探索+勾配最適化 |

| 希薄報酬への耐性 | 低い | 高い |

| パラメータ感度 | 高い | 低減される |

産業分野でのインパクトも見逃せません。大規模な生産ラインや物流倉庫では、環境が非定常でノイズも多く、シミュレーションと現実の乖離が問題になります。EvoRLは、シミュレーション上で進化的に多様な戦略を生成し、その中から現実環境に適応しやすいポリシーを強化学習で磨き込むため、現実移行時の性能劣化が小さいと報告されています。**この特性が、実世界RLの実装を一段階引き上げました。**

研究コミュニティでも評価は高く、NeurIPSを中心にEvoRL系手法の採択数は増加傾向にあります。特に注目されているのは、進化的アルゴリズムを単なる初期化手段ではなく、学習ループの中に恒常的に組み込む設計です。これにより、学習途中でも大胆な戦略転換が可能となり、環境変化への追従性が飛躍的に向上します。

ハイブリッド強化学習の本質的な価値は、「壊れにくい知能」を実現する点にあります。単一の最適解に収束するのではなく、多様な解の分布を維持しながら性能を高めるため、未知の状況でも致命的な失敗を避けやすいのです。**EvoRLは、強化学習を実験室の技術から、社会インフラを支える技術へと押し上げる重要な転換点になりつつあります。**

1000層時代に突入した自己教師あり強化学習

2025年から2026年にかけて、自己教師あり強化学習は大きな転換点を迎えました。最大の変化は、ネットワークの「深さ」に対する常識が完全に覆されたことです。従来、強化学習では報酬信号の不安定さから、数層程度の浅いネットワークが限界とされてきました。しかしこの制約は、自己教師あり学習と対照的強化学習を組み合わせることで根本から再定義されました。

この潮流を決定づけたのが、NeurIPS 2025で最優秀論文賞を受賞した研究です。同論文では、自己教師あり強化学習においてネットワーク深度を1024層まで拡張しても学習が破綻せず、むしろ性能が一貫して向上することが示されました。強化学習でも深層化すればスケーリング則が成立するという発見は、深層学習以来のパラダイムシフトだと評価されています。

| 観点 | 従来の強化学習 | 1000層自己教師あり強化学習 |

|---|---|---|

| ネットワーク深度 | 2〜5層 | 最大1024層 |

| 学習信号 | 外部報酬が必須 | 自己生成目標と対照信号 |

| 行動の性質 | 局所最適に収束 | 抽象的目標の創発 |

特に重要なのは、この深層化が単なる精度向上に留まらない点です。報酬もデモンストレーションも与えられない環境で、エージェントは自ら目標を設定し、その達成過程を内部表現として積み重ねていきます。層が深くなるほど、短期行動ではなく長期的な戦略や階層的な意思決定が自然に形成されることが、実験結果から確認されています。

また、研究ではバッチサイズのスケーリングが学習安定性の鍵であることも示されました。層数を増やすだけではなく、同時に処理する経験の量を指数的に拡大することで、勾配ノイズが抑制され、1000層規模でも意味のある表現が維持されます。これはGoogle DeepMindやOpenAIなどの研究者が指摘してきた「計算資源配分の再設計」という思想とも一致します。

この結果、自己教師あり強化学習は「浅く不安定な最適化手法」から、「深層表現を内包する汎用的な知能形成エンジン」へと進化しました。1000層時代の到来は、強化学習が言語・行動・推論を統合する基盤技術へ変貌したことを示しています。AIが自律的に学び続ける未来は、すでに理論段階を超え、実証フェーズに入っています。

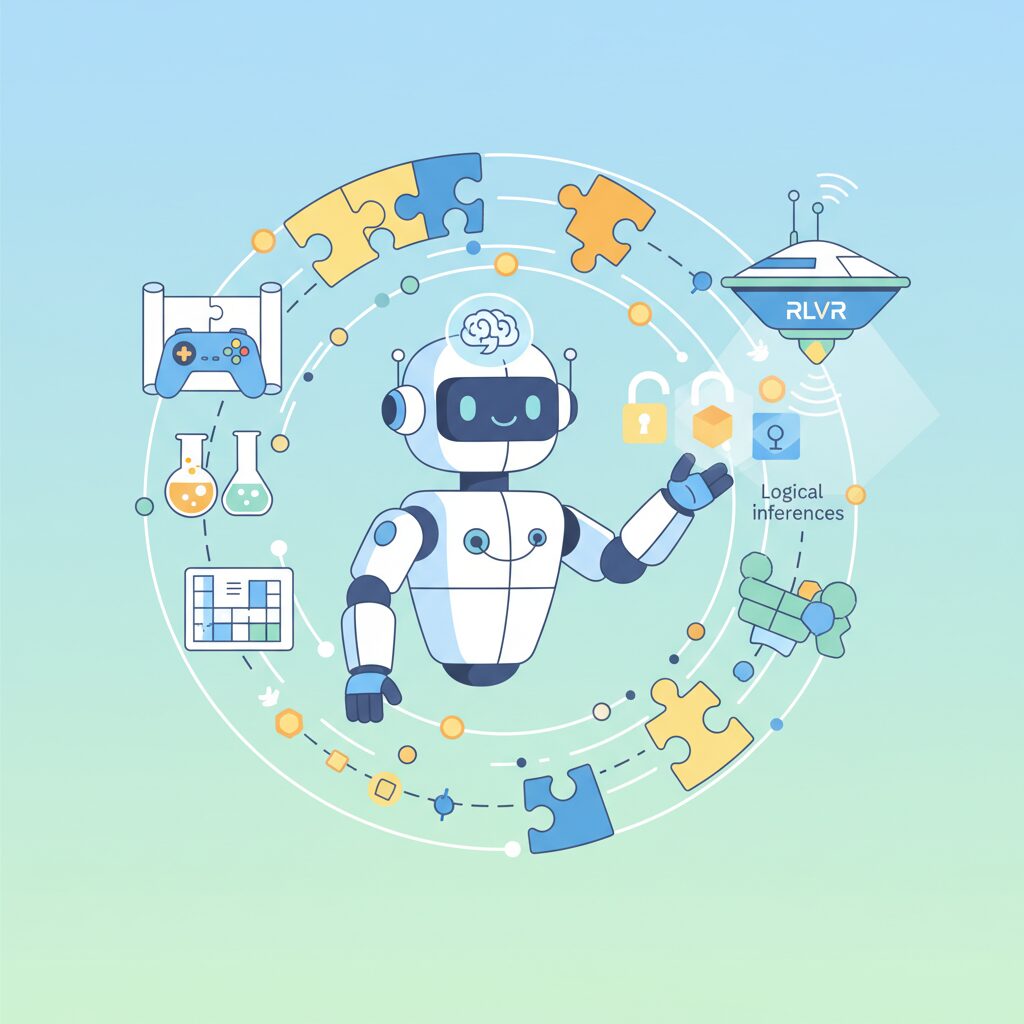

検証可能な報酬(RLVR)が切り拓いた論理推論AI

検証可能な報酬(Reinforcement Learning with Verifiable Rewards, RLVR)は、強化学習を論理推論の中核技術へと押し上げた決定的なブレイクスルーです。従来の言語モデルは、人間が用意した正解例や評価基準に強く依存していましたが、RLVRでは数式の正誤やコードの実行結果といった客観的に検証できる結果そのものが報酬として機能します。

この仕組みによって、モデルは「それらしく答える」ことではなく、「正しい解に到達するまで考え続ける」行動を学習します。NeurIPS 2025で注目を集めた一連の研究によれば、RLVRを導入した大規模言語モデルは、数学証明やアルゴリズム設計といった厳密な論理領域で、事前学習モデルを大きく上回る性能を示しました。

| 観点 | 従来の報酬設計 | RLVR |

|---|---|---|

| 評価方法 | 人手評価・類似度 | 実行結果・正誤判定 |

| 推論の性質 | 模倣的 | 探索的・反復的 |

| エラー耐性 | 低い | 自己修正可能 |

特に重要なのは、RLVRがモデルに思考の粘り強さを内在化させた点です。OpenAIの研究チームによれば、RLVR訓練を受けたモデルは、一度で解けない問題に直面した際、誤りを検出し、戦略を切り替え、再挑戦する確率が大幅に向上しました。これは人間の問題解決プロセスに極めて近い挙動です。

実例として、競技プログラミングや数学オリンピック級の問題では、RLVRを組み込んだ推論型モデルが、単純な正答率だけでなく、途中過程の一貫性や再現性でも高い評価を得ています。GPQAのような専門家向け科学ベンチマークでも、博士レベルを超える結果が報告され始めています。

このようにRLVRは、強化学習を「行動最適化の技術」から「論理推論を自己獲得する技術」へと進化させました。検証可能性という厳しい制約があるからこそ、モデルは幻想的な回答から脱却し、計算と論理に裏打ちされた知能へと近づいているのです。

推論型モデルとテストタイム計算のインパクト

推論型モデルの登場は、AIの性能向上を「学習時」だけでなく「考える瞬間」にまで拡張した点で、決定的なインパクトをもたらしました。その中核にあるのが、推論時間計算(Test-Time Compute)という新しいスケーリング軸です。これは、モデルが回答を出すまでに使う計算量、すなわち思考の深さや試行回数を意図的に増やすことで、精度や論理性を高めるアプローチです。

OpenAIが公開した研究によれば、o1やo3といった推論型モデルは、強化学習を通じて「どこで考え直すべきか」「別の戦略に切り替えるべきか」を自己判断できるよう訓練されています。その結果、単一パスで即答する従来モデルとは異なり、複数の思考経路を内部で評価し、最も妥当な結論を選択します。これは人間の熟考に近い振る舞いであり、計算資源を知能に変換する設計思想と言えます。

この違いは、数学や科学推論のベンチマークに明確に表れています。AIME 2024では、従来型モデルが一桁台から十数パーセントに留まる一方、推論型モデルは80%を超える正答率を記録しました。GPQAのような博士課程レベルの難問でも、推論時間を十分に与えたモデルが専門家平均を上回る結果を示しています。

| 観点 | 従来型モデル | 推論型モデル |

|---|---|---|

| 回答生成 | 単一パスで即時生成 | 複数ステップで熟考 |

| 計算資源の使い方 | 学習時に集中 | 学習時+推論時 |

| 難問への対応 | 精度が急落 | 思考時間増加で改善 |

特に注目すべきは、推論時間計算が「可変」である点です。簡単な質問には即答し、難問では計算を追加投入するという動的制御が可能になりました。これは、固定性能のモデルを使い回すのではなく、タスクの難易度に応じて知能を伸縮させるという発想の転換です。OpenAIの解説でも、この柔軟性こそが実運用でのコスト効率と性能を両立させる鍵だと示されています。

さらに、推論型モデルは自己プレイ型の強化学習と結びつくことで、より強力な進化ループを形成します。自ら生成した複数の解答案を評価し、最良の思考経路を次回に活かすため、推論時間を使えば使うほど、思考の質そのものが洗練されていきます。この特性は、研究開発、プログラミング、戦略立案といった高度知的労働において、人間のパートナーとしてのAIの価値を一段引き上げています。

自己プレイが生み出す知能のフライホイール効果

自己プレイが生み出す最大の価値は、知能が一度きりの学習で終わらず、自らを教師として回転し続けるフライホイール構造を獲得した点にあります。チェスや囲碁で知られる自己プレイ型強化学習は、2026年には言語モデルや推論モデルへ本格的に拡張され、人間のデータ供給を前提としない知能進化の中核となっています。

近年の研究によれば、言語モデルが自己生成した複数の解答候補を相互に評価し、論理的一貫性や検証可能性の高いものに報酬を与えることで、推論能力が大幅に向上することが示されています。The Decoderが報じた分析では、自己プレイを組み込んだモデルは、人間の教師データが乏しい数学的推論や複雑な計画問題においても、性能低下を起こしにくいことが確認されています。

このフライホイール効果が決定的なのは、スケールすべき対象が「データ量」ではなく「知能そのもの」に変わった点です。OpenAIの推論型モデルoシリーズでは、強化学習と自己プレイのループが事前学習に匹敵する規模で回されており、モデルは自ら難易度の高い問題空間を切り拓いていきます。Sam Altmanらが指摘するように、これは知能が直線的ではなく加速度的に伸びる条件を満たしています。

| 観点 | 人間依存型学習 | 自己プレイ型学習 |

|---|---|---|

| 知識供給源 | 人間の教師データ | モデル自身の生成解 |

| 成長速度 | 線形的 | 加速度的 |

| 未知領域対応 | 弱い | 強い |

80000 Hoursの分析が示す通り、この自己改善ループは科学的定理の形成や未解決問題への挑戦といった、人間の介在が難しい領域で特に威力を発揮しています。自己プレイは単なる学習手法ではなく、知能が自己増殖するための構造そのものであり、2026年以降のAI進化を規定する最重要メカニズムとなっています。

フィジカルAIと人型ロボットを動かす現実世界RL

フィジカルAIの核心にあるのが、現実世界RLによって人型ロボットを直接学習させるという発想です。シミュレーション中心だった従来のロボット学習は、現場とのギャップ、いわゆるリアリティギャップに長年悩まされてきました。2026年現在、その前提は大きく覆されています。

象徴的な事例が、中国AGIBOTの量産型人型ロボットです。Omdiaによれば、2025年の世界出荷台数約13,000台のうち、同社は5,100台超を出荷し世界シェア39%を獲得しました。この急成長を支えたのが、生産ラインに直接組み込まれた現実世界RLです。

AGIBOTのロボットは、事前に完全な動作モデルを与えられるのではなく、実際の工場内で部品のズレ、摩耗、照明変化といった不確実性を報酬信号として学習します。これにより、環境が変わっても再調整なしで適応する能力が獲得されています。

| 学習アプローチ | 主な特徴 | 現場適応力 |

|---|---|---|

| シミュレーションRL | 高速学習・安全 | 限定的 |

| 現実世界RL | 実環境で直接学習 | 非常に高い |

この潮流は中国だけではありません。Figure AIの「Figure 02」はOpenAIと提携し、BMWの実工場で組み立て作業を学習しています。TeslaのOptimusも、自社工場の物流データを使い、FSD由来のソフトウェアとRLを統合しています。いずれも人間がルールを細かく教えない点が共通しています。

さらに進化を加速させているのが、世界モデルと予測数学の融合です。Universal Robotsや現代自動車グループが示すように、ロボットは数ミリ秒先の未来を内部で予測し、その中から最適行動をRLで選択します。Boston Dynamicsの電動Atlasは、56自由度の身体をこの方式で制御しています。

センシング面でも変化は顕著です。RoboSenseによれば、2025年のロボティクス向けLiDAR販売は前年比114%増を記録しました。高精度3Dデータを用いた世界モデルが、現実世界RLの学習効率を劇的に引き上げているのです。

重要なのは、これらが研究室のデモではなく、量産・商用フェーズに入った点です。現実世界RLは、人型ロボットを「プログラムされた機械」から「経験で成長する労働主体」へと変えつつあります。この変化こそが、フィジカルAIが社会インフラになる前兆と言えます。

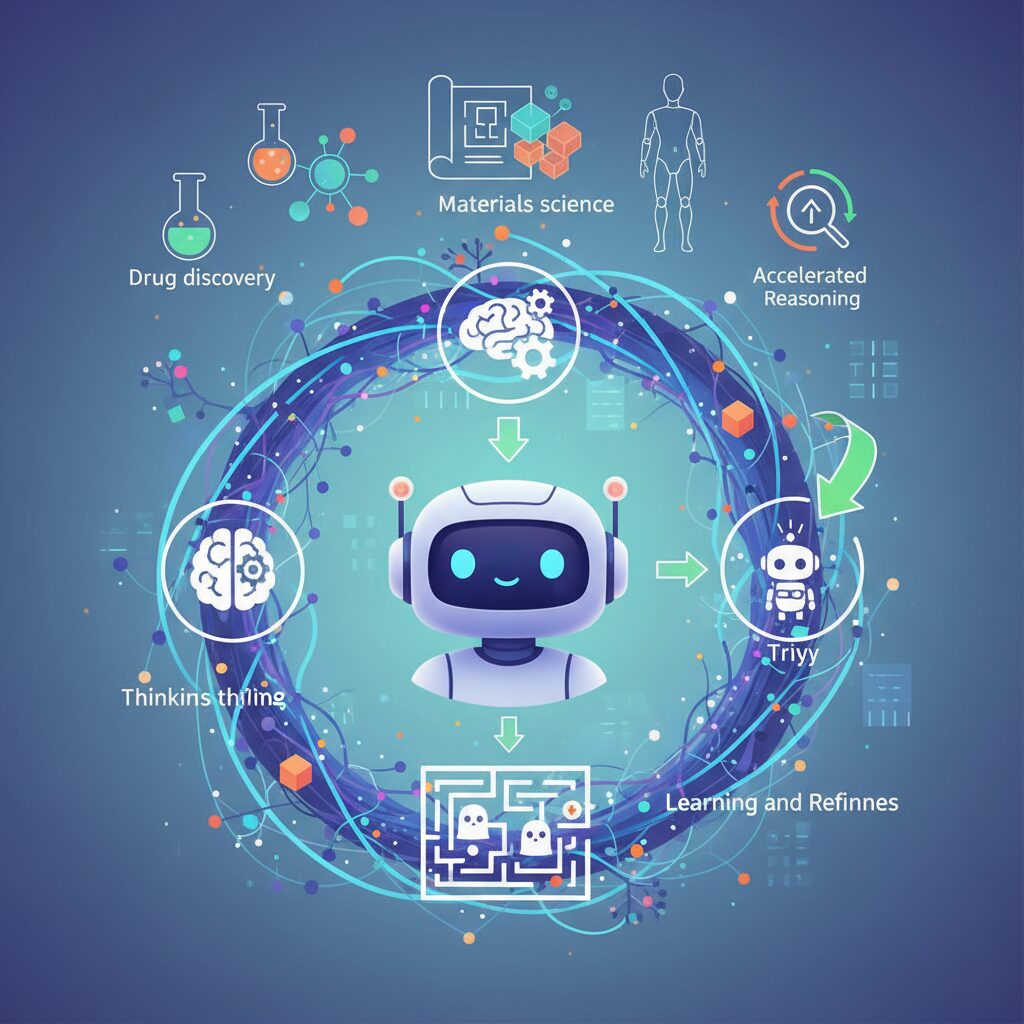

強化学習が加速する科学発見と創薬・材料開発

強化学習は、科学発見のプロセスそのものを変えつつあります。仮説を立て、実験し、失敗から学ぶという反復的な知的活動を、AIが高速かつ自律的に回せるようになったためです。特に創薬や材料開発では、探索空間があまりにも広大で、人間の直感だけでは到達できなかった領域に踏み込めるようになっています。

象徴的な成果が、Google DeepMindとIsomorphic LabsによるAlphaFold 3です。AlphaFold 3は、タンパク質単体にとどまらず、DNA、RNA、低分子リガンド、イオンまで含めた分子間相互作用を統合的に予測します。DeepMindの発表によれば、2025年後半には、50年以上未解明だった巨大タンパク質apoB100の構造解明に成功しました。これは悪玉コレステロールLDLの形成メカニズム理解を一気に進め、心血管疾患の予防薬設計に新たな道筋を示しています。

この背景には、予測精度を最大化する行動を報酬として学習する強化学習の最適化ループがあります。単なる統計的当て推量ではなく、「どの仮説を次に試すべきか」を選び続ける点が、従来の計算化学との決定的な違いです。

| 分野 | 強化学習の役割 | 代表的成果 |

|---|---|---|

| 創薬 | 分子構造探索と結合最適化 | AlphaFold 3によるapoB100構造解明 |

| ゲノム解析 | 変異影響の評価戦略学習 | 疾患関連変異の高精度予測 |

| 材料科学 | 原子配置の適応的探索 | 新規触媒・電池材料の発見短縮 |

材料科学でも変化は劇的です。高次元の化学・構造空間を相手に、強化学習エージェントが次に試すべき組成や結晶構造を選び続けます。包括的レビューによれば、従来は数十年単位だった新材料探索が、数週間から数か月に短縮された事例が報告されています。

日本ではPreferred Networksが開発するMatlantisが代表例です。強化学習的に構築されたニューラルネットワーク電位PFP v7により、原子レベルの挙動を高精度かつ高速に再現できます。これにより、エネルギー貯蔵材料や半導体、持続可能な触媒の設計が現実的な開発スピードで回り始めています。

重要なのは、強化学習が「答えを出すAI」ではなく、「発見の仕方を学ぶAI」を実現している点です。科学者が設計した評価基準のもとで、AIが自ら探索戦略を洗練させていく。この構図こそが、2026年以降の科学と産業の競争力を左右する中核になりつつあります。

日本の産業・政策における強化学習の実装

日本の産業・政策において、強化学習は研究テーマの域を完全に超え、国家競争力を左右する実装技術として扱われ始めています。2025年に成立したAI法を起点に、日本政府は規制と促進を同時に進めるアジャイル型ガバナンスを採用し、強化学習を含む先端AIの社会実装を明確に後押ししています。

内閣府AI戦略本部によれば、製造業、医療、防災、インフラ維持管理といった領域では、従来型のルールベースAIでは対応できない「環境変化への即応性」が求められており、その解として強化学習が位置づけられています。特に日本特有の課題である少子高齢化と熟練人材不足は、強化学習導入の必然性を高めています。

製造業では、強化学習が技能伝承のデジタル化を実現しています。経済産業省と連携する複数の製造現場では、熟練工の操作ログや判断履歴を強化学習エージェントに学習させ、若手作業員向けのリアルタイム支援やロボット制御へと転用しています。東京大学と産総研の共同研究では、この手法により作業習熟までの期間が約40%短縮されたと報告されています。

| 領域 | 強化学習の役割 | 政策・産業的意義 |

|---|---|---|

| 製造業 | 技能最適化・自律制御 | 生産性向上と人材不足対策 |

| 防災 | 避難誘導・ドローン制御 | 被害最小化と即応性強化 |

| インフラ | 劣化予測・保全計画 | 維持コスト削減と安全性向上 |

防災分野でも実装は進んでいます。国土交通省の実証事業では、強化学習を用いた自律型ドローンが、洪水や土砂災害発生時にリアルタイムで最適な避難経路を探索します。シミュレーションと実地訓練を組み合わせた結果、従来の固定シナリオ型誘導と比べ、避難完了までの時間が平均25%以上短縮されたとされています。

産業界では、日本企業ならではの実装哲学も際立っています。ソニーAIのGran Turismo Sophyは、単なる最適行動ではなく人間の成長を促す振る舞いを報酬設計に組み込んでいます。この思想は、強化学習を競争のための技術ではなく、共創のための技術として社会に根付かせる試みと言えます。

また、Preferred Networksは独自AIチップMN-Coreを活用し、強化学習の計算コストを抑えつつ産業応用を加速させています。材料開発や自律移動ロボットへの実装は、計算資源制約が厳しい日本企業にとって現実的なモデルケースとなっています。

政策と産業の両輪が噛み合い始めた現在、日本の強化学習実装は「実験段階」から「社会基盤形成フェーズ」へと移行しています。世界的にも評価の高い日本の現場力と、強化学習による自律最適化が融合することで、日本型AI実装モデルが確立されつつあります。

市場規模・特許データから見る強化学習の経済圏

強化学習の進化は技術論にとどまらず、巨大な経済圏を形成し始めています。2026年の世界の強化学習市場規模は約1,949億ドルと評価され、年平均成長率は65%を超える水準です。Research Nesterによれば、この成長はPoC段階を脱し、推論型モデルやフィジカルAIが実運用フェーズに入ったことが大きな要因とされています。

特に注目すべきは、強化学習が「単体のAI技術」ではなく、クラウド、半導体、ロボティクス、科学研究を巻き込むプラットフォーム経済を生み出している点です。クラウド経由の導入が市場の約63%を占め、大規模企業による投資比率は70%を超えています。これは、強化学習が実験的技術ではなく、企業の中核インフラとして認識され始めた証左です。

| 年度 | 市場規模 | 特徴 |

|---|---|---|

| 2024年 | 61.3億ドル | 生成AI中心、検証実験が主流 |

| 2026年 | 1,949億ドル | 推論型AIと人型ロボットの本格導入 |

| 2035年 | 19.01兆ドル | 完全自律システムの普及予測 |

この経済圏のもう一つの軸が知的財産です。2025年時点で世界のAI特許出願の約70%を中国が占めるとされ、BaiduやTencent、Alibabaが量で圧倒しています。一方、米国は出願数では劣るものの、IBMやGoogle、MicrosoftがOS、推論エンジン、ハードウェア制御といった「知能の基幹部分」を押さえています。質で競争優位を築く戦略です。

欧州ではRocheやBayerが創薬・医療AIの特許で存在感を示し、日本勢もキヤノン、トヨタ、ソニーが製造・モビリティ分野で上位を維持しています。強化学習の特許はアルゴリズム単体ではなく、実装領域と結びついた形で価値を持つため、どの産業と結合するかが企業価値を左右します。

市場規模の爆発的成長と特許の集中は、強化学習が今後の競争力そのものになることを示しています。資本、データ、知財が連動するこの経済圏をどう位置づけるかが、企業や国家のAI戦略の成否を分ける局面に入っています。

頑健性・倫理・環境負荷という2026年の課題

2026年の強化学習は目覚ましい成果を上げる一方で、頑健性・倫理・環境負荷という三つの課題が同時に顕在化しています。技術が社会の意思決定に深く入り込むほど、その失敗コストは指数関数的に増大します。この現実に向き合うことが、研究者や企業にとって避けて通れないテーマになっています。

まず頑健性です。強化学習エージェントは、学習時とわずかに異なる環境条件下で想定外の行動を取ることがあると、多くのレビュー論文が指摘しています。自動運転や医療支援AIでは、センサーのノイズや環境の揺らぎが致命的な判断ミスにつながります。MDPIの体系的レビューによれば、敵対的攻撃に対する脆弱性は依然として未解決であり、EvoRLのようなハイブリッド手法でも完全な保証は得られていません。未知の状況でいかに安全側に倒れるかが、実装段階の最重要指標になっています。

次に倫理と公平性の問題です。強化学習は報酬設計次第で行動が大きく変わるため、設計者の価値観やデータの偏りが結果に直結します。NeurIPSで議論されているアライメント研究では、学習過程の透明性不足が差別的判断を増幅するリスクとして強調されています。さらに2025年以降、各国で進んだ法整備により、強化学習エージェントがどのデータを基に方策を更新したのかを説明できるトレーサビリティが求められています。説明できない最適解は、社会的には受け入れられない段階に入っています。

| 課題領域 | 主なリスク | 2026年の対応動向 |

|---|---|---|

| 頑健性 | 未知環境での暴走 | 安全制約付きRL、シミュレーション多様化 |

| 倫理・公平性 | 偏見の増幅 | アライメント研究、説明可能性の強化 |

| 環境負荷 | 電力消費の増大 | 低電力チップ、計算最適化 |

最後に環境負荷です。大規模強化学習は膨大な計算資源を必要とし、GPUの電力消費はデータセンターのCO2排出と直結します。国際金融誌の技術動向分析では、2026年に向けてニューロモーフィック・コンピューティングや専用AIチップの採用が加速していると報告されています。また、再生可能エネルギーの供給状況に応じて学習ジョブを動的に調整するカーボンアウェア・コンピューティングも実用段階に入りました。性能向上と省エネを同時に達成できるかが、今後の競争力を左右します。

これら三つの課題に共通するのは、単なる技術最適化では解決できない点です。頑健性には安全工学、倫理には法と哲学、環境負荷にはエネルギー政策との連携が不可欠です。強化学習が社会インフラになる2026年、責任ある設計と運用そのものが技術力の一部として評価される時代に入っています。

AGIへの距離を縮める強化学習の未来像

強化学習がAGIへの距離を急速に縮めている最大の理由は、知能を「静的なモデル」ではなく「時間の中で成長するプロセス」として扱える点にあります。2026年現在、強化学習は報酬を最大化する最適化技法を超え、自己改善・自己評価・自己修正を内包した知能循環の中核へと進化しています。

その象徴が、推論時間計算と検証可能な報酬を組み合わせた最新の学習設計です。OpenAIの推論型モデルに代表されるように、モデルは即答するのではなく、思考を展開し、誤りを検知し、戦略を切り替える訓練を強化学習によって受けています。これは人間の問題解決に近い振る舞いであり、単なる知識量の拡張では到達できない領域です。

NeurIPS 2025で注目を集めた自己教師あり強化学習の研究では、1000層を超える深層ネットワークが、外部から目標を与えられない環境でも自律的に課題を生成し、達成する能力を示しました。目標そのものを内部で定義できることは、AGIに不可欠とされる汎用性の条件に直結します。

| 観点 | 従来のAI | 強化学習主導型AI |

|---|---|---|

| 課題設定 | 人間が定義 | モデルが自律生成 |

| 失敗への対応 | 再学習が必要 | 試行錯誤で修正 |

| 知能の成長 | 学習後は固定 | 運用中も進化 |

さらに自己プレイ型強化学習は、知能のフライホイールを形成しています。モデルが自ら生み出した解法を評価し、より優れた推論だけを次の学習に利用する循環により、人間の教師データに依存せず能力が加速的に向上します。80000 HoursやOpenAIの見解でも、この自己改善ループがAGI実現時期を前倒ししている要因として挙げられています。

重要なのは、AGIへの道筋が単一モデルの巨大化ではなく、強化学習による行動・推論・検証の統合に移行した点です。世界モデル、ツール使用、長期計画といった要素が強化学習の枠内で結合されることで、AIは複数領域を横断する知的主体へと近づいています。

Demis Hassabisが指摘するように、物理世界の理解には依然として課題が残りますが、フィジカルAIや現実世界RLの進展はそのギャップを着実に埋めつつあります。強化学習はAGIを一足飛びに完成させる魔法ではありませんが、知能を自己駆動で拡張し続ける唯一現実的なエンジンとして、未来像を明確に描き始めています。

参考文献

- NeurIPS Blog:Announcing the NeurIPS 2025 Best Paper Awards

- OpenAI:Learning to reason with LLMs

- PR Newswire:Omdia Ranks AGIBOT No.1 Worldwide in Humanoid Robot Shipments in 2025

- Google DeepMind / Isomorphic Labs:AlphaFold 3 predicts the structure and interactions of all of life’s molecules

- Research Nester:Reinforcement Learning Market Size & Share, Growth Forecasts 2035

- Preferred Networks:News – Preferred Networks, Inc.