文章を書くAIは、もはや珍しい存在ではなくなりました。チャットボットや自動要約、広告コピー生成など、私たちの日常や仕事の中に自然に溶け込んでいます。

しかし2026年現在、自動テキスト生成技術は「便利なツール」という段階を明確に超え、社会を支えるインフラとして本格的に機能し始めています。AIが自ら考え、検証し、外部ツールと連携しながら業務を遂行する時代に突入したのです。

本記事では、最新の生成AIモデルの技術進化から、日本語に特化した国産LLMの動向、ハルシネーションを抑制する実装技術、さらに広告・出版・報道といった産業への具体的な影響までを俯瞰します。AIに関心のある方が「今、何が起きているのか」「これから何を学ぶべきか」を体系的に理解できる内容をお届けします。

自動テキスト生成技術が「実装フェーズ」に入った理由

自動テキスト生成技術が「実装フェーズ」に入った最大の理由は、もはや試してみる技術ではなく、使わなければ競争力を失う技術へと質的に変化した点にあります。2026年時点での生成AIは、単なる文章作成ツールではなく、業務プロセスそのものに組み込まれ、安定的に価値を生み出す前提条件を満たしました。

この転換を決定づけたのが、推論能力と信頼性の飛躍的向上です。OpenAIやGoogleなどの最先端モデルは、多段階推論を内部で自律的に検証する設計を取り入れています。松尾豊教授がディープラーニング協会の年頭所感で述べているように、AIは性能競争の段階を終え、「社会の中でどう使われるか」が主戦場になりました。これは、誤情報を前提に人がチェックする実験環境では成立しません。

特にRAGと自律的ファクトチェックの組み合わせは、実装を阻んでいた最大の壁を取り払いました。KDDI総合研究所のAIエージェントは、顧客対応で約90%の回答精度を実現し、応対時間を70%削減しています。この数値は、PoCではなく本番運用で成果が出ている点に意味があります。生成結果が業務KPIに直結する段階に入ったのです。

さらに、計算資源とアルゴリズムの進化により、長大な文書や社内ナレッジを一括で扱えるようになりました。数千ページ規模の契約書やマニュアルを前提知識として読み込んだ上で回答できることは、人間の補助ではなく、実務の代替を可能にします。これが「AIに聞く」から「AIに任せる」への転換を生みました。

| 観点 | 実験段階 | 実装フェーズ |

|---|---|---|

| 信頼性 | 人による常時確認が必要 | 自律検証により業務委任可能 |

| 役割 | 文章生成の補助 | 業務プロセスの一部 |

| 成果指標 | デモの完成度 | 時間削減・精度向上 |

日本国内でも、国産LLMの定着が実装を後押ししています。日本語の語感や業界特有の判断基準を学習したモデルは、現場でそのまま使える水準にあります。これは「試しに使うAI」から「組み込むAI」への決定的な違いです。

こうして2026年、自動テキスト生成技術は技術的成熟、社会的信頼、経済的成果の三点が揃い、実装フェーズに入ったと言えます。導入するかどうかを議論する段階は終わり、どう組み込むかが問われる局面に移行しました。

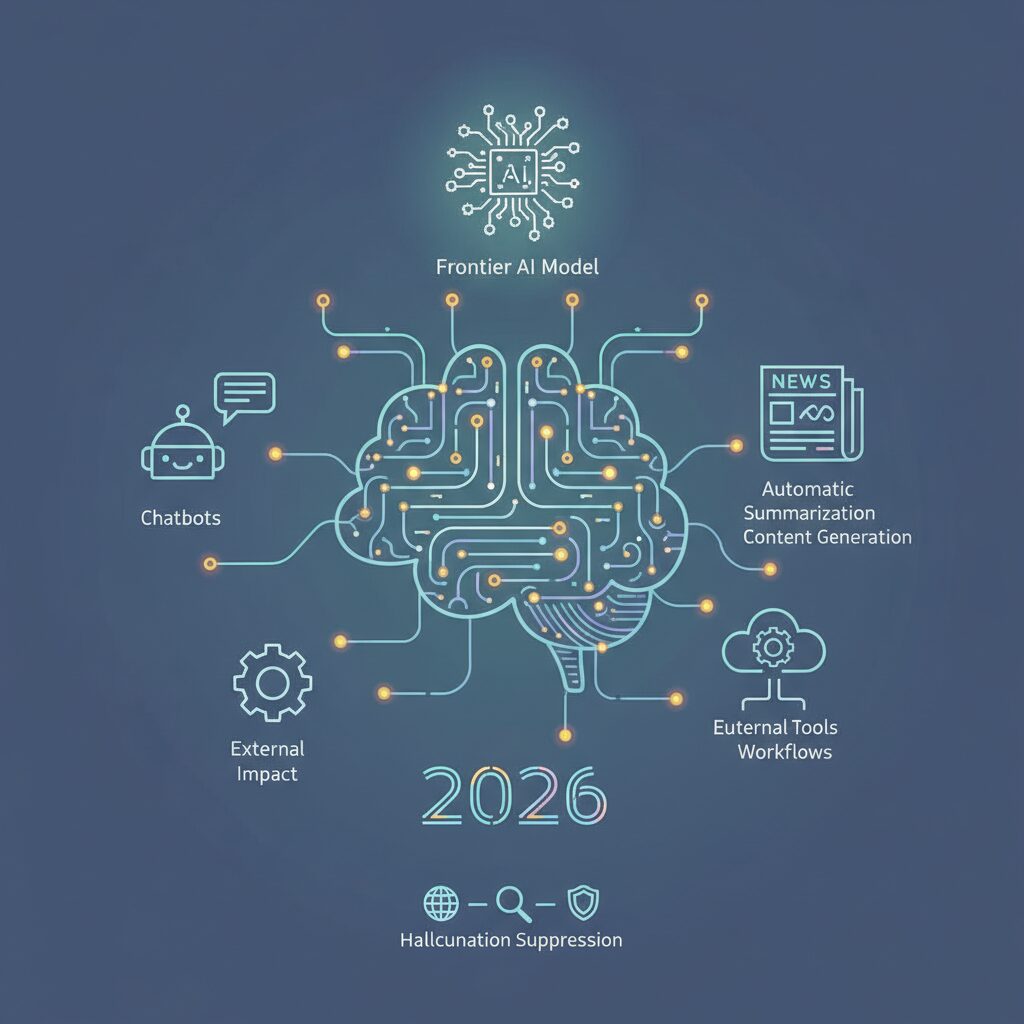

2026年の主役となるフロンティアAIモデルの全体像

2026年におけるフロンティアAIモデルは、単なる性能競争の段階を越え、社会インフラとしての完成度が問われるフェーズに入っています。OpenAIのGPT-5、AnthropicのClaude 4、GoogleのGemini 2.5/3、MetaのLlama 4といった最先端モデルは、いずれも「人間の専門家にどこまで近づいたか」ではなく、「どれだけ安全かつ確実に任務を遂行できるか」が評価軸になっています。

特に大きな転換点となったのが、多段階推論とマルチモーダルの統合です。テキスト、画像、音声、動画を横断して理解し、長時間にわたる推論を内部で完結できる設計が標準化しました。スタンフォード大学やMITが関与する公開ベンチマークでも、大学院レベルの科学推論や高度数学において、人間の上位層に匹敵する正答率が報告されています。

| モデル | 特徴的な進化 | 注目ポイント |

|---|---|---|

| GPT-5 | 動的ルーティング推論 | ハルシネーション大幅低減 |

| Claude 4 | 安全性重視の設計 | 長文理解と倫理制御 |

| Gemini | 超長文・高速処理 | 業務統合力の高さ |

中でも注目されるのが、GPT-5に代表される推論深度の自動制御です。質問の難易度に応じて計算資源を切り替える仕組みにより、高速応答と論理的厳密性を両立しました。OpenAIの技術レポートによれば、この仕組みは従来世代と比べ誤情報生成を最大80%抑制しています。

また、Llama 4 Scoutが実現した1,000万トークン級のコンテキスト処理は、AIの役割を決定的に変えました。数千ページの契約書や巨大なコードベースを一括で理解し、要点抽出から改善提案まで行う能力は、すでに法務や開発現場で実運用されています。Google Researchも「AIは回答者ではなく実行主体になった」と指摘しています。

このように、2026年の主役となるフロンティアAIモデルは、知能の高さ、安全性、実行力を同時に満たす存在へと進化しました。もはや実験的な技術ではなく、社会の意思決定や業務プロセスを静かに支える基盤として、その全体像が明確になりつつあります。

推論力・長文理解はどこまで進化したのか

2026年における生成AIの進化を語るうえで、推論力と長文理解の飛躍は避けて通れません。かつての大規模言語モデルは、与えられた文脈の中でそれらしい文章をつなぐ存在でしたが、現在は複数の前提条件を整理し、段階的に結論へ導く能力が明確に向上しています。これは単なる計算能力の増加ではなく、推論プロセスそのものを内部で制御する設計思想の変化によるものです。

代表例として、OpenAIのGPT-5では、質問の難易度に応じて推論の深さを自動調整する動的ルーティングが導入されています。日常的な質問には即時応答を行い、専門的な問いに対しては数分規模で思考を重ねる仕組みです。Promptitude.ioなどの比較分析によれば、この仕組みによりGPT-4世代と比べて誤った推論に基づく回答が最大80%削減されたと報告されています。

推論性能の向上は、学術的ベンチマークにも表れています。大学院レベルの科学推論を測るGPQA Diamondでは、2026年時点の最新モデルが8割後半の正答率を記録し、人間の専門家水準に迫っています。高度な数学推論を評価するAIME 2026でGPT-5が満点を達成した点も、象徴的な成果といえます。

| 評価領域 | 代表的指標 | 最新モデルの到達点 |

|---|---|---|

| 科学的推論 | GPQA Diamond | 約87%の正答率 |

| 数学的推論 | AIME 2026 | 満点達成 |

| 長文理解 | コンテキスト長 | 最大1,000万トークン |

長文理解の進化も同様に劇的です。MetaのLlama 4 Scoutでは最大1,000万トークンの文脈を一度に扱えるようになり、数千ページの契約書や巨大なソースコード全体を俯瞰したうえで分析できます。これは単に「長く覚えられる」だけでなく、全体構造を保持しながら重要箇所を関連付けて理解する能力が向上したことを意味します。

こうした進化の背景には、線形アテンションや状態空間モデルといった数理的改良があります。計算量を抑えつつ情報を圧縮保持する仕組みにより、AIは長文を読んで考え、矛盾を検証する存在へと近づきました。東京大学の松尾豊教授も、現在の生成AIは性能向上の段階を越え、思考と理解の質が問われるフェーズに入ったと指摘しています。

AIエージェント化がもたらす仕事の委任モデル

AIエージェント化が進むことで、仕事の委任モデルは「作業を指示する」段階から「目的を任せる」段階へと大きく変わりつつあります。従来の生成AIは、人間が細かなプロンプトを与え、その都度アウトプットを確認・修正する必要がありました。しかし2026年時点では、AIが自律的にタスクを分解し、検証しながら実行することが可能になっています。

この変化の本質は、**人間が担ってきた“段取り”や“判断の前工程”そのものをAIに委ねられるようになった点**にあります。動的ルーティングやマルチステップ推論を備えた最新モデルでは、目標だけを与えると、必要な情報収集、下書き生成、ファクトチェック、改善までを一連の流れとして完遂します。松尾豊教授も、生成AIは「問いに答える存在」から「業務を引き受ける存在」へ移行したと指摘しています。

| 従来モデル | AIエージェントモデル |

|---|---|

| 人が手順を細かく指示 | 人は目的・制約のみ提示 |

| 都度アウトプットを確認 | 自己評価と修正を自動実行 |

| 単一タスク中心 | 複数タスクを連鎖的に処理 |

この委任モデルは、特に知的労働の現場で威力を発揮しています。KDDI総合研究所が発表したAIエージェントでは、過去の応対履歴を構造化し、不足情報を自律的に補完したうえで回答を生成します。その結果、顧客サポート業務において**回答精度約90%、応対時間約70%削減**という具体的な成果が報告されています。これは単なる自動化ではなく、「判断を含む仕事」を委ねた結果だと言えます。

重要なのは、人間の役割が不要になるわけではない点です。委任モデルでは、人間はAIに対して評価基準や優先順位、倫理的制約を設計する立場に回ります。どこまで任せ、どこで介入するのかを定義すること自体が、新しいスキルとなります。**仕事を奪うかどうかではなく、仕事の設計者になるかどうか**が問われているのです。

AIエージェント化がもたらす委任モデルは、効率化の延長線ではなく、組織や個人の意思決定構造そのものを再編します。目的を描き、評価軸を定める人間と、実行を担うAI。この分業が定着したとき、仕事のスピードと質はこれまでの前提を大きく超えることになります。

日本で進むソブリンAIと国産LLMの戦略

日本では近年、生成AIを単なる海外製クラウドサービスとして利用する段階を越え、データ主権と産業競争力を自国で確保する「ソブリンAI」の考え方が急速に広がっています。背景にあるのは、機密性の高い行政・金融・医療データを国外に依存せずに扱う必要性と、日本語や日本文化に最適化された知能基盤を自ら設計・運用したいという戦略的要請です。

総務省や経済産業省の議論でも、AIは電力や通信と同様に社会インフラと位置づけられつつあり、東京大学の松尾豊教授も「AIは国家単位での設計思想が問われる段階に入った」と指摘しています。こうした認識のもと、国内企業はグローバル最先端モデルを参照しながらも、日本独自の価値を組み込んだ国産LLMの開発を本格化させています。

象徴的な動きが、NTT、富士通、NEC、ソフトバンクといった大手による日本語特化型LLMの展開です。特に日本語は、主語の省略、敬語体系、文脈依存の意味変化が多く、英語中心に設計されたモデルでは誤解が生じやすい領域でした。国産LLMは言語そのものだけでなく、意思決定の前提となる文化的文脈まで学習対象に含めている点が大きな違いです。

| 観点 | グローバルLLM | 国産LLM |

|---|---|---|

| データ管理 | 海外クラウド依存が中心 | 国内データセンターで完結 |

| 日本語理解 | 一般的な翻訳・生成に強み | 語感・敬意・空気感まで最適化 |

| 用途設計 | 汎用タスクが中心 | 製造・行政・広告など特化型 |

実例として、SB Intuitionsの「Sarashina」は、日本語の微妙なニュアンス制御に重点を置いた設計が評価され、広告やカスタマーサポート領域で導入が進んでいます。電通や電通デジタルと進める共同研究では、実在する広告コピーやクリエイターの思考プロセスを教師データとして用い、感情に訴える表現を再現できるレベルに到達したと報告されています。

また、富士通やNEC、日立製作所は、長年蓄積してきた公共インフラや製造現場の知見をLLMに統合し、高い説明責任と再現性を備えたAIを構築しています。これは単なる文章生成ではなく、現場の判断基準や暗黙知を言語化し、組織全体で共有可能にする試みです。

重要なのは、日本が「すべてを国産で完結させる」方向を取っているわけではない点です。実際には、GPT-5やGeminiといった世界最先端モデルを補助的に活用しつつ、最終的な判断や生成の中核を国産LLMが担うハイブリッド戦略が主流になっています。この構造により、安全保障、法令順守、日本語品質を確保しながら、進化速度でも世界から取り残されない体制が整いつつあります。

ソブリンAIと国産LLMの推進は、日本がAI時代において「利用国」にとどまらず、「設計国」として存在感を保つための基盤です。2026年現在、その取り組みはすでに理念の段階を越え、具体的な産業競争力として結実し始めています。

日本語のニュアンスを理解する生成AIの仕組み

生成AIが日本語のニュアンスを理解できるようになった背景には、単なる翻訳精度の向上ではなく、言語そのものを文化的・社会的な文脈ごと扱う設計思想の進化があります。日本語は主語の省略、曖昧さを許容する表現、敬語や語尾による感情の制御などが特徴で、英語ベースのモデルでは誤解が生じやすい言語でした。

2026年時点の最新モデルでは、日本語専用コーパスを用いた教師あり微調整と、選好最適化が組み合わされています。東京大学松尾研究室や日本ディープラーニング協会が指摘するように、意味の正しさだけでなく「その場で自然かどうか」を評価軸に含めることが、日本語理解の鍵になっています。**同じ内容でも言い切るのか、余韻を残すのかという判断をAIが内部的に行っている**点が大きな進歩です。

特に広告や対話分野では、文脈依存性の処理が重要になります。電通とソフトバンクが共同研究する日本語コピー生成AIでは、過去の高評価コピーとその使用場面を対にして学習させることで、「強いが嫌味にならない」「柔らかいが弱くない」表現を再現しています。これは単語単位ではなく、文全体の印象を数値化して扱うアプローチです。

| 観点 | 従来型LLM | 日本語最適化LLM |

|---|---|---|

| 主語省略の解釈 | 文脈を誤認しやすい | 会話履歴全体から補完 |

| 敬語・語尾 | 形式的な変換 | 関係性を考慮して生成 |

| 曖昧表現 | 意味を一意に固定 | 意図的な余白を保持 |

さらに、ハルシネーション抑制技術の進展も日本語理解を底上げしています。RAGと自律的検証を組み合わせることで、AIは「知らないことを知らない」と表明できるようになりました。Google Cloudのエンタープライズ向け生成AIでは、根拠が確認できない日本語表現をあえて出力しない設計が採用されています。

結果として、2026年の生成AIは日本語を単なる記号列ではなく、人間関係や空気感を含んだコミュニケーション手段として扱っています。**日本語のニュアンス理解とは、高度な言語処理であると同時に、社会理解そのもの**であり、その水準にAIが到達しつつあることが、現在地を象徴しています。

ハルシネーションを防ぐRAGと自律検証技術

生成AIの社会実装が進む中で、最大の信頼性リスクとされてきたのがハルシネーションです。2026年時点では、この課題に対する実践的な解としてRAGと自律検証技術の組み合わせが事実上の標準になりつつあります。単にモデル性能を高めるのではなく、生成プロセスそのものを制御する発想への転換が起きています。

RAGは、AIが回答を作る前段階で信頼できる外部知識にアクセスし、その内容を根拠として文章を構成する仕組みです。Google Cloudが提供する業務向け生成AIでは、社内文書や公式データベースを検索し、該当情報が存在しない場合には無理に補完せず「情報が見つからない」と返す設計が採用されています。**この「答えない勇気」を持たせる設計思想こそが、業務利用における信頼性を大きく押し上げました。**

一方で、RAGだけでは十分ではありません。検索結果自体が古い、文脈に合わない、といった問題が残るためです。そこで導入が進んでいるのが自律検証、すなわちAI自身によるファクトチェックです。生成された回答を別の推論プロセスで再評価し、矛盾や根拠不足があれば再検索や再生成を行う多段階構造が採用されています。

| 観点 | RAG | 自律検証技術 |

|---|---|---|

| 役割 | 外部知識を参照して生成 | 生成内容の妥当性を再検証 |

| 防げるリスク | 知識不足による誤情報 | 論理破綻や文脈ズレ |

| 主な効果 | 根拠の明確化 | 品質の安定化 |

KDDIとKDDI総合研究所が発表したAIエージェントは、この両者を高度に統合した代表例です。過去の正確な応対履歴を構造化し、不足情報を自律的に収集・検証したうえで回答を生成する仕組みにより、顧客サポートで約90%の回答精度を達成しています。**属人化していた判断基準をAIが内在化した点が、従来型チャットボットとの決定的な違いです。**

東京大学の松尾豊教授も、生成AIがインフラ化する条件として「誤りを前提に自己修正できる構造」の重要性を指摘しています。正解を知っているAIではなく、検証し続けるAIこそが社会で使われるという視点です。RAGと自律検証の融合は、生成AIを便利な文章生成ツールから、信頼できる意思決定支援者へと進化させる中核技術だと言えます。

広告・出版・報道を変えるコンテンツ制作の現場

広告・出版・報道の現場では、2026年を境にコンテンツ制作の役割分担が明確に再設計されつつあります。生成AIは単なる文章作成ツールではなく、企画から検証、改善までを担う制作パートナーとして組み込まれています。**重要なのは「速く書く」ことではなく、「精度と一貫性を保ったまま量と多様性を出す」点にあります。**

広告領域では、電通やソフトバンク、SB Intuitionsなどが取り組む日本語コピー生成AIが象徴的です。過去の膨大な広告コピーやクリエイターの思考プロセスをSFTやDPOで学習させることで、感情の強弱や余韻まで制御可能になりました。媒体別に最適化されたコピーを同時並行で生成し、ABテストまで自動化する運用は、すでに大手代理店では標準になりつつあります。

出版の現場でも変化は顕著です。KADOKAWAのように編集部内にAI研究組織を設け、原稿整理、要約、ファクト確認をAIに委ねる事例が増えています。**編集者は「書く人」から「価値を見極め、磨き上げる人」へと役割が移行しています。**定型的な校正や構成案の作成をAIが担うことで、編集者は作家との対話や企画の独自性に時間を使えるようになりました。

報道分野では、正確性と透明性が最優先されます。日本経済新聞社のNIKKEI KAIは、生成AIを活用しながらも情報源を明示し、調査・分析のプロセスを可視化しています。RAGと自律的ファクトチェックの組み合わせにより、AIは確認できない情報については生成を拒否する設計が採用されています。**これは「書かない判断」をAIが担う段階に入ったことを意味します。**

| 分野 | AIの主な役割 | 人間の価値が集中する領域 |

|---|---|---|

| 広告 | 大量コピー生成、表現最適化、ABテスト | ブランド思想、企画の核 |

| 出版 | 構成案作成、要約、校正支援 | 編集判断、作家との関係構築 |

| 報道 | 情報整理、分析補助、下書き | 取材、論点設定、最終責任 |

こうした変化を支えているのが、ハルシネーション抑制技術の成熟です。GoogleやKDDIの事例に見られるように、生成結果を別AIが検証する多層構造が一般化しました。専門家の間でも「生成AIが入ることで品質が下がるのではなく、むしろ最低品質が底上げされる」という見方が広がっています。

広告・出版・報道に共通するのは、AIによって制作工程が分解され、再統合されている点です。**コンテンツ制作は属人的な技能から、再現可能な知的プロセスへと変換されました。**その中で人間に残る役割は、何を伝えるべきかを決め、社会的責任を負う意思決定そのものだと言えるでしょう。

市場データで見る生成AIの経済インパクト

生成AIの経済インパクトを語るうえで、まず押さえておきたいのが市場データが示す成長の確度です。IMARCグループの分析によれば、日本の生成AI市場規模は2025年時点で約10億米ドルに達し、2034年には約40億米ドル規模へと拡大すると予測されています。年平均成長率は16%超とされており、これは国内IT市場全体の成長率を大きく上回る水準です。

この数字が示しているのは、一過性のブームではなく、生成AIが中長期的に企業投資の中核に組み込まれているという事実です。特に日本では少子高齢化による労働力不足が深刻であり、AIによる代替や補完はコスト削減ではなく、事業継続そのものを支える基盤として位置づけられています。

市場規模の拡大は、単なるIT投資ではなく「生産性の再設計」に向けた資金流入を意味しています。

| 指標 | 2025年 | 2034年予測 | CAGR |

|---|---|---|---|

| 日本の生成AI市場 | 約10.1億米ドル | 約40.5億米ドル | 16.63% |

| 日本のテキスト分析市場 | 約6.8億米ドル | 約19.6億米ドル | 12.54% |

注目すべきは、生成AI単体だけでなく、テキスト分析市場も並行して拡大している点です。これは、文章を作るだけでなく、既存の膨大な文書データを読み解き、意思決定に変換する需要が急増していることを示しています。日本経済新聞社が提供する法人向け生成AIサービスのように、分析と要約を組み合わせた高付加価値型のサービスが伸びている背景とも一致します。

生産性指標の面でも、経済効果はすでに数値として可視化されています。2026年時点の調査では、マーケターの約87%がコンテンツ制作にAIを活用しており、半数以上が週に半日分以上の業務時間を削減できたと回答しています。これは単純計算でも、1人あたり年間数十時間規模の余剰時間が生まれていることを意味します。

生成AIの価値は「人件費削減」ではなく、「人間が付加価値の高い判断に集中できる時間」を創出する点にあります。

さらに重要なのは、こうした生産性向上が新規事業の創出につながっている点です。企業は浮いたリソースを、パーソナライズドマーケティング、バーチャルキャラクター、データドリブンな商品開発など、新たな収益源に再投資しています。市場データが示す成長率の裏側には、この再投資の好循環が存在しています。

専門家の間では、生成AIを導入した企業とそうでない企業の間で、今後数年で収益性と競争力に明確な差が生まれると指摘されています。市場データは、生成AIがもはや選択肢ではなく、経済合理性に基づく必須投資フェーズに入ったことを静かに、しかし明確に物語っています。

著作権と倫理から考えるAI時代の創作ルール

AIが創作の現場に深く入り込んだ2026年、著作権と倫理はもはや専門家だけの議論ではなく、すべてのクリエイターが理解すべき実践的なルールになっています。特に自動テキスト生成がインフラ化した現在、何が許され、どこからがリスクなのかを曖昧にしたまま制作を続けることは、事業上も信頼面でも大きな損失につながります。

日本における著作権侵害の判断は、文化庁が繰り返し示している通り、「類似性」と「依拠性」の二段階で行われます。AIが既存作品と似た表現を生成した場合でも、それだけで違法になるわけではありません。問題となるのは、その生成過程において、特定の著作物を参照・模倣する意図があったかどうかです。**AI時代でも、著作権の核心はあくまで人間の意思と行為にあります。**

実務上、特に注意すべきなのが「画風・文体の模倣」です。文化庁の見解によれば、特定の作家や作品を意図的に再現する目的で、LoRAなどを用いて追加学習させる行為は、権利者の利益を不当に害する場合、違法と判断される可能性が高いとされています。一方で、「〇〇風」という抽象的な指示だけで生成された表現については、個別具体的に判断されるため、グレーゾーンが残るのが現実です。

AI生成物の著作権の所在についても誤解が多い点です。AIが完全自動で出力した文章やコピーには、原則として著作権は発生しません。著作権が認められるかどうかの分岐点は、人間の創作的寄与がどこまで介在しているかです。

| 人間の関与 | 著作権の扱い |

|---|---|

| 単純な指示のみで自動生成 | 原則として著作権は発生しない |

| 詳細なプロンプト設計と試行錯誤 | 創作的寄与が認められる可能性が高い |

| 生成後の加筆・修正を実施 | 人間に著作権が帰属する余地がある |

つまり、AIは「作者」ではなく「道具」であり続けています。だからこそ、どのような指示を出し、どの出力を選び、どう仕上げたのかという制作プロセスそのものが、法的にも倫理的にも重要な意味を持ちます。

さらに2026年は、欧州AI規則(AI Act)が全面施行される年でもあります。この規則では、生成AIによるコンテンツであることを明示する透明性義務が定められました。日本企業であっても、海外向けのコンテンツやグローバル展開を行う場合、この基準を無視することはできません。**「知らなかった」では済まされない国際ルールが、すでに始まっています。**

倫理の観点で重要なのは、合法か違法かの二択だけで判断しない姿勢です。たとえ法的に問題がなくても、クリエイターや権利者の信頼を損なう使い方は、長期的にはブランド価値を毀損します。東京大学の松尾豊教授も、AIが社会インフラ化するほど、人間側の判断と責任がより重くなると指摘しています。

AI時代の創作ルールとは、規制に縛られるためのものではありません。誰の知的成果を尊重し、どこに自分自身の創造性を宿らせるのかを明確にするための指針です。AIを使うこと自体が価値になる時代は終わり、**どう使い、どう責任を引き受けるか**が、創作の質を決定づける時代に入っています。

専門家が語る2026年以降のAIと人間の関係性

2026年以降のAIと人間の関係性は、「代替」や「競争」という単純な構図から明確に離れ、人間の意思決定や創造性を拡張するパートナーへと進化していきます。東京大学の松尾豊教授は、生成AIが社会インフラ化した現在、問われるのは性能そのものではなく、**AIをどの判断領域まで委ね、人間がどこに責任と意味を見出すのか**だと指摘しています。

実際、2026年時点のAIは高度な推論や予測を担い、膨大な選択肢を瞬時に提示できます。一方で、その選択肢に「どの価値を採用するか」を決める最終判断は人間に残されています。たとえば企業経営において、AIは市場データを基に最適戦略を複数提示しますが、社会的影響や企業理念との整合性を踏まえた意思決定は経営者が担います。この分業構造こそが、2026年以降の標準形です。

| 領域 | AIの役割 | 人間の役割 |

|---|---|---|

| 判断・予測 | データ解析と選択肢提示 | 価値判断と最終決定 |

| 創造 | 案の大量生成と改善提案 | 意図付与と意味づけ |

| 実行 | 自動化・エージェント実行 | 責任と統制 |

また、AIエージェントやフィジカルAIの進展により、人間は「作業者」から「設計者」へと役割を変えつつあります。KDDI総合研究所の事例が示すように、AIが高精度な業務遂行を担うほど、人間には例外対応や倫理的判断、他者との関係構築といった非定型領域が集中します。**AIが優秀になるほど、人間の仕事は抽象度と責任が高まる**という逆説が現実になっています。

教育や人材育成の観点でも関係性は再定義されています。松尾教授は、AIやプログラミングを理解した上で各専門分野に進むことが必須になると述べていますが、これは全員が技術者になるという意味ではありません。AIの特性と限界を理解し、適切に問いを立て、結果を解釈できる力が、あらゆる職種の基礎リテラシーになるということです。

AIは疲れず、迷わず、膨大な知識を扱えます。しかし、社会的合意や感情への配慮、未来に対する意思表示は依然として人間固有の役割です。専門家たちが共通して示すビジョンは、AIに判断を奪われる未来ではなく、**AIによって人間がより人間らしい問いに集中できる未来**です。その関係性をどう設計するかが、2026年以降の私たち一人ひとりに委ねられています。

参考文献

- Ledge.ai:生成AIは「実装フェーズ」へ ディープラーニング協会・松尾豊理事長 年頭所感

- MarkeZine:電通・ソフトバンクら4社、日本語特化の広告コピー生成AI開発で共同研究

- KDDI総合研究所:世界初、人間の応対を学習し高精度に再現するAIエージェントを開発

- AIsmiley:GoogleのAIで実現する『考える社内アシスタント』Gemini Enterprise解説

- 文化庁:生成AIをめぐる最新の状況について

- EnterpriseZine:日本経済新聞社、生成AIサービス『NIKKEI KAI』提供開始