生成AIのブームを経て、AIは「文章を書く存在」から「業務を実行する存在」へと進化しています。いま企業現場で導入が進む自律型エージェントは、ERPやCRM、外部APIと直接接続し、実際の取引やデータ更新まで担うようになりました。

しかしその一方で、ハルシネーションによる誤情報の出力という問題は、誤送金や機密情報漏えいといった“実損害”リスクへと質的に変化しています。従来のプロンプトベースの制御だけでは、エンタープライズ環境における安全性を担保できないという認識が広がっています。

本記事では、Open Policy Agent(OPA)やAWS Cedarを活用し、AIの意思決定から「許可・不許可」を外部化するポリシーエンジン連携アーキテクチャを体系的に解説します。技術的メカニズムからEU AI Actや日本のAI事業者ガイドラインへの対応、市場データ、国内スタートアップ事例まで網羅し、AIガバナンスの最前線を一気通貫で理解できる内容をお届けします。

生成AIからエージェンティックAIへ:ワークフロー実行型への進化

2026年のAIトレンドを語るうえで欠かせないのが、生成AIからエージェンティックAIへの進化です。かつての生成AIは、文章や画像を「作る」ことに特化した受動的な存在でした。しかし現在の主役は、与えられた目標をもとに自律的に計画を立て、実行まで完遂するワークフロー実行型AIです。

たとえば「来週の大阪出張を手配して」と指示すると、エージェントは日程確認、フライト検索、ホテル予約、経費システム登録までを一連の流れとして処理します。単なる回答生成ではなく、企業システムや外部APIと連携しながら“行動”する点が決定的に異なります。

この変化は、リスクの質も根本から変えました。従来はハルシネーションによる誤情報が主な問題でしたが、エージェンティックAIでは誤送金や誤設定変更といった実損害に直結します。StrongDMは「AIエージェントはもはやツールではなくアクターである」と指摘しており、これは実行主体としての責任が問われる段階に入ったことを意味します。

実際、市場もこの方向に動いています。Straits Researchの調査では、エンタープライズ向けLLM市場は急拡大しており、特にエージェント型ユースケースが主要ドライバになると分析されています。企業が求めているのは生成物ではなく、生産性そのものだからです。

| 観点 | 生成AI | エージェンティックAI |

|---|---|---|

| 役割 | コンテンツ生成 | 目標達成と実行 |

| 接続範囲 | 主に対話UI | ERP・CRM・外部API |

| 主なリスク | 誤情報出力 | 誤行動による実損害 |

さらに重要なのは、エージェントがタスクを自律分解し、複数ツールを横断して処理する点です。Grid Dynamicsのエンタープライズ統合ガイドでも、オーケストレーション基盤と連携したエージェント設計が標準になりつつあると述べられています。

つまり、AIは「問いに答える存在」から「業務を遂行する存在」へと役割を拡張しました。このエージェンティック・シフトこそが、2026年のAIランドスケープを定義する最大の変化です。企業競争力の源泉は、生成精度ではなく、いかに安全かつ確実にワークフローを実行できるかに移っています。

なぜプロンプトベースのガバナンスは限界を迎えたのか

エージェンティックAIの台頭により、従来の「プロンプトで縛る」ガバナンスは限界を迎えています。生成AIブーム期には、システムプロンプトに「機密情報を出力してはいけません」と書き込むことで一定の抑止効果が期待されていました。しかし、AIが実際にAPIを呼び出し、データベースを書き換え、送金まで実行する時代において、この方法は構造的に不十分です。

最大の問題は、プロンプトベースの制御が本質的に確率論的であることです。大規模言語モデルは次トークンを確率的に予測する仕組みで動いており、同じ入力でも出力が揺らぎます。arXiv上のアクセス制御推論に関する研究でも、LLMは役割や権限に関する判断で一貫性を欠くケースが報告されています。99回正しく拒否しても、100回目に誤って許可する可能性をゼロにできません。

さらに深刻なのは、攻撃者によるプロンプトインジェクションや脱獄手法の高度化です。2026年のセキュリティ分析では、自然言語による禁止命令は、巧妙な文脈操作や多段プロンプトによって回避され得ることが示されています。これはモデルの能力不足ではなく、自然言語制御という枠組み自体の脆弱性です。

| 観点 | プロンプト型ガバナンス | 要求水準(エージェント時代) |

|---|---|---|

| 判定方式 | 確率的・文脈依存 | 決定論的・再現可能 |

| 耐攻撃性 | 脱獄に弱い | 外部検証で強化 |

| 監査可能性 | 出力ログ中心 | 許可/拒否の根拠を記録 |

加えて、リスクの質が変わりました。対話型AIにおけるハルシネーションは「誤情報の提示」で済みましたが、自律型エージェントでは「存在しないAPIパラメータでの実行」や「権限外リソースへのアクセス試行」といった具体的行動になります。StrongDMなどが指摘するように、エージェントはもはや“ツール”ではなく“アクター”です。アクターを自然言語のお願いだけで統制するのは現実的ではありません。

さらに、規制環境もこの限界を浮き彫りにしています。EU AI Actではリスク管理や監査証跡が重視され、日本のAI事業者ガイドラインでも説明責任が求められています。「なぜその行動が許可されたのか」を再現可能な形で示せないプロンプト依存型統制は、コンプライアンス要件を満たしにくいのです。

結果として形成されたコンセンサスは明確です。プロンプトは補助的ガイドにはなりますが、最終的な行動制御の根拠にはなりません。AIの推論と実行の間に、外部かつ決定論的なチェックポイントを置かない限り、エンタープライズ環境での本格運用は危険水域にあると言わざるを得ません。

決定論的インフラという発想:Agentic Constitutionの台頭

エージェンティックAIの普及により、企業はある重大な現実に直面しています。AIの「思考」は確率的であっても、その「行動」は決定論的でなければならないという要請です。

従来のプロンプト依存型ガバナンスは、あくまでAIの内部に期待する統制でした。しかし2026年現在、主流となっているのは行動制約をAIの外部に切り出す「決定論的インフラ」という発想です。

このアプローチは「Agentic Constitution(エージェント憲法)」と呼ばれ、AIに守らせる原則を機械可読なルールとして固定化します。

| 従来モデル | 決定論的インフラ |

|---|---|

| 自然言語による注意喚起 | Policy-as-Codeによる強制執行 |

| 確率的に従う | Yes/Noを必ず判定 |

| 内部統制に依存 | 外部エンジンで検証 |

arXivに掲載された「From Craft to Constitution」では、自然言語ベースのガードレールは原理的に突破可能であると指摘されています。LLMは統計的予測装置であり、常に例外的出力の余地を残します。

そこで採用されているのが、Open Policy AgentやAWS Cedarのようなポリシーエンジンです。これらは入力に対して常に同じ判定を返す決定論的システムであり、AIの推論結果を実行前に検証します。

この構造により、AIが「誤って考える」ことは許容しつつも、「誤って実行する」ことは防げます。

Agentic Constitutionの本質は、倫理的宣言ではなく実行可能な制約です。例えば「1,000ドルを超える送金は財務責任者のみ承認可能」という原則は、Cedarポリシーとしてコード化され、実行前に必ず評価されます。

StrongDMの分析によれば、エージェントはもはや「ツール」ではなく「アクター」です。アクターである以上、アクセス制御や監査可能性は人間と同等水準で求められます。

そのため決定論的インフラは単なるセキュリティ強化ではなく、AIを企業インフラの一部として正式に位置付けるための統治基盤といえます。

重要なのは、憲法がPDFでは意味を持たないという点です。RegoやCedarのような形式言語で表現され、API呼び出しごとに自動評価されて初めて効力を持ちます。

この仕組みにより、法規制の変更や社内規程の改訂もコード更新として即時反映できます。EU AI Act対応において「機械可読なコンプライアンス」が重視されているのも、この延長線上にあります。

エージェントの自由度を高めるために、むしろ統制を厳格化するという逆説的な思想こそが、2026年のAIガバナンスの核心です。

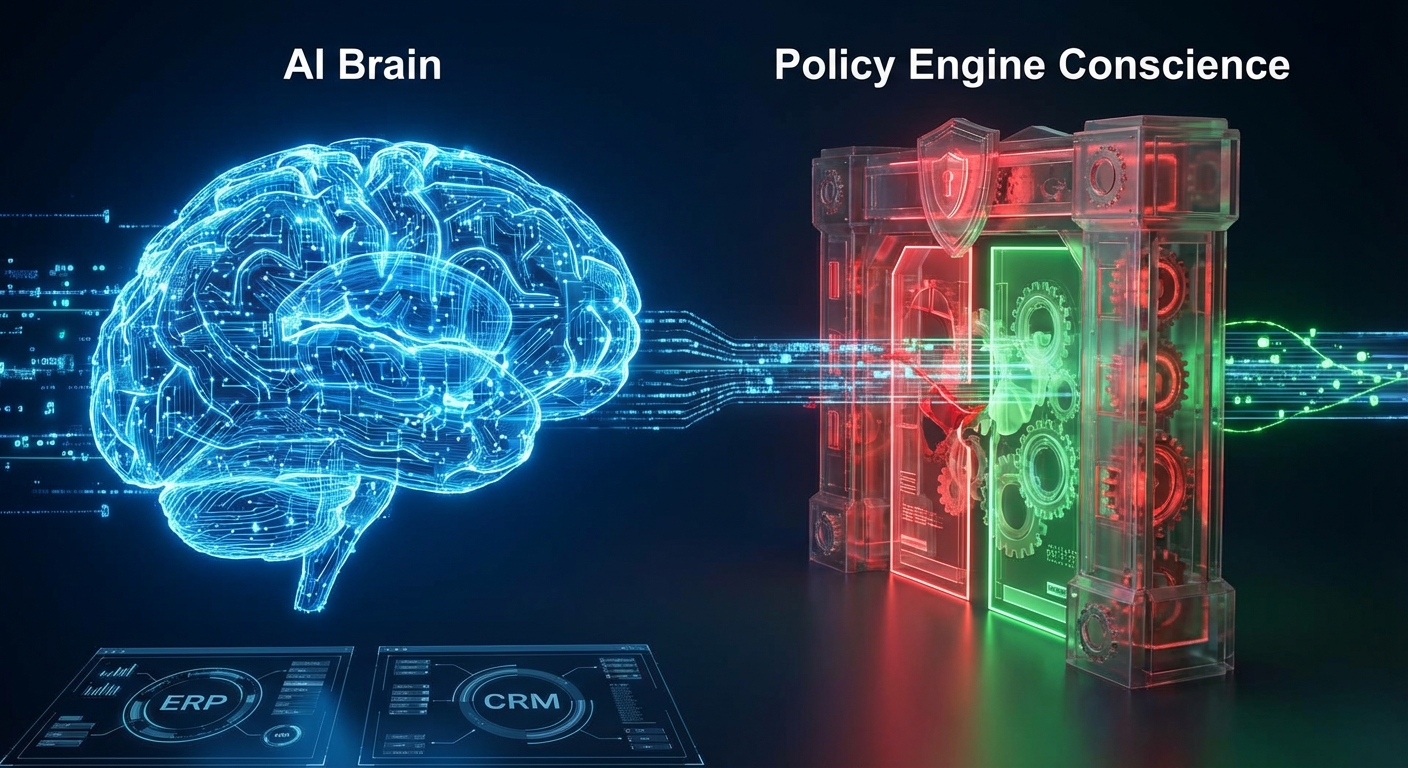

AI(脳)とポリシーエンジン(良心)の分離アーキテクチャ

エージェンティックAI時代における最大の設計原則が、AI(脳)とポリシーエンジン(良心)の分離です。これはソフトウェア工学でいう「関心の分離」を、AIガバナンスに適用したアーキテクチャ思想です。

LLMには推論と計画に集中させ、最終的な実行可否は外部の決定論的システムに委ねます。AIの創造性と、組織の統制を技術的に切り分ける発想です。

推論は確率的に、実行は決定論的に。この二層構造こそが、2026年の標準モデルになりつつあります。

| レイヤー | 役割 | 特性 |

|---|---|---|

| AI(LLM) | 意図理解・計画立案・ツール選択 | 確率的・非決定論的 |

| ポリシーエンジン | 許可/拒否の最終判定 | 決定論的・再現可能 |

たとえばAIが「顧客データを取得し、外部へ送信する」という計画を立てた場合、そのリクエストは実行前に必ずポリシーエンジンへ送られます。Open Policy Agent(OPA)やAWS Cedarは、そのJSONリクエストを評価し、AllowかDenyを100%同じ結果で返します。

ここで重要なのは、判定がモデルの“気分”に左右されないことです。LLMは同じ入力でも出力が揺らぐ可能性がありますが、ポリシーエンジンは同一条件下では常に同一の結論を出します。

arXivで報告されているガバナンス研究でも、自然言語による制約のみでは確率的な逸脱を完全には防げないと指摘されています。だからこそ、行動制約をモデル内部ではなく外部インフラに実装するという設計が採用されているのです。

この分離には、運用上の大きな利点もあります。法令改正や社内規定の変更があった場合、LLMを再学習する必要はありません。RegoやCedarで記述されたポリシーコードを書き換えれば、即時に全エージェントへ適用できます。

つまり「知能の更新」と「規範の更新」を独立させられるのです。これはEU AI Actのように継続的なリスク管理を求める規制環境下では極めて重要な設計です。

さらに、すべての判定はログとして保存されます。「誰が」「どのエージェントが」「何を実行しようとして」「どのルールにより拒否されたか」が完全に追跡可能です。ZL Technologiesの予測でも、監査証跡を持たないAIは今後運用不可能になるとされています。

AIをより賢くすることと、AIをより安全にすることは別問題です。この分離アーキテクチャは、その二律背反を解消します。脳の進化を止めずに、良心をコードとして固定する。それが2026年のAI設計思想の核心です。

Open Policy Agent(OPA)とRegoによるPolicy-as-Code実装

エージェンティックAIの行動を安全に制御する中核技術が、Open Policy Agent(OPA)とRegoによるPolicy-as-Code実装です。AIの「推論」と「許可判断」を分離するという設計思想は、2026年の決定論的インフラの要となっています。

Cloud Native Computing Foundationの卒業プロジェクトであるOPAは、もともとKubernetesのアドミッション制御などで採用が進みましたが、現在ではAIエージェントのツール実行前チェックにも広く使われています。StrongDMによれば、AIエージェントは「ツール」ではなく「アクター」であり、実行時の認可レイヤーが不可欠だと指摘されています。

OPAとRegoの役割整理

| 要素 | 役割 | 特性 |

|---|---|---|

| OPA | ポリシー評価エンジン | 決定論的・高速(ミリ秒以下) |

| Rego | 宣言型ポリシー言語 | JSON構造に強い・監査可能 |

| LLM | 意図生成・計画立案 | 確率的・非決定論的 |

Regoは宣言型言語であり、「誰が」「何を」「どの条件で」実行できるかを論理式として記述します。特にLLMが出力するJSON形式のツールコール引数と相性が良く、フィールド単位で厳密な検証が可能です。

たとえば「1,000ドル超の送金は禁止」「PIIを含む本文は社外送信不可」といったルールをコード化すれば、AIがいかに巧妙な推論を行っても、最終実行前に必ずOPAがAllowまたはDenyを返します。ここで重要なのは、判定が100%再現可能である点です。プロンプトと異なり、同じ入力には常に同じ結果が返ります。

さらにPolicy-as-CodeとしてGitで管理することで、変更履歴の追跡、レビュー、CI/CD連携が可能になります。Grid Dynamicsの解説でも示されている通り、エージェント統合においてはポリシーのバージョン管理が監査対応の基盤になります。

実装面では、エージェントランタイムがツール呼び出しをインターセプトし、その内容をJSONとしてOPAに送信します。OPAはRegoポリシーと照合し、即座に判定を返します。拒否された場合、エージェントはエラーを受け取り、自己修正や代替案提示を行います。

arXivのガバナンス研究でも指摘されているように、自然言語ベースの制御は脱獄攻撃に脆弱ですが、コード化されたポリシーは外部からのプロンプト操作では改変できません。つまり、ガバナンスを「モデル内部」ではなく「実行境界」に置くことが、防御の本質です。

OPAとRegoの導入は単なる技術選定ではなく、AIを社会実装するためのインフラ設計です。エージェントの能力を最大化しながら、その行動を決定論的に縛る。この緊張関係を制御できる組織だけが、次世代AIの本格運用に到達できます。

AWS Cedarの強み:高速認可と形式的検証

AWS Cedarがエンタープライズ環境で急速に存在感を高めている最大の理由は、高速な認可判定と形式的検証(Formal Verification)を両立している点にあります。

エージェンティックAIの時代では、1回のユーザー指示に対して数十回のAPIコールが発生することも珍しくありません。そのすべてに対してリアルタイムで認可チェックを行うには、ミリ秒単位の応答性能が前提となります。

Cedarは「プリンシパル(誰が)」「アクション(何を)」「リソース(何に対して)」という明確なモデルに基づき、アプリケーションレベルでの認可を極めて高速に評価できる設計になっています。

| 観点 | Cedarの特性 | エージェント環境での意義 |

|---|---|---|

| 評価速度 | ミリ秒単位の認可判定 | 多段ツール呼び出しでも遅延を最小化 |

| ポリシーモデル | Principal-Action-Resource中心 | 動的主体の権限整理が容易 |

| 検証可能性 | 自動推論による整合性確認 | 大規模ポリシーの安全性担保 |

特に重要なのが、ポリシーの「検証可能性」です。Medium上で公開されているCedar解説や実装ガイドによれば、Cedarは自動推論を活用し、ポリシー間の矛盾や意図しない許可経路を数学的に検査できます。

これは単なる静的解析ではありません。「ある条件下で本来拒否されるべきアクセスが許可されていないか」「特定のロールが過剰権限を持っていないか」といった問いに対し、論理的整合性を検証できます。

数千〜数万規模のポリシーが絡み合う環境では、人間のレビューだけでは限界があります。 形式的検証はその限界を補完する技術的セーフティネットです。

エージェントが顧客データベース、財務システム、外部APIを横断的に操作するケースを想像してください。もしポリシーに微細な抜け穴があれば、確率的に生成されたツールコールが偶発的にその穴を突く可能性があります。

Cedarの自動推論は、その「抜け穴」の存在を事前に検知するアプローチです。これは確率論ではなく、決定論的に安全性を確認する手法です。

StrongDMなどが指摘するように、AIエージェントは「ツール」ではなく「アクター」です。アクターである以上、その行動は常に厳密な認可体系の上に置かれる必要があります。

結果として、企業はポリシーを頻繁に更新しながらも、変更が新たなセキュリティホールを生んでいないかを機械的に確認できます。これはEU AI Actのように説明責任やリスク管理が求められる環境でも大きな武器になります。

単に「速い」だけでも、「安全」なだけでも不十分です。Cedarの真価は、リアルタイム認可性能と論理的完全性の両立にあります。

エージェンティックAIの暴走リスクが現実の経済損失に直結する今、この二軸を同時に満たす設計思想こそが、AWS Cedarの最大の強みです。

LangGraphなどオーケストレーターとの統合パターン

LangGraphのようなオーケストレーターとポリシーエンジンを統合する際の核心は、エージェントの「思考フロー」と「実行フロー」を構造的に分離することです。LangGraphは状態遷移を持つグラフベースの実行基盤であり、各ノードで推論やツール呼び出しを管理できます。この特性を活かし、ツール実行直前に必ずポリシー評価ノードを挿入する設計が、2026年の標準パターンになっています。

Grid Dynamicsのエンタープライズ統合ガイドによれば、エージェントのランタイムにガバナンス層を組み込むことで、API表面の爆発的拡大に対処できるとされています。LangGraphでは、ツール呼び出しを単なる関数実行ではなく「検証対象のイベント」として扱えるため、OPAやCedarとの接続点を明確に設計できます。

代表的な統合パターン

| パターン | 特徴 | 適用シナリオ |

|---|---|---|

| 同期インターセプト型 | ツール実行前に必ずOPAへ照会 | 送金・本番変更など高リスク操作 |

| サイドカー型 | エージェント横に常駐し全I/Oを監視 | マルチツール・複数API連携 |

| 非同期監査型 | 実行後にログを集約し分析 | 低リスク業務の可観測性向上 |

最も堅牢なのは同期インターセプト型です。LangGraphのノード間に「policy_check」ノードを設け、LLMが生成したJSON形式のツール引数をそのままOPAへ渡します。RegoはJSON構造の検証に強く、入力パラメータの型、値域、ユーザー属性を同時に評価できます。StrongDMが指摘するように、エージェントはもはやツールではなく「アクター」です。したがって、すべてのアクションはゼロトラスト前提で再認可されるべきです。

さらに高度な設計では、LangGraphの状態オブジェクトに「principal」「delegator」「task_scope」といったメタデータを保持し、Cedarへそのまま渡します。Cedarはプリンシパル・アクション・リソースの三項関係を高速評価できるため、大規模データアクセスでもミリ秒単位の判定が可能です。

Temporalのようなワークフローエンジンと併用する場合も同様で、各アクティビティ開始前に認可チェックを入れることで、長時間実行ジョブの途中権限変更にも対応できます。arXivのランタイムガバナンス研究でも、実行時インターセプトは静的プロンプト制御よりも一貫性と監査性で優れると報告されています。

LangGraph統合の本質は、LLMの柔軟な推論を活かしつつ、行動の最終決定権を決定論的エンジンに委譲する構造を徹底することにあります。この分離設計こそが、自律型エージェントをエンタープライズ基盤へ安全に接続する鍵になります。

Rich Authorization Requests(RAR)と最小権限設計

エージェンティックAIの時代において、認可は「後付けの設定」ではなく、アーキテクチャの中核です。特に重要なのが、Rich Authorization Requests(RAR)と最小権限設計の組み合わせです。

従来のOAuthスコープは「read」「write」といった粗い粒度でしたが、RAR(RFC 9396)はリクエスト単位で詳細な条件を付与できます。これにより、エージェントはタスクに必要な権限だけを、その瞬間に限定して要求できます。

「常に広い権限を持つAI」から「必要な瞬間に、必要な範囲だけ権限を持つAI」へ。これが2026年の認可設計の前提です。

例えば、出張手配エージェントが経費精算APIにアクセスする場合を考えます。従来型では「経費データの書き込み権限」を包括的に付与していました。しかしRARでは、次のような条件付き要求が可能です。

| 項目 | 従来スコープ | RARによる指定例 |

|---|---|---|

| 対象リソース | 経費全体 | 出張ID=1234に紐づく申請のみ |

| 金額上限 | 無制限 | 100,000円以下 |

| 有効期間 | 長期トークン | 30分間のみ有効 |

このように、金額・対象・時間といったコンテキストを埋め込んだ認可要求が可能になります。ComposioのセキュアAIエージェント設計ガイドでも、Just-in-Timeかつ条件付きトークンの発行が被害範囲の最小化に有効だと指摘されています。

最小権限の原則は古典的なセキュリティ概念ですが、エージェント環境では意味合いがさらに重くなります。なぜなら、エージェントはAPIを連鎖的に呼び出し、権限を横断的に利用するためです。StrongDMが指摘するように、AIエージェントは「ツール」ではなく「アクター」であり、従来の静的RBACでは不十分です。

ここで重要なのが、ポリシーエンジンとの連携です。RARで提示された詳細条件を、OPAやCedarが評価し、AllowかDenyを決定します。もし「上限100,000円」という条件を超えれば、エージェントの推論がいかに合理的であっても、実行は拒否されます。

推論は確率的でも、認可は決定論的でなければなりません。この分離こそが、エージェントの暴走や権限昇格リスクを封じ込めます。

さらに、RARは監査性の向上にも寄与します。どのタスクのために、どの条件で権限が発行されたのかが明示されるため、EU AI Actが求めるトレーサビリティや、日本のAI事業者ガイドラインが重視する説明責任にも適合しやすくなります。

結果として、RARと最小権限設計は単なるセキュリティ強化策ではありません。エージェントを安心して現場に解放するための「信頼のプロトコル」であり、攻めのAI活用を支える基盤技術なのです。

On-Behalf-Ofフローとエージェントのアイデンティティ管理

自律型エージェントが企業システムに接続する時代において、最大の論点の一つが「その行為は誰の意思なのか」というアイデンティティの問題です。単なるAPI認証では不十分であり、エージェントが“誰の代理として”行動しているのかを技術的に証明できる仕組みが不可欠になっています。

そこで中核となるのが、OAuth 2.0拡張仕様であるOn-Behalf-Of(OBO)フローです。これはエージェントがユーザーの代理としてバックエンドへアクセスする際、ユーザーのトークンとエージェント自身の識別情報を連鎖させて提示する仕組みです。

| 観点 | 従来のサービスアカウント | OBOフロー |

|---|---|---|

| 主体の識別 | システムのみ | ユーザー+エージェント |

| 監査ログ | 一律の実行記録 | 「誰の代理か」まで記録 |

| 権限制御 | 固定的 | ユーザー権限に従属 |

例えば、営業担当者がエージェントに「顧客Aの契約状況を確認して」と依頼した場合、OBOを用いればバックエンドは「営業担当Yの代理としてエージェントXが要求している」と認識できます。これにより、ユーザー自身が持たない権限をエージェントが行使することを構造的に防止できます。

Microsoft Entra IDなどが提供するOBO実装は、この“アイデンティティの連鎖”を標準化しており、ゼロトラスト原則との親和性も高いと評価されています。StrongDMの分析でも、エージェントは「ツール」ではなく「行為主体」である以上、実行単位での厳格な主体識別が必要だと指摘されています。

さらに重要なのが、エージェント自身のアイデンティティ管理です。エージェントごとに一意のプリンシパルを割り当て、ポリシーエンジン(OPAやCedar)で「ユーザーYの代理としてのエージェントX」という複合条件を評価します。これにより、単純なRBACでは実現できないきめ細かな制御が可能になります。

加えて、Rich Authorization Requests(RAR)を組み合わせることで、「特定の顧客レコードに対する一時的読み取り権限」といった限定的なトークン発行も実現できます。RFC 9396で定義されたRARは、必要最小限の権限をタスク単位で付与する設計を可能にし、万一の侵害時にも被害範囲を限定できます。

エージェント時代のアイデンティティ管理は、単なる認証強化ではありません。人間・エージェント・ポリシーエンジンの三層で責任の所在を明確化し、監査可能な連鎖を構築することこそが、決定論的ガバナンスを支える基盤になります。

クレデンシャル・ブローカリングとVaultパターン

エージェント型AIのリスクが「誤った回答」から「誤った実行」へと移行した現在、最大の論点は認可ロジックだけではありません。認証情報そのものをどこに置くのかという設計思想が、システムの安全性を左右します。

その中核となるのがクレデンシャル・ブローカリングとVaultパターンです。これは「LLMに鍵を渡さない」という原則を徹底するための実装アーキテクチャです。

基本構造の比較

| 項目 | 従来型 | ブローカリング型 |

|---|---|---|

| APIキーの保持 | アプリやLLM周辺に直接保持 | 専用Vaultに隔離保管 |

| LLMの認識範囲 | キーを間接的に参照可能 | キーの存在を認識しない |

| 漏洩リスク | プロンプトインジェクション経由で露出可能 | 設計上露出不可 |

従来型では、アプリケーション層に埋め込まれたAPIキーがLLMのログやエラーメッセージ経由で露出する可能性が指摘されてきました。セキュリティ研究でも、プロンプトインジェクションにより内部情報が抽出される事例が報告されています。

これに対し、ブローカリング型では、LLMは「どのツールを呼ぶか」「どのパラメータを使うか」だけを出力します。実際のAPIキー付与は、ランタイムに配置されたブローカーがVaultから一時的に取得し、実行後は破棄します。

LLMは“意思決定”のみを担当し、“資格情報”には一切触れない。この分離がゼロトラスト時代の前提です。

VaultにはHashiCorp Vaultのような秘密情報管理基盤や、クラウドネイティブなシークレットマネージャーが用いられます。これらはアクセス制御、暗号化、監査ログを標準装備しており、誰がいつどのキーを取得したかを追跡できます。

さらに近年は、長期固定キーではなく、短命な動的クレデンシャルを発行する方式が主流です。一定時間で自動失効するため、仮に通信経路が侵害されても被害範囲を限定できます。これはStrongDMなどが指摘するランタイムガバナンスの考え方とも整合します。

重要なのは、この仕組みが単なるセキュリティ強化ではなく、ガバナンス基盤そのものであるという点です。監査ログ、ポリシーエンジン、OBOフローと連携することで、「誰の代理で」「どの権限で」「どの鍵を使ったか」を完全に可視化できます。

エージェントが社会インフラへ接続する時代において、鍵管理の設計は思想そのものです。クレデンシャル・ブローカリングとVaultパターンは、AIの自律性を維持しながらも、統制を失わないための実践的な解となっています。

EU AI ActとMachine-Readable Complianceの実践

EU AI Actの実践フェーズにおいて、企業に突きつけられている核心的課題は「規制をどうコードに落とし込むか」です。2026年は議論の段階を終え、コンプライアンスを“証明できる状態”にすることが求められています。

特に高リスクAIや汎用目的AIに対しては、リスク管理体制、技術文書の整備、人間による監視の確保が義務付けられています。Ethycaの整理によれば、単なる社内ポリシーの整備では不十分で、運用レベルでの統制が不可欠です。

そこで注目されているのがMachine-Readable Compliance、すなわち機械可読なコンプライアンス実装です。

| 従来型対応 | Machine-Readable対応 |

|---|---|

| PDFや社内規程で管理 | RegoやCedarでコード化 |

| 人間による事後監査 | 実行前の自動ポリシー判定 |

| 証跡は手動収集 | 判定ログを自動保存 |

たとえば「差別的判断を行ってはならない」「生体認証データは限定用途のみ使用可能」といった規制要件を、自然言語のままではなくPolicy-as-Codeとして実装します。AIエージェントが外部APIを呼び出す直前にOPAやCedarが評価を行い、違反であれば即座にブロックします。

このアプローチの本質は、法令要件を“実行時制御”に変換する点にあります。EU AI Actは文書提出だけでなく、継続的リスク管理を要求します。ポリシーエンジンはその継続性を担保する装置として機能します。

さらに重要なのが監査証跡です。すべてのAllow/Deny判定はJSONログとして保存され、「いつ・誰が・どのリソースに・なぜアクセスを拒否されたか」が明確に残ります。ZL Technologiesの予測でも、監査可能性を持たないAI運用は事実上維持困難になると指摘されています。

実務では、規制文書をそのままコードに変換するのではなく、リスクカテゴリごとに抽象化し、YAMLや自然言語で定義した後にRegoへ変換するパターンが広がっています。これにより法務部門とエンジニアリング部門の橋渡しが可能になります。

Machine-Readable Complianceは単なる技術トレンドではありません。エージェンティックAIが社会インフラに接続される時代において、規制遵守をリアルタイムで執行するための基盤です。EU市場でAIを展開する企業にとって、ポリシーエンジン連携は選択肢ではなく前提条件になりつつあります。

日本のAI事業者ガイドラインと国内スタートアップの動向

日本では、経済産業省と総務省が公表するAI事業者ガイドラインが、2026年時点の実務的な拠り所となっています。法的拘束力は持ちませんが、リスク管理、透明性、説明責任、人間による監督といった原則を体系化し、企業に対して自主的かつ実効性あるガバナンス体制の構築を求めています。

とりわけエージェンティックAIの普及を背景に、単なる倫理指針ではなく、「実装可能な統制」へ落とし込めるかどうかが問われています。ガイドラインで示されるリスクベースアプローチは、EU AI Actの議論とも軌を一にしており、技術的コントロールと組織的統制の両立が重要視されています。

| 観点 | ガイドラインの要点 | 実務上の焦点 |

|---|---|---|

| リスク管理 | 利用目的に応じた評価と低減策 | ログ取得・外部監査対応 |

| 透明性 | 利用者への適切な情報提供 | 説明可能な設計と記録 |

| 人間の関与 | 重要判断への監督確保 | Human-in-the-Loop設計 |

TechTargetジャパンが報じたIT専門家調査によれば、日本企業の約4割がAIガバナンス関連に7億円超を投資しているとされます。これは単なる実験段階を超え、経営アジェンダとして本格化していることを示しています。

こうした動向を背景に、国内スタートアップの存在感も急速に高まっています。東京大学松尾研究室発のAthena Technologiesは、LLMの入出力を監視する「Athena Firewall」を展開し、大企業への導入を進めています。生成内容のフィルタリングにとどまらず、エージェントの行動制御を視野に入れた設計が特徴です。

SherLOCKは「AIセーフティ」と「AIセキュリティ」を統合的に扱うことを掲げ、自律型エージェント特有の暴走や権限昇格リスクに対応する基盤を提供しています。対話型AIから自律型への移行を前提とした思想設計が評価されています。

さらにCitadel AIは「Eval Insight」により、ハルシネーションやバイアスのリスクを自動評価し、ガバナンスレポートを生成します。これは説明責任を重視する日本企業のニーズと親和性が高い領域です。

日本市場の特徴は「慎重さ」ではなく、「統制を前提に攻める姿勢」へと進化している点にあります。

ガイドラインを抽象論に留めず、ログ管理、権限分離、ポリシーコード化といった具体的実装に接続できる企業が、エージェンティックAI時代の競争優位を確立します。国内スタートアップはその橋渡し役として、規制理解と技術実装を両立するポジションを築きつつあります。

急拡大するAIガバナンス市場と投資トレンド

AIが「生成」から「自律的な行動」へと進化したことで、AIガバナンス市場は急拡大しています。とりわけエージェンティックAIの普及により、リスクは情報の誤りから実損害へと質的に変化し、それを制御するインフラへの投資が加速しています。

Straits Researchの分析によれば、世界のLLM関連市場は2030年代にかけて大幅な成長が見込まれていますが、その中でもセキュリティとガバナンス領域は最も高い成長率を示すセグメントの一つと位置づけられています。特に2026年は、規制対応とエージェント実装が同時進行する転換点です。

AI活用が本格化するほど、「攻めの投資」としてのガバナンス予算が増大している点が2026年の特徴です。

調査データでは、LLMセキュリティ・ガバナンス市場は2025年に約65億ドル規模、2026年には約81.9億ドルへ拡大し、2034年には約498億ドルに達すると予測されています。年平均成長率は約25.9%とされ、一般的なITセキュリティ市場を上回る伸び率です。

| 指標 | 2025年 | 2026年 | 2034年予測 |

|---|---|---|---|

| 市場規模 | 約65億ドル | 約81.9億ドル | 約498億ドル |

| CAGR | – | 約25.9%(2026-2034) | |

投資トレンドを見ると、北米が最大市場である一方、アジア太平洋地域が最速成長エリアとされています。EU AI Actの本格施行や各国のガイドライン整備が、コンプライアンス対応需要を押し上げています。

日本でも変化は顕著です。TechTargetジャパンのIT専門家調査によれば、AIガバナンス関連に7億円超を投じる企業が約4割にのぼります。これは単なるPoC予算ではなく、本番運用を前提とした基幹投資フェーズに入ったことを示しています。

投資対象も進化しています。従来のログ監視やアクセス制御に加え、Policy-as-Code基盤、ポリシーエンジン(OPAやCedar)、LLMガードレール製品、評価・監査ダッシュボードなど、「実行前に止める」「実行後に証明する」ための層に資金が集中しています。

さらにベンチャー投資も活発です。国内ではAIセーフティとセキュリティを統合するスタートアップが資金調達を進めており、ガバナンスが独立した市場カテゴリーとして確立しつつあります。これはAIが単なるツールではなく、社会インフラに近づいている証左です。

今後の焦点は、ガバナンスをコストではなく競争優位の源泉として位置づけられるかどうかです。堅牢な統制基盤を持つ企業ほど、大胆にAIエージェントを展開できるという逆説が、市場の拡大をさらに後押ししています。

導入ステップ:YAMLからRegoへの段階的アプローチ

Policy-as-Codeを本格導入する際、最大の壁になるのが「Regoが難しい」という心理的ハードルです。そこで2026年の現場では、YAMLで定義し、Regoへ段階的に昇華させるアプローチが主流になっています。

Atakan Salar氏による実践報告でも、まずは人間にとって可読性の高いYAMLでガードレールを記述し、OPAで強制する方法が紹介されています。これにより、法務・セキュリティ・エンジニアの共通言語としてポリシーを扱えるようになります。

フェーズ別アプローチ

| フェーズ | 主な担当 | 目的 |

|---|---|---|

| 定義(YAML) | 法務・業務部門 | ルールの明文化と合意形成 |

| 変換(Rego生成) | プラットフォーム担当 | 機械可読化と自動テスト |

| 検証・展開 | DevSecOps | CI/CD統合と監査可能性確保 |

第一段階では「1000ドル超の送金は禁止」「PIIを含むメールは外部送信不可」といった業務ルールをYAMLで記述します。自然言語に近い構造のため、非エンジニアでもレビューが可能です。

第二段階で、そのYAMLをRegoへ変換します。最近ではLLMを用いて自然言語からRegoを生成し、人間が差分レビューするワークフローも一般化しています。arXivのARPaCCino研究でも、RAGとPolicy-as-Codeを組み合わせた自動生成・検証の有効性が示されています。

重要なのは、Regoを書くこと自体が目的ではなく、「決定論的に評価できる状態」に持ち込むことです。YAMLはあくまで入口にすぎません。

さらに成熟した組織では、生成されたRegoをそのまま使うのではなく、ユニットテストとポリシーテストを必須化します。OPAは入力JSONに対する期待結果をテストケースとして記述できるため、CIパイプラインで自動検証が可能です。

このプロセスを経ることで、ポリシーは単なるドキュメントではなく、バージョン管理された実行可能コードになります。EU AI Actが求める技術文書や監査証跡の整備においても、コード化されたポリシーは強力な証拠となります。

YAMLからRegoへの段階的アプローチは、技術的な移行戦略であると同時に、組織文化の変革プロセスでもあります。人間が理解できる形で始め、最終的には機械が100%の確度で判断する――この橋渡しこそが、エージェント時代の実装成功の鍵になります。

誤検知を抑えるハイブリッド審査モデル(OPA+LLM Judge)

決定論的なポリシーエンジンは強力ですが、現実の業務は常に白黒が明確とは限りません。そこで注目されているのが、OPAによる一次審査とLLM Judgeによる二次審査を組み合わせたハイブリッド審査モデルです。

この構成は、速度と柔軟性を両立させるための実践的アプローチとして、arXivのGovernance-as-a-Service研究などでも有効性が示されています。

| 審査レイヤー | 役割 | 特徴 |

|---|---|---|

| OPA(一次) | 明確な違反の即時検知 | 決定論的・低レイテンシ(1ms以下) |

| LLM Judge(二次) | 文脈依存の判断 | 確率的・数百ms・柔軟性高 |

例えば「競合他社の動向を調査する」という指示があった場合、単純なキーワードベースのルールでは「競合」「内部資料」といった語に反応し、過剰にブロックしてしまう可能性があります。

しかしLLM Judgeは、タスク全体の文脈や利用目的を踏まえて、正当な市場分析なのか、不正な情報取得なのかを推論できます。これにより、業務を止めずにリスクだけを下げる設計が可能になります。

重要なのは、LLM Judgeが最終決定権を持つのではなく、あくまで「補助的裁定者」として機能する点です。最終的な実行可否は、依然としてポリシーエンジン側の枠内に収めます。

さらに高度な実装では、LLM Judgeの判定ログを収集し、誤検知だったケースを分析してRegoポリシーへ還元します。これにより、ルールとAI推論が相互に学習する循環構造が生まれます。

MI9フレームワークなどの統合ランタイム研究でも示されている通り、単層のフィルタリングではエージェント環境の複雑性に対応できません。多層防御と段階的判断が、エージェント時代の標準設計になりつつあります。

誤検知を恐れてルールを緩めればリスクが増大し、厳しくしすぎれば現場がAIを使わなくなります。ハイブリッド審査モデルは、このトレードオフを構造的に解消するための実務的解です。

結果として、セキュリティと生産性の両立が可能になり、企業は自律型エージェントをより広範な業務へ展開できるようになります。

可観測性と監査ログ設計:運用フェーズのベストプラクティス

エージェント型AIを本番環境で運用するうえで、可観測性と監査ログ設計は単なる補助機能ではありません。「何が起きたのか」を事後に説明できないAIは、企業システムとして成立しません。とりわけAPI実行やデータアクセスを伴うエージェントでは、行動単位でのトレーサビリティが不可欠です。

2026年のガバナンス実務では、LLMの推論ログとポリシーエンジンの判定ログを分離しつつ、相関IDで結合する設計が推奨されています。ZL Technologiesのデータリスク予測でも、AI監査証跡の欠如は重大なコンプライアンスリスクとして指摘されています。

重要なのは「モデルの出力」ではなく、「実行直前の意思決定と認可結果」を記録することです。特にOPAやCedarは、Allow/Denyの判定理由をJSONで出力できるため、これを中核に据えたログ基盤が標準化しつつあります。

| ログ種別 | 主な内容 | 目的 |

|---|---|---|

| 推論ログ | プロンプト、思考結果、生成計画 | 挙動分析・改善 |

| ポリシー判定ログ | 入力属性、評価ルール、Allow/Deny理由 | 監査・説明責任 |

| 実行ログ | API呼び出し結果、レスポンス | 障害解析・証跡保全 |

ベストプラクティスは、エージェントの各ツールコールに一意のトランザクションIDを付与し、思考→インターセプト→ポリシー評価→実行までを時系列で追跡可能にすることです。これにより「誰の代理で」「どのポリシーに基づき」「なぜ拒否または許可されたのか」を数秒で再現できます。

さらに、監査ログは改ざん耐性を前提に設計する必要があります。WORMストレージや外部ログ基盤への即時転送を行い、運用チーム自身がログを操作できない構造にします。EU AI Actの技術文書義務や説明責任要件を考慮すると、機械可読な証跡保存は事実上の必須条件です。

可観測性の高度化には、リアルタイムダッシュボードも重要です。Permit.ioやStyra DASのような可視化基盤では、拒否率の急増や特定エージェントの異常挙動を即座に検知できます。単なる記録ではなく、異常検知とインシデント対応に直結する設計が求められます。

最後に見落とされがちなのが「ブロックされた試行」の分析です。拒否ログは攻撃兆候や誤設定の早期発見につながります。特定ポリシーへのヒットが急増している場合、それはプロンプトインジェクションの兆候かもしれません。可観測性とは可視化ではなく、リスクの早期発見能力そのものなのです。

エージェントの自律性が高まるほど、ブラックボックス運用は許されません。決定論的なポリシー評価と完全な監査証跡を組み合わせてこそ、企業は安心してAIに「行動」を委ねられます。

自己修復するポリシーと日本企業への実践提言

自律型エージェント時代において、ポリシーは「固定的なルール集」では不十分です。環境変化、法規制改正、新たな攻撃手法の出現に応じて進化する自己修復型ポリシー(Self-Healing Policy)が、2026年の次なる競争軸になりつつあります。

arXivで提案されているPolicy Refinement Loopの研究によれば、過去の違反ログやブロック履歴を学習データとして活用し、AIがポリシー改善案を生成、人間が承認する半自動更新モデルが有効とされています。これは単なる自動化ではなく、「ガバナンスの継続的デリバリー」です。

例えば、特定の経費精算エージェントが「金額上限超過」で頻繁に拒否されている場合、それが業務実態と乖離しているのか、不正兆候なのかをAIが統計的に分析し、調整案を提示します。人間は最終承認のみを担い、RegoやCedarポリシーが更新されます。

日本企業がここで取るべき実践は明確です。第一に、ブロックログや拒否理由を経営指標として扱うことです。ZL Technologiesの予測でも、監査ログを持たないAI運用は実質的に不可能とされています。ログは防御の副産物ではなく、改善の燃料です。

第二に、AI Governance Center of Excellenceの設置です。AWSも提唱するように、法務・セキュリティ・開発を横断する専門組織が不可欠です。ポリシーを文章で保管するのではなく、Git管理されたコードとして運用する体制が競争力を左右します。

第三に、段階的導入です。

| フェーズ | 対象領域 | 目的 |

|---|---|---|

| PoC | 経費・総務系エージェント | 誤検知率と運用負荷の検証 |

| 拡張 | CRM・人事データ | OBO連携と最小権限設計 |

| 全社化 | 基幹API全体 | Machine-Readable Compliance確立 |

TechTargetジャパンの調査では、国内企業の約4割がAIガバナンスに7億円超を投資していると報告されています。この投資を単なる防御費用で終わらせず、自己修復型ポリシーによって「安全だから加速できる」状態へ転換することが重要です。

推論は確率的でも、統制は決定論的であるべきです。そのうえで、統制自体を進化させる仕組みを持つ企業だけが、エージェント社会で持続的優位を確立できます。日本企業が目指すべきは、制限するガバナンスではなく、成長を可能にするガバナンスです。

参考文献

- CIO:Why your 2026 IT strategy needs an agentic constitution

- Medium:From Generative to Agentic AI: A Roadmap in 2026

- Grid Dynamics:Agentic AI Integration: Enterprise Systems Guide

- Medium:How Cedar Simplifies AWS Access Control (With Examples)

- TechTargetジャパン:AIガバナンスに「7億円超」投資が約4割 データで見る2026年の“AI予算相場”

- Amazon Web Services ブログ:AI/ML CoE (Center of Excellence) の設立