生成AIは文章や画像を生み出す段階を超え、実際にブラウザや業務システムを操作する「エージェント」へと進化しています。OpenAIのOperatorやAnthropicのComputer Useの登場により、AIは実行主体として企業のワークフローに組み込まれ始めました。

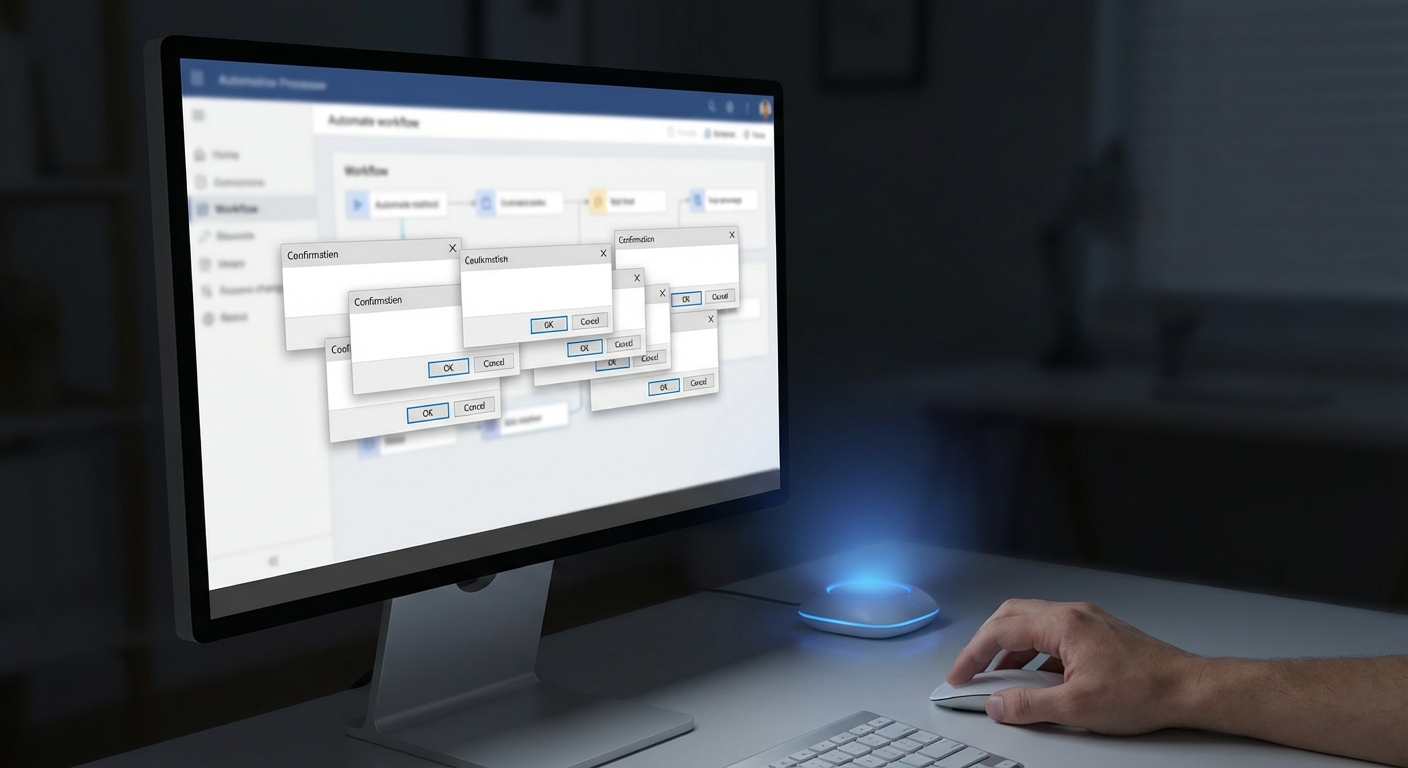

しかしその裏側で、多くの現場が直面しているのが「確認ダイアログ地獄」です。あらゆる操作に対して「本当に実行しますか?」と問い続ける設計は、安心をもたらすどころか、ユーザーの注意力を奪い、無意識の承認を誘発するという逆説的なリスクを生んでいます。

本記事では、Human-in-the-Loopの限界を乗り越えるHuman-on-the-Loopへの移行、信頼較正(Trust Calibration)に基づく動的信頼スコアリング、Model Context ProtocolやJIT権限管理といった最新アーキテクチャを体系的に整理します。AIと人間が持続的に協働するための設計原則を、理論・技術・法規制・UXの観点から解き明かします。

エージェントAIの台頭と「確認ダイアログ地獄」という新たなボトルネック

2026年、生成AIは「答える存在」から「行動する主体」へと明確に進化しています。OpenAIのOperatorやAnthropicのComputer Useに代表されるComputer-Using Agentsは、ブラウザ操作やSaaS連携を自律的に実行し、企業の業務フローそのものを書き換えつつあります。

Salesforceの2026年予測が指摘するように、AIエージェントはナレッジワーカーの生産性を飛躍的に高める潜在力を持っています。しかし同時に、新たなUX上のボトルネックが顕在化しました。それが「確認ダイアログ地獄」です。

エージェントが外部に影響を与える操作、たとえば「送信」「購入」「削除」「デプロイ」といったアクションごとに承認を求める設計は、一見すると安全に見えます。実際、Human-in-the-Loopは長らくAI倫理の基本原則とされてきました。

しかしCognitive Science Societyで報告されている「習慣化」の研究が示す通り、同じ刺激が繰り返されると人は反応を弱めます。結果として、ユーザーはダイアログを精読せずにOKを押す「クリック・スルー症候群」に陥ります。

皮肉なことに、安全のための確認が、実質的な安全性を下げるという逆説が起きているのです。Mediumなどの実務者レポートでも、過剰な確認フローがユーザーの集中力を削ぎ、重大な見落としを招く事例が共有されています。

| 項目 | 従来型UI | エージェント型UI |

|---|---|---|

| 操作頻度 | 人間主導で限定的 | AIが高速・多段階で実行 |

| 確認回数 | 数回/タスク | 数十〜数百回/日 |

| 認知負荷 | 可視化しやすい | 累積し不可視化 |

| リスク傾向 | 誤操作中心 | 無意識承認による構造的リスク |

特に「Vibe coding」のように自然言語で高速にコード生成と実行を行う環境では、生成物の確認責任がすべて人間に押し戻されます。これがSalesforceの言う「Workslop」現象、つまりAI成果物の監査に追われる逆転現象を生みます。

問題の本質は、技術の進化速度と承認モデルが噛み合っていない点にあります。エージェントは秒単位でAPIを横断しますが、人間は1秒間に一つの判断しかできません。この非対称性がボトルネックを生みます。

したがって今求められているのは、単純な確認回数の削減ではありません。「いつ確認すべきか」を再設計することです。自律性と安全性を二項対立で捉えるのではなく、信頼を動的に調整する設計思想への転換が不可欠になっています。

エージェントAIの台頭は、単なる生産性革命ではありません。UX設計、認知科学、セキュリティ理論が交差する新たな設計課題を突きつけています。そして「確認ダイアログ地獄」は、その転換点を象徴する現象なのです。

なぜ確認を増やすほど危険になるのか:認知負荷と習慣化のパラドックス

確認ダイアログは安全性を高めるための仕組みのはずですが、一定の閾値を超えると逆にリスクを増幅させます。その背景にあるのが認知負荷の増大と習慣化のパラドックスです。

人間のワーキングメモリには限界があります。認知科学の分野では、同時に処理できる情報量は厳しく制約されることが知られています。そこに一日に数十回、あるいは数百回の「許可しますか?」が差し込まれると、本来重要な判断に割くべき注意資源が削られてしまいます。

Cognitive Science Societyで報告された自律システムに対する信頼較正研究によれば、過剰な介入要求はユーザーの精神的疲労を高め、判断の質を低下させる傾向が示されています。つまり確認を増やすことは、常に安全側に働くわけではありません。

| 確認頻度 | 短期的効果 | 長期的影響 |

|---|---|---|

| 低頻度 | 注意喚起として機能 | 重要場面での集中維持 |

| 中頻度 | 安全性向上 | 軽度の疲労蓄積 |

| 高頻度 | 安心感の演出 | 習慣化・無意識承認 |

特に問題となるのが「習慣化」です。同じ形式のダイアログが繰り返されると、脳はそれを重要でない刺激として処理し始めます。これは警告アラート研究でも広く確認されている現象で、医療機器やセキュリティ警告においても“アラート疲れ”が重大事故の一因になることが報告されています。

AIエージェント環境ではこれが「クリック・スルー症候群」として現れます。ユーザーは内容を精査せず反射的に承認ボタンを押します。結果として、形式上はHuman-in-the-Loopであっても、実質的にはHuman-out-of-the-Loopに近い状態が生まれてしまいます。

さらに、確認行為そのものがタスクを分断します。生成AIが連続的に推論し処理を進めるのに対し、人間側は細切れの判断を強いられます。このコンテキストスイッチは集中力を低下させ、元の業務パフォーマンスにも悪影響を与えます。Salesforceが指摘する「Workslop」現象も、こうした監査過多の副作用と解釈できます。

重要なのは、確認の「回数」ではなく「意味」です。すべてを等価に確認させる設計は、ユーザーにとってシグナルとノイズの区別を曖昧にします。結果として、本当に危険な操作が埋もれてしまいます。

したがって、確認ダイアログ地獄の本質は技術的未成熟ではなく、人間の認知構造との不整合にあります。安全性を高めるには、確認を積み上げるのではなく、認知資源を温存し、本当に重要な瞬間に集中させる設計思想が不可欠です。

自律性の再定義:完全自動化ではなく“適切に助けを求める能力”へ

2026年においてAIの自律性は、もはや「人間の介入なしに最後までやり切る能力」ではありません。むしろ評価されているのは、どの瞬間に人間へ委ねるべきかを判断できる能力です。

OneReach.aiやClemson大学の研究が示すように、エージェント型AIが実運用に入ると、完全自動化よりも「適切な介入設計」のほうが成果に直結します。自律性とは孤立ではなく、関係性の設計なのです。

この再定義の背景には、確認ダイアログの過剰化による生産性低下と、逆説的なセキュリティリスクの増大があります。

| 従来の自律性観 | 2026年型の自律性観 |

|---|---|

| 人間を排除する | 人間との役割分担を最適化する |

| 介入ゼロを目指す | 介入のタイミングを最適化する |

| 常時フル権限 | 状況に応じた動的権限 |

特に重要なのが「信頼較正」との接続です。Cognitive Science Societyの研究によれば、人間はシステムの能力と自身の信頼感が一致しているときに最も適切な判断を下します。つまりAI側が自らの不確実性を認識し、必要時に助けを求める設計こそが、高度な自律性なのです。

例えば、低リスクなドラフト作成では自律的に進め、高額決済や不可逆的削除では確信度が十分でも一時停止する。この「自己抑制」ができるかどうかが成熟度を分けます。

また、Emergent Mindが整理する信頼較正研究では、過信と不信の両方がパフォーマンスを下げると示されています。常に人間へ確認するAIは不信を生み、常に自動実行するAIは過信を誘発します。最適解はその中間にあります。

適応型自律性は、人間をボトルネックにしないための仕組みであると同時に、人間の判断力を温存する仕組みでもあります。全てを聞くのではなく、聞くべきときだけ聞く。その選別能力こそが2026年のエージェントに求められる資質です。

結果として、自律性は「どこまで任せられるか」という尺度から、「どこで人と協働できるか」という尺度へと移行しています。完全自動化を追求する時代は終わり、賢く助けを求めるAIこそが、真に自律的なAIと評価される段階に入っています。

AIエージェントの自律性レベルモデルとHITLの限界

AIエージェントの自律性は、もはや「自動化できるかどうか」という単純な尺度では測れません。2026年現在、Knight ColumbiaやAIGLのワーキングペーパーで整理されているように、自律性は人間との役割分担の設計問題として再定義されています。

特に重要なのは、意思決定と実行のどちらを誰が担うのか、そして確認をどのタイミングで挿入するのかという観点です。以下は代表的な5段階モデルの要点です。

| レベル | 人間の役割 | 確認のあり方 |

|---|---|---|

| L1 操作者 | 逐一指示 | 常時承認 |

| L2 協働者 | 選択・修正 | 頻繁な確認 |

| L3 相談役 | 計画を事前承認 | 一括承認型 |

| L4 承認者 | 例外時のみ介入 | 動的・条件付き |

| L5 監視者 | 事後監査・停止権 | 原則なし |

多くの企業システムは依然としてL3にとどまっています。つまり、AIが立てた計画を人間が毎回承認するHuman-in-the-Loop(HITL)型です。しかしエージェントが秒単位でAPIを連鎖実行する環境では、すべての工程に人間を挟む設計はスケールしません。

Red HatやSercoの分析でも指摘されている通り、HITLは制御性を高める一方で、処理速度を人間の反応時間に縛りつけます。さらに認知科学の研究では、確認頻度が高まりすぎると「習慣化」が起こり、内容を読まずに承認するクリック行動が増えることが示されています。これは安全装置が形骸化する典型例です。

この限界を踏まえ、2026年の設計思想はHITLからHuman-on-the-Loop(HOTL)へ移行しています。HOTLではAIがデフォルトで実行し、人間は監督者として拒否権を持ちます。介入は例外的・条件付きで行われます。

たとえば低リスクなドラフト作成やデータ取得は自動実行し、高リスク操作やモデル確信度が低い場合のみ確認を求める設計です。DeepScribeのガイドでも、効率と制御のトレードオフを動的に調整することが推奨されています。

つまり、自律性レベルモデルの本質は「完全自動か完全手動か」という二項対立ではありません。状況に応じてL3とL4を往復できる動的遷移構造を設計できるかどうかが競争力を左右します。HITLの限界を直視し、監督中心のアーキテクチャへ進化できるかが、エージェント時代の分水嶺になっています。

Human-on-the-Loop(HOTL)と拒否権中心設計への転換

確認ダイアログ地獄から脱却する鍵は、Human-in-the-Loop(HITL)を前提とした設計思想そのものを見直すことにあります。2026年のエージェント環境では、秒単位で複数のAPIを横断する処理が当たり前となり、すべてのアクションに事前承認を求めるモデルは現実的ではありません。

そこで注目されているのがHuman-on-the-Loop(HOTL)です。SercoやRed Hatの分析によれば、HOTLは人間を「承認者」から「監督者」へと再定義し、例外時のみ介入する構造を取ります。

主導権はAIに委ねつつ、最終的な拒否権は常に人間が保持するという設計が中核です。これは単なる効率化ではなく、認知負荷とリスクを同時に最適化するアーキテクチャ転換です。

| 観点 | HITL | HOTL |

|---|---|---|

| 実行権限 | 人間の事前承認が必須 | 原則AIが実行 |

| 人間の役割 | 逐次判断者 | 監督者・拒否権保持者 |

| 介入タイミング | 常時 | 例外・高リスク時のみ |

| スケーラビリティ | 低い | 高い |

DeepScribeの整理では、HITLは制御を最大化する代わりに処理速度を犠牲にします。一方HOTLは、通常処理を自律化し、異常検知や低確信度時のみ人間を呼び戻すため、大規模業務に適しています。

ここで重要になるのが「拒否権中心設計」です。従来のUIは「承認ボタンを押す」ことを前提にしていましたが、HOTLでは「問題があれば止める」設計へと反転します。

例えば、AIが経費精算を自動処理し「10分後に確定します」と通知する場合、ユーザーは異常がなければ何もしません。これはByteBridgeが指摘する“管理による例外”の思想に合致します。

さらに、拒否権中心設計は法規制とも整合します。EU AI法が求める「人間による監視」は必ずしも逐次承認を意味しません。IAPPの解説が示すように、常時監督と介入可能性が担保されていれば、HOTLは要件を満たし得ます。

心理学的観点でも合理的です。Cognitive Science Societyの研究が示す通り、過剰な確認は習慣化を招き、実質的な安全性を低下させます。HOTLは確認頻度を動的に抑制することで、この逆説的リスクを回避します。

最終的に問われるのは、自律性の再定義です。高度なAIとは「すべてを自動化する存在」ではありません。本当に必要な瞬間だけ人間を呼び戻せる存在こそが、2026年における成熟したエージェント像です。

HOTLと拒否権中心設計は、人間の認知資源を戦略的判断に集中させます。確認のための確認を排除し、監督という本質的役割に人間を再配置することが、持続可能な人間-AI協働の基盤になります。

適応型摩擦(Adaptive Friction):リスクに応じて変化するUI戦略

AIエージェント時代のUI設計では、「摩擦は悪」という従来の常識が通用しなくなっています。むしろ重要なのは、リスクに応じて摩擦を意図的に変化させる設計です。これが適応型摩擦(Adaptive Friction)の核心です。

Microsoft Researchの「Tools for Thought」やMicroblinkの適応型KYC事例が示すように、摩擦をゼロにするのではなく、状況に応じて調整することが安全性とUXの両立に直結します。

適応型摩擦は、主に「操作の不可逆性」と「AIの確信度」という2軸で設計されます。

| リスク水準 | UI摩擦の設計 | 具体例 |

|---|---|---|

| 低 | 事後通知・Undo可能 | メール下書き保存、タグ付け |

| 中 | 軽量な確認・時間遅延 | 外部共有リンク生成 |

| 高 | 強制入力・画面ロック | 大量削除、送金処理 |

低リスク領域では、トースト通知と「元に戻す」ボタンだけで十分です。Gmail型のUndo設計は、明示的承認を省きながらも回復可能性を担保します。

一方、高リスク操作ではあえて操作負荷を上げます。削除対象の名前を再入力させる、タイムラグを設けるなど、無意識のクリックを物理的に困難にする設計が有効です。

重要なのは、摩擦を「固定値」にしないことです。Cleanlabのリアルタイム信頼スコア研究が示す通り、モデル確信度や過去成功率に応じてガードレールを動的に変化させることで、誤作動率を抑制できます。

認知科学の観点でも、確認の多発は「習慣化」を招きます。Cognitive Science Societyの研究が指摘するように、繰り返される警告は注意資源を消耗させ、最終的には読まれなくなります。

だからこそ、低リスクでは極力静かに動き、高リスク時のみ明確に介入させる設計が必要です。常に赤い警告を出すのではなく、本当に危険な瞬間だけ色やモーダルで強調します。

さらに有効なのが、確信度の可視化です。Confidence Visualization Patternsの実践例では、数値や色で不確実性を提示することで、ユーザーの過信を抑制できると報告されています。

適応型摩擦は単なるUIテクニックではありません。信頼較正と連動し、人間の認知特性を前提に設計される「動的ガバナンス層」です。

確認ダイアログを減らすこと自体が目的ではありません。本当に注意を向けるべき瞬間だけ、確実に注意を向けさせることこそが、この戦略の本質です。

信頼較正(Trust Calibration)の科学と3つの構成要素

信頼較正とは、ユーザーがAIに抱く主観的な信頼と、AIの実際の性能や限界を一致させるプロセスを指します。Emergent Mindの整理によれば、信頼が過大でも過小でもなく、客観的信頼性と整合している状態こそが、持続可能な人間–AI協働の前提です。

ここで重要なのは、信頼を「感覚」ではなく「設計可能な変数」として扱う視点です。2026年のエージェント設計では、信頼は定量化・分解され、UIや権限管理ロジックに組み込まれています。

信頼は大きく3つの構成要素に整理できます。PubMed Centralに掲載された自動化システム研究でも、この多次元モデルが支持されています。

| 構成要素 | 意味 | 設計上の指標例 |

|---|---|---|

| 能力(Competence) | タスクを成功させる実力 | 成功率、誤答率、ベンチマーク性能 |

| 誠実さ(Benevolence) | ユーザー意図との整合性 | アライメント評価、バイアス検査 |

| 予測可能性(Integrity) | 一貫した振る舞いと説明可能性 | 推論ログ、説明生成の安定性 |

第一の能力は、もっとも直感的な要素です。過去の類似タスクでの成功率や、リアルタイムのモデル確信度がここに含まれます。Cleanlabのエージェント評価研究では、誤答検出を組み込むことで実運用時の信頼性を有意に改善できることが示されています。

第二の誠実さは、単なる精度以上の概念です。たとえば正確でも、ユーザーの目的から逸脱していれば信頼は崩れます。価値観整合性やポリシー遵守のモニタリングが不可欠です。

第三の予測可能性は、信頼較正の鍵を握ります。PLOS Oneの研究が示す通り、人は結果そのものよりも「なぜそうなったか」が理解できるかどうかで信頼を調整します。推論プロセスの要約提示や確信度表示は、この要素を強化します。

能力が高くても説明が不十分なら過信が生まれ、説明が丁寧でも性能が低ければ不信が生まれます。この三要素のバランス設計こそが、確認ダイアログの頻度を科学的に最適化する土台になります。

信頼較正は心理学とシステム工学の交差点にあります。適応型自律性を成立させるには、これら三要素を継続的に測定し、UI・権限・介入レベルへ動的に反映させる設計思想が不可欠です。

動的信頼スコアリング:モデル確信度・データ品質・文脈リスクの統合

適応型自律性を実装する中核が、動的信頼スコアリングです。これはエージェントの挙動を一律ルールで縛るのではなく、状況ごとに「どこまで任せられるか」を数値で判断する枠組みです。

Emergent Mindが整理する信頼較正の研究によれば、信頼とは主観的感情ではなく、客観的信頼性との整合で評価すべき対象です。そのためには複数の変数を統合したスコア設計が不可欠になります。

モデル確信度・データ品質・文脈リスクを統合し、閾値を超えた場合のみ自律実行するという設計が、確認ダイアログ地獄を回避する鍵になります。

| 要素 | 内容 | スコア低下要因 |

|---|---|---|

| モデル確信度 | 出力確率・自己評価・過去成功率 | 曖昧回答・分布外入力 |

| データ品質 | 鮮度・完全性・出典信頼性 | 古いデータ・欠損値 |

| 文脈リスク | 操作の不可逆性・影響範囲 | 削除・送金・外部公開 |

モデル確信度は、LLMが内部で算出するトークン確率や履歴ベースの成功率から推定されます。Cleanlabのベンチマークでは、リアルタイム信頼スコアを導入したエージェントは、ハルシネーション検出精度が改善する傾向が示されています。

一方、データ品質は見落とされがちです。Ideas誌のデータ適合性評価フレームワークによれば、入力データの鮮度や網羅性は推論信頼度に直接影響します。最新価格が必要な場面で古いキャッシュを参照すれば、確信度が高くても誤判断になります。

そして最も重要なのが文脈リスクです。同じ90%の確信度でも、メール草稿作成と顧客データ削除では許容閾値が異なります。EU AI法が高リスク領域に厳格な監督を求めていることからも、リスク加重は制度的にも不可欠です。

実装上は、これらを重み付きで統合し、事前に設定したAutomation Thresholdと比較します。スコアが閾値を上回れば自律実行、下回ればHOTLモードで通知または承認要求へ遷移します。

PLOS Oneの適応的信頼較正研究が示す通り、信頼は固定値ではなく相互作用の中で更新されます。ユーザーが繰り返し承認した操作は履歴パラメータが上昇し、逆に差し戻しが続けば自動的に閾値を超えにくくなります。

この動的更新こそが、過信と不信の両極端を防ぎます。常に人間確認に戻す設計はスケールしませんが、完全自動化もリスクが高すぎます。数理モデルに基づく信頼スコアリングは、その中間を滑らかにつなぐ実践的アーキテクチャなのです。

Model Context Protocol(MCP)とコンテキスト認識型権限管理

エージェント型AIの自律性を安全に拡張するうえで中核となるのが、Model Context Protocol(MCP)とコンテキスト認識型権限管理です。従来のAPIキー中心の連携では、一度認証情報を渡すと広範な権限が包括的に委譲されてしまい、確認ダイアログを増やす以外にリスクを抑える手段が限られていました。

MCPは、モデルと外部ツール・データソースの接続方法を標準化する仕様であり、仕様書ではツール定義や呼び出し契約を明示的に記述できる点が強調されています。Kongなどが解説するMCP Gatewayのアーキテクチャによれば、このレイヤーを介在させることで、AIエージェントの行動をプロトコルレベルで制御できます。

MCPの本質は「接続の標準化」ではなく、「権限の細粒度化と強制力」にあります。

たとえば、ツールごとに承認要否や利用条件を定義できるため、delete_userのような高リスク操作には必ず人間の承認トークンを要求する、といった制御が可能です。これはUI側で確認ダイアログを乱発するのではなく、インフラ層で自律性の上限を設計するアプローチです。

| 観点 | 従来API連携 | MCPベース連携 |

|---|---|---|

| 権限範囲 | APIキーに依存し広範 | ツール単位で細分化 |

| 承認制御 | 主にUIで実装 | プロトコルレベルで強制 |

| 監査性 | 個別実装に依存 | 呼び出し契約として標準化 |

さらに重要なのが、コンテキスト認識型のアクセス制御です。CerbosやCloud Security Allianceが指摘するように、エージェントのIDだけでなく「誰の依頼か」「業務時間内か」「どのデータ領域か」といった属性を組み合わせるABAC(属性ベースアクセス制御)が実装の鍵になります。

これにより、同じエージェントでも経理担当者の依頼時のみ会計システムへ書き込み可能とし、深夜帯や異常なボリュームの操作では自動的に読み取り専用へ降格させる、といった動的制御が実現します。確認の回数を増やすのではなく、実行可能な範囲そのものを文脈に応じて変化させる設計がポイントです。

加えて、ジャストインタイム(JIT)権限付与との組み合わせが有効です。DelineaやCrowdStrikeが解説するJITモデルでは、エージェントは常時高権限を保持せず、必要な瞬間にのみ一時的な認証情報が発行されます。タスク完了後に即時失効させることで、万一の侵害時の被害範囲を限定できます。

この構造では、信頼スコアやリスク評価に応じて「自動発行」か「管理者承認付き発行」かを切り替えられます。つまり、MCPが接続の標準を定め、ABACが文脈を評価し、JITが時間軸を制御するという三層構造が、適応型自律性を技術的に支えています。

結果として、ユーザーはすべての操作を逐一承認する必要がなくなります。危険な操作だけが構造的に制限され、低リスク領域ではスムーズな自律実行が可能になります。これこそが、確認ダイアログに依存しない次世代の権限管理モデルです。

ジャストインタイム(JIT)アクセスと最小特権の実装原則

エージェント型AIにおけるセキュリティ設計の核心は、「常に確認する」ことではなく「必要な瞬間だけ権限を与える」ことにあります。その実装原則が、ジャストインタイム(JIT)アクセスと最小特権(Least Privilege)です。

Cloud Security AllianceやCrowdStrikeが指摘するように、常時高権限を持つアイデンティティは攻撃面を指数関数的に広げます。特にエージェントはAPIやSaaSを横断的に操作するため、侵害時の影響範囲が人間ユーザーより大きくなりがちです。

そこで重要になるのが、「デフォルト無権限・必要時のみ昇格」という設計思想です。

| 原則 | 従来型 | JIT+最小特権 |

|---|---|---|

| 権限付与タイミング | 事前に恒久付与 | 要求発生時のみ一時付与 |

| 権限範囲 | ロール単位で広範 | 操作単位で限定 |

| 失効 | 手動・不定期 | タスク完了と同時に自動失効 |

Strata IdentityやDelineaが解説するJITモデルでは、エージェントは待機中ほぼ無権限です。たとえば「顧客データを更新する」という具体的タスクが発生した瞬間にだけ、更新対象テーブルへの限定的な書き込みトークンが発行されます。

しかもそのトークンは短命で、処理終了後に自動的に無効化されます。侵害されても“今その瞬間の操作”しか実行できない構造になるため、横展開リスクを大幅に抑制できます。

最小特権の実装では、ロールベース(RBAC)だけでなく属性ベース(ABAC)の併用が有効です。Cerbosが示すMCP連携の例では、「誰の依頼か」「業務時間内か」「リスクスコアはいくつか」といったコンテキスト属性によって利用可能ツールを動的に絞り込みます。

ここで重要なのは、権限を“人間と同じ粒度”で設計しないことです。エージェントは秒単位で複数APIを呼び出すため、「ユーザー管理者」ではなく「delete_userの実行1回分」という粒度まで分解する必要があります。

さらに、信頼スコアと連動させることで自律性との整合も取れます。CleanlabやCredo AIが示す動的信頼評価を用い、スコアが閾値を超えた場合のみ自動的に一時権限を払い出し、下回れば人間承認を必須にします。

この設計は「確認ダイアログを増やさずに安全性を高める」ための鍵です。常時承認を求めるのではなく、権限のライフサイクルそのものを短縮・細分化することでリスクを構造的に削減します。

結果として、ユーザーは監視と例外対応に集中でき、エージェントは必要な瞬間だけ行動できます。JITアクセスと最小特権は、適応型自律性を技術的に支える基盤アーキテクチャなのです。

日本のAI技術利用促進法とEU AI法に見る“人間による監督”の実像

AIエージェントが実業務を担う時代において、「人間による監督」は単なる倫理的スローガンではなく、法的義務や説明責任の中核概念となっています。

とりわけ日本のAI技術利用促進法とEU AI法は、同じ「Human Oversight」を掲げながら、その実像には明確な違いがあります。

両者を比較すると、監督の設計思想そのものが異なることが見えてきます。

| 観点 | 日本:AI技術利用促進法 | EU:AI法(AI Act) |

|---|---|---|

| 規制アプローチ | イノベーション促進型(努力義務中心) | リスクベース型(法的義務・制裁あり) |

| 人間の関与 | リスクに応じた柔軟な監督 | 高リスク領域で明示的な監視体制を要求 |

| 重視点 | トレーサビリティと説明可能性 | 事前統制と運用時の実効的介入可能性 |

2025年に成立した日本のAI技術利用促進法は、いわゆるハードローによる厳格な事前規制ではなく、事業者の自主的取り組みを前提としたソフトロー型の枠組みを採用しています。

海外法制比較を行ったFPFやCSISの分析によれば、日本は「アジャイル・ガバナンス」を掲げ、リスク評価と継続的改善を重視する設計です。

そのため、**すべてのAI判断に人間が逐一承認することまでは求めていません。**

求められているのは、リスクに応じた適切な監督体制、そして事後的に検証可能なログや説明責任の確保です。

これは、Human-in-the-Loopの固定的義務化ではなく、Human-on-the-Loop型の監督モデルとも整合的です。

つまり日本では、「常時介入」よりも「介入可能性の担保」が実質的な焦点になっています。

一方、EU AI法はより厳格です。

高リスクAIシステムに該当する場合、第14条で人間による監視措置の実装が法的義務とされています。

医療、重要インフラ、雇用・人事評価などの分野では、完全自律型運用は原則として許容されません。

IAPPやDeloitteの解説によれば、EUにおける「監視」とは単なる形式的存在ではなく、実効的に介入できる設計を意味します。

人間がAIの能力や限界を理解し、異常時に停止・修正できる状態を制度的に組み込む必要があります。

**監督は「存在していること」ではなく、「機能していること」が求められるのです。**

もっとも、EU法も常時クリック承認を義務づけているわけではありません。

リアルタイム監視ダッシュボードやアラート設計によって、人間が常に状況を把握し、必要時に即時介入できる体制であれば要件を満たし得ると解釈されています。

この点で、適応型自律性や動的信頼スコアリングを組み込んだ設計は、EU市場でも実装可能です。

両法制を俯瞰すると、日本は「柔軟性の中の責任」、EUは「規律の中の自律」という対照的構図が浮かび上がります。

AIエージェント時代の監督とは、単に人間をループ内に残すことではありません。

**人間が意味のある判断を下せる瞬間だけに関与する構造をどう設計するか――そこに法制度と技術設計の接点があります。**

規制を制約と捉えるのではなく、信頼を設計するためのフレームワークと捉えられるかどうかが、2026年の競争力を左右します。

信頼を可視化するUXパターン:確信度表示・Undo設計・推論の透明化

AIエージェントが自律的に行動する時代において、UXの役割は単なる操作性の向上ではありません。「このAIはどこまで任せてよいのか」を直感的に理解させる設計こそが、確認ダイアログ地獄を回避する鍵になります。

その中心にあるのが、確信度表示、Undo設計、推論プロセスの透明化という3つのパターンです。これらは信頼較正をユーザー体験のレベルで実装する手法といえます。

確信度表示:ブラックボックスを数値化する

GoogleのPeople + AIガイドブックが示すように、AIの状態を可視化することは信頼形成に直結します。特に有効なのが「確信度の視覚化」です。

| 確信度 | UI表現 | 推奨アクション |

|---|---|---|

| 高(80%以上) | 緑色バー・安定した表示 | 自動実行+事後通知 |

| 中(50〜80%) | 黄色バー・注意アイコン | 軽量な確認 |

| 低(50%未満) | 赤色表示・警告文 | 明示的承認必須 |

Confidence Visualization Patternの研究でも、数値と色を併用することでユーザーの過信と過度な不信の両方を抑制できると報告されています。重要なのは、確信度を隠さないことです。曖昧な断定表現よりも「この提案の確信度は62%です」と明示するほうが、意思決定の質は向上します。

Undo設計:承認を減らし、回復可能性を上げる

「実行前に確認」から「実行後に取り消し」への転換は、摩擦を減らしつつ安全性を保つ強力な方法です。Gmailの送信取り消しと同様、一定時間の猶予を設けることで、クリック疲労を防げます。

ただし不可逆的操作には適用できません。ここで重要なのは、操作のリスクと回復可能性を明確に区別する設計思想です。PLOS Oneの信頼較正研究でも、回復可能な環境ではユーザーの心理的負担が大きく低減することが示されています。

推論の透明化:結果ではなく過程を見せる

AnthropicやMicrosoftが採用しているように、エージェントの行動理由を段階的に開示する設計も有効です。ただし常時すべてを表示するのではなく、必要時に展開できるプログレッシブ・ディスクロージャが望ましいです。

例えば「価格比較→在庫確認→予約実行」というステップを要約表示し、詳細をクリックで確認できるようにします。Trust Repairに関する研究では、エラー発生後に推論根拠を提示すると信頼回復が有意に早まると報告されています。

信頼は宣言するものではなく、設計によって可視化するものです。確信度表示で現在地を示し、Undoで安全網を張り、推論透明化で納得感を与える。この三位一体のUXが、適応型自律性をユーザーに受け入れさせる実践的アプローチになります。

OpenAI・Microsoft・Google・Anthropic・Appleの最新アプローチ比較

2026年における主要テック企業のエージェント戦略は、「どこまで自律させ、どこで人間を関与させるか」という設計思想の違いに明確に表れています。確認ダイアログ地獄を回避しつつ、安全性とスケーラビリティを両立するためのアプローチは、各社で大きく異なります。

| 企業 | 中核アプローチ | 人間関与モデル |

|---|---|---|

| OpenAI | Operatorによる段階的自律 | 動的HITL+学習型介入削減 |

| Microsoft | Copilot StudioのAI承認 | 多段階承認・HOTL志向 |

| Geminiの安全重視設計 | 明示的HITL推奨 | |

| Anthropic | Computer Useと透明性 | リスク検知時の強制確認 |

| Apple | オンデバイス中心 | プライバシー起点の明示的同意 |

OpenAIのOperatorは、ブラウザ操作を伴うエージェントとして設計され、System Cardでも安全対策が強調されています。初期段階では慎重な確認設計を採用しつつ、反復タスクではユーザーの過去の承認履歴を踏まえ介入頻度を下げる方向に進んでいます。信頼の履歴を活用して摩擦を減らす設計思想が特徴です。

MicrosoftはCopilot StudioにおいてAI自身を一次承認者とする「AI approvals」を実装しています。Microsoft公式ブログによれば、低リスク案件はAIが自動処理し、高リスクのみ人間へエスカレーションされます。これはHuman-on-the-Loopを業務フローに組み込んだ実装例であり、確認の集中管理によって認知負荷を下げています。

GoogleのGeminiは、開発者ドキュメントでHuman-in-the-Loopの活用を明示的に推奨しています。特にComputer Use機能では、外部操作に対する人間の確認を前提とした設計が紹介されており、安全性を優先する保守的アプローチが読み取れます。PAIRガイドブックでも説明可能性と信頼形成の重要性が繰り返し強調されています。

AnthropicはComputer UseとTransparency Hubを通じ、モデルの挙動可視化とリスク検知分類器の導入を進めています。フィッシング画面など高リスク兆候を検出した場合に強制確認へ切り替えるフェイルセーフ型設計は、信頼スコアが下がった瞬間に自律レベルを落とす動的モデルの実装例といえます。

Apple Intelligenceは他社と一線を画し、オンデバイス処理を中心に据えています。Appleのニュースルームによれば、クラウド処理が必要な場合は明確なユーザー同意プロセスを挟みます。自律性の拡大よりも「データ主権の明示」を優先する点が特徴であり、確認行為を単なる安全装置ではなく信頼構築のUXとして位置付けています。

総じて見ると、OpenAIとMicrosoftは適応型自律性の高度化、GoogleとAnthropicは安全優先の統制強化、Appleはプライバシー主導の自律制御という構図です。同じエージェント技術でも、確認の設計哲学が企業文化と規制戦略を映し出している点が、2026年の最大の示唆といえます。

持続可能な人間×AI協働を実現する設計原則

人間とAIの協働を持続可能にするためには、単に精度を高めるだけでは不十分です。重要なのは「信頼の閾値をどう設計するか」という視点です。確認ダイアログを増やせば安全になるという発想は、認知科学が示す「習慣化」によって逆効果になり得ます。Cognitive Science Societyの研究が示すように、過剰な警告は注意力を鈍らせ、結果的にリスクを高めます。

したがって設計原則の第一は、静的な承認主義からの脱却です。すべての操作に同じ摩擦をかけるのではなく、信頼スコアや文脈リスクに応じて自律レベルを可変にすることが前提になります。

| 設計軸 | 低リスク領域 | 高リスク領域 |

|---|---|---|

| 人間の関与 | 監視中心(HOTL) | 事前承認(HITL) |

| UI摩擦 | Undo猶予・通知型 | 明示入力・多段階確認 |

| ログ要件 | 事後監査可能 | 完全トレーサビリティ |

第二の原則は、「拒否権を中心に据える設計」です。SercoやRed Hatの分析が示す通り、承認を求め続けるモデルはスケールしません。代わりに、AIが実行し、人間は異常時のみ介入する構造に転換します。これは人間の役割を“操作担当者”から“監督者”へ進化させる発想です。

第三に、信頼較正を前提とした透明性の確保です。Emergent MindやPLOS Oneの研究では、確信度表示や説明可能性の提供が過信と不信の両方を抑制すると報告されています。確信度バー、根拠データの提示、推論プロセスの段階的開示は、単なるUX改善ではなく、信頼の精密制御装置です。

最後に、法規制との整合も不可欠です。日本のAI技術利用促進法が示すように、逐一承認ではなく、事後監査可能性と介入可能性を担保することで監督要件を満たすアプローチが現実的です。一方、EU AI法下では高リスク用途で明確な人間監督が求められます。つまり設計原則は、技術・心理・法の三層を横断して統合されなければなりません。

持続可能な人間×AI協働とは、効率と安全のどちらかを選ぶことではありません。信頼を定量化し、摩擦を動的に設計し、人間の役割を再定義することによって初めて実現します。ここに、2026年型AI設計の核心があります。

参考文献

- Salesforce:The Future of AI Agents: Top Predictions and Trends to Watch in 2026

- OpenAI:Operator System Card

- Anthropic:Computer use tool – Claude API Docs

- Knight First Amendment Institute:Levels of Autonomy for AI Agents

- Emergent Mind:Trust Calibration in AI

- Cleanlab:Benchmarking real-time trust scoring across five AI Agent architectures

- Model Context Protocol:Specification

- Cloud Security Alliance:Agentic AI Identity Management Approach

- CSIS:Japan’s Agile AI Governance in Action: Fostering a Global Nexus Through Pluralistic Interoperability

- IAPP:IAPP Global Legislative Predictions 2026