生成AIや基盤モデルを取り巻く環境は、ここ数年で大きく変わりました。かつては研究者や一部の先進企業だけが意識していた「AIの透明性」が、2026年には企業活動の前提条件になりつつあります。

特に注目されているのが、EU AI Actの本格施行を契機としたモデルカードの位置づけの変化です。モデルカードは単なる倫理的アピールではなく、法規制への適合、リスク管理、そして顧客や社会からの信頼構築を支える中核的な技術文書となりました。

本記事では、AIガバナンスとモデルカード運用がどのように進化しているのかを、規制動向、技術トレンド、具体的な企業事例、研究知見を交えながら整理します。なぜ今「自律的透明性」が求められるのか、そしてAIエージェントがどのように実務を変えつつあるのかを理解することで、読者の皆さまは次世代のAI開発と運用に必要な視点を体系的に得られるはずです。

AIを単に使う側にとどまらず、設計・提供・評価する立場にある方にとって、本記事は2026年以降を見据えた実践的な羅針盤となることを目指します。

2026年に起きているAI透明性のパラダイムシフト

2026年は、AI透明性の意味そのものが書き換えられた年として記憶される転換点です。かつて透明性は、企業が自主的に取り組む倫理配慮やブランド価値向上のための施策に近い位置づけでした。しかし現在は、**AIを社会に提供するための最低限の前提条件**へと明確に格上げされています。その直接的な引き金となったのが、EU AI Actによる汎用AIモデルへの法的義務化です。

欧州委員会やNISTなどの公的機関によれば、透明性はもはや「説明できること」だけを指しません。**誰が、どのデータを使い、どの程度の計算資源と環境負荷でモデルを構築し、どのようなリスクを把握した上で市場に出したのか**まで含めて説明できる状態が求められています。これはAIをブラックボックスとして扱う発想からの決定的な脱却を意味します。

| 観点 | 従来(〜2023年頃) | 2026年時点 |

|---|---|---|

| 透明性の位置づけ | 任意・推奨事項 | 法的義務・参入条件 |

| 対象範囲 | 性能・用途説明が中心 | データ出自・環境負荷・リスク評価まで包含 |

| 更新頻度 | 静的ドキュメント | 運用と連動した継続的更新 |

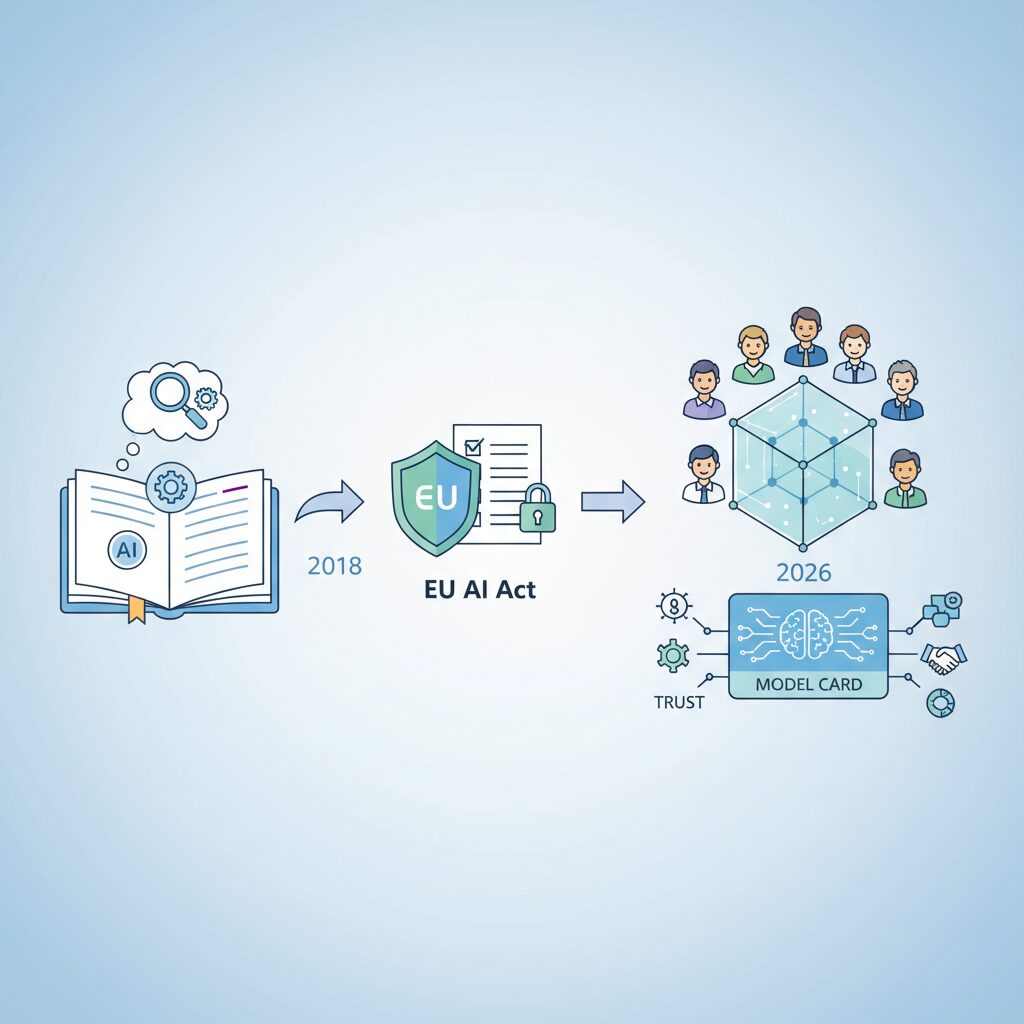

象徴的なのがモデルカードの役割変化です。Googleの研究者によって2018年に提唱された当初、モデルカードは「栄養成分表示」のように、性能や制約を簡潔に示す補助資料でした。ところが2026年現在、EU AI Act附属書XI・XIIに対応する形で、**モデルカードは法規制対応文書、リスク引継書、下流事業者向け技術仕様書を兼ねる中核ドキュメント**へと進化しています。

特に注目すべきは、透明性が“静的な公開”から“動的な責任遂行”へと変わった点です。トレーニングデータの構成比や著作権対応状況、累積計算量がもたらす体系的リスクなどは、時間とともに変化します。そのため、**一度書いて終わりの開示は、もはや透明性とは見なされません**。実態とドキュメントが常に一致していること自体が、信頼の条件になっています。

このパラダイムシフトは欧州に限りません。日本でもAI事業者ガイドラインや公共調達要件を通じて、モデルカードや関連文書の整備が事実上の標準となりました。透明性は規制対応コストであると同時に、**市場でAIを使ってもらうための信用インフラ**へと変貌しています。2026年のAI開発競争は、性能だけでなく、どこまで誠実に説明できるかという次元に突入したのです。

モデルカードとは何か:2018年の提唱から現在までの進化

モデルカードという概念は、2018年にGoogleの研究者であるマーガレット・ミッチェル氏らによって提唱されました。当初の狙いは非常にシンプルで、機械学習モデルの性能や想定用途、既知の制限やバイアスを簡潔に示すことでした。食品の栄養成分表示になぞらえ、専門家だけでなく利用者や意思決定者にもモデルの特性を伝えるための補助資料として位置付けられていました。

この初期モデルカードの重要性は、学術界で急速に認識されました。Google Researchによれば、精度やF1スコアだけでは説明できない社会的リスクを明示することで、モデルの誤用を防ぐ効果があるとされています。特に顔認識や自然言語処理の分野では、特定の人口統計グループに対する性能差を記載する試みが進み、透明性の新しい標準として注目を集めました。

しかし2018年当時のモデルカードは、あくまで自発的な倫理的実践にとどまっていました。記載内容や粒度は組織ごとに大きく異なり、更新も手動で行われる静的な文書でした。その結果、実運用とドキュメントの乖離が生じやすく、実務的な意思決定に十分活用されないケースも少なくありませんでした。

| 時期 | モデルカードの位置付け | 主な特徴 |

|---|---|---|

| 2018年頃 | 研究コミュニティの提案 | 性能・制限・バイアスの簡潔な記述 |

| 2020〜2023年 | 企業の責任あるAI施策 | 公平性評価や利用上の注意が拡張 |

| 2025年以降 | 規制対応の必須文書 | 法的・運用的情報を含む包括文書 |

転機となったのは、基盤モデルと生成AIの急速な普及です。NVIDIAやMicrosoftの技術ブログでも指摘されているように、モデルがAPIとして広範に再利用されるようになると、単一の性能評価ではリスクを説明しきれなくなりました。ここからモデルカードは、開発者向けの注意書きではなく、サプライチェーン全体を支える技術文書へと役割を変えていきます。

2025年にEUのAI法が汎用AIモデルに透明性義務を課したことで、この流れは決定的になりました。モデルカードは、トレーニングデータの来歴、計算資源や環境負荷、既知のリスクを含む包括的な説明責任文書として再定義されました。**もはや「あると望ましい資料」ではなく、「存在しなければ市場に出せない前提条件」になったのです。**

2026年現在のモデルカードは、2018年の原型と比べると別物に近い存在です。それでも根底にある思想は変わっていません。それは、AIモデルの限界や前提条件を正直に示し、人間が適切に判断するための共通言語を提供することです。モデルカードの進化は、AI技術そのものの成熟と、社会から求められる責任の重さを映し出す鏡だと言えるでしょう。

EU AI Actがもたらしたガバナンス実務の変化

EU AI Actの施行は、AIガバナンスを「理念」から「日常業務」へと一気に引き下ろしました。特に2025年8月以降、GPAIを提供する企業では、ガバナンスが法務部門や倫理委員会だけの専管事項ではなく、研究開発、MLOps、プロダクト管理、調達、営業までを横断する実務プロセスへと再定義されています。

最大の変化は、ガバナンスの単位が「組織」から「モデル」へと移行した点です。EU AI ActのAnnex XIおよびXIIが求めるのは、企業全体の方針ではなく、個々のモデルについての技術的・運用的説明責任です。これにより、多くの企業でモデル単位のオーナーシップが明確化され、モデル責任者が技術文書の正確性に法的責任を負う体制が整えられています。

この流れを受け、実務ではガバナンスとMLOpsの統合が急速に進みました。NISTのAIリスクマネジメントフレームワークが示すように、リスク管理は開発後のチェックではなく、設計・学習・評価・運用の各段階に組み込むべきものとされています。結果として、トレーニングログ、評価指標、データ来歴がそのままガバナンス証跡として再利用される設計が標準化しつつあります。

| 観点 | 従来のガバナンス実務 | EU AI Act以後の実務 |

|---|---|---|

| 管理対象 | 組織・プロジェクト単位 | モデル単位 |

| 文書化 | 年次・手動更新 | 継続的・半自動更新 |

| 責任所在 | 委員会中心 | モデル責任者+横断レビュー |

また、下流事業者との関係性も大きく変わりました。Annex XIIが求める透明性情報は、単なる参考資料ではなく、下流側が自らのコンプライアンスを果たすための前提条件です。そのため、モデルカードは法務文書と技術仕様書の中間的性格を持ち、利用条件や制限事項の曖昧さが契約リスクに直結するようになりました。欧州委員会の解説資料でも、責任分界点を明示することの重要性が繰り返し強調されています。

さらに実務を難しくしているのが、体系的リスクを持つGPAIへの追加義務です。累積計算量や社会的影響を基準に指定されたモデルでは、外部専門家によるレッドチーミングやインシデント即時報告が求められます。これは多くの企業にとって初めての経験であり、サイバーセキュリティ部門や広報部門まで巻き込んだ訓練と手順整備が不可欠となりました。

結果として、EU AI Actがもたらした本質的な変化は、ガバナンスをコストではなく運用品質の指標として扱う視点です。モデルの透明性や説明可能性が高いほど、下流事業者や顧客との取引が円滑になるという現実が、実務担当者の意識を大きく変えています。規制対応のために始まった取り組みが、いつの間にかプロダクト競争力そのものを左右する要素へと変貌している点に、2026年のAIガバナンスの特徴があります。

日本におけるAIガバナンスとモデルカードの実装動向

日本におけるAIガバナンスは、2026年に入り「法制化されていないから任意」という段階を明確に脱し、ソフトローが実務上の強制力を持つ運用フェーズへと移行しています。特にモデルカードは、企業倫理の表明ではなく、公共調達や大企業取引における実質的な審査資料として扱われるようになっています。

経済産業省と総務省が策定したAI事業者ガイドラインは、改定を重ねる中で、モデルカードを単独文書としてではなく、システムカード、データカードと連動した三層構造で管理することを推奨しています。これはAIの挙動だけでなく、出自、設計意図、運用時リスクまでを一貫して説明可能にするという、日本独自の実務的アプローチです。

| 文書種別 | 主な役割 | 日本での実装上の位置づけ |

|---|---|---|

| モデルカード | 性能・制限・リスクの説明 | 調達・監査時の中核資料 |

| データカード | 学習データの来歴と権利関係 | 個人情報・著作権対応の根拠 |

| システムカード | 運用環境と責任分界 | 実装・利用段階の説明責任 |

この動きを決定づけたのが、デジタル庁による生成AI調達ガイドラインです。2025年以降、政府機関がAIを調達する際には、透明性確保とリスク管理プロセスの文書化が必須要件となりました。結果として、モデルカードを提出できないベンダーは入札に参加できないという状況が生まれています。

注目すべき点は、日本では罰則よりも「説明できるかどうか」が評価軸になっていることです。欧州のような制裁金リスクは存在しない一方で、モデルカードの記載内容が不十分な場合、調達失格や取引停止という形で即座に事業影響が現れます。このため、多くの企業がモデルカードを法務部門だけでなく、開発部門と一体で整備する体制を構築しています。

さらに2026年には、AI基本法の審議が進んでいることもあり、大規模モデル開発者に対する安全性評価の報告義務が導入される可能性が指摘されています。専門家の間では、EU規制を直接コピーするのではなく、既存のガイドライン運用を法的裏付けで補強する形になるとの見方が有力です。

このように日本では、モデルカードは「公開物」よりも「信頼を担保する実務文書」として進化しています。誰に、どのリスクを、どこまで説明できるのかという視点が、モデルカード実装の成熟度を測る新たな指標となりつつあります。

2026年版モデルカードに必須となる記載項目の全体像

2026年版モデルカードに必須となる記載項目の全体像を理解することは、もはや単なるドキュメント設計の話ではありません。**規制対応、リスク管理、そして信頼構築を同時に成立させるための設計図**として、モデルカードは位置づけ直されています。EU AI Actの施行以降、モデルカードは研究者向けの補足資料ではなく、規制当局、下流事業者、監査人といった多様なステークホルダーが参照する公式文書となりました。

その全体像を俯瞰すると、2026年のモデルカードは大きく「来歴の説明」「データと学習の透明性」「リスクと制約の明示」「利用条件の定義」という四つの軸で構成されていることが分かります。GoogleのModel CardsやNVIDIAのModel Card++が示すように、これらは独立した項目ではなく、相互に検証可能な形で結びつくことが重視されています。たとえば、トレーニングデータの説明は、そのまま公平性評価や既知の制限事項の根拠になります。

| 記載領域 | 主な内容 | 主な読者 |

|---|---|---|

| モデルの来歴 | バージョン、提供形態、ライセンス | 規制当局・監査人 |

| 学習データ | データソース、権利処理、個人情報対応 | 法務・下流事業者 |

| 評価とリスク | 性能指標、公平性、既知の制限 | 開発者・研究者 |

| 利用条件 | 意図された用途、禁止事項 | プロダクト担当 |

特に重要なのは、**「意図された用途」と「対象外用途」を明確に分けて記載する点**です。EU AI Act附属書XIIでは、下流プロバイダーが自らのコンプライアンス判断を行えるだけの情報提供が求められており、曖昧な表現は許容されなくなっています。NISTのAIリスクマネジメントフレームワークでも、想定外利用がリスク顕在化の主要因になると指摘されています。

また、2026年版の特徴として、環境負荷やエネルギー消費といったサステナビリティ関連情報が、全体像の中に自然に組み込まれている点が挙げられます。欧州委員会によれば、計算資源や電力消費の開示は、単なる環境配慮ではなく「社会的影響評価の一部」として扱われています。これにより、モデルカードは技術文書であると同時に、企業の責任あるAI姿勢を示す証拠資料にもなっています。

このように必須記載項目の全体像を把握することで、モデルカードは「説明責任を果たすための負担」ではなく、「信頼を設計するための中核資産」へと変わります。AIの高度化が進むほど、この全体設計の巧拙が、技術そのもの以上に評価される時代に入っているのです。

環境負荷・公平性・リスク評価が重視される理由

環境負荷・公平性・リスク評価が強く重視されるようになった背景には、AIが社会インフラとして利用される段階に入ったという構造的変化があります。2026年時点では、基盤モデルは単なる研究成果ではなく、行政、医療、金融、教育といった領域で意思決定を間接的に支える存在になっています。そのため、性能が高いだけでは不十分で、社会的コストと副作用を可視化し、説明責任を果たすことが不可欠になっています。

まず環境負荷については、EU AI ActのAnnex XIでトレーニング時の計算資源やエネルギー消費量の記載が義務化されたことが象徴的です。大規模モデルの学習では、数百MWh規模の電力が消費されるケースも報告されており、データセンターの電力源によってはCO2排出量が企業のESG評価に直接影響します。欧州委員会の技術文書要件によれば、再生可能エネルギー比率を考慮した排出量推定が求められており、AI開発そのものがサステナビリティ戦略の一部として評価される時代に入っています。

| 観点 | 重視される理由 | 実務への影響 |

|---|---|---|

| 環境負荷 | エネルギー消費の外部不経済 | 学習規模・効率性の説明が必須 |

| 公平性 | 特定集団への不利益防止 | 人口統計別評価の開示 |

| リスク評価 | 悪用・事故の予防 | レッドチーミング結果の文書化 |

公平性が重視される理由も同様に実践的です。GoogleやSony AIの研究によれば、モデル全体の精度が高くても、属性別に見ると性能差が大きいケースが珍しくありません。特に顔認識や自然言語生成では、性別や文化圏による誤差が社会的差別として顕在化するリスクがあります。そのためモデルカードでは、単一スコアではなく人口統計グループ間の性能差や既知のバイアスを明示することが、利用者の判断材料として求められています。

リスク評価が不可欠とされるのは、AIの失敗が「予測不能な形」で拡大するためです。NISTのAIリスクマネジメントフレームワークやEUの体系的リスク指定では、敵対的テストやインシデント報告が重視されています。これは、ハルシネーションやプロンプトインジェクションといった挙動が、下流システムで重大な事故につながる可能性があるためです。リスクを事前に列挙し、限界を認めること自体が信頼の源泉となり、結果として企業や研究機関の持続的なAI活用を支える基盤になっています。

Agentic Workflowによるモデルカード自動生成と更新

Agentic Workflowによるモデルカードの自動生成と更新は、2026年のAIガバナンス運用において中核的な役割を担っています。従来のモデルカードは、リリース時に人手で作成され、その後の再学習や微調整によって内容が陳腐化するという構造的な課題を抱えていました。このギャップを解消したのが、AIエージェントが主体となってドキュメントを維持管理する自律型ワークフローです。

この仕組みでは、ドキュメンテーション専用のエージェントがModel Context Protocolを介して複数の開発基盤に接続します。具体的には、コードリポジトリの変更履歴、MLflowやWeights & Biasesに蓄積された実験ログ、さらにUnity Catalogなどのデータカタログに記録されたデータリネージ情報を横断的に取得します。GoogleのModel Card ToolkitやMicrosoftのResponsible AI Dashboardが示すように、技術的事実を一次情報から直接取得する設計が、ハルシネーションの抑止と監査耐性の向上に直結しています。

モデルの再トレーニングが完了すると、エージェントは新旧バージョンの差分を解析し、性能指標、データ構成、エネルギー消費量など更新が必要な項目だけを自動で書き換えます。その際、EU AI ActのAnnex XIやAnnex XIIに照らして必須項目の欠落を検知し、人間のレビュー担当者に通知します。欧州委員会の技術文書要件に基づくこのチェック機構は、単なる効率化にとどまらず、法令順守をプロセスに埋め込むという点で決定的な意義を持っています。

| 工程 | 人手中心の運用 | Agentic Workflow |

|---|---|---|

| 情報収集 | 担当者が各ツールを個別確認 | エージェントが自動横断取得 |

| 更新頻度 | リリース時・不定期 | 再学習や変更のたびに即時 |

| 規制適合確認 | チェックリスト依存 | 要件ベースで自動検証 |

さらに先進的な現場では、単一エージェントではなくマルチエージェント構成が採用されています。執筆エージェントが事実を文章化し、監査エージェントが規制要件との整合性を検証し、批評エージェントが専門外の読者にも理解できる表現かを評価します。AAAIやACMの研究コミュニティで報告されているように、この分業構造は人間のレビュー時間を大幅に削減しつつ、記載漏れの発生率を下げる効果が確認されています。

重要なのは、自動生成されたモデルカードがそのまま公開されるのではなく、人間の最終承認を前提とした「Human-in-the-Loop」に組み込まれている点です。エージェントはあくまで事実整理と草稿作成を担い、リスク解釈や表現の最終判断は責任者が行います。Agentic Workflowは人間を排除する仕組みではなく、透明性を持続可能にするための補助知能として機能しているのです。

このように、モデルカードは静的な説明書から、開発と運用の実態をリアルタイムで反映する生きたドキュメントへと変貌しました。GoogleやMicrosoft、Databricksといった主要プラットフォームの実装が示す通り、自動生成と継続更新を前提としたAgentic Workflowこそが、2026年以降のAI透明性を支える実装標準になりつつあります。

主要MLOpsプラットフォームに見る最新のモデルカード運用

主要なMLOpsプラットフォームでは、モデルカードはもはや付随的なドキュメントではなく、開発から運用、監査までを貫く中核的な管理単位として扱われています。2026年時点の最大の特徴は、モデルカードがMLOps基盤にネイティブ統合され、更新・検証・共有が半自動化されている点にあります。

例えばGoogle Cloud Vertex AIでは、モデルの学習や再チューニング、デプロイのイベントと連動してモデルカードが自動生成され、Model Registryに登録されます。Googleの研究部門が提唱してきたModel Card Toolkitは、実験管理ツールから評価指標やデータ来歴を直接取得し、Pythonレベルで再現可能なカード生成を可能にしています。これにより、ドキュメントと実装の乖離が最小化されていると評価されています。

MicrosoftのAzure AI Foundryでは、Responsible AI Dashboardとモデルカードが密結合しています。公平性、エラー分析、説明可能性といった指標はダッシュボード上で計算され、その結果がそのままモデルカードに反映されます。NISTのAIリスクマネジメントフレームワークに準拠した設計である点は、米国政府調達やグローバル企業にとって大きな安心材料となっています。

| プラットフォーム | モデルカード運用の特徴 | 主な強み |

|---|---|---|

| Google Vertex AI | 学習・デプロイと連動した自動生成 | 再現性と開発者フレンドリーなSDK |

| Azure AI Foundry | 責任あるAI指標との統合 | 規制・調達要件への適合性 |

| Databricks | データリネージを中心とした可視化 | データ起点の説明責任 |

Databricks Unity Catalogは、異なるアプローチを取っています。ここではモデルカードの価値を、どのデータからそのモデルが生まれたのかを遡及できる点に置いています。テーブル、特徴量、モデル間の依存関係が自動追跡され、監査時にはモデルカードからデータの作成者や更新履歴まで一気通貫で確認できます。EU AI Actが求めるトレーサビリティ要件に極めて親和性が高い設計です。

オープンなエコシステムではHugging Face Hubが重要な役割を果たしています。YAML形式のメタデータを用いたモデルカード運用は、研究者と企業の共通言語として定着しつつあり、学術論文と商用モデルの橋渡しになっています。GoogleやNVIDIAの研究者も、モデルカードは単なる説明資料ではなく、利用条件を誤解なく伝える契約的文書だと位置づけています。

これらの事例から見えてくるのは、優れたMLOpsプラットフォームほど、モデルカードを人手で「書かせない」設計を志向しているという点です。自動生成と人間のレビューを前提にした運用こそが、2026年のモデルカード実務における現実解となっています。

Sony・SoftBank・富士通・NECに学ぶ実践的ガバナンス事例

日本企業におけるAIガバナンスは、抽象的な倫理宣言から、事業プロセスに組み込まれた実装知へと進化しています。Sony、SoftBank、富士通、NECの4社は、業種も扱うAIリスクも異なりますが、2026年時点で共通して「説明可能で監査に耐える仕組み」を構築している点が特徴です。

Sonyは、ガバナンスをデータレベルから設計しています。Sony AIが公開したFHIBEは、公平性評価専用の画像データセットであり、被写体の同意取得、属性定義、用途制限までを詳細なデータカードとして明文化しています。Nature系ジャーナルでも指摘されるように、データ収集段階での倫理設計が下流のモデルリスクを大幅に低減することが実証されつつあり、Sonyはそれを企業ガバナンスに統合しています。

SoftBankの特徴は、意思決定速度を落とさないリスクベース設計です。AIシステムを4段階に分類し、モデルカードの記載粒度や承認フローを可変にしています。高リスク案件のみ外部有識者を含む審査を必須とすることで、グループ88社規模でも運用可能な統制を実現しています。これはOECDが推奨する比例原則に合致した実践例です。

富士通は、倫理判断を属人的にしない点で際立っています。AI倫理インパクト評価やKozuchiに統合された自動評価機能により、公平性や説明可能性を定量指標としてモデルカードに反映しています。IEEEの責任あるAI研究でも、評価の自動化が透明性の再現性を高めるとされており、富士通はその産業実装を進めています。

NECは、高リスク領域ならではの監査重視型です。生体認証を含むAIについて、自社DXで先行適用するClient Zeroを通じて運用実証を行い、モデルカードやシステムカードの記載内容を第三者視点で検証しています。内部利用で検証した統制を外販製品に展開する手法は、ガバナンスの実効性を示す強力なエビデンスになります。

| 企業 | 主な焦点 | 実践的特徴 |

|---|---|---|

| Sony | データ倫理 | 同意取得済みデータと厳密なデータカード運用 |

| SoftBank | リスク管理 | 4段階分類による可変型ガバナンス |

| 富士通 | 技術支援 | 倫理評価の自動化とモデルカード連動 |

| NEC | 監査可能性 | Client Zeroと第三者検証の組み合わせ |

これらの事例が示すのは、AIガバナンスは統制コストではなく、信頼を設計する経営技術だという点です。モデルカードは単なる文書ではなく、組織の意思決定と責任分界を可視化する中核ツールとして機能し始めています。

透明性の蜃気楼問題と監査可能性という新たな課題

AIガバナンスが高度化する一方で、近年深刻化しているのが透明性の蜃気楼問題です。これは、モデルカードや技術文書が整備されているように見えても、実際にはリスク判断に資する情報が欠落している状態を指します。AAAIやACM関連会議で共有された大規模調査によれば、数十万件規模のモデルカードのうち、具体的なリスク評価を含むものはごく一部にとどまり、多くが定型文に終始していました。

この現象の本質は、透明性が「開示の量」ではなく「検証可能性」によって成立するという点が十分に理解されていないことにあります。性能指標や倫理方針を並べるだけでは、ユーザーや規制当局はモデルの安全性を評価できません。特にEU AI Actの文脈では、記載内容が実態と一致しているかどうかが問われ、形式的な開示はむしろリスクになり得ます。

| 観点 | 形骸化した透明性 | 監査可能な透明性 |

|---|---|---|

| リスク記述 | 抽象的・一般論 | 具体的な失敗条件や限界 |

| データ説明 | 出所の概略のみ | リネージと権利処理を明示 |

| 検証手段 | 内部自己申告 | 第三者・自動監査が可能 |

ここで鍵となるのが監査可能性です。API経由で提供されるブラックボックス型モデルに対しても、近年はメンバーシップ推論攻撃やプライバシー監査手法を用い、モデルカードの記述内容を外部から検証する研究が進んでいます。国際的に評価の高い学術研究では、記載と実挙動の乖離が検出される事例も報告されています。

さらに注目されているのが、強化学習を活用した自動監査エージェントの登場です。好奇心駆動型の監査手法は、人間が想定しにくい入力を体系的に探索し、バイアスや有害出力を発見します。これにより、モデルカードは単なる説明書から、継続的に検証される生きた証跡へと性格を変えつつあります。

真の透明性とは、安心感を演出することではなく、不都合な事実も含めて検証に耐える情報を提示することです。蜃気楼のような透明性を越え、監査を前提とした設計思想へ移行できるかどうかが、今後のAI信頼性を左右します。

自律的透明性が切り拓く次世代AIガバナンスの展望

自律的透明性は、次世代のAIガバナンスを支える中核概念として急速に注目を集めています。これは単に情報を公開する姿勢ではなく、AIシステム自身が透明性を継続的かつ自動的に維持・更新する能力を指します。EU AI Actの完全施行以降、透明性は静的な遵守文書では不十分となり、運用と同時に進化する動的な仕組みが求められるようになりました。

この転換を後押ししているのが、AIエージェントを活用した自律的ドキュメンテーションです。NISTのAIリスクマネジメントフレームワークでも強調されているように、リスクは時間とともに変化します。モデルの再学習や用途拡大に応じて、リスク評価や利用制限を即座に反映できなければ、透明性は形骸化します。Agentic Workflowは、実験管理ツールやデータカタログと連携し、モデルカードをリアルタイムで更新することでこの課題に対応しています。

学術界でもこの流れは支持されています。AAAIで報告された研究によれば、手動更新のモデルカードは実態との乖離が生じやすく、特にリスク情報の更新遅延が信頼低下を招くと指摘されています。一方、自律更新を導入した組織では、インシデント報告の初動が平均で大幅に短縮されたとされています。透明性を人の善意に依存しない設計が、ガバナンスの実効性を高めています。

| 観点 | 従来型透明性 | 自律的透明性 |

|---|---|---|

| 更新頻度 | 定期的・手動 | イベント駆動・自動 |

| リスク検知 | 事後的 | 継続的モニタリング |

| 監査対応 | 資料提出中心 | 即時応答・検証可能 |

企業ガバナンスの観点では、自律的透明性はコストではなく投資と捉え直されています。欧州委員会の関係者も、透明性の自動化は長期的にコンプライアンスコストを低減し、市場参入の信頼条件になると述べています。特にGPAIのような汎用モデルでは、下流事業者が安心して統合できるかどうかが競争力を左右します。

今後は、透明性そのものがAIシステムの品質指標として評価される時代に入ります。説明でき、監査に耐え、変化に追随できるAIだけが社会インフラとして受け入れられるでしょう。自律的透明性は、規制対応の延長ではなく、信頼を前提とした次世代AIガバナンスへの進化形なのです。

参考文献

- EU Artificial Intelligence Act:Overview of Guidelines for GPAI Models

- Google:Google Model Cards

- European Commission:Template for the Public Summary of Training Content for general-purpose AI models

- Digital Agency Japan:行政における生成AIの調達・利用に関するガイドライン

- Sony AI:Groundbreaking Fairness Evaluation Dataset From Sony AI Now Available

- Hugging Face:Model Cards Documentation

- arXiv:Privacy Auditing of Large Language Models