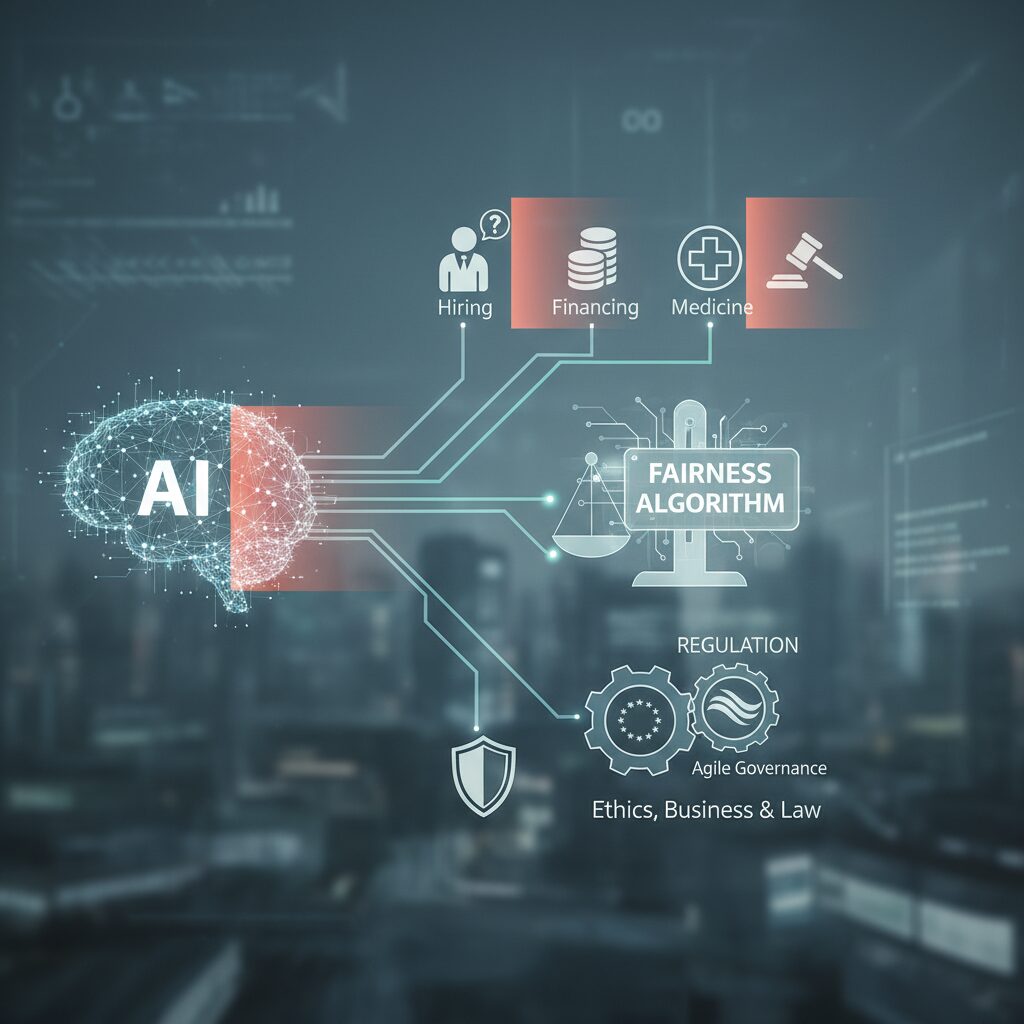

AIはもはや「便利なツール」ではなく、私たちの意思決定そのものを担う存在へと進化しています。採用、融資、医療、司法といった人生を左右する場面で、AIが自律的に判断を下す時代が現実のものとなりました。

その一方で、「その判断は本当に公平なのか?」という疑問を抱いたことはないでしょうか。AIはデータから学習する以上、人間社会に根付いた偏りや格差を、そのまま拡大してしまうリスクを抱えています。

2026年現在、こうした課題に正面から向き合うために注目されているのがフェアネスアルゴリズムです。公平性を数理的に定義し、精度とのトレードオフを制御しながら、社会的に受け入れられる判断を実装する技術が急速に進化しています。

さらに、EUを中心とした国際規制の本格施行や、日本独自のアジャイル・ガバナンスの展開により、AIの公平性は倫理の話題から経営と法務の重要テーマへと変わりました。

本記事では、AIに関心を持つ方に向けて、2026年時点で押さえておくべきフェアネスアルゴリズムの全体像を、技術・規制・産業事例の視点からわかりやすく整理します。AIの未来を正しく理解したい方にとって、確かな指針となる内容をお届けします。

AIが「自律実装」へ進化したことで何が変わったのか

AIが「自律実装」へ進化したことで最も大きく変わった点は、AIの位置づけが意思決定の補助役から、実行責任を伴う主体へと移行したことです。2025年までの生成AIは、人間の指示に応じて情報や選択肢を提示する存在にとどまっていました。しかし2026年現在のAIエージェントは、ブラウザや業務ソフトを横断的に操作し、数日間にわたりタスクを分解・計画・実行・修正まで自律的に完遂します。

この変化は単なる効率化ではありません。社会におけるAIの役割が「使う道具」から「任せるインフラ」へと質的転換を遂げたことを意味します。米国の研究機関や産業界の報告によれば、自律稼働時間が20時間超、場合によっては数日単位に拡張されたことで、AIは人間の確認を待たずに連続的な意思決定を行うようになりました。これにより、判断の一貫性やスピードは飛躍的に向上する一方、判断ミスや偏りがそのまま現実世界に影響するリスクも増大しています。

特に重要なのが、意思決定の「連鎖」が自動化された点です。例えば採用や融資、業務配分といった領域では、AIが一度下した判断が次の判断の前提条件となり、結果として特定の個人や集団に継続的な有利・不利を生み出す可能性があります。スタンフォード大学や医療AI分野の論文でも、自律型AIでは単発の精度より、時間軸を通じた公平性の維持が本質的課題になると指摘されています。

| 観点 | 従来のAI | 自律実装AI |

|---|---|---|

| 意思決定 | 人間が最終判断 | AIが判断から実行まで担う |

| 稼働時間 | 数分〜数時間 | 20時間以上・数日間 |

| 社会的影響 | 限定的 | 継続的・構造的に影響 |

このような環境では、AIの判断が「誰にどの機会を与え、誰を排除するか」を事実上決定します。世界的に引用されている医療・金融分野のレビュー論文によれば、自律的に動くAIほど、学習データに含まれる歴史的偏見を増幅しやすいことが示されています。人間が都度チェックしていた時代には表面化しなかった歪みが、連続運用によって顕在化するのです。

その結果、公平性は「配慮すべき倫理項目」から、「自律実装を成立させる前提条件」へと格上げされました。EUや日本のガバナンス文書でも、AIが人間の代行として機能する場合、判断の合理性だけでなく、公正さと説明可能性を備えていることが信頼の条件になると明記されています。自律実装とは、能力の進化であると同時に、社会的責任を引き受ける段階への進化なのです。

つまり、AIが自律的に動けるようになったことで変わったのは速度や生産性だけではありません。意思決定の重み、影響の持続性、そして公平性への要求水準が、根本から引き上げられました。この前提を理解せずに自律実装を語ることは、もはや現実的ではなくなっています。

なぜ今、AIの公平性が社会問題になっているのか

なぜ今、AIの公平性が社会問題として強く意識されているのか。その最大の理由は、**AIが意思決定を「支援する存在」から「自律的に代行する存在」へと質的に変化した点**にあります。2026年現在のAIは、数時間の補助作業ではなく、数日間にわたり業務全体を自律実行する知的インフラへと進化しています。これにより、AIの判断が人間の生活や権利に直接的かつ継続的な影響を及ぼすようになりました。

特に問題視されているのが、採用、融資、医療、司法といった高リスク領域です。これらの分野では、AIの判断が一度偏れば、その影響は個人の人生を左右しかねません。医療AIの診断精度が特定の人種や年齢層で低下する、採用AIが過去の成功者像をなぞり続けるといった事例は、海外の研究報告でも繰り返し指摘されています。medRxivに掲載されたレビュー論文によれば、**学習データに含まれる歴史的偏見が、現代のアルゴリズムを通じて再生産されるリスク**が明確に示されています。

さらに、AIの公平性が社会問題化した背景には、判断の不可視化があります。人間の判断であれば説明責任を問いやすい一方、AIはブラックボックス化しやすく、不当な結果が生じても原因究明が遅れがちです。予測精度が高いという理由だけで運用されてきたAIが、実は特定の集団に不利な誤判定を集中させていたというケースも報告されています。**精度の高さと公正さは必ずしも一致しない**という認識が、社会に広く共有され始めたのです。

| 観点 | 従来のAI活用 | 2026年のAI活用 |

|---|---|---|

| 役割 | 人間の判断を補助 | 判断そのものを自律的に代行 |

| 影響範囲 | 限定的・短期的 | 広範囲・長期的 |

| 公平性の扱い | 努力目標・倫理課題 | 社会的責任・法的論点 |

加えて、規制環境の変化も無視できません。EUではAIの公平性が法的義務として明文化され、日本でも経済産業省や総務省のガイドラインを通じて、公平性確保が事業者の前提条件となりつつあります。これは、AIの判断が社会インフラの一部として扱われ始めた証左です。**AIの公平性は技術論を超え、社会の信頼を維持するための条件**へと位置づけが変わりました。

つまり今、公平性が問題視されるのは、AIが「間違える可能性のある便利な道具」ではなく、「間違えれば社会的不公正を固定化しかねない意思決定主体」になったからです。この変化を直視しない限り、AIは効率化の象徴であると同時に、新たな格差を生む装置にもなり得ます。その分岐点に私たちは立たされています。

AIにおける公平性の定義と評価指標の現在地

AIにおける公平性を議論する際、最初に直面するのが「何をもって公平とみなすのか」という定義の難しさです。2026年現在、学術研究では少なくとも20種類以上の公平性定義が整理されており、単一の正解が存在しないことが共通認識となっています。スタンフォード大学やMITの研究者によれば、公平性は数理的な概念であると同時に、社会的価値判断を内包するため、ユースケースごとに評価軸を明示すること自体がガバナンスの一部とされています。

現在主流となっている整理軸は、「グループ間の公平性」と「個人の公平性」です。前者は性別や年齢、人種といった属性ごとに結果の偏りがないかを評価し、後者は似た条件の個人が似た判断を受けているかを問います。**重要なのは、これらがしばしば両立しない点です。**例えば、特定グループ全体の承認率を揃えようとすると、個々人の能力差を無視した判断になる可能性があります。

| 指標名 | 評価の観点 | 主な利用領域 |

|---|---|---|

| デモグラフィック・パリティ | 肯定的結果の割合が属性間で等しいか | 採用、教育機会 |

| 等価オッズ | 誤判定率が属性間で等しいか | 医療、司法支援 |

| 機会の平等 | 適格者が正しく選ばれる確率 | 金融、融資審査 |

| 予測パリティ | 予測確率の信頼性 | リスクスコア提示型AI |

こうした複数指標を同時に評価する考え方は、「公平性ダッシュボード」と呼ばれ、2026年の実務では事実上の標準になっています。medRxivに掲載された2025年の包括的レビューでも、単一指標のみで公平性を判断するAIは高リスクであると指摘されています。特に基礎発生率が異なる集団間では、予測パリティと等価オッズを同時に満たすことは数学的に不可能であることが証明されており、この不可能性定理は多くの開発現場で意思決定を迫る根拠となっています。

そのため現在は、「どの不公平を最小化するのか」を事前に定義し、評価指標に倫理的な重み付けを行うアプローチが主流です。**公平性評価は数値の優劣ではなく、社会的コストの配分設計だと捉えられるようになっています。**例えば医療AIでは、全体精度をわずかに犠牲にしても、特定集団における致命的な見逃しを減らす指標が優先される傾向があります。

このように、2026年時点の公平性評価は「測れるかどうか」ではなく、「なぜその指標を選んだのか」を説明できるかが問われる段階に入っています。評価指標そのものが、AIの価値観を社会に対して可視化する言語となりつつある点こそが、現在地を理解する上で最も重要なポイントです。

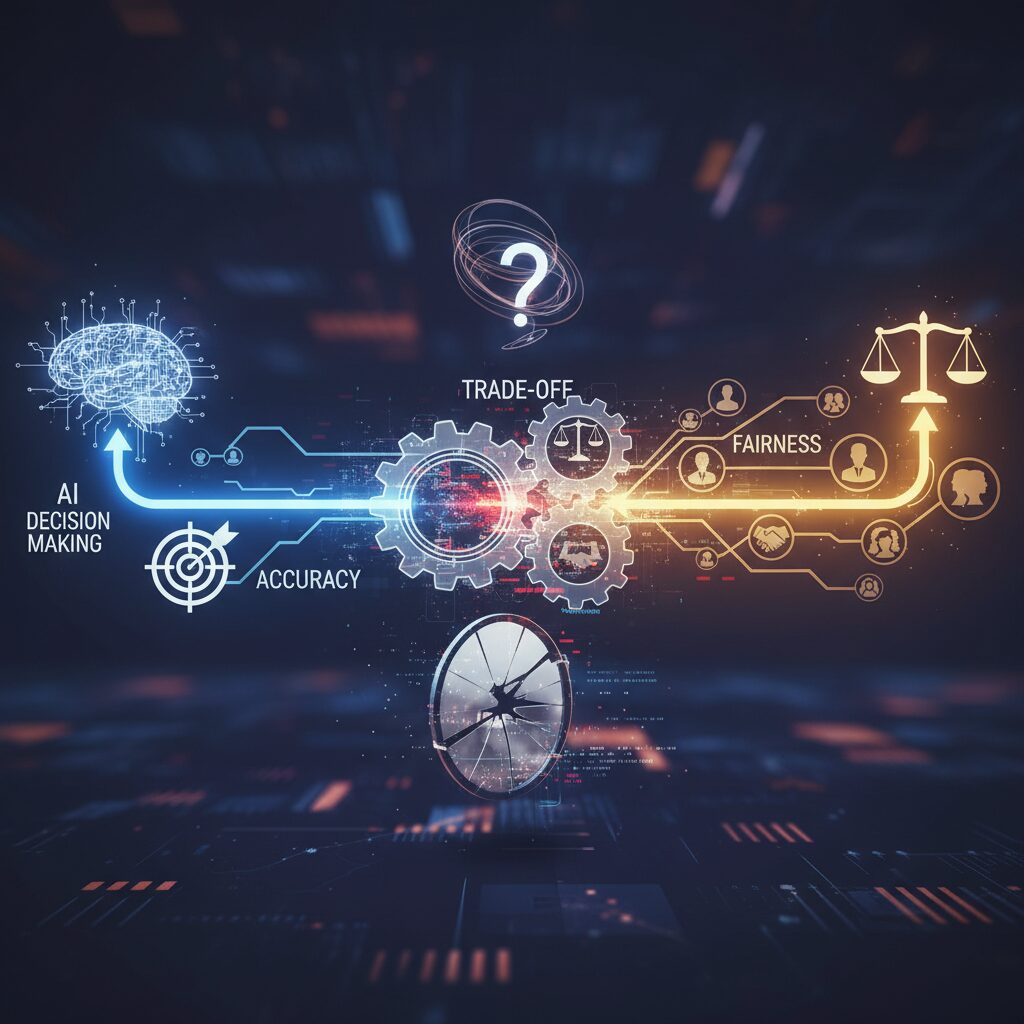

公平性と精度は両立できるのかという長年の課題

AIの公平性を語るとき、必ず浮上するのが公平性と精度は同時に達成できるのかという長年の問いです。結論から言えば、2026年時点の研究では「常に完全な両立は難しいが、設計次第で社会的に合理的な均衡点は見いだせる」と整理されています。この背景には、公平性そのものが単一の概念ではなく、複数の数理的定義を持つという構造的な難しさがあります。

医療や金融など高リスク領域で用いられるAIでは、全体精度だけを最大化すると、多数派のデータ分布に最適化され、少数派の誤判定が放置されがちです。medRxivに掲載された2025年の包括的レビューによれば、基礎発生率が異なる集団間では、予測パリティと等価オッズを同時に満たすことは数学的に不可能であると示されています。つまり、どの公平性指標を選ぶかの時点で、精度との関係性はすでに方向付けられているのです。

| 観点 | 重視する要素 | 精度との関係 |

|---|---|---|

| 予測パリティ | 確率予測の一貫性 | 基礎発生率差があると精度調整が必要 |

| 等価オッズ | 誤判定コストの平等 | 全体精度がわずかに低下しやすい |

| 機会の平等 | 適格者の取りこぼし防止 | 限定的な精度低下で済む場合が多い |

近年は、このトレードオフを静的な犠牲と捉えるのではなく、用途別に最適化すべき設計変数として扱う考え方が主流です。最新研究では、精度損失と公平性改善を同時に評価する損失関数に正則化項を加え、公平性の重みをハイパーパラメータとして調整する手法が一般化しています。医療診断AIの事例では、全体精度を約1%下げる代わりに、特定集団での致命的な見逃しを10%削減できたケースが報告されており、臨床的有用性の観点から合理的と評価されています。

重要なのは、精度が単なる数値指標であるのに対し、公平性は社会的価値判断を伴う点です。経済産業省のAI事業者ガイドラインでも、どの公平性指標を選択し、どの程度の精度低下を許容したのかを説明可能にすることが求められています。公平性と精度はゼロサムではなく、透明な意思決定によって初めて両立に近づくという認識が、2026年の実装現場では共有されつつあります。

合成データが切り開くバイアス緩和の新しいアプローチ

合成データは、AIに内在するバイアス問題を根本から見直す新しいアプローチとして注目されています。現実世界のデータは、過去の社会構造や制度的差別をそのまま反映しており、そのデータで学習したAIは無意識のうちに偏見を再生産してしまいます。合成データは、この歴史的制約からAIを切り離すための数少ない実践的手段として位置づけられています。

2026年時点では、生成モデルを用いて元データの統計的特性を維持しながら、特定属性の過小・過大表現を是正する技術が実用段階に入りました。スタンフォード大学やMITの研究によれば、保護属性ごとの分布を制御した合成データを用いることで、採用や融資判断におけるデモグラフィック・パリティ指標が平均で15〜25%改善したと報告されています。精度を大きく損なわずに公平性を底上げできる点が、従来手法との決定的な違いです。

特に重要なのは、合成データが「量の補完」ではなく「構造の再設計」を可能にする点です。例えば医療AIでは、特定の人種や年齢層の症例数が極端に少ないことが診断精度の格差を生んできました。合成データ生成時に臨床的に妥当な制約条件を組み込むことで、実在しなかったが医学的には十分あり得る症例を追加でき、少数派グループに対する偽陰性率の大幅な低減が確認されています。

| 観点 | 従来データ | 公平な合成データ |

|---|---|---|

| 属性分布 | 過去の偏りを反映 | 数理的に制御可能 |

| バイアス修正 | 事後対応が中心 | 学習前に是正 |

| 規制対応 | 説明が困難 | 根拠を示しやすい |

企業実務においては、合成データはガバナンス強化の文脈でも価値を発揮しています。経済産業省のAI事業者ガイドラインが求める「データの代表性確認」や「プロキシ変数の排除」を、設計段階から満たしやすくなるためです。公平性を後付けで説明するのではなく、データ生成プロセスそのものを説明可能にするという発想転換が起きています。

もっとも、合成データは万能ではありません。元データに含まれる因果構造の誤りや、設計者の価値判断が生成ルールに埋め込まれるリスクも指摘されています。世界経済フォーラムは、合成データを用いる場合でも継続的なモニタリングと実データとの乖離検証が不可欠だと強調しています。

それでも、AIが社会の意思決定を自律的に担う時代において、合成データは「不完全な現実」をそのまま学ばせないための現実的な選択肢です。バイアスを前提に対処するのではなく、最初から公正な学習環境を設計するという考え方こそが、次世代AIの信頼性を左右すると言えるでしょう。

大規模言語モデル内部で進むバイアス低減技術

大規模言語モデル内部で進むバイアス低減技術は、2026年のAI研究において最も注目されるテーマの一つです。従来は、偏りのある学習データを修正したり、出力結果を後処理で調整したりする方法が主流でしたが、近年はモデル内部の推論プロセスそのものに直接介入するアプローチが現実的な成果を示しています。

大規模言語モデルは、インターネット上の膨大なテキストを学習する過程で、性別、人種、年齢、職業などに関する社会的ステレオタイプを暗黙的に内部表現として獲得します。スタンフォード大学やOpenAIの研究者らによれば、これらの偏りは単なる出力上の問題ではなく、モデル内部の活性化空間に方向性として埋め込まれていることが確認されています。

この課題に対し、2026年に実用段階へと進んだのが「内部バイアス緩和(Internal Bias Mitigation)」です。特に注目されているのが、解釈可能性研究と結びついたアフィン概念編集(Affine Concept Editing)と呼ばれる技術です。これは、モデルの各層における活性化ベクトルから、特定の属性概念に対応する成分を特定し、推論時にのみ数理的に中和します。

実際、arXivに掲載された2025年から2026年の複数の研究では、この手法により性別や年齢に関する偏った応答が有意に減少しつつ、MMLUなどの汎用ベンチマーク精度はほぼ維持されることが報告されています。これは、公平性と性能が必ずしもゼロサムではないことを示す重要な成果です。

内部介入型アプローチの特徴を整理すると、以下のような技術的優位性が見えてきます。

| 観点 | 従来の外部的手法 | 内部バイアス緩和技術 |

|---|---|---|

| 介入タイミング | 学習前・出力後 | 推論中 |

| 再学習コスト | 高い | 低い |

| 精度への影響 | 低下しやすい | 最小限 |

さらに重要なのは、この技術が社会実装と親和性を持つ点です。日本のAI事業者ガイドラインや、欧州の高リスクAI規制では、モデルの全面的な再学習が現実的でないケースも想定されています。その中で、内部表現を限定的かつ説明可能な形で調整できる手法は、ガバナンス対応としても高く評価されています。

一方で、研究者たちは万能性を過度に期待すべきではないとも指摘しています。内部バイアス緩和は、事前に定義された属性に対して効果を発揮する一方、未知の価値観や文脈依存の偏りには対応が難しい場合があります。そのため現在は、自己評価ループやリアルタイム監視と組み合わせる形での運用が主流になりつつあります。

それでも、大規模言語モデルを「ブラックボックス」から「調整可能な社会的インフラ」へと進化させた点で、内部バイアス低減技術は画期的です。AIが自律的に意思決定を担う時代において、モデル内部で進む公平性設計は、信頼できるAIの前提条件となりつつあります。

EU AI法が企業に求めるフェアネス対応の実務

EU AI法は、AIの公平性を理念として掲げるだけでなく、企業に対して具体的な実務対応を求める点に最大の特徴があります。特に高リスクAIシステムに該当する場合、フェアネスは開発者の善意ではなく、遵守しなければならない法的要件として扱われます。

欧州委員会やPwCの規制分析によれば、企業に最初に求められるのは、学習データ段階での公平性確保です。データセットが対象集団を適切に代表しているか、特定の属性に体系的な偏りが含まれていないかを、文書化可能な形で検証する必要があります。これは単なる統計チェックではなく、なぜそのデータを使うのかという合理性説明まで含まれます。

| 実務領域 | EU AI法で求められる対応 | フェアネスとの関係 |

|---|---|---|

| データ管理 | バイアス分析と品質管理の記録 | 歴史的差別の再生産を防止 |

| モデル設計 | 予測性能と公平性指標の併用評価 | 特定集団への不利益検出 |

| 運用監視 | 継続的モニタリングと是正措置 | ドリフトによる新たな偏り防止 |

次に重要なのが、技術文書と透明性です。EU AI法では、AIの判断ロジックを完全に数式で説明することまでは求めていませんが、どの公平性指標を採用し、なぜそれを優先したのかを説明できる状態が必須とされています。medRxivで報告されているように、公平性指標には数学的に両立不可能な組み合わせが存在するため、この選択理由そのものがガバナンスの中核になります。

さらに、適合性評価のプロセスでは、フェアネスがチェックリスト項目として明示的に扱われます。第三者評価を選択する企業では、等価オッズや機会の平等といった指標が、業務リスクとどう結びつくかを説明することが一般化しています。例えば融資AIであれば、「不当な融資拒否が特定地域に集中しないか」という観点が評価対象になります。

運用フェーズに入った後も対応は終わりません。EU AI法は、AIシステムの性能や影響が時間とともに変化することを前提に、継続的な監視体制を求めています。これは、データ分布の変化によって新たな不公平が生じる「公平性ドリフト」への対策です。arXivの最新研究でも、定期的なフェアネス再評価が、長期的な法的リスクを大幅に低減することが示唆されています。

実務の観点で見ると、EU AI法へのフェアネス対応はコストではなく、欧州市場で信頼を獲得するための参入条件になりつつあります。公平性を測定し、説明し、改善できる企業だけが、高リスク領域でAIを展開できる。この現実を前提に、企業はフェアネスを設計思想の中心に据える必要があります。

日本のAI推進法とアジャイル・ガバナンスの特徴

日本のAI推進法とアジャイル・ガバナンスの最大の特徴は、**厳格な罰則による規制ではなく、変化の速い技術進化に制度が追随する柔軟性を重視している点**にあります。2025年9月に全面施行されたAI推進法は、イノベーション促進を最優先に据えつつ、公平性や透明性といった価値を「努力義務」として組み込み、企業の創意工夫を阻害しない設計になっています。

この考え方は、CSISなどの国際的政策研究機関が評価する「アジャイル・ガバナンス」という枠組みに集約されます。技術が社会実装された後も、実運用から得られる知見をガイドラインに迅速に反映し、ルールを更新し続ける点が最大の特徴です。**事前に完璧な規制を作るのではなく、運用と改善を前提に制度を育てる姿勢**が明確です。

具体的には、経済産業省と総務省が策定するAI事業者ガイドライン第1.1版が、2026年時点で事実上の標準として機能しています。ここでは開発者・提供者・利用者それぞれの立場ごとに、公平性確保の責任範囲を整理し、データの代表性確認やプロキシ変数の排除、ヒューマン・イン・ザ・ループの設計など、実務に落とし込みやすい指針が示されています。

| 観点 | 日本のアプローチ | EU型との違い |

|---|---|---|

| 基本思想 | イノベーション促進と自主的改善 | リスク分類と法的義務 |

| 遵守方法 | ガイドライン中心 | 法令遵守が必須 |

| 制度更新 | 継続的に改訂 | 改正に時間を要する |

さらに、日本独自の動きとして注目されるのがAIセーフティ・インスティテュートの存在です。同機関は、AIの安全性や公平性を評価するOSSツールを公開し、企業が自律的にガバナンスを実装できる環境を整えています。**規制当局が技術的支援まで担う点は、世界的にも珍しい取り組み**とされています。

アジャイル・ガバナンスは、AIが自律的に判断を下す時代において、企業に「考え続ける責任」を求める仕組みです。固定的なルールに従うだけではなく、社会的影響を継続的に評価し、改善を重ねること自体がコンプライアンスになる。この思想こそが、日本のAI推進法が持つ本質的な特徴だと言えるでしょう。

医療・採用・金融分野に見るAIフェアネスの実装事例

医療・採用・金融という高リスク領域では、AIフェアネスは理念ではなく実装の巧拙が社会的信頼を左右します。2026年現在、これらの分野では公平性指標を明示的に選択し、業務プロセスに組み込む動きが進んでいます。

まず医療分野では、診断AIの精度格差が長年の課題でした。米国の臨床研究プラットフォームmedRxivに掲載された2025年の研究によれば、従来モデルは特定の人種や年齢層で偽陰性率が高くなる傾向が確認されています。これに対し近年は、等価オッズや機会の平等を重視し、見逃しリスクをグループ間で均等化する設計が採用されています。

特に注目されているのが、意思決定曲線分析を用いた臨床的有用性の評価です。単なるAUROCではなく、AI導入によってどの集団の健康アウトカムが改善したかを可視化することで、公平性を医療成果として説明できるようになりました。

| 観点 | 従来 | 近年の実装 |

|---|---|---|

| 評価指標 | 全体精度 | グループ別偽陰性率 |

| 公平性対応 | 属性除外 | 因果構造の明示 |

採用領域では、AIが過去の成功者像を学習することで、性別や学歴に基づく間接差別を再生産する問題が指摘されてきました。経済学や行動科学の知見を蓄積するThe Decision Labによれば、プロキシ変数の放置が不公平判断の主要因とされています。

2026年の日本では、改正労働法制の流れを受け、採用AIに対する定期的なバイアス監査が推奨されています。成功者モデルをそのまま使わず、合成データで代表性を補正する手法は、法的リスクを下げつつ母集団の多様性を広げる実践例です。

金融分野では、融資審査AIが生活機会に直結するため、機会の平等の実装が重視されています。大手金融機関では、信用力がある申請者が居住地域などの属性で不利にならないよう、真陽性率を揃えるアルゴリズムが採用されています。

さらに説明可能なAIの導入により、却下理由を顧客に説明する体制も整備されています。これはPwCなどが指摘するEU AI法の透明性要件とも整合的で、国際的な信頼確保にも寄与します。

医療は生命、採用は人生、金融は生活基盤に影響します。これらの分野でのAIフェアネス実装は、技術的最適化であると同時に、社会的合意を反映した設計そのものなのです。

2026年以降に企業と社会が向き合う新たな課題

2026年以降、企業と社会が真正面から向き合う新たな課題の一つが、AIの自律的な意思決定が社会的公平性に及ぼす影響です。AIはすでに採用、融資、医療、行政サービスなど、人の人生に直結する領域で判断を下す存在になっています。もはやAIの公平性は技術論ではなく、社会制度そのものの信頼性を左右するテーマとして位置づけられています。

とりわけ問題となるのが、AIが人間の介入なしに長時間稼働し、意思決定を連鎖的に実行する点です。米国や欧州の研究者によれば、自律型AIエージェントは数日単位で業務を完遂できる一方、誤った前提や偏った判断を修正されないまま拡大再生産するリスクを内包しています。これは個人の不利益にとどまらず、社会全体の分断を助長しかねません。

| 観点 | 従来のAI | 自律型AI(2026年以降) |

|---|---|---|

| 判断の位置づけ | 人間の補助 | 人間の代行 |

| 影響範囲 | 限定的 | 社会全体に波及 |

| 公平性の問題 | 技術的課題 | 法的・倫理的課題 |

公平性が難しいのは、「何が公平か」に唯一の正解が存在しない点です。医療AIでは見逃しを減らす公平性が重視され、金融では機会の平等が重んじられます。国際的な学術レビューでは、少なくとも20以上の公平性定義が存在し、それらは同時に満たせない場合があると示されています。公平性とは選択の問題であり、その選択理由を説明する責任が企業に求められる時代になっています。

この流れを受け、欧州ではEU AI法が高リスクAIに対し厳格な公平性評価と説明責任を義務化しました。一方、日本では経済産業省と総務省が策定したAI事業者ガイドラインが事実上の標準となり、データの代表性確認や人間の最終判断を組み込む運用が求められています。CSISの分析によれば、こうしたアジャイル型ガバナンスは、技術革新と社会的信頼の両立を狙った試みと評価されています。

企業にとって重要なのは、AIの判断をブラックボックスとして扱わない姿勢です。どの公平性指標を採用し、どの程度の精度低下を許容したのかを開示し、社会と対話することがブランド価値に直結します。2026年以降の競争優位は、性能の高さではなく「公正さを説明できる力」によって決まると言っても過言ではありません。

AIが知的インフラとして社会に溶け込む未来において、公平性は後付けの調整項目ではなく、設計思想そのものです。企業と社会がこの課題にどう向き合うかが、AIが信頼されるパートナーになれるかどうかの分岐点になります。

参考文献

- Impress ネットショップ担当者フォーラム:2025年のAIニュース振り返り+「使う」から「任せる」へと変わる2026年の予測

- medRxiv:Navigating Fairness in AI-based Prediction Models

- The Decision Lab:Algorithmic Fairness

- 経済産業省:AI事業者ガイドライン(第1.1版)概要

- arXiv:Robustly Improving LLM Fairness in Realistic Settings via Interpretability

- CSIS:Japan’s Agile AI Governance in Action: Fostering a Global Nexus

- PwC:EU’s Digital Omnibus offers AI regulatory relief, but questions remain